UCloud AI 在線服務推出GPU版本 主攻低延時場景

前言

自去年5月開啟免費公測和正式上線以來,UCloud AI在線服務UAI-Inference已幫助許多初創企業、大型傳統企業降低了AI技術門檻和成本投入,有利抓住了人工智能風口。UAI-Inference因其易部署、易運維、支持多種主流AI框架以及安全可靠的特性,可適用于機器學習、視頻圖像識別、自然語言處理等多種AI應用場景。

隨著人工智能技術演進和AI細分化領域日趨成熟,對云服務商的AI產品能力也提出了更高要求。近日,UCloud AI在線服務平臺推出獨占型GPU推理節點,提供高性能AI在線推理服務。GPU在線服務節點主要面向對深度學習AI在線推理服務有低延時要求的應用場景。

P40高性能GPU加速卡提供算力保障

人工智能爆發的第三波浪潮離不開計算能力的提升,而算力提升的背后離不開GPU的廣泛使用。UAI-Inference的GPU節點采用NVIDIA P40高性能GPU加速卡,提供穩定、高效的算力保障。

UAI-Inference GPU在線服務平臺同UAI-Inference CPU平臺一樣,可提供海量計算節點、自動負載均衡、節點容災、服務監控、服務版本灰度管理等功能。同時,UAI-Inference GPU在線服務支持用戶隨時調整在線服務GPU節點規模,實時應對線上業務負載變化。

UAI-Inference GPU在線服務平臺基于Docker容器技術實現,用戶僅需提供在線推理的容器實現即可。在線服務平臺的GPU節點預制NVIDIA GPU以及Docker的執行環境,可以實現服務集群快速擴容。另外,UAI 團隊提供主流AI框架的基礎容器鏡像,支持范圍包括:TensorFlow/Caffe/MXNet/Keras等。

三大場景延時降低效果顯著

UAI-Inference GPU在線服務利用P40 GPU強勁性能可以將在線Inference的效率提升10倍以上。

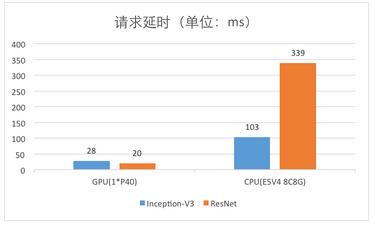

例如,圖像分類場景利用UAI-Inference獨占型GPU在線服務,Inception-V3和ResNet101兩個算法模型在batchsize=1時的推理延時,相對8C8G的CPU云主機性能有明顯提升,可以將請求延時降低至50ms以內,如下圖所示:

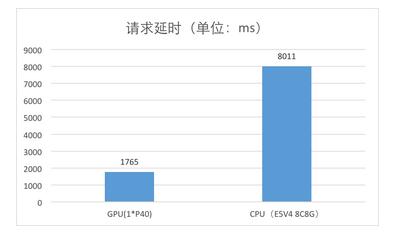

針對文字檢測場景,利用UAI-Inference獨占型GPU在線服務,CTPN和EAST兩個算法模型在batchsize=1時的推理延時,相對8C8G的CPU云主機性能有明顯提升,可以將請求延時從秒級優化至100ms級,如下圖所示:

針對目標檢測場景,利用UAI-Inference獨占型GPU在線服務,Fast RCNN算法模型在batchsize=1時的推理延時,相對8C8G的CPU云主機性能有明顯提升,可以將請求延時降低接近5倍,如下圖所示:

彈性付費成本更低

目前,主要的人工智能應用場景的實現方式之一是基于云端AI,即用戶通過網絡將要處理的數據上傳到云平臺,在云平臺大規模計算并進行建模、識別等處理,***再將計算結果傳到本地。該方式的主要優勢在于彈性可快速部署,能隨時根據用戶的實際業務需求對計算節點進行調整。

UAI-Inference GPU在線服務平臺針對業務處于高峰或低峰的不同階段,支持用戶隨時調整GPU集群的節點數量,對GPU集群進行橫向擴展和回縮。因此用戶可以按照實際需求調整資源,無需擔心資源閑置浪費。此外,還提供精確到分鐘的計費維度,獨占服務P40 GPU節點僅0.085元/節點*分鐘。

人工智能的發展前景被越來越看好,云服務商作為企業AI轉型的基礎設施支撐平臺,將會面臨更多挑戰,但為了進一步滿足用戶的需求,UCloud將在探索AI產品的道路上不斷創新。