VMware 虛擬化平臺規劃設計方案

1 需求分析

XX銀行目前虛擬化平臺為3年前建設投產的,版本為vSphere 5.5,一直沒有更新。隨著XX銀行業務的高速發展,原有平臺已經滿足不了目前的應用需求,而且有些版本老舊,給運維帶來很多不便。基于上述原因,現決定構建全新的虛擬化平臺,采用新的vSphere 6.0版本,并考慮到未來的業務擴展。

現階段規劃5個分區,分別為生產業務區、管理區、網銀Web區、網銀App區、運維基礎區。每個業務區承載著不同數量的虛擬機,并且隨著業務發展不斷增加。隨著新業務不斷增長要求,未來將逐步把小型機服務器上應用系統遷移到虛擬化平臺,最終實現數據中心x86服務器的全部虛擬化。

本方案將根據用戶現有虛擬化平臺的現狀和物理服務器進行評估,給出新數據中心虛擬化平臺的詳細設計,作為以后項目實施測試和驗收的依據。

2 總體架構

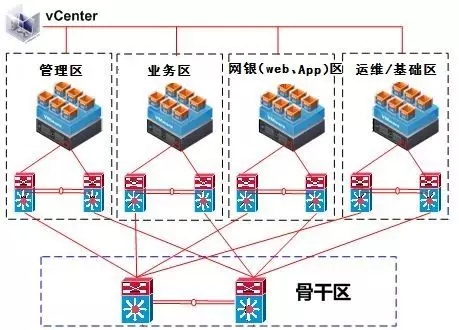

XX銀行虛擬化平臺總體架構由86臺主機組成,分別為生產業務區、管理區、網銀Web區、網銀App區、運維基礎區構成,面向正式生產業務,由一個放在運維/基礎區的vCenter統一管理。

每個業務區域之間是網絡隔離的,但vCenter管理網絡是相通的。

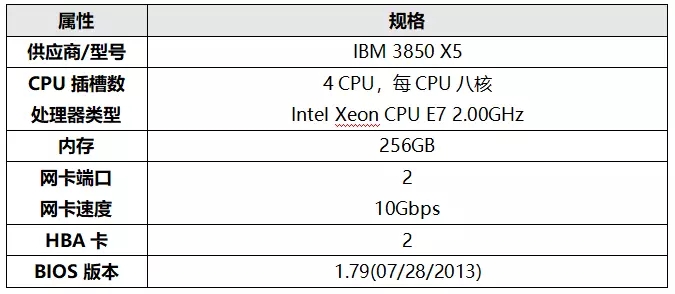

2.1 ESXi主機配置

2.1.1 硬件配置規格

2.1.2 BIOS設置

2.1.3 ESXi主機軟件版本

Name: VMware ESXi 6.0 Update 1

2.1.4 配置NTP時間源

ESXi使用是UTC(Universal Time/Temps Cordonn 世界標準時間)時區,而且ESXi已經不支持修改時區。如果沒有NTP服務器,可以手動調整ESXi主機時間。

安裝ESXi主機后,立刻調整時間(未調整時間之前不能建立和遷移新虛擬機)。強烈建議統一配置NTP時間源,所有主機須與時間源同步。

2.1.5 ESXi主機命名規范

bkxx-esxi55-e<編號>

FQDN示例:bkxx-esxi55-e01.bkxx.cn,全小寫。ESXi主機與vCenter服務器名稱解析,加入XX銀行為此項目搭建的DNS服務器(DNS服務安裝于vCenter服務器)。

3 群集和資源池設計

3.1 VMware HA群集設計原理

至少2臺以上ESXi主機組建為一個HA群集。虛擬機文件放置在由光纖存儲組成的共享存儲上。 ESXi主機產生故障時,虛擬機自動在群集內其他可用的ESXi主機上重新啟動。VMware HA為虛擬機中的運行提供快速計劃外中斷恢復和具有成本效益的高可用性。

VMware HA不需要在應用程序或虛擬機內安裝任何特殊軟件。HA群集中的所有虛擬機均受 VMware HA 保護。VMware HA要求虛擬機必須駐留在共享存儲上。

VMware HA代理會在ESXi主機間相互通信,并監控群集內各臺ESXi主機的活躍度。默認情況下,此通信通過每秒交換一次檢測信號來完成。如果15 秒過去后仍未收到檢測信號,而且 ping 不到該ESXi主機,則系統會聲明該ESXi主機發生故障。

網絡檢測信號是確定主機狀態的關鍵,數據存儲檢測信號使主機更加正確地判斷管理網絡不可達的狀態。默認情況下,HA會選擇2個數據存儲心跳,這個選出的的數據存儲在集群內所有的主機上有效。

如果連接服務器的物理網絡交換機支持 PortFast(或等效)設置,請將其啟用。此設置可防止ESX主機在執行冗長的跨樹算法期間誤認為網絡已被隔離。

在虛擬化平臺進入運行維護期后,如果需要執行可能會觸發主機隔離響應的網絡維護,建議首先禁用HA群集中的“主機監控”功能,以掛起 VMware HA。完成維護后,請重新啟用“主機監控”。

虛擬機重新啟動優先級用于設定在ESX主機發生故障后虛擬機的重新啟動相對順序。這些虛擬機在新主機上按順序重新啟動,首先啟動優先級相對較高的虛擬機,然后是那些低優先級的虛擬機。建議為提供最重要服務的虛擬機分配較高的重新啟動優先級。

3.2 集群和資源池的劃分

群集為運行的虛擬機提供一個高可用性和冗余環境。虛擬機可以在以資源池為單位的范圍內負載均衡,靈活調配。

根據數據中心網絡和業務架構,每個業務區為一個獨立集群,每個集群即為一個獨立的資源池。生產區域共分為5個集群單元:管理區集群、業務區集群、網銀Web區集群、網銀App區集群和運維基礎區集群,所有集群由運維基礎區的vCenter統一管理調度。

3.3 群集接入控制策略設置

一類 指定故障切換主機

使用“指定故障切換主機”,在群集中空置一臺ESXi主機備用,指定它做為故障切換ESXI主機。則在ESXI主機發生故障時,VMware HA 將嘗試在備用ESXI主機上重新啟動其虛擬機。備用ESXI主機CPU和內存配置不得低于群集內的其他ESXI主機。

第二類 群集允許的主機故障數目

使用“群集允許的主機故障數目” ,VMware HA 允許指定數目的ESXI主機發生故障,同時可以確保群集內留有足夠的資源來對這些主機上的虛擬機進行故障切換。此類HA規則適用于虛擬機CPU和內存耗用(或保留值)較平均的場景。目前,XX銀行項目中采用此種群集設置規則,設置群集允許的主機故障數目為1。

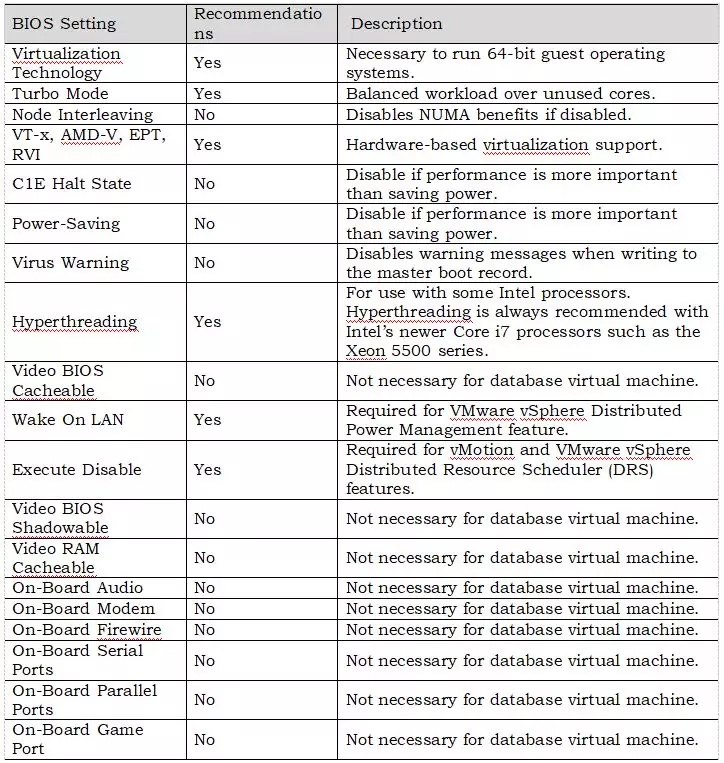

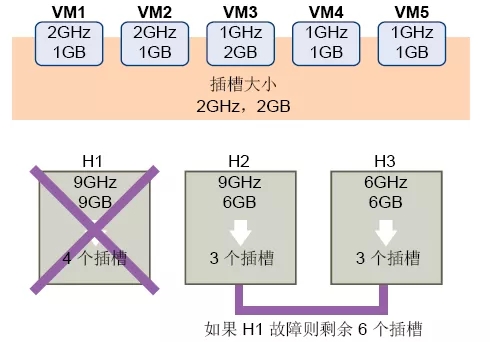

計算插槽大小

插槽大小由兩個組件(CPU 和內存)組成。CPU 的方法是選擇已啟動虛擬機上的 CPU 預留最大值。無CPU 預留,則默認值 256 MHz(使用 das.vmCpuMinMHz 更改)。內存的方法是選擇已啟動虛擬機的內存預留,然后再選擇最大值(使用 das.slotMemInMB 更改)。

確定每臺主機可以支持的插槽數目上限

用主機的 CPU/內存資源數除以插槽大小,得出插槽數目上限,計算群集允許的主機故障數目。

示例,下圖中主機故障數目為1

第三類 預留的群集資源的百分比

可以將vSphere HA 配置為通過預留特定百分比的群集CPU 和內存資源來執行接入控制,用于從主機故障中進行恢復。

使用“預留的群集資源的百分比”接入控制策略,vSphere HA 可確保預留CPU 和內存資源總量的指定百分比以用于故障切換。

XX銀行選擇第二種“群集允許的主機故障數目”接入控制策略,值為“1”,即“允許1臺主機出現故障”。

注:如果vCenter不可用,它不會影響到群集的現有配置。故障切換時沒有vCenter加入,HA只是依賴vCenter配置和監視群集。

3.4 VMware DRS功能

VMware DRS監控群集內所有主機和虛擬機的 CPU 和內存資源的分布情況和使用情況。在給出群集內資源池和虛擬機的屬性、當前需求以及不平衡目標的情況下,DRS會將這些衡量指標與理想狀態下的資源利用率進行比較。然后,DRS會相應地執行虛擬機遷移(或提供遷移建議)。群集中初次啟動虛擬機時,DRS 將嘗試通過在相應主機上放置該虛擬機或提出建議來保持適當的負載平衡。

DRS 的自動化級別:

手動 : 初始放置位置:顯示推薦的主機。

遷移:顯示遷移建議。

半自動:初始放置位置:自動。

遷移:顯示遷移建議。

全自動:初始放置位置:自動。

遷移:自動執行遷移建議。

在目前設置下,考慮到虛擬機與駐留主機的固定配置關系,暫不啟用DRS功能或者選擇“手動”DRS方式。啟用DRS功能,只需在群集配置中勾選啟用DRS,以及配置相應規則。在正確規劃和操作的情況下,DRS的配置不影響虛擬機的正常運行。

4 管理中心vCenter設計

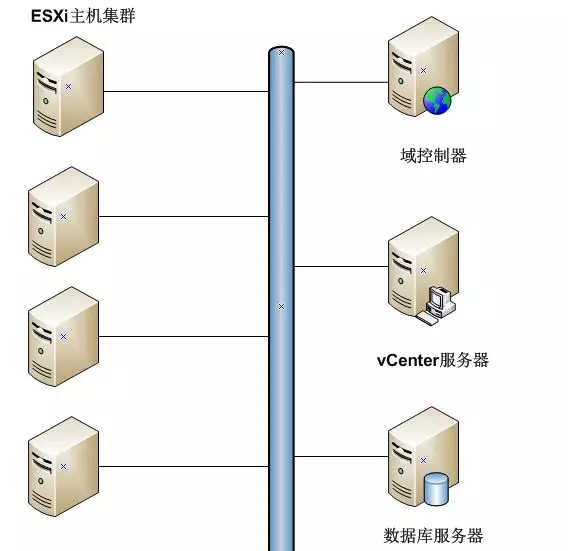

管理軟件vCenter是整個虛擬化平臺管理控制的核心,考慮其考慮重要性和可管理性,我們設計把域控制器,vCenter服務器和數據庫服務器分離,邏輯架構圖如下:

以上各組件說明:

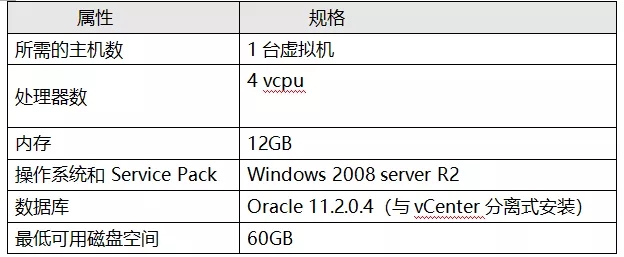

vCenter服務器采用虛擬機部署方式,部署在該運維區。建議配置如下:

vCenter與其數據庫分離,采用虛擬機形式安裝。這樣便于利用VMware的HA技術進行保護,而且安裝后建議克隆vCenter服務器作為一個備份鏡像。數據庫每天使用Oracle備份工具備份vCenter數據,并在ESXi主機本地內置磁盤上保留vCenter數據庫服務器的完整克隆。根據vCenter服務器所管理的ESXi主機與虛擬機的數量,估算vCenter數據庫的容量如下:

按約50臺ESXi主機和200臺虛擬機進行預估,vCenter數據庫容量估算工具,請參考《VC Database Sizing Calculator》。

創建數據庫時,按照該容量的3倍進行數據庫空間的預留,即50GB。

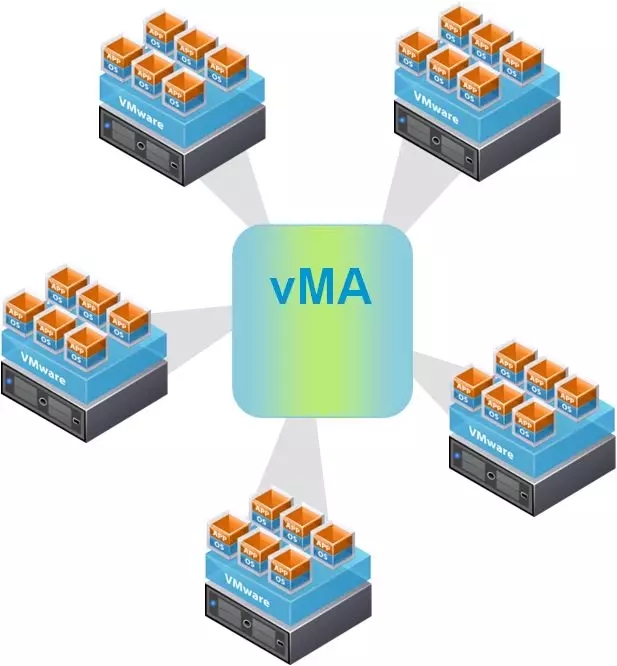

4.1 安裝vMA

VMware vSphere Management Assistant (vMA) 是VMware對外提供的工具。vMA 將 vSphere 命令行界面、vSphere SDK for Perl 以及日志記錄和身份驗證模塊打包到一個方便的捆綁包中。vMA還可以托管第三方代理,以增強管理功能。

建議安裝vMA,并憑此工具對ESXi主機進行集中管理。同時,vMA還配置成syslog日志服務器,用于管理ESXi主機的日志。由于ESXi主機發生紫屏死機,重啟后log就丟失,所以推薦配置syslog服務器,把日志轉儲。

從安全性考慮,不建議打開ESXi主機的SSH功能,如果需要命令行管理主機,可以使用vMA管理助手。

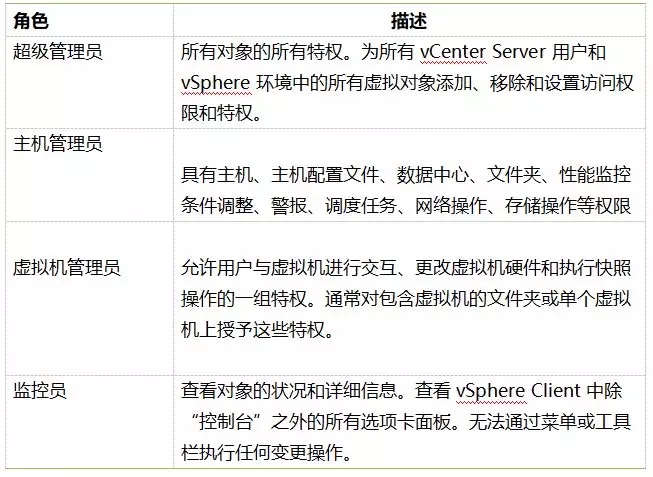

4.2 用戶、組、權限和角色

定義用戶、組、角色和權限能夠控制哪些用戶可以訪問 vSphere 受管對象以及這些用戶可以執行哪些具體操作。vCenter Server 授權用戶是包括在 vCenter Server 引用的 Windows 域列表中的用戶,或者是 vCenter Server系統上的本地 Windows 用戶。

角色是一組預定義的特權。特權定義用戶執行操作和讀取屬性所需的個人權限。當給用戶或組分配權限時,將用戶或組與角色配對,并關聯與清單中某一受管對象,直接與vCenter服務器中的高層級的對象相關聯。

根據項目建設和未來運營管理的實際需要,在建設初期,按照運維管理的模式與需求,創建相關用戶、組和vCenter角色,并創建若干具有管理員權限的用戶。進入運營管理階段后,則刪除原具有管理員權限的用戶(保留Administrator),按照既定的用戶、組和vCenter角色設置,對vSphere進行操作。

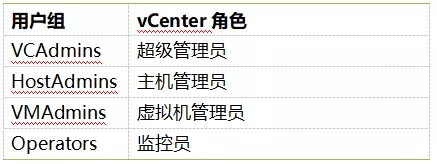

4.2.1 vCenter角色

4.2.2 vCenter服務器域用戶組

根據角色設置,在域控服務器創建域用戶組(如果使用新的用戶組來管理),具體設置如下:

4.2.3 vCenter角色與用戶組關聯

在vCenter服務器最上層級(),做vCenter角色與用戶組的關聯。

4.3 vSphere監控事件報警

借助事件監控和報警系統,在vSphere、vCenter中將被配置以便監控所有核心虛擬架構的健康和性能內容,包括ESXi主機、群集、HA、虛擬機操作如VMotion和vCenter自身的健康。

配置以下被監視事件。條件和閥值配置細節如下:

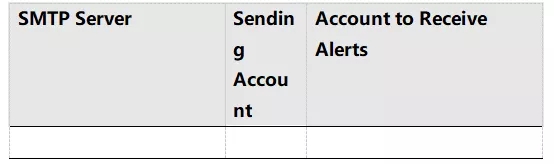

當以上告警觸發后,配置vCenter發送SNMP traps到網絡管理軟件;同時也將由郵件發送到相關負責人和所有vSphere企業管理組中。

vSphere企業管理組將定期負責審查和管理這些有vCentre、ESXi主機、虛擬機產生的健康和系統日志。這些日志將為企業的保留策略和程序做準備和歸檔。

SNMP 接受端得配置如下表所示:

vCenter告警郵件轉發的SMTP配置如下表所示:

5 虛擬化網絡設計

XX銀行虛擬化網絡設計考慮了以下基本原則:

1)物理交換機和網卡均冗余配置;

2)充分利用分布式交換機的優點,物理網卡上均設置為Active-Active模式,有效提高帶寬,負載均衡策略和故障切換策略;

3)物理交換機連接到ESXi主機的端口設置為Trunk訪問模式,允許VLAN訪問。

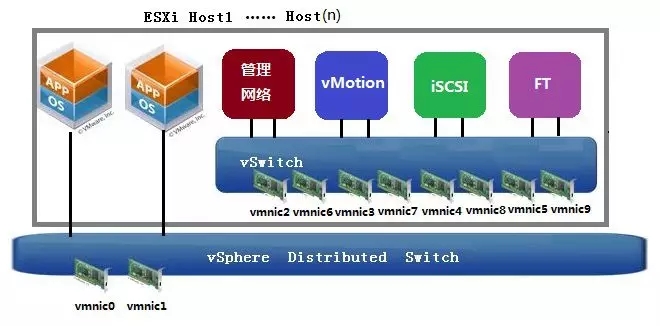

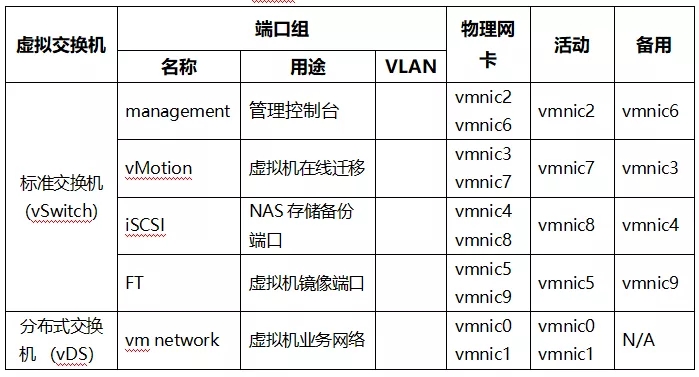

主機物理網卡布局示意圖如下:

每臺ESXi主機共配有2片(每片有4個網口)千兆網卡,ESXi主機自帶2個千兆網口,共有10個網口可用。在標準虛擬交換機中,為管理網絡、VMotion端口、iSCSI存儲和FT端口提供網絡服務。正式部署前,管理網絡和VMotion端口、iSCSI存儲和FT端口都需要分配好固定IP地址。兩片網卡交叉備份,一旦前一片網卡或網絡鏈路出現故障,則自動切換到第二片網卡上運行。

虛擬機業務網絡采用分布式交換機方式,使用主機自帶兩個網絡端口。在虛擬端口組中,這兩片網卡都處于活動狀態,虛擬機的業務流量按照實際物理流量規則進行負載均衡,在這兩片網卡上進行轉發。連接這兩塊網卡的物理交換機端口設置為TRUNK訪問模式,允許虛擬機業務VLAN通過。

對于生產業務區、管理區、網銀Web區、網銀App區的虛擬化網絡規劃如下圖:

管理區、生產區和網銀區ESXi主機網絡規劃表

注:運維基礎區由于是一個集群承擔運維和基礎業務兩種角色,并且運維和基礎業務有各自的網段,其上承載的虛擬機不能互訪。所以需要把FT和iSCSI的備用網卡都拿出來到分布式交換機的vm network上,保證基礎業務和運維每個網段都有兩張網卡可以接到各自的兩臺物理交換機上,保障物理設備和鏈路的冗余。

虛擬交換機配置:

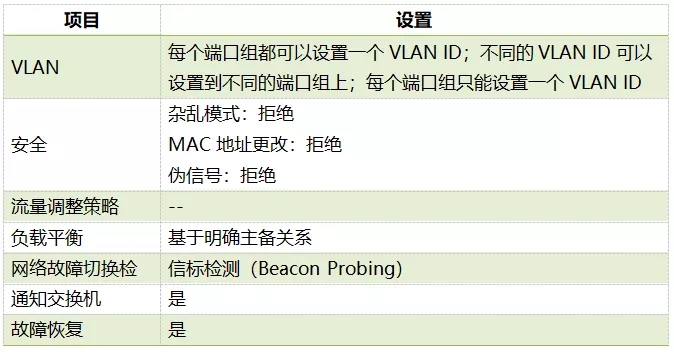

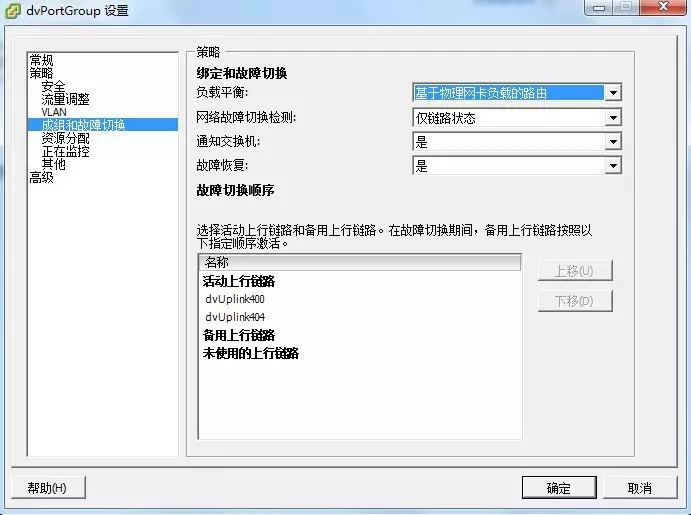

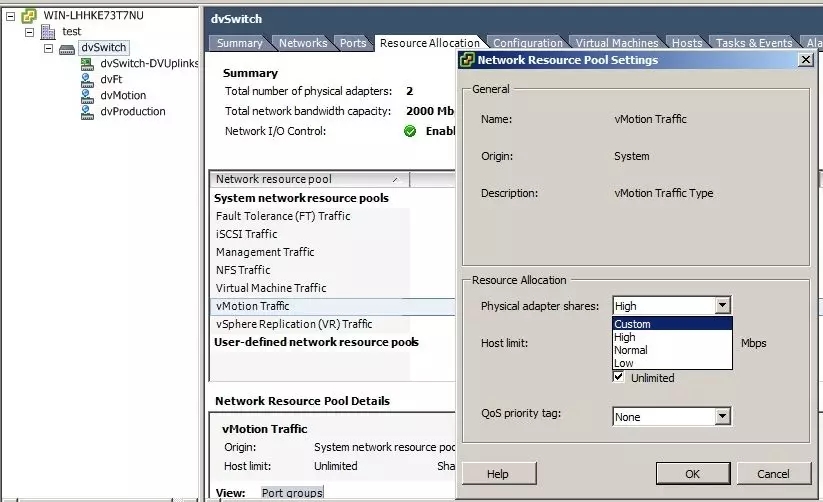

分布式交換機的負載均衡選擇“基于物理網卡負載的路由”

應客戶要求,如果以后網絡進行萬兆改造,服務器上只有兩個網口,那么為了做到網絡隔離,推薦下列設計:

兩個網卡一個負責虛擬機網絡,另一個負責管理網絡和vmkernel應用,二者互為主備。可以通過NIOC設置份額,讓各個vmkernel網絡按份額比例分配。

6 存儲規劃

6.1 設備連接冗余設計

存儲設備的高可用性非常重要,建議連接到共享存儲的每臺ESX主機配備兩塊HBA卡,并提供兩臺物理光纖交換機,避免單點故障。

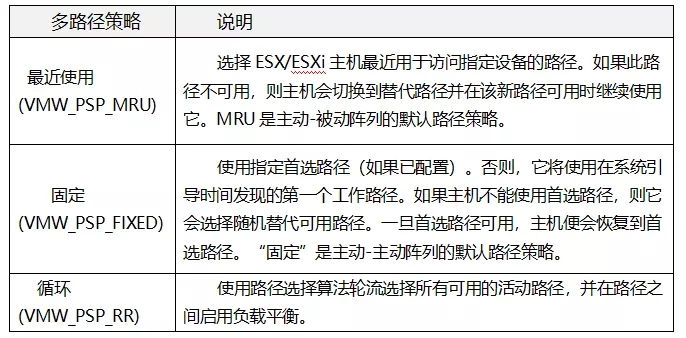

ESXi主機安裝后可以管理多路徑,對于配備了兩個控制器的存儲,使用主動-主動控制器,路徑選擇策略可以是“固定”或“循環”策略。

6.2 共享存儲容量規劃

共享存儲總共規劃容量6T,由20個LUN構成,每個大小300G。根據VMware實踐,推薦Datastore與Lun一一對應,按照此規則各個集群數據存儲容量規劃方案如下:

6.3 存儲命名規范

本地存儲命名

- 三位:ESX主機名后三位;

- 一位:連接符“-”;

- 五位:固定字串“local”;

- 一位:連接符“-”;

- 二位:序號,從1開始。

例子:e01-local-01

共享存儲命名

- 群集后5位;

- 一位:連接符“-”;

- 五位:存儲類型標識 “fc” – Fiber Channel SAN storage “iscsi” – iSCSI storage “nas” - NAS storage “vplex” - vplex storage

- 一位:連接符“-”;

- 二位:序號,從1開始。

示例:cls01-fc-01

7 備份規劃

vSphere Data Protection (VDP) 是一個基于磁盤的備份和恢復解決方案,可靠且易于部署。 vSphere Data Protection 與 VMware vCenter Server 完全集成,可以對備份作業執行有效的集中式管理,同時將備份存儲在經過重復數據消除的目標存儲中。

7.1 vSphere Data Protection 具有優勢

1 針對所有虛擬機提供快速有效的數據保護,甚至可保護那些已關閉或在物理主機之間移動的虛擬機。

2 在所有備份上使用智能重復數據消除,從而可極大地減少備份數據所消耗的磁盤空間。

3 通過使用更改數據塊跟蹤和 VMware 虛擬機快照,降低了備份虛擬機的成本,盡可能地縮短了備份窗口。

4 可實現輕松備份,無需在每個虛擬機上安裝第三方代理。

5 可以作為集成組件簡單直接地安裝到 vSphere 中,可通過 Web 門戶進行管理。

6 對 vSphere Data Protection 配置的直接訪問已集成到標準的 vSphere Web Client 中。

7 使用檢查點和回滾機制保護備份。

8 從基于 Web 的界面中,通過最終用戶啟動的文件級恢復 (諸多限制)提供 Windows 和 Linux 文件的簡化恢復。

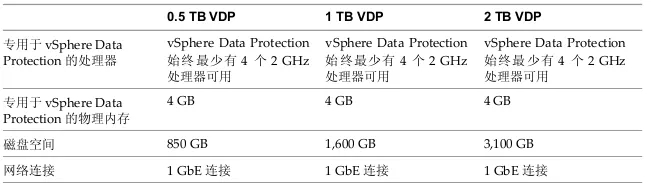

7.2 vSphere Data Protection 體系結構

vSphere Data Protection (VDP) 使用 vSphere Web Client 和 vSphere Data Protection 應用裝置將備份存儲到經過重復數據消除的存儲中。

vSphere Data Protection 由一組在不同計算機上運行的組件構成 (如下圖所示)。

1 vSphere

2 vSphere Data Protection Appliance

3 vSphere Web Client

vSphere Data Protection 應用裝置有三種選項可用:

建議XX銀行虛擬化數據中心采用2TB VDP類型。由于每個集群互不相通,所以每個集群各部署一個VDP Appliance。備份介質可以使用NAS,在網絡設計部分已經建立iSCSi端口,可以通過網絡進行備份。虛擬機備份保留策略為每天一備,保留7天。

注:VDP是已虛擬機為最小單位的備份工具,對于虛擬機里面的應用和Oracle數據庫不能單獨備份。建議客戶采用應用和Oracle的專用備份工具對其備份。對于Lan-Free備份方式,可以咨詢Netapp和賽門鐵克等廠商。他們針對虛擬化平臺有對于的產品和解決方案可以把虛擬機備份到帶庫中。

8 虛擬機設計

8.1 安裝和配置VMware Tools

每臺虛擬機安裝好操作系統后,必須先安裝vmware tools。沒有vmware tools驅動,vsphere的一些功能將使用受限。

以下功能是僅當安裝VMware Tools 時才可用的一些功能:

- 支持Aero 的操作系統上大大提升的圖形性能和Windows Aero 體驗

- 在虛擬機與主機或客戶端桌面之間復制并粘貼文本、圖形和文件

- 改進的鼠標性能

- 虛擬機中的時鐘與主機或客戶端桌面上的時鐘同步

- 幫助自動執行客戶機操作系統操作的腳本

安裝步驟請參考VMWare知識庫文檔:1014294

http://kb.vmware.com/selfservice/microsites/search.do?cmd=displayKC&docType=ex&bbid=TSEBB_1267116806002&url=&stateId=1%200%20125994156&dialogID=125988560&docTypeID=DT_KB_1_1&externalId=1014294&sliceId=1&rfId=

Installing VMware Tools in a Windows virtual machine (1018377)

Installing VMware Tools in an Ubuntu virtual machine (1022525)

Installing VMware Tools in a Novell virtual machine (1018299)

Installing VMware Tools in a Linux virtual machine using RPM (1018392)

Installing VMware Tools in a Linux virtual machine using Compiler (1018414)

Installing VMware Tools in a Solaris virtual machine (1023956)

8.2 虛擬機模板管理

虛擬機模板統一放置在運維區,需要部署到其他區時候,進行虛擬機克隆,導出ovf文件形式再導入到相應區域進行部署。

8.3 虛擬機磁盤格式選擇

虛擬磁盤有三種方式供給方式:

- 厚置備延遲置零(Thick Provision Lazy Zeroed):以默認的厚格式創建虛擬磁盤。創建虛擬磁盤時分配虛擬磁盤所需的空間。創建過程中不會清除物理設備上保留的數據,但以后初次從虛擬機寫入時則會按需置零。使用默認的平面虛擬磁盤格式,不會根除或消除恢復已刪除文件或還原此已分配空間上可能存在的舊數據的可能性。無法將平面磁盤轉換為精簡磁盤。

- 厚置備置零(Thick Provision Eager Zeroed):一種厚虛擬磁盤類型,可支持群集功能,如 Fault Tolerance。在創建時為虛擬磁盤分配所需的空間。與平面格式相反,創建虛擬磁盤時,會將物理設備上保留的數據置零。創建這種格式的磁盤所需的時間可能會比創建其他類型的磁盤長。

- 精簡置備(Thin Provision):使用此格式可節省存儲空間。對于精簡磁盤,可以根據輸入的磁盤大小值置備磁盤所需的任意數據存儲空間。但是,精簡磁盤開始時很小,只使用與初始操作所需的大小完全相同的存儲空間。注意 如果虛擬磁盤支持群集解決方案(如 Fault Tolerance),請勿將磁盤設置為精簡格式。如果精簡磁盤以后需要更多空間,它可以增長到其容量上限,并占據為其置備的整個數據存儲空間。而且,您可以將精簡磁盤手動轉換為厚磁盤。

建議將I/O負載較重的虛擬機分別駐留在不同的VMFS(LUN)上。

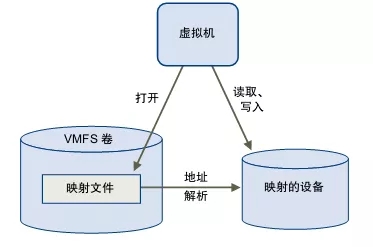

8.4 虛擬機文件系統選擇

VMFS 數據存儲是VMkernel處理磁盤的默認方式;VMkernel對磁盤分區并進行格式化,創建了VMFS文件系統的磁盤在vSphere中稱為數據存 儲,而且VMkernel能夠讀取磁盤,VMFS的優勢是單個磁盤(在SAN中術語為LUN)能夠承載多個虛擬機。

有關每個LUN應該承載 多少個虛擬機,平均數應該是12(生產系統推薦8個,測試類系統可用16個)個虛擬機共享一個數據存儲。一個數據存儲能夠承載多個虛擬機及構成虛擬機的所有文件。這些文件包括VMX文 件(該文件列出了虛擬機的硬件配置)和VMDK文件(虛擬機的硬盤以及構成虛擬機的其他零散文件)。

使用RDM,VMkernel不會對LUN進行格式化,而是由虛擬機客戶操作系統對LUN執行格式化。每個RDM是一塊單獨的虛擬機硬盤,而且通常只關聯到單個虛擬機。RDM存儲虛擬機的磁盤內容而非虛擬機文件,構成虛擬機的文件需要存放在RDM之外的數據存儲上。

部署RDM通常基于RDM能夠提供更好的性能這一理念,因為其開銷要比VMFS上的VMDK文件低。但是在某些情況下,RDM要比VMFS的性能還要差一些。

關于RDM配置,請參考官方文檔《vSphere 存儲》第18章“裸設備映射”一節。

注:除非軟件應用有要求使用RDM,VMWare官方推薦客戶使用VMFS文件系統,可用充分利用虛擬化的一切特性。

8.5 虛擬機集群共享存儲配置

Virtual SCSI 適配器

集群的成員虛擬機必須選擇專用的SCSI適配器。參考官方文檔KB1037959

For example, if the system disk (drive C:) is attached to SCSI0:0, the first shared disk would be attached to SCSI1:0, and the data disk attached to SCSI1:1.

The shared storage SCSI adapter for Windows Server 2008 and higher must be the LSI Logic SAS type, while earlier Windows versions must use the LSI Logic Parallel type.

Disk configurations

•RDM: Configurations using shared storage for Quorum and/or Data must be on Fibre Channel (FC) based RDMs (physical mode for cluster across boxes "CAB", virtual mode for cluster in a box "CIB") in vSphere 5.1 and earlier. RDMs on storage other than FC (iSCSI and FCoE) are only supported in vSphere 5.5..

•VMFS: Virtual disks used as shared storage for clustered virtual machines must reside on VMFS datastores and must be created using the EagerZeroedThick option. This can be done using the vmkfstools command from the console, the vSphere CLI, or from the user interface. To create EagerZeroedThick storage with the vmkfstools command:

1.Log into the console of the host or launch the VMware vSphere CLI.

2.For example, to create a 10 GB file in datastore1 named myVMData.vmdk, run the command:

▪Using the console:vmkfstools –d eagerzeroedthick –c 10g /vmfs/volumes/datastore1/myVM/myVMData.vmdkNote: Replace 10g with the desired size.

▪Using the vSphere CLI:vmkfstools.pl –-server ESXHost –-username username --password passwd –d eagerzeroedthick –c 10g /vmfs/volumes/datastore1/myVM/myVMData.vmdk

•To create EagerZeroedThick storage with the user interface:

1.Using the vSphere Client, select the virtual machine for which you want to create the new virtual disk.

2.Right-click the virtual machine and click Edit Settings.

3.From the virtual machine properties dialog box, click Add to add new hardware.

4.In the Add Hardware dialog box, select Hard Disk from the device list.

5.Select Create a new virtual disk and click Next.

6.Select the disk size you want to create.

7.Select the datastore with the virtual machine or select a different datastore by clicking Specify a datastore and browsing to find the desired datastore.

8.To create an EagerZeroedThick disk, select Support clustering features such as Fault Tolerance.Note: Step 8 must be the last configuration step. Changes to datastores after selecting Support clustering features such as Fault Tolerance cause it to become deselected.

Complete the wizard to create the virtual disk.

根據以往經驗,如果數據庫的大小<800G,建議使用VMFS格式,如果數據庫大小>800G,可以考慮使用RDM方式。

需要設置的共享盤:心跳盤,數據庫用到的磁盤(NEC Cluster設置需要磁盤多宿主)。

在使用NEC Cluster時候,主應用虛擬機允許遷移,但不設置回切。在主備虛擬機之間設置關聯規則:互斥,避免應用雙機同時遷移到同一臺ESXi主機上。

設置NEC Cluster共享盤時, 心跳磁盤大小大于200M以上即可,使用VMFS方式。

設置集群IP時:分為Service IP(對外),public IP(管理),private IP(心跳)。Service IP與public IP在同一網段內,private IP單獨規劃出一個網段,做到網絡隔離。

本文作者:趙海,曾在IBM、惠普中國等企業任軟件工程師、高級系統工程師,2013年加入IBM Devops Solution Team,參加云計算項目建設及部署,以及后期的咨詢及解決方案提供工作。2014年加入某城商銀行系統規劃設計中心,任系統架構師,專注于銀行數據中心解決方案規劃及設計工作。