大數(shù)據(jù)開發(fā)之路:hive篇,你看了嗎?

引語

大數(shù)據(jù)開發(fā)之路漫漫其修遠兮,吾將上下而求索。很多入門大數(shù)據(jù)的小伙伴,可能接觸到的,就是一只可愛的“小象”,也就是我們的大數(shù)據(jù)領域的數(shù)據(jù)倉庫工具hive。

這只小象給我們提供了方便類SQL查詢語言HQL來操縱數(shù)據(jù),使得我們一開始不用編寫復雜的代碼,就可以輕松的探索數(shù)據(jù)。Hive對于熟悉傳統(tǒng)數(shù)據(jù)庫的同學來說,算是很友好的一個入門工具。

原理

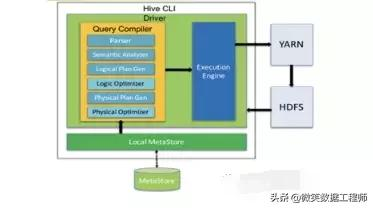

在大數(shù)據(jù)生態(tài)中,hive一般作為數(shù)據(jù)倉庫來使用。什么是數(shù)據(jù)倉庫呢? 簡單來說就像一個大糧倉,里邊堆著各種各樣的糧食,比如小麥、玉米、土豆、大米等等。數(shù)據(jù)倉庫里是一個數(shù)據(jù)集合體,把不同數(shù)據(jù)源按照一定的形式集合統(tǒng)一起來。 Hive本身是不做數(shù)據(jù)存儲的,它是構建在分布式存儲系統(tǒng)HDFS之上,我們平常看到的表數(shù)據(jù)其實本質(zhì)上來說還是HDFS的文件。 Hive把這些HDFS數(shù)據(jù)文件,通過元數(shù)據(jù)規(guī)則映射為數(shù)據(jù)庫的表,并且可以提供SQL操作的功能。 Hive總體結構比較簡單,下方是整體的hive架構圖,我們可以看到,總體有三個組件:用戶接口、元數(shù)據(jù)系統(tǒng)、驅(qū)動器。

用戶通過用戶接口來輸入操作指令。一般接口有三種形式:

- CLI端:一般在linux服務器直接輸入hive即可進入;

- WEB模式:通過命令bin/hive --service hwi啟動,默認訪問9999端口;

- 遠程模式:一般是JDBC之類的編程接口;

Hive的核心在于驅(qū)動器,一般驅(qū)動器接收到用戶接口傳遞的一條SQL之后,會進行下面的一系列操作:

- 驅(qū)動器開始進行語法和語義分析

- 生成邏輯計劃并且邏輯優(yōu)化

- 生成物理計劃

- 發(fā)送計劃到執(zhí)行引擎(常用引擎有mapredue和sprk)執(zhí)行

結果返回

而元數(shù)據(jù)系統(tǒng)一般傳統(tǒng)數(shù)據(jù)庫來承載,主要記錄了包括hive表的名字,表的列和分區(qū)及其屬性,表的屬性(是否為外部表等),表的數(shù)據(jù)所在目錄等。

常用hive語法

了解了hive的基礎原理之后呢,我們這里結合工作中一些需求,來介紹下開發(fā)同學常用的hive操作。

分組統(tǒng)計

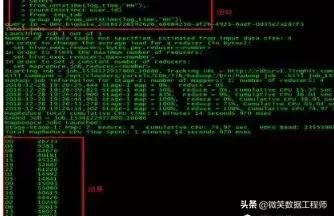

作為一名SQL仔,經(jīng)常會要去統(tǒng)計一些奇奇怪怪的指標,比如不同年齡段的UV,下單數(shù)的小時分布之類的。一般常用的分組就是group by了,然后配合上一些窗口函數(shù), SUM、AVG、MIN、MAX、COUNT等,就可以實現(xiàn)我們很多統(tǒng)計需求了。比如下邊的統(tǒng)計時間段的獨立用戶數(shù),查詢結果如下圖所示:

關聯(lián)查詢

有時候我們查詢的數(shù)據(jù)存放在不同的表中,那關聯(lián)查詢就派上用場了。所謂關聯(lián)查詢,一般就是通過兩張表相同的字段值關聯(lián)起來,同時查詢兩張表的記錄。Hive中常用關聯(lián)分內(nèi)外關聯(lián)。

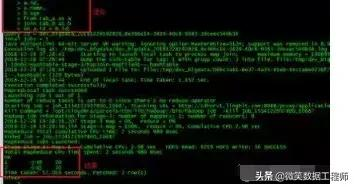

我們先建立兩張簡單的表tab_a和tab_b,用實例來說明關聯(lián)機制。表結構和表數(shù)據(jù)如下圖所示:

內(nèi)關聯(lián)一般使用 關鍵字Join或inner join ,內(nèi)關聯(lián)只返回關聯(lián)上的結果。

外關聯(lián)的形式就比較多樣化了,又分為:

- 左外關聯(lián):關鍵字為left [outer] join,以前邊的表為主表,返回記錄數(shù)和主表記錄一致,關聯(lián)不上的字段為null;

- 右外關聯(lián):關鍵字為right [outer] join,和左外關聯(lián)相反,則是以后邊的表為主表。

- 全外關聯(lián):full [outer] join,返回兩個表的去重之和,關聯(lián)不上的字段為null。

行列轉(zhuǎn)換

有時候我們會遇到這樣的需求,需要把多列的數(shù)據(jù)平鋪到一行上輸出。比如查詢用戶的訪問軌跡,這時候有兩個函數(shù)就起上作用了。還是讓我們先來看看效果。

這兩個sql的作用都是把每個用戶的點擊軌跡拼接暫展示出來,其中collect_set和collect_set能夠把列數(shù)據(jù)合并,轉(zhuǎn)為一行。而兩個的區(qū)別就是collect_set會進行去重。

上述講的是行轉(zhuǎn)列,還有些需求,希望我們能把列數(shù)據(jù)拆分成多行,比如數(shù)據(jù)結構如下,

Page_id StringAd_id Array

- A[1,2,3]

- B[3,5,6]

- C[2,4,5]

要統(tǒng)計每個廣告在所有頁面出現(xiàn)的次數(shù),這時候,我們可以先把同一列的數(shù)據(jù)線拆成多行,hive提供了explode展開函數(shù),具體效果如下圖:

Explode一般配合lateral view使用,把字段內(nèi)容鋪開成虛擬視圖。接下來我們再這個基礎之上,就可以使用統(tǒng)計函數(shù)來進行分析。

取TopN記錄

給數(shù)據(jù)分組排序再取前幾條記錄,也是我們較為常見的需求。hive提供了row_number函數(shù),可以對排序值進行編號。舉個栗子,要取省份的溫度較高的城市,數(shù)據(jù)如下:

- 省份城市溫度

- 廣東佛山34

- 廣東廣州30

- 江西贛州31

- 江西南昌28

- 江西萍鄉(xiāng)29

- 湖南長沙26

- 湖南衡陽25

我們可以使用row_number()組合group by的形式,來進行組內(nèi)排序,并且返回順序值rank。

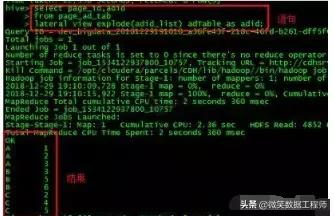

結果如下圖所示:

此時,如果要去top1的數(shù)據(jù),只需添加rank為1的條件即可。和row_number功能和用法類似的函數(shù)還有rank()和dense_rank(),區(qū)別在返回的排序rank值有細微區(qū)別,此處不再贅述。

Hive進階

數(shù)據(jù)傾斜

在我們數(shù)據(jù)清洗過程中,經(jīng)常會出現(xiàn)一種現(xiàn)象,分布式任務一般會分成多個小任務task,但是呢,有些task處理的很快,有些task就很慢,有時候甚至會卡死導致整個任務失敗,這種現(xiàn)象就是惡名遠揚的數(shù)據(jù)傾斜。之所以導致數(shù)據(jù)傾斜,大部分是join、去重統(tǒng)計(count distinct)或者group by操作中的key分布不均勻。拿最常見的hive查詢引擎mapreduce來說,基本就是shuffle階段,有些reduce任務獲取到的key數(shù)據(jù)量十分多,導致處理很緩慢。

為了避免數(shù)據(jù)傾斜,一般從兩種方向去解決:

1.調(diào)整hive參數(shù)

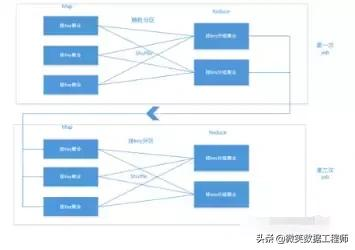

我們可以設置hive.map.aggr和hive.groupby.skewindata兩個參數(shù)為true,此時hive會生成兩個job任務,job先將key進行隨機化處理,第二個job在進行真正的shuffle key。如下流程說明圖:

從上圖可以看出,由于多次在map端聚合,使得最終shuffle時的數(shù)據(jù)量大大減少,從而減輕了數(shù)據(jù)傾斜的程度。

2.優(yōu)化SQL

使用mapJoin:我們經(jīng)常會有大小表join的需求,而這也是數(shù)據(jù)傾斜的多發(fā)區(qū)。此時我們可以使用mapJoin的方式,從而避免shuffle。具體實現(xiàn)就是把小表在每一個Map任務內(nèi)存中保存一份,從而直接在Map就進行join操作。沒了reduce過程,自然也避免了數(shù)據(jù)傾斜。在hive0.11版本之前,需要顯示聲明啟動該優(yōu)化操作,如下示例SQL所示:Select /+ MAPJOIN(small_tab)/ .key,value FROM small_tab JOIN big_tab ON small_tab.key = big_tab.key 而在hive0.11版本之后,hive能夠自動檢測小表,自行進行mapJoin優(yōu)化。我們可以通過hive.mapjoin.smalltable.filesize參數(shù)手動配置小表的閾值(默認值25M)。使用MapJoin有一個缺點在于內(nèi)存會浪費,因為每個Map端都有一個副本。所以mapJoin也一般只適合大小表join的情況。

異常值、特殊值手動處理:很多時候造成數(shù)據(jù)傾斜的可能是一些空值或者,字符串導致的。我們可以通過過濾空值或者對空值做隨機字符串處理,由此避免空值的影響。

如果是大表和大表的join產(chǎn)生了數(shù)據(jù)傾斜,mapJoin這種方式不太合適,但是在某些場景下,其中一個大表可以被處理成小表。比如,我們要查詢單日訪客瀏覽記錄,并需要附加用戶信息。這時候要和用戶大表user_info關聯(lián),而單日訪客記錄量user_flow也比較大,并不能直接使用mapjoin的方式。但仔細分析,單日訪客UV其實并不大,可以先進行簡單去重,轉(zhuǎn)換為小表進而可以使用mapJoin。

具體SQL如下所示:

- select /+mapjoin(x)/ from user_flow a left outer join (select /+mapjoin(c)/d. from ( select distinct user_id from user_flow )c join user_info d on c.user_id = d.user_id) x on a.user_id = b.user_id;

優(yōu)勢和不足

Hive目前作為業(yè)內(nèi)使用最為廣泛的數(shù)據(jù)倉庫工具,自然有著很多優(yōu)點: 高可靠、容錯性高、擴展性強。

HQL語法和傳統(tǒng)SQL類似,且內(nèi)置大量處理函數(shù)支持的存儲格式種類多,兼容性強。用戶接口多,支持各種形式的調(diào)用。但是hive也有它自身的一些不足,比如:

OLTP支持不足,不支持事務,目前只有比較新的版本才可以實現(xiàn)行列級別更新且對格式要求嚴格。

由于HDFS特性數(shù)據(jù)處理延遲高效率較低。HQL的表達能力和靈活性方面有限。基于這些優(yōu)缺點,hive有它自身擅長的領域,比如用作離線數(shù)據(jù)倉庫,批量處理海量數(shù)據(jù)。如果要追求實時性或者要高效率處理小量數(shù)據(jù),目前來看,其他新的技術方案,比如kudu、hbase等或許是更好的選擇。