神仙打架激辯深度學(xué)習(xí):LeCun出大招,馬庫斯放狠話

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

AI學(xué)術(shù)圈,又吵了起來,圖靈獎得主、年近古稀的機器學(xué)習(xí)奠基者、唱衰AI的代表人物等等,紛紛下場“開懟”。

相關(guān)話題在Twitter上轉(zhuǎn)發(fā)過千,點贊數(shù)萬,場面極其激烈。

究其源頭,起于一個直擊靈魂的問題:什么是深度學(xué)習(xí)?

什么是深度學(xué)習(xí)?

你可能會很自然地想起那段再熟悉不過的定義:

深度學(xué)習(xí)(DL)是一類機器學(xué)習(xí)算法,使用多個層逐步從原始數(shù)據(jù)中提取更高層的特征。

——維基百科

有點懵逼?

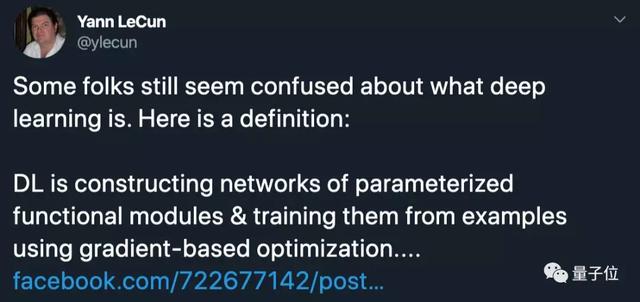

現(xiàn)在,有人給出了更明確的說法,出手者不是旁人,正是深度學(xué)習(xí)三巨頭之一,圖靈獎得主Yann LeCun。他說:

有些人似乎仍然對什么是深度學(xué)習(xí)感到困惑。以下是深度學(xué)習(xí)的定義:深度學(xué)習(xí)就是構(gòu)建由參數(shù)化功能模塊構(gòu)成的網(wǎng)絡(luò),并利用基于梯度的優(yōu)化方法進行樣本訓(xùn)練。

與此定義正交的是學(xué)習(xí)范式:強化學(xué)習(xí)、監(jiān)督學(xué)習(xí)或自監(jiān)督學(xué)習(xí)。不要說“深度學(xué)習(xí)沒法做X” ,如果你真正想的是“監(jiān)督學(xué)習(xí)需要太多數(shù)據(jù)所以沒法做X”。

對于其擴展形態(tài)(動態(tài)網(wǎng)絡(luò)、可微編程、圖神經(jīng)網(wǎng)絡(luò)等),網(wǎng)絡(luò)結(jié)構(gòu)可以依數(shù)據(jù)動態(tài)變化。

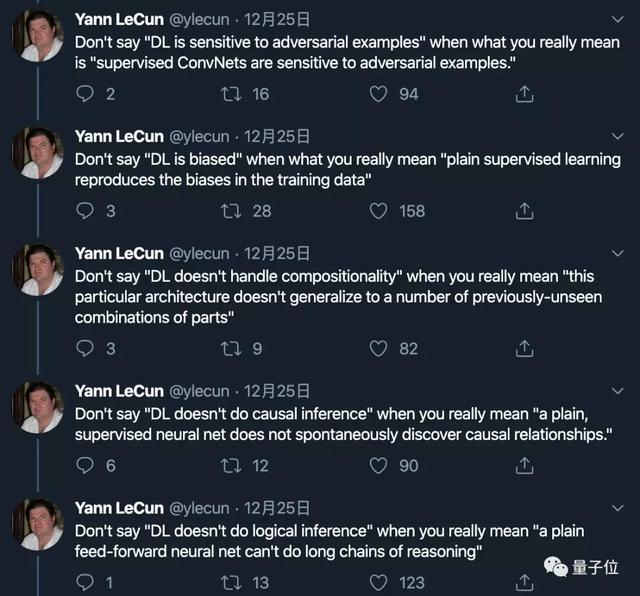

這話之后還沒完,他又一口氣放出了5個排比句,對當(dāng)前深度學(xué)習(xí)領(lǐng)域出現(xiàn)的“術(shù)語”進行了解讀:

別說“DL對對抗樣本很敏感”,你真正的意思是“受監(jiān)督的卷積神經(jīng)網(wǎng)絡(luò)對對抗樣本很敏感”。

別說“DL存在偏見”,你真正的意思是“純監(jiān)督學(xué)習(xí)再現(xiàn)了訓(xùn)練數(shù)據(jù)中的偏見”。

別說“DL無法處理組合性”,你真正的意思是“此特定體系結(jié)構(gòu)不能推廣到許多以前不可見的部件組合”。

別說“DL不做邏輯推理”,你真正的意思是“一個簡單的前饋神經(jīng)網(wǎng)絡(luò)不能做長鏈的推理”。

別說“DL不做因果推理”,你真正的意思是“一個普通的、有監(jiān)督的神經(jīng)網(wǎng)絡(luò)不會自發(fā)地發(fā)現(xiàn)因果關(guān)系。”

本來是對自己去年初提出的觀點——“深度學(xué)習(xí)不再是流行概念”進行了一次回應(yīng)。

但誰能想到,推文一出,各路大神紛紛出面發(fā)表觀點,展開了激烈的討論。

一場大型“互懟現(xiàn)場”就此拉開序幕。

機器學(xué)習(xí)奠基人下場激辯

馬庫斯開杠LeCun

第一批下場的,有DeepMind的高級研究科學(xué)家Danilo Jimenez Rezende。

他點贊認同,對Yann LeCun的觀點進行了簡要總結(jié):

深度學(xué)習(xí)是用于構(gòu)建復(fù)雜模塊化可微函數(shù)的工具的集合。討論深度學(xué)習(xí)能做或不能做什么毫無意義。真正有意義的是如何訓(xùn)練它,以及如何把數(shù)據(jù)喂給它。

但知名AI“杠精”——馬庫斯看到這條推特,當(dāng)場不干了:

如果不能討論一種方法可以做什么不能做什么,那它還算是一種方法?

推崇深度學(xué)習(xí)的人現(xiàn)在為了不被批評,總是在盡量避免提出具體、可驗證的主張。這是有一個很危險的信號。

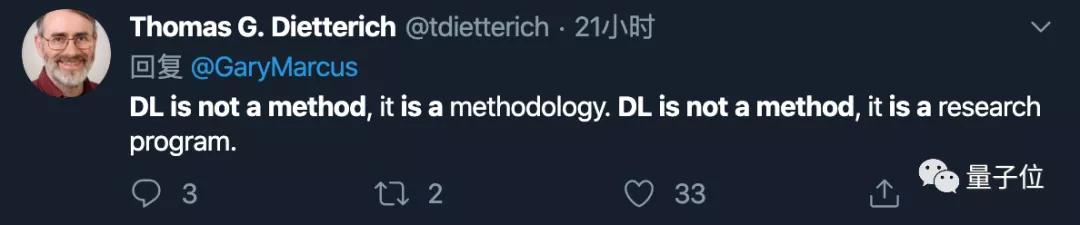

機器學(xué)習(xí)先驅(qū)下場反擊:深度學(xué)習(xí)是方法論

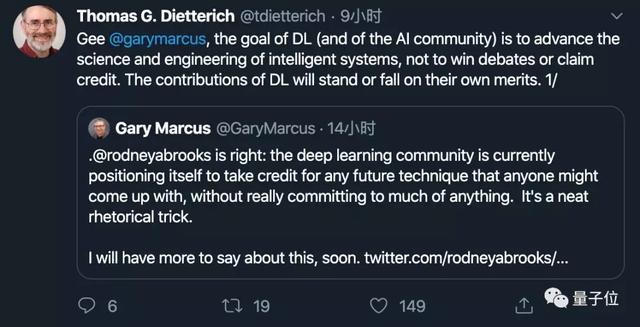

對此,機器學(xué)習(xí)領(lǐng)域奠基人之一、AAAI前主席Thomas G. Dietterich迅速下場回擊:

深度學(xué)習(xí)本來就不是一種方法,而是方法論。是一種研究路徑。

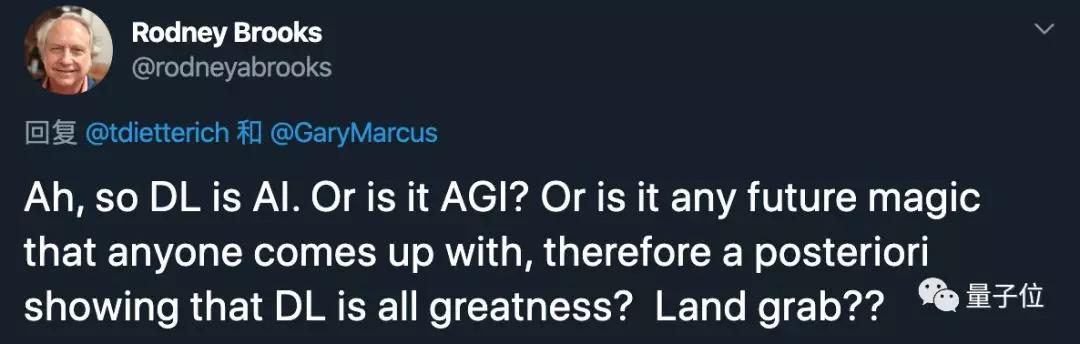

結(jié)果,這一辯論分會場又炸出了另一位大佬——機器人教父Rodney Brooks。

他說:啊,所以深度學(xué)習(xí)是AI還是AGI哇?還是說人能想到的未來科技都基于深度學(xué)習(xí)?

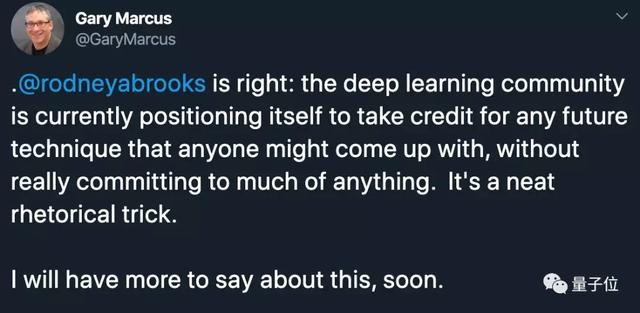

這一發(fā)言似乎又點燃了馬庫斯新的戰(zhàn)斗熱情:

Rodney Brooks說得對啊!深度學(xué)習(xí)社區(qū)現(xiàn)在給自己的定位就是所有未來科技都將歸功于DL,但他們并沒有真正致力于任何事情。

等著吧,我馬上就會火力全開。

面對這樣的“挑釁”,Dietterich表示圖樣圖森破:DL(以及AI社區(qū))的目標(biāo)是推動智能系統(tǒng)的科學(xué)和工程進步,而不是成為嘴炮王者。

深度學(xué)習(xí)沒有定義“是什么”,而是“如何進行”

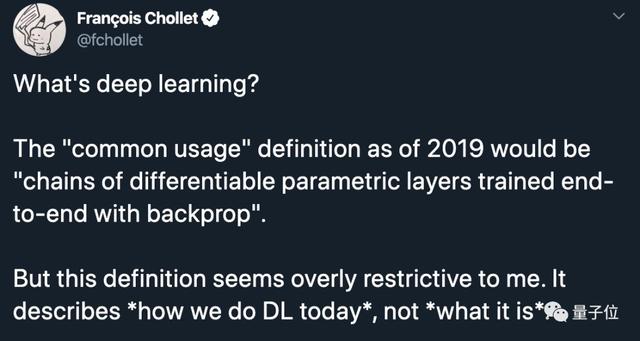

在各方互懟之外,Keras創(chuàng)造者François Chollet也另開新帖,對“什么是深度學(xué)習(xí)”發(fā)表了觀點。

他認為,截至現(xiàn)在,深度學(xué)習(xí)的定義對他來說過于“嚴格”。并且和以下情況是相反的:

⑴ 非表征性學(xué)習(xí)(如SIFT、symbolic AI等人工特征工程);

⑵ “淺層學(xué)習(xí)(shadow learning)”,其中只有一個特征提取層。

此外,它沒有規(guī)定一個特定的學(xué)習(xí)機制(如反向傳播)或一個特定的用例(如監(jiān)督學(xué)習(xí)或強化學(xué)習(xí)),也不需要端到端的聯(lián)合學(xué)習(xí)。

現(xiàn)在的定義描述的是我們該如何進行深度學(xué)習(xí),而不是它是什么。

而現(xiàn)在的深度學(xué)習(xí)的定義,只是給出了一個比較清晰邊界:哪些是深度學(xué)習(xí),哪些不是。例如:

DNN是深度學(xué)習(xí),而遺傳編程、快速排序和支持向量機就不屬于深度學(xué)習(xí)。

單個的密集層(dense layer)不是深度學(xué)習(xí),而密集堆棧(dense stack)是深度學(xué)習(xí)。

K-means不是深度學(xué)習(xí),而堆疊K-means特征提取器是深度學(xué)習(xí)。

通常由人類工程師編寫的程序不是DL,參數(shù)化這樣的程序來自動學(xué)習(xí)一些常量仍然不是DL。

需要用一連串的特征提取器來進行表征學(xué)習(xí)。

François Chollet認為,深度學(xué)習(xí)模型只代表了很小很小的程序空間。

本來Chollet并未加入論戰(zhàn),誰知道還是被拉下了水。

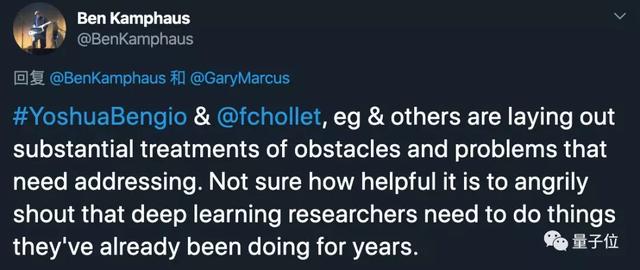

有好事網(wǎng)友Ben Kamphaus在馬庫斯的推文下,當(dāng)場@了他,還有另一位深度學(xué)習(xí)巨頭、圖靈獎得主Bengio,他說:

Bengio、Chollet以及其他人正在對需要解決的問題進行實質(zhì)性的處理了。

不知道那些憤怒高呼讓DL研究人員去做他們已經(jīng)做了很多年工作的人,對解決這個問題有什么幫助。

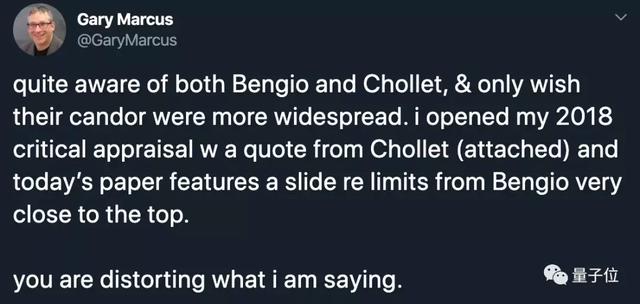

馬庫斯則坦然解釋說:

我很了解Bengio和Chollet,只是希望他們更坦率些。

你曲解我的意思了。

對于馬庫斯的這一說法,Bengio和Chollet都沒有給出直接回應(yīng)。

吃瓜群眾一臉懵逼

場面上,感覺大半個AI學(xué)術(shù)圈都下場爭鳴了。如此盛景,吃瓜群眾不免有些懵逼。

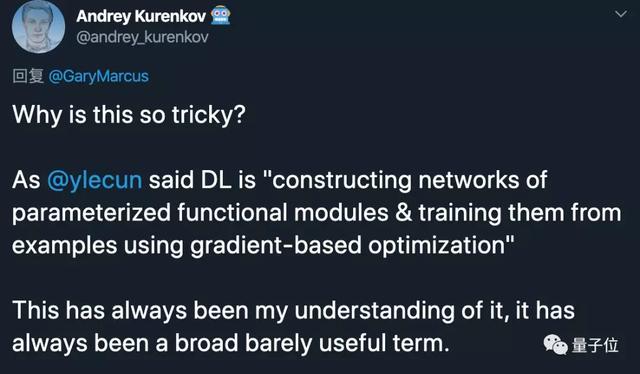

有人問:這個問題這么棘手的嗎?

當(dāng)然,還有一臉懵逼的。

那么,你是怎么看的呢?

第一現(xiàn)場傳送門

https://bit.ly/2ZqjKkA