深入解析Ceph分布式存儲的內核客戶端

隨著云計算的發展,Ceph已經成為目前最為流行的分布式存儲系統,儼然存儲界的Linux操作系統。Ceph集塊存儲、文件存儲和對象存儲于一身,適用場景廣泛,用戶眾多。本文是介紹Ceph客戶端在內核部分的實現的文章,本號特以翻譯成中文。

Ceph是一個開源,統一的分布式存儲系統,我們在Salesforce中用作塊存儲服務。Ceph的塊存儲通過一個客戶端模塊實現,這個客戶端可以直接從數據守護進程讀寫數據(不需要經過一個網關)。根據客戶端整合生態系統的差異(譯者注:也就是應用場景),客戶端有兩種實現方式:

- librbd (用戶態)

- krbd (內核態)

Librbd是一個典型的應用就是在虛擬機環境中(例如KVM或者QEMu),而krbd則是用在容器和裸金屬環境。在Salesforce, 我們將Ceph作為Docker容器并且在應用容器運行主機上安裝krbd模塊。

本文將描述Ceph內核客戶端的一些內部實現。下面是本文涵蓋的內容:

- 初始化

- Ceph的配置是如何被內核模塊獲取的

- 處理配置的代碼入口點

- 連接處理

- 安全

- 連接狀態機

krbd 初始化

krbd是一個內核模塊。其在內核中以一個塊設備的方式加以實現。整個Ceph客戶端都是以內核模塊的方式實現(沒有與之相關的用戶態進程或者守護進程)。

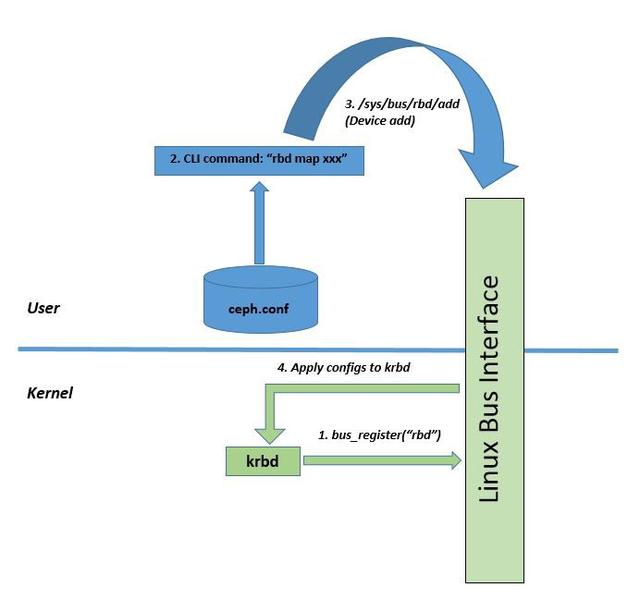

Ceph客戶端需要一個配置文件(ceph.conf)以知道如何連接集群,并且需要知道集群的屬性。該配置文件通常包括Monitor的IP地址、用戶證書和Ceph認證的安全屬性(Cephx)。在初始化的時候,所有這些配置都需要加載到內核模塊當中。一旦完成這一步,剩下的諸如鏡像或者卷生命周期、連接管理、認證和狀態機等所有實現都可以在內核模塊中完成。

將CEPH配置推送到內核模塊

當你運行ceph-deploy去安裝客戶端的時候,它將安裝在Ceph客戶端(以rbd為前綴的命令)CLI命令調用的二進制文件。

rbd CLI

第一個客戶端命令是:

- rbd map <device-name> --pool <pool_name>

默認情況下,rbd從配置文件/etc/ceph/ceph.conf中讀取配置信息。該文件包含諸如Monitor地址(客戶端通過該地址與Monitor聯系)、OSD閑時ttl、OSD超時時間、OSD請求超時和加密等內容。關于配置項的全量列表可以從這個地址獲取:http://docs.ceph.com/docs/jewel/man/8/rbd/#kernel-rbd-krbd-options。

OSD

krbd 初始化

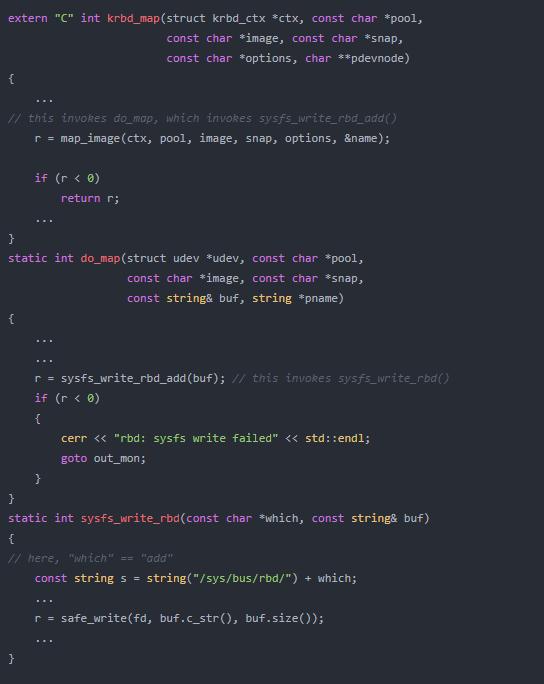

rbd map命令行命令實際上讀取ceph.conf文件的內容,并且通過Linux的“總線”接口(/sys/bus/

定義依賴這里: https://github.com/torvalds/linux/blob/master/include/linux/device.h

總線(bus)是處理器和一個或者多個設備間的通道。其目的是實現設備模型,所有設備由總線連接,甚至可以是一個內部的、虛擬的平臺(platform)總線。總線之間可以彼此連接,比如一個USB控制器通常是一個PCI設備。設備模型代表總線和它們所控制設備的實際連接。

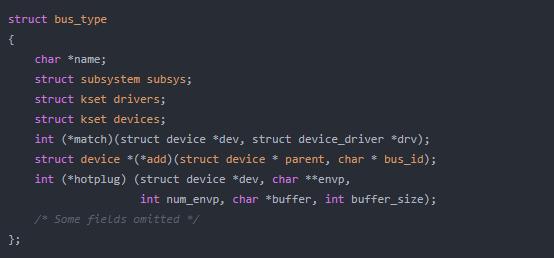

在Linux設備模型中,bus_type結構體代表一個總線,在linux/device.h中定義。該結構體如下:

本實現的源代碼在ceph/ceph git庫,具體如下:https://github.com/ceph/ceph/blob/master/src/krbd.cc

KRBD 配置解析

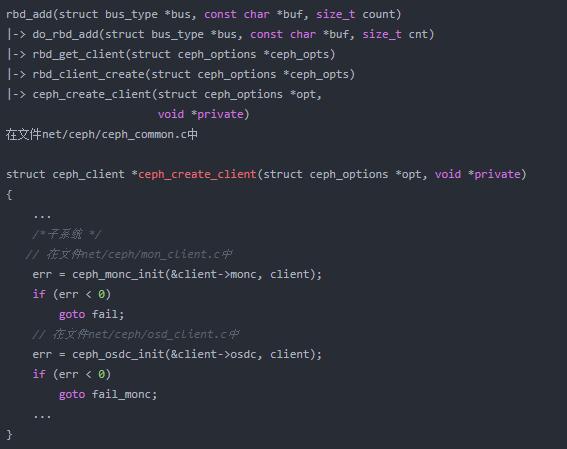

在內核模塊中,處理配置文件的入口點定義在drivers/block/rbd.c 中(https://github.com/ceph/ceph-client/blob/for-linus/drivers/block/rbd.c):

static ssize_t rbd_add(struct bus_type *bus, const char *buf, size_t count)

連接設置

內核模塊全權負責建立與Monitor和OSD的TCP連接,檢測這些連接,并且進行在出現問題的時候重建連接,以及認證工作。這些工作都是在內核中進行的。

Mon 客戶端初始化

入口函數: ceph_monc_init()

該函數首先通過掛載時提供的IP地址構建一個臨時的monmap(build_initial_monmap()) ,這個操作發生在客戶端與Monitor建立新連接的時候。之后,其初始化認證數據結構,進一步準備如下消息以完成連接后的初步握手:

- CEPH_MSG_MON_SUBSCRIBE (msg Id: 15)

- CEPH_MSG_MON_SUBSCRIBE_ACK (msg Id: 16)

- CEPH_MSG_AUTH (msg Id: 17)

- CEPH_MSG_AUTH_REPLY (msg Id: 18)

連接初始化

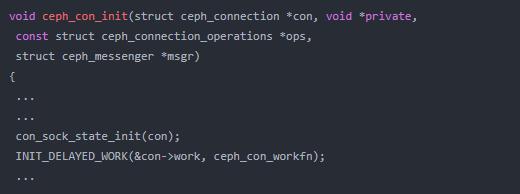

入口函數: ceph_con_init()

這時,調用ceph_con_init() (在net/ceph/messenger.c中) 函數完成與Monitor連接的初始化,并且通過一個狀態機轉換連接。ceph_con_init() 初始化套接字,發起一個工作隊列函數,該函數通過異步的方式實現連接的設置。

ceph_con_workfn() 函數通過如下套接字狀態(ceph_connection -> sock_state)遍歷連接,并將其轉換為ESTABLISHED狀態。

- /*

- * Socket state - transitions (connection state is different from socket state)

- * --------

- * | NEW* | transient initial state

- * --------

- * | con_sock_state_init()

- * v

- * ----------

- * | CLOSED | initialized, but no socket (and no

- * ---------- TCP connection)

- * ^ \

- * | \ con_sock_state_connecting()

- * | ----------------------

- * | \

- * + con_sock_state_closed() \

- * |+--------------------------- \

- * | \ \ \

- * | ----------- \ \

- * | | CLOSING | socket event; \ \

- * | ----------- await close \ \

- * | ^ \ |

- * | | \ |

- * | + con_sock_state_closing() \ |

- * | / \ | |

- * | / --------------- | |

- * | / \ v v

- * | / --------------

- * | / -----------------| CONNECTING | socket created,

- * | | / -------------- TCP connect

- * | | | initiated

- * | | | con_sock_state_connected()

- * | | v

- * -------------

- * | CONNECTED | TCP connection established

- * -------------

- *

- * State values for ceph_connection->sock_state; NEW is assumed to be 0.

- */

- /*

- * Connection state - transitions

- * --------

- * | CLOSED |<----<-----------------<-----------<-

- * -------- | | |

- * | | On failures | |

- * v | | |

- * -------- | | |

- * ---->| PREOPEN |---- | |

- * | -------- ^ ^

- * | | ceph_tcp_connect() | |

- * | v | |

- * ^ ------------- | |

- * | | CONNECTING |----------------------- |

- * | ------------- |

- * | | Read and process banner ("ceph v027"), |

- * | | prepare capabilities to send to peer |

- * | | |

- * | v |

- * | -------------- |

- * | | NEGOTIATING |----------------------------------

- * | --------------

- * ------- | Read connect_reply, auth capabilites

- * |STANDBY| | from peer

- * ------- |

- * | v

- * | -----

- * <----- |OPEN |--------------------------------------->

- * ----- (Complete final handshake ack)

- *

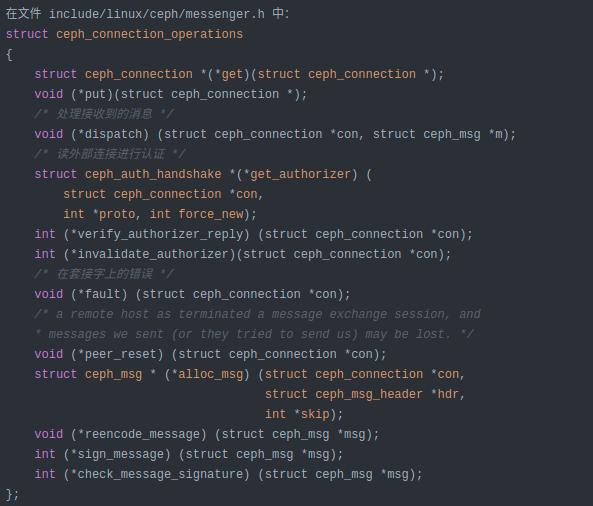

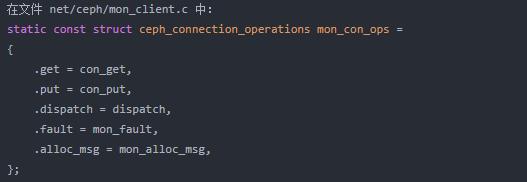

Connection Callback Registrations

下面是在include/linux/ceph/messenger.h中定義的數據結構,這個數據結構定義了在Monitor連接中處理連接事件的回調函數(包括連接到OSD的連接):

一旦客戶端完成連接,它將收到如下內容:

Mon map (ceph_monc_handle_map() 在 net/ceph/mon_client.c)

Osd map (ceph_osdc_handle_map() 在 net/ceph/osd_client.c)

如果Ceph客戶端的配置文件中包含集群中所有Monitor的信息,客戶端將與所有的Monitor建立連接。但是,如果在你的集群中有5個Monitor,但是配置文件中只有一個Monitor。這時,客戶端與配置文件中的這個Monitor建立連接。如果與Monitor的連接中斷,客戶端將隨機選取一個Monitor建立連接(客戶端通過其接收的monmap獲得所有Monitor的列表)。

當Monitor連接觸發創建OSD客戶端數據結構和連接的時候,客戶端會收到OSD map的信息。

krbd在內核的源碼目錄

源文件:

- drivers/block/rbd.c

- drivers/block/rbd_types.h

- net/ceph/

頭文件:

include/linux/ceph

包裝

本文深入介紹了Ceph客戶端krbd,并且介紹了其在內核中的實現。同時,還介紹了在內核中實現的客戶端的各種功能的入口函數。

總結(譯者注)

本文介紹了Ceph客戶端塊存儲部分的初始化和實現的部分細節。Ceph在內核中還有另外一部分,這部分就是大名鼎鼎的Ceph文件系統。這部分內容比較復雜,后面譯者將另外寫一篇文章進行介紹。

另外,這里需要補充的是,在Linux內核中Ceph的內容主要涉及3個方面,一個是krbd的實現(在 drivers/block/rbd.c中),也就是塊設備的實現;第二個是Ceph文件系統(在 fs/ceph目錄中)的實現,這里類似與NFS,它通過網絡的方式實現對Ceph集群分布式文件系統的訪問;第三個是網絡部分(在 net/ceph目錄中),這部分是公用的,塊設備和文件系統都用到了該部分的內容。