誰(shuí)說(shuō)RL智能體只能在線訓(xùn)練?谷歌發(fā)布離線強(qiáng)化學(xué)習(xí)新范式

為了避免 distribution mismatch,強(qiáng)化學(xué)習(xí)的訓(xùn)練一定要在線與環(huán)境進(jìn)行交互嗎?谷歌的這項(xiàng)最新研究從優(yōu)化角度,為我們提供了離線強(qiáng)化學(xué)習(xí)研究新思路,即魯棒的 RL 算法在足夠大且多樣化的離線數(shù)據(jù)集中訓(xùn)練可產(chǎn)生高質(zhì)量的行為。該論文的訓(xùn)練數(shù)據(jù)集與代碼均已開(kāi)源。機(jī)器之心友情提示,訓(xùn)練數(shù)據(jù)集共包含 60 個(gè)雅達(dá)利游戲環(huán)境,谷歌宣稱(chēng)其大小約為 ImageNet 的 60 x 3.5 倍。

「異策略學(xué)習(xí)的潛力依然很誘人,但實(shí)現(xiàn)它的最佳方式依然是個(gè)謎。」—Sutton & Barto(兩人為《強(qiáng)化學(xué)習(xí)導(dǎo)論》一書(shū)的作者)

多數(shù)強(qiáng)化學(xué)習(xí)算法都假設(shè)一個(gè)智能體主動(dòng)與在線環(huán)境交互,從它自己搜集的經(jīng)驗(yàn)中學(xué)習(xí)。這些算法在現(xiàn)實(shí)問(wèn)題中的應(yīng)用困難重重,因?yàn)閺默F(xiàn)實(shí)世界中進(jìn)一步搜集的數(shù)據(jù)可能樣本效率極低,還會(huì)帶來(lái)意想不到的行為。而那些在仿真環(huán)境中運(yùn)行的算法需要高保真模擬器,因此構(gòu)建起來(lái)非常困難。然而,對(duì)于許多現(xiàn)實(shí)世界中的強(qiáng)化學(xué)習(xí)應(yīng)用來(lái)說(shuō),之前已經(jīng)搜集了很多交互數(shù)據(jù),可以用于訓(xùn)練在上述現(xiàn)實(shí)問(wèn)題中可行的強(qiáng)化學(xué)習(xí)智能體,同時(shí)通過(guò)結(jié)合之前的豐富經(jīng)驗(yàn)來(lái)提高泛化性能。

現(xiàn)有的交互數(shù)據(jù)可以實(shí)現(xiàn)離線強(qiáng)化學(xué)習(xí)的有效訓(xùn)練,后者是完全的異策略(off-policy)強(qiáng)化學(xué)習(xí)設(shè)置,智能體從一個(gè)固定的數(shù)據(jù)集中學(xué)習(xí),不與環(huán)境進(jìn)行交互。

離線強(qiáng)化學(xué)習(xí)有助于:

1)使用現(xiàn)有數(shù)據(jù)預(yù)訓(xùn)練一個(gè)強(qiáng)化學(xué)習(xí)智能體;

2)基于強(qiáng)化學(xué)習(xí)算法利用固定交互數(shù)據(jù)集的能力對(duì)他們進(jìn)行實(shí)驗(yàn)評(píng)估;

3)對(duì)現(xiàn)實(shí)世界的問(wèn)題產(chǎn)生影響。然而,由于在線交互與固定數(shù)據(jù)集中的交互數(shù)據(jù)分布不匹配,離線強(qiáng)化學(xué)習(xí)面臨很大的挑戰(zhàn)。即,如果一個(gè)經(jīng)過(guò)訓(xùn)練的智能體采取了與數(shù)據(jù)收集智能體不同的行動(dòng),我們不知道提供什么樣的獎(jiǎng)勵(lì)。

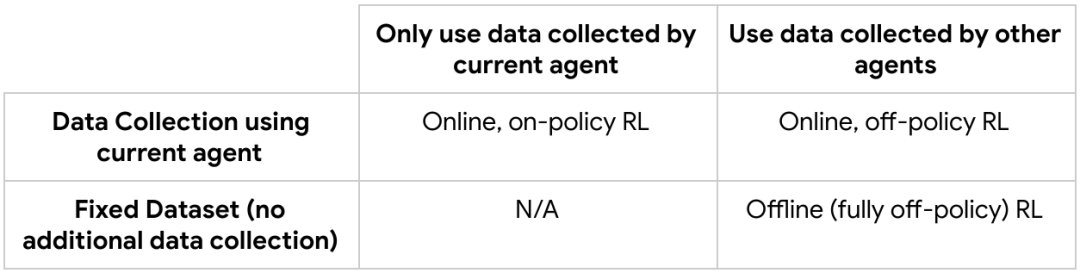

具有在線交互的 RL 與離線 RL 的流程圖比較。

在這篇名為「An Optimistic Perspective on Offline Reinforcement Learning」的論文中,根據(jù) DQN 智能體記錄下的經(jīng)驗(yàn),谷歌大腦團(tuán)隊(duì)的研究者提出了一種在 Atari 2600 游戲中進(jìn)行離線強(qiáng)化學(xué)習(xí)的簡(jiǎn)單實(shí)驗(yàn)設(shè)置。他們展示了不通過(guò)對(duì)任何錯(cuò)配分布的顯式修正,仍然可能訓(xùn)練出性能超越使用標(biāo)準(zhǔn)異策略 RL 算法收集數(shù)據(jù)的智能體。同時(shí),研究者還提出了一種魯棒的 RL 算法,在離線 RL 中表現(xiàn)出可觀的結(jié)果,稱(chēng)作隨機(jī)混合集成(random ensemble mixture,REM)。

總的來(lái)說(shuō),研究者提出一種全新的優(yōu)化角度,即魯棒的 RL 算法在足夠大且多樣化的離線數(shù)據(jù)集中訓(xùn)練可產(chǎn)生高質(zhì)量的行為,鞏固了新興的數(shù)據(jù)驅(qū)動(dòng) RL 范式。為促進(jìn)離線 RL 方法的開(kāi)發(fā)與評(píng)估,研究者公開(kāi)了他們的 DQN 回溯數(shù)據(jù)集并開(kāi)源了論文的代碼。

- 論文鏈接:https://arxiv.org/pdf/1907.04543.pdf

- 項(xiàng)目地址:https://github.com/google-research/batch_rl

異策略與離線強(qiáng)化學(xué)習(xí)基礎(chǔ)

不同 RL 算法匯總?cè)缦拢?/p>

在線的異策略 RL 智能體(如 DQN),僅通過(guò)接收來(lái)自游戲屏幕的圖像信息,不需要其他任何關(guān)于此游戲的知識(shí),在 Atari 2600 游戲中取得了與人類(lèi)玩家同等的表現(xiàn)。在一個(gè)給定的環(huán)境狀態(tài)下,DQN 根據(jù)如何最大化未來(lái)獎(jiǎng)勵(lì)(如 Q-values),對(duì)動(dòng)作的有效性進(jìn)行估計(jì)。

此外,當(dāng)前使用價(jià)值函數(shù)分布的 RL 算法(如 QR-DQN)對(duì)所有可能的未來(lái)獎(jiǎng)勵(lì)的分布進(jìn)行估計(jì),而不是為每個(gè)狀態(tài)-動(dòng)作對(duì)估計(jì)單一的期望價(jià)值。DQN 與 QR-DQN 這樣的智能體被看作是「在線」的算法,這是因?yàn)樗鼈冊(cè)趦?yōu)化策略與使用優(yōu)化后的策略去收集更多數(shù)據(jù)之間不斷交替迭代。

理論上異策略的 RL 智能體可以從任意策略收集的數(shù)據(jù)中進(jìn)行學(xué)習(xí),而不僅限于被優(yōu)化的那個(gè)策略。然而,最近的研究工作顯示,標(biāo)準(zhǔn)的異策略智能體在離線 RL 設(shè)定下將會(huì)發(fā)散或性能表現(xiàn)較差。為解決以上問(wèn)題,之前的研究提出了一種正則化學(xué)習(xí)到的策略的方法,來(lái)使其策略更新在離線交互數(shù)據(jù)集附近。

為離線 RL 設(shè)計(jì)的 DQN 回溯數(shù)據(jù)集

研究者首先建立了 DQN 回溯數(shù)據(jù)集來(lái)重新審視離線 RL。該數(shù)據(jù)集使用 DQN 智能體在 60 個(gè) Atari 2600 游戲中各訓(xùn)練兩億步得到,并使用了粘滯動(dòng)作(sticky action)來(lái)使問(wèn)題更具挑戰(zhàn)性,即有 25% 的概率執(zhí)行智能體之前的動(dòng)作,而不是當(dāng)前的動(dòng)作。

在這 60 個(gè)游戲中,對(duì)于每一個(gè)游戲,研究者訓(xùn)練 5 個(gè)具有不同初始化參數(shù)的 DQN 智能體,并將訓(xùn)練中產(chǎn)生的所有 (state, action, reward, next state) 元組儲(chǔ)存在 5 個(gè)回溯數(shù)據(jù)集中,總共產(chǎn)生 300 個(gè)數(shù)據(jù)集。

這個(gè) DQN 回溯數(shù)據(jù)集之后被用于訓(xùn)練離線 RL 智能體,訓(xùn)練過(guò)程中并不需要任何與環(huán)境的交互。每一個(gè)游戲回溯數(shù)據(jù)集大約是 ImageNet 的 3.5 倍,包含在優(yōu)化在線 DQN 時(shí)中間策略產(chǎn)生的所有樣本。

在 Atari 游戲中使用 DQN 回溯數(shù)據(jù)集的離線 RL。

在 DQN 回溯數(shù)據(jù)集上訓(xùn)練離線智能體

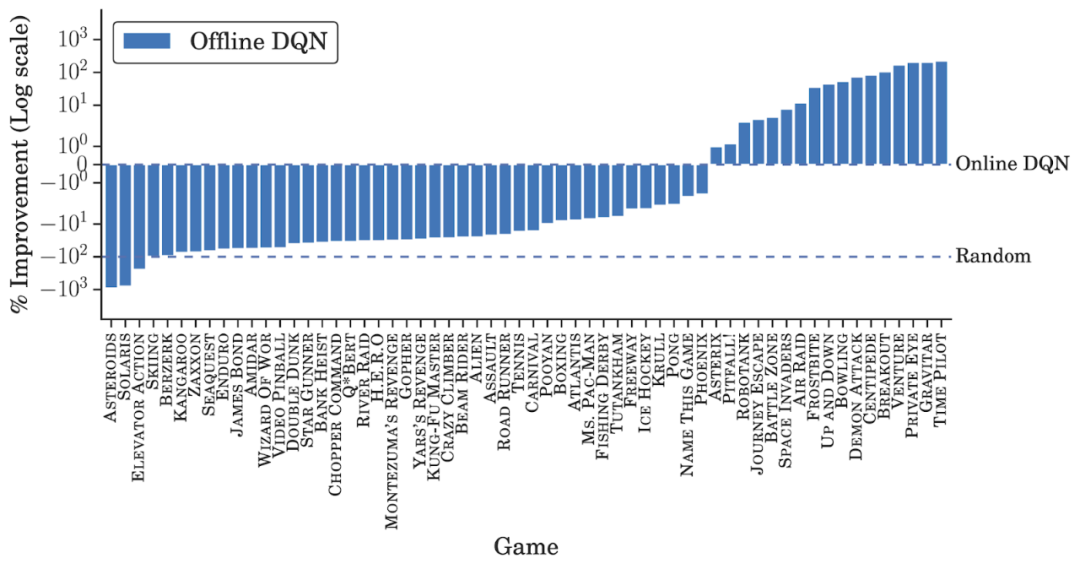

研究者在 DQN 回溯數(shù)據(jù)集上對(duì) DQN 和值函數(shù)分布 QR-DQN 的變體進(jìn)行訓(xùn)練。盡管離線數(shù)據(jù)集包含了 DQN 智能體經(jīng)歷過(guò)的數(shù)據(jù),并且這些數(shù)據(jù)會(huì)隨著訓(xùn)練進(jìn)程的推移而相應(yīng)地改善,研究者對(duì)離線智能體和訓(xùn)練后得到的 best-performing 在線 DQN 智能體(即完全訓(xùn)練好的 DQN)的性能進(jìn)行了比較。對(duì)于每一次游戲,他們使用在線 returns 對(duì)訓(xùn)練的 5 個(gè)離線智能體展開(kāi)了評(píng)估,并得出了最佳的平均性能。

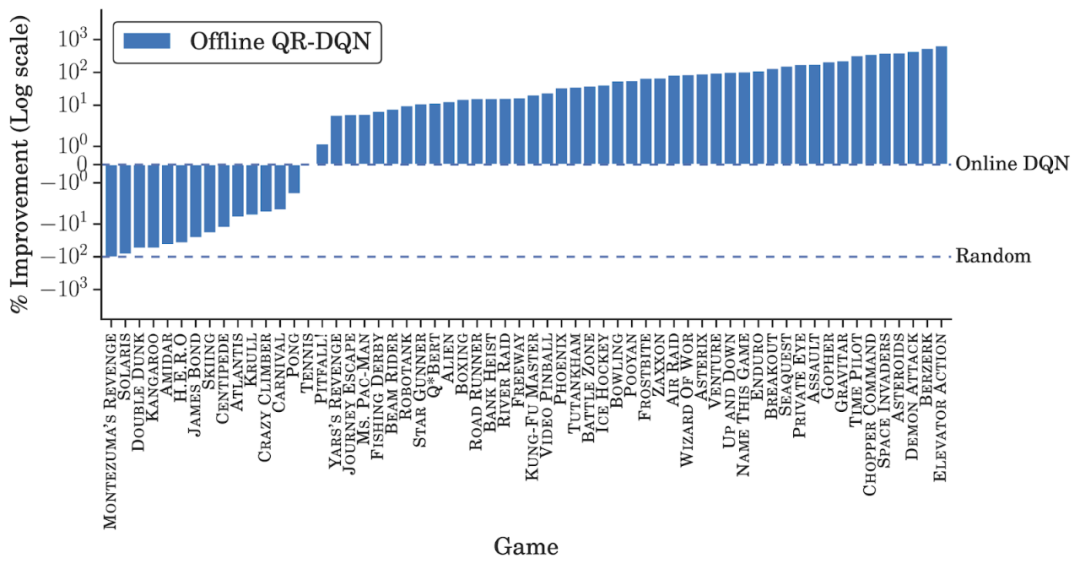

除了在少數(shù)游戲中相同數(shù)據(jù)量下得分高于完全訓(xùn)練(fully-trained)的在線 DQN 之外,離線 DQN 的表現(xiàn)均弱于后者。另一方面,離線 QR-DQN 在大多數(shù) game 中的表現(xiàn)優(yōu)于離線 DQN 和完全訓(xùn)練的 DQN。這些結(jié)果表明,利用標(biāo)準(zhǔn)深度 RL 算法來(lái)優(yōu)化強(qiáng)大的離線智能體是可能實(shí)現(xiàn)的。并且,離線 QR-DQN 和 DQN 的表現(xiàn)差距表明它們利用離線數(shù)據(jù)的能力也存在著差異。

離線 DQN 結(jié)果。

離線 QR-DQN 結(jié)果。

兩種魯棒的離線 RL 智能體

在在線 RL 中,一個(gè)智能體選擇它認(rèn)為會(huì)帶來(lái)高獎(jiǎng)勵(lì)(high reward)的動(dòng)作,然后會(huì)接收糾錯(cuò)性反饋(corrective feedback)。此外,由于在離線 RL 中無(wú)法收集額外數(shù)據(jù)(additional data),所以有必要使用一個(gè)固定的數(shù)據(jù)集來(lái)推理出泛化能力。借助于使用模型集成來(lái)提升泛化能力的監(jiān)督學(xué)習(xí)方法,研究者提出了以下兩個(gè)新的離線 RL 智能體:

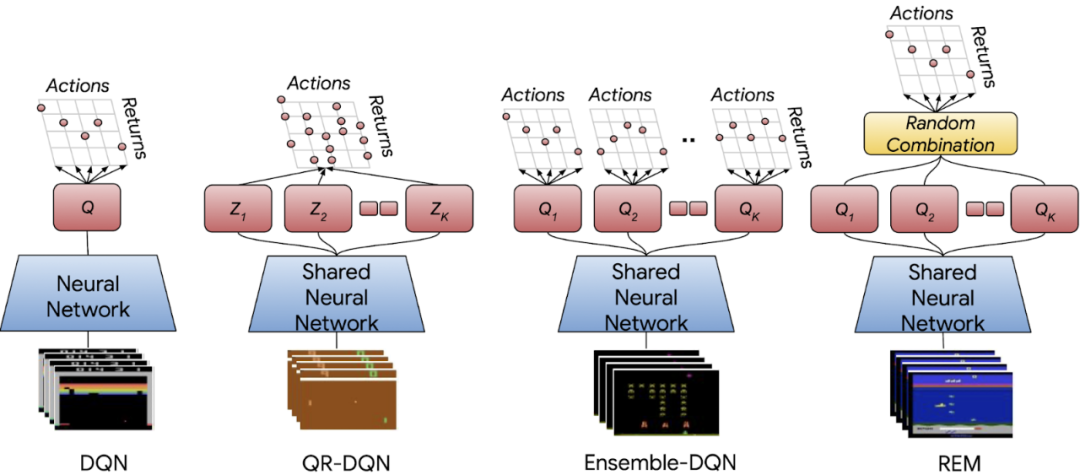

- 集成 DQN 是 DQN 的一個(gè)簡(jiǎn)單擴(kuò)展,它訓(xùn)練多個(gè) Q 值估計(jì)并取平均值來(lái)進(jìn)行評(píng)估;

- 隨機(jī)集成混合(Random Ensemble Mixture,REM)是一個(gè)易于實(shí)現(xiàn)的 DQN 擴(kuò)展,它受到了 Dropout 的啟發(fā)。REM 的核心理念是,如果可以得到 Q 值的多個(gè)估計(jì),則 Q 值估計(jì)的加權(quán)組合(weighted combination)也成為 Q 值的一個(gè)估計(jì)。因此,REM 在每次迭代中隨機(jī)組合多個(gè) Q 值估計(jì),并將這種隨機(jī)組合用于魯棒訓(xùn)練。

DQN、值函數(shù)分布 QR-DQN、具有相同多頭機(jī)制 QR-DQN 架構(gòu)的期望 RL 變體、集成 DQN 和 REM 的神經(jīng)網(wǎng)絡(luò)架構(gòu)。

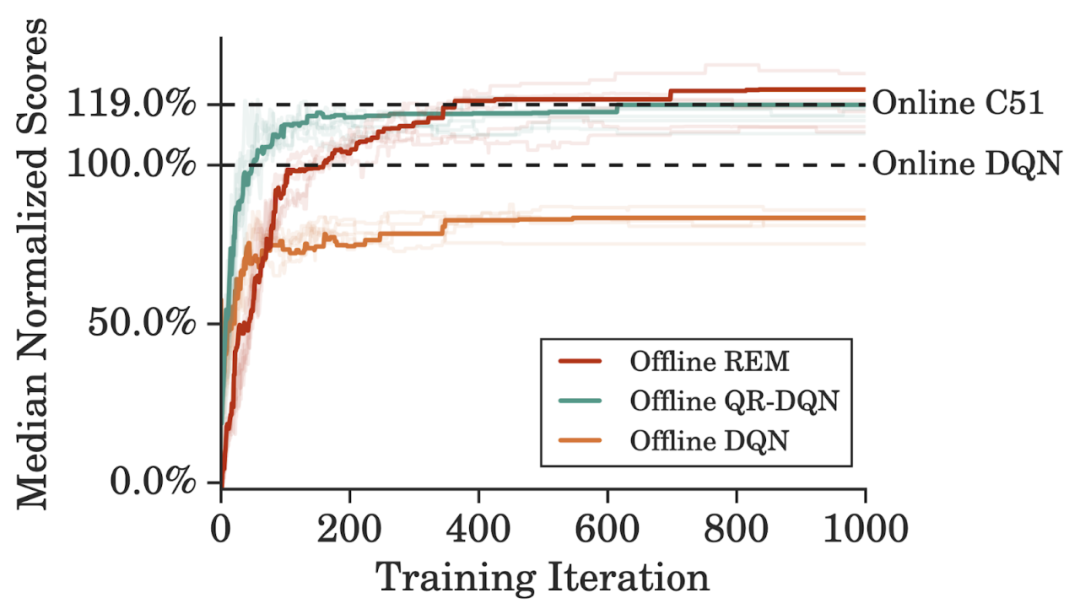

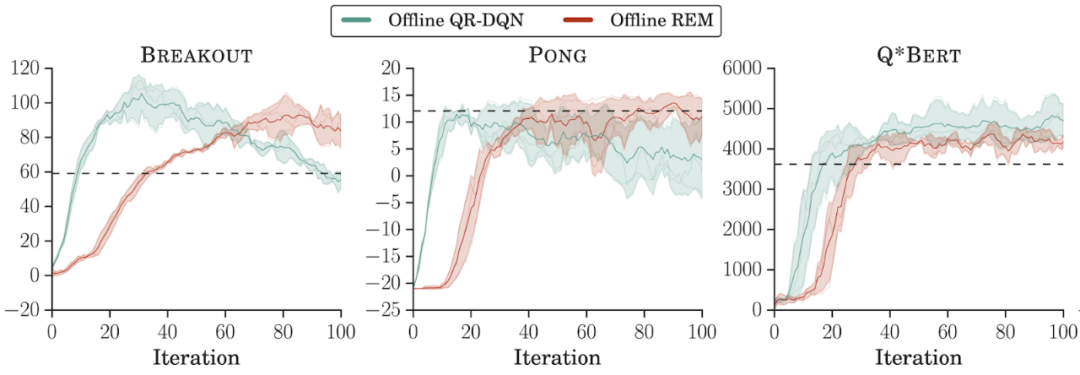

為了更高效地利用 DQN 回溯數(shù)據(jù)集,研究者在訓(xùn)練離線智能體時(shí)將訓(xùn)練迭代次數(shù)設(shè)置為在線 DQN 訓(xùn)練的 5 倍,性能表現(xiàn)如下圖所示。離線 REM 要優(yōu)于離線 DQN 和離線 QR-DQN。并且,與一個(gè)強(qiáng)大的值函數(shù)分布智能體,即完全訓(xùn)練的在線 C51 的性能比較表明,從離線 REM 獲得的增益要高于 C51。

離線 REM 與基線方法的性能比較。

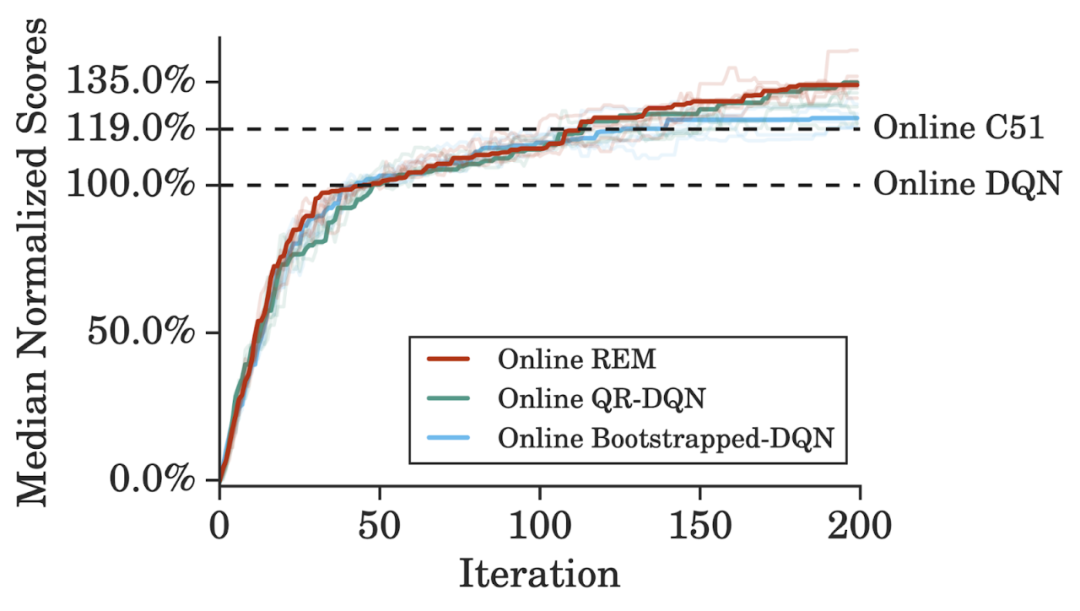

在 Atari 游戲中使用標(biāo)準(zhǔn)訓(xùn)練方案時(shí),在線 REM 在標(biāo)準(zhǔn)在線 RL 設(shè)置下的性能能夠與 QR-DQN 媲美。這表明我們可以利用從 DQN 回溯數(shù)據(jù)集和離線 RL 設(shè)置中獲得的 insight 來(lái)構(gòu)建有效的在線 RL 方法。

在線 REM 與基線方法的性能比較。

結(jié)果對(duì)比:離線強(qiáng)化學(xué)習(xí)中的重要因素

為什么之前的標(biāo)準(zhǔn)強(qiáng)化學(xué)習(xí)智能體在離線設(shè)置下屢屢失敗?谷歌研究者總結(jié)了他們的研究與之前研究的幾個(gè)重要差異:

- 離線數(shù)據(jù)集大小。谷歌訓(xùn)練離線 QR-DQN 和 REM 所用的數(shù)據(jù)集是通過(guò)隨機(jī)下采樣整個(gè) DQN 回溯數(shù)據(jù)集得到的簡(jiǎn)化數(shù)據(jù),同時(shí)保持了相同的數(shù)據(jù)分布。與監(jiān)督學(xué)習(xí)類(lèi)似,模型性能隨著數(shù)據(jù)集大小的增加而提升。REM 和 QR-DQN 只用整個(gè)數(shù)據(jù)集的 10% 就達(dá)到了與完全的 DQN 接近的性能;

- 離線數(shù)據(jù)集的組成。研究者在 DQN 回溯數(shù)據(jù)集每個(gè)游戲的前 2000 萬(wàn)幀上訓(xùn)練了離線強(qiáng)化學(xué)習(xí)智能體。離線 REM 和 QR-DQN 在這個(gè)低質(zhì)量數(shù)據(jù)集上的表現(xiàn)優(yōu)于最佳策略(best policy),這表明如果數(shù)據(jù)集足夠多樣,標(biāo)準(zhǔn)強(qiáng)化學(xué)習(xí)智能體也能在離線設(shè)置下表現(xiàn)良好;

- 離線算法的選擇。有人認(rèn)為,在離線狀態(tài)下訓(xùn)練時(shí),標(biāo)準(zhǔn)異策略智能體在連續(xù)控制任務(wù)中會(huì)表現(xiàn)不佳。然而,谷歌研究者發(fā)現(xiàn),最近的連續(xù)控制智能體(如 TD3)在大型、多樣化離線數(shù)據(jù)集上訓(xùn)練時(shí),其性能與復(fù)雜離線智能體相當(dāng)。

用較低質(zhì)量數(shù)據(jù)集在離線設(shè)置下訓(xùn)練強(qiáng)化學(xué)習(xí)智能體。

展望

谷歌的這項(xiàng)研究表明,在從大量不同策略的離線數(shù)據(jù)中學(xué)習(xí)時(shí),需要對(duì)神經(jīng)網(wǎng)絡(luò)泛化的作用進(jìn)行嚴(yán)格描述。另一個(gè)重要的方向是通過(guò)對(duì) DQN 回溯數(shù)據(jù)集進(jìn)行下采樣,利用各種數(shù)據(jù)收集策略對(duì)離線 RL 進(jìn)行基準(zhǔn)測(cè)試。

谷歌研究者目前采用的是在線策略評(píng)估,然而「真正的」離線 RL 需要離線策略評(píng)估來(lái)進(jìn)行超參數(shù)調(diào)優(yōu)和早停。最后,基于模型的 RL 和自監(jiān)督學(xué)習(xí)方法也有望用于離線 RL。