在理解通用逼近定理之前,你都不會理解神經網絡

神經網絡力量背后的證據

從字面上看,通用近似定理是神經網絡起作用的理論基礎。 簡而言之,它聲明了一個神經網絡,其中具有一個包含足夠但有限數量的神經元的隱藏層,可以在激活函數的某些條件下(即,它們必須像S型一樣)以合理的精度近似任何連續函數。

由George Cybenko于1989年制定,僅適用于S型曲線激活,并于1991年由Kurt Hornik證明適用于所有激活函數(神經網絡的體系結構而不是功能的選擇是性能背后的驅動力),它的發現是一個重要的驅動力 促使神經網絡的激動人心的發展成為當今使用它們的眾多應用程序。

然而,最重要的是,該定理令人驚訝地解釋了為什么神經網絡似乎表現得如此聰明。 理解它是發展對神經網絡的深刻理解的關鍵一步。

更深入的探索

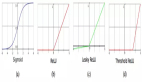

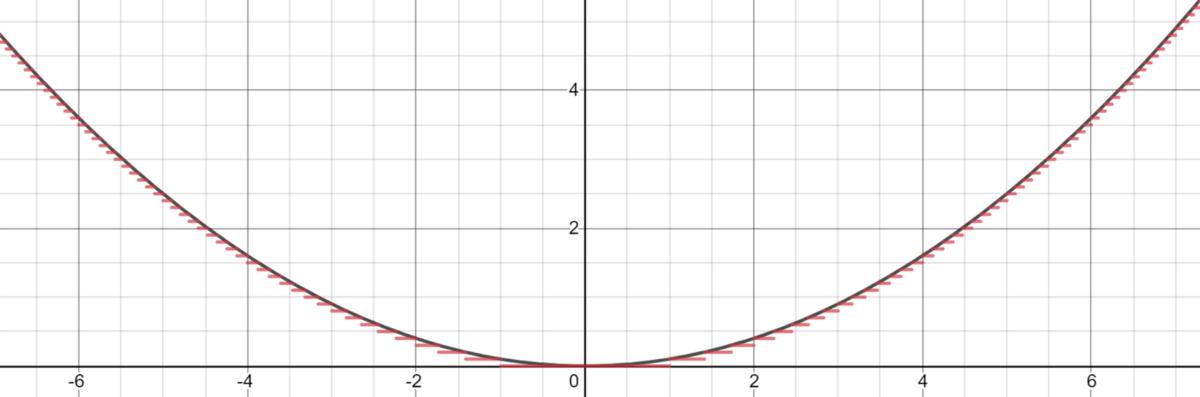

緊湊(有界,封閉)集合上的任何連續函數都可以通過分段函數來近似。 以-3和3之間的正弦波為例,可以很令人信服地用三個函數(兩個二次函數和一個線性函數)近似。

> Graphed in Desmos.

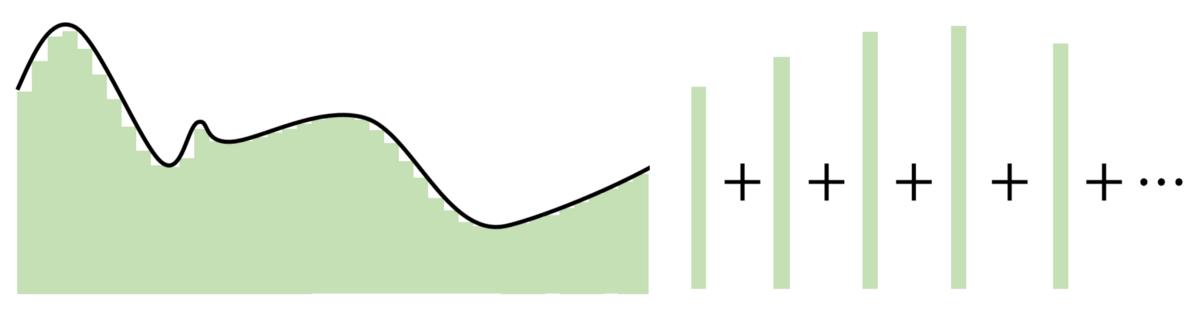

Cybenko對于此分段函數更為具體,因為它可以是恒定的,基本上由適合該函數的幾個步驟組成。 有了足夠的恒定區域("步長"),就可以在給定的范圍內合理估計函數。

> Graphed in Desmos.

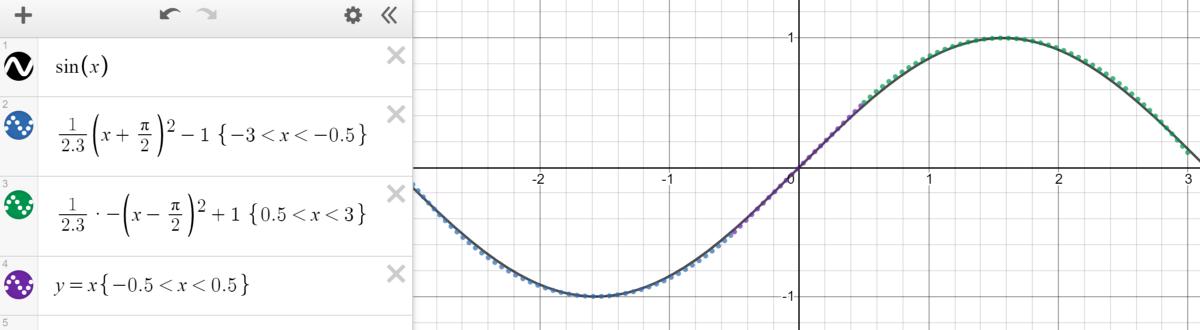

基于這種近似,可以通過將每個神經元委托給一個"步驟"來構建網絡。 使用權重和偏差作為"門"來確定哪個輸入下降,從而確定哪個神經元應該被激活,具有足夠數量神經元的神經網絡可以簡單地將一個函數分為幾個恒定區域來估計一個函數。

對于落入神經元委托區域的輸入,通過將權重分配到巨大的值,最終值將接近1(使用S型函數進行評估時)。 如果未落入該部分,則將權重移向負無窮大將產生接近0的最終結果。使用S形函數作為各種"處理器"來確定神經元的存在程度,幾乎可以近似任何函數 完美地給出了豐富的神經元。 在多維空間中,Cybenko推廣了這種想法,每個神經元"控制"多維函數中的空間超立方體。

通用逼近定理的關鍵在于,與其在輸入和輸出之間創建復雜的數學關系,不如使用簡單的線性操作將復雜的功能劃分為許多小的,較不復雜的部分,每個部分都由一個神經元獲取。

> Image created by Author.

> Image created by Author.自Cybenko的初步證明以來,已經做出了許多其他改進,例如針對不同的激活函數(例如ReLU)(無邊(在一側)或具有各種體系結構(遞歸,卷積等)測試通用逼近定理)。

無論如何,所有這些探索都圍繞著一個想法-神經網絡在數字上找到了優勢。 每個神經元監視特征空間的一個模式或區域,其大小取決于網絡中神經元的數量。 神經元越少,每個人需要監視的空間就越大,因此逼近能力會下降。 但是,有了更多的神經元,無論激活功能如何,任何功能都可以與許多小片段結合在一起。

泛化與外推

有人可能會指出,盡管如此簡單,但通用近似定理有點太簡單了(至少是概念)。 強大的神經網絡實際上可以是一個復雜的近似器,它可以分離數字,產生音樂,并且通常表現得很聰明。

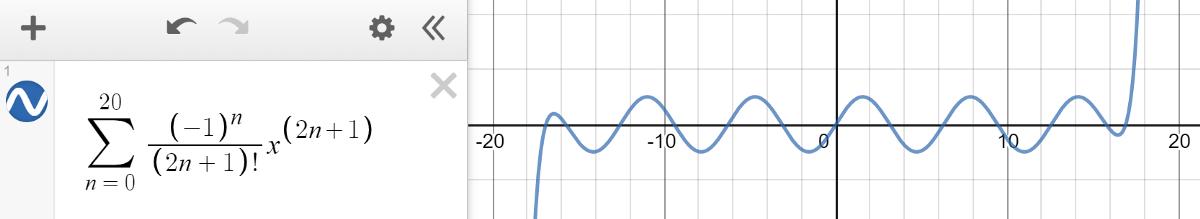

神經網絡的目的是在給定數據點采樣的情況下概括或建模復雜的數學函數。 它們是很好的近似值,但是一旦您請求輸入的值超出訓練有素的直接范圍,它就會慘遭失敗。 這類似于有限的泰勒級數逼近法,該方法令人信服地對一定范圍內的正弦波進行建模,但在其外部產生了混亂。

> Graphed in Desmos.

外推或在給定訓練范圍之外做出合理預測的能力并不是神經網絡的設計目標。 從通用逼近定理中,我們了解到神經網絡根本不是真正的智能,而只是隱藏在多維偽裝下的良好估計量,這使其功能(在兩三個維度上看起來很普通)似乎令人印象深刻。

神經網絡是否在受過訓練的范圍之外發生故障并不重要,因為那不是其目標。

定理的實際含義

由機器學習工程師的直覺和經驗來構造適合給定問題的神經網絡體系結構,以便在知道存在這樣的網絡的情況下,可以很好地近似多維空間,還可以平衡計算賬單的真實性。 是。 該定理讓機器學習工程師知道總會有一個解決方案。