AI將光子時間轉換成3D圖像,通過時間來可視化世界

近日,由格拉斯哥大學計算科學學院數據科學研究員Alex Turpin博士帶領的研究團隊研究團隊開發了一種嶄新的3D成像方法:通過捕獲有關光子的時間信息而不是其空間坐標來成像。

這種方法通過利用AI將時間轉換成三維空間的視覺,可以幫助汽車、移動設備和健康監護儀器等提高360度的認知能力。

此項研究「Spatial images from temporal data」目前已在Optica雜志上發表。

論文鏈接:https://arxiv.org/pdf/1912.01413.pdf

通過光子的時間信息生成3D圖像,成像速度快

在我們生活中,照片和視頻通常是通過使用數字傳感器捕獲光子(光的構建基塊)來制作的。比如,數碼相機由數百萬個像素組成,這些像素通過檢測空間每個點的光的強度和顏色來形成圖像。

然后,通過在拍攝對象周圍放置兩個或更多攝像機可以從多個角度對其進行拍攝,或者通過使用光流掃描場景并將其重構三維來生成3D圖像。

無論哪種方式,我們拍攝的照片和視頻僅通過收集場景的空間信息來構建圖像。

而研究人員此次是通過有關光子的時間信息來生成3D圖像,他們是如何做到的呢?

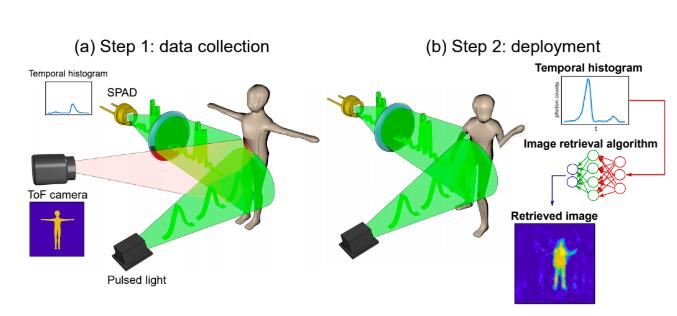

他們的實驗過程是使用了一個簡單且廉價的單像素檢測器,該檢測器經過調整可充當光子的秒表。

這個檢測器僅記錄由瞬間激光脈沖產生的光子從任意給定場景中的每個物體反彈并到達傳感器所需的時間。物體距離越遠,每個反射光子到達傳感器所花費的時間就越長。

有關場景中反射的每個光子的時間信息,研究人員稱為時間數據,收集在一個非常簡單的圖形中。

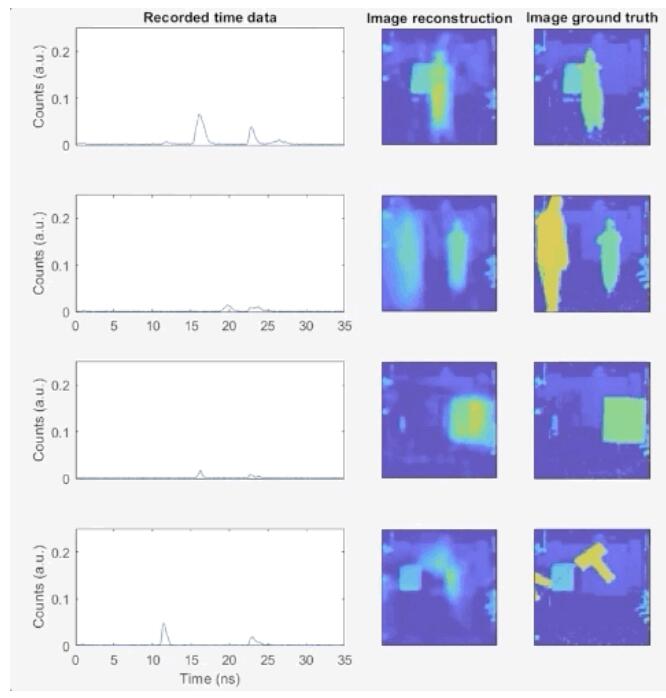

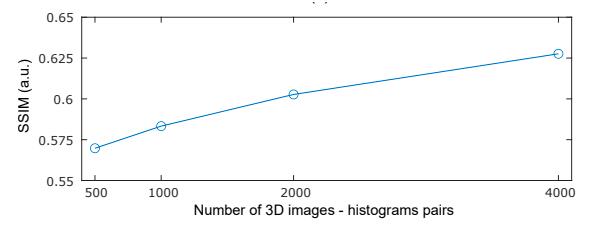

然后,借助復雜的神經網絡算法將這些圖轉換為3D圖像。研究人員通過向團隊展示數千張團隊人員在實驗室中移動和攜帶物體的常規照片,以及同時由單像素檢測器捕獲的時間數據來訓練算法。

最終,網絡已經足夠了解時間數據與照片的對應關系,從而僅憑時間數據就可以創建高度準確的圖像。

在驗證原理的實驗中,盡管使用的硬件和算法有可能每秒產生數千張圖像,但研究人員設法從時間數據中以約10幀/秒的速度構造了運動圖像。

Turpin 博士表示,我們手機中的相機通過使用數百萬個像素來形成圖像。如果僅考慮空間信息,則僅憑單個像素創建圖像是不可能的,因為單像素檢測器沒有任何信息。但是,這樣的檢測器仍然可以提供有關時間的有價值的信息。我們設法做的是找到一種新方法,可以將一維數據,即簡單的時間測量,轉換成運動圖像,該圖像代表任何給定場景中空間的三個維度。

與傳統圖像制作不同的最重要方式是,該團隊的研究方法能夠將光線與整個過程完全解耦。

Turpin 說道,「我們有信心該方法可以適用于能夠用短脈沖探測場景并精確測量回波的任何系統,以全新的方式使用時間而非光來可視化世界」。

當前,神經網絡創建圖像的能力僅限于經過訓練以從研究人員創建的場景的時態數據中挑選出來的能力。

但是,通過進一步培訓甚至使用更高級的算法,可以學習可視化各種場景,從而擴大其在現實世界中的潛在應用。

Turpin 補充說,「收集時間數據的單像素檢測器體積小、重量輕、且價格便宜,這意味著它們可以輕松地添加到現有系統中,比如自動駕駛汽車的攝像頭,以提高尋路的準確性和速度。它們可以增強移動設備中現有的傳感器,比如 Google Pixel 4,這些傳感器已經具有基于雷達技術的簡單手勢識別系統。」