一篇文章教會你理解Scrapy網絡爬蟲框架的工作原理和數據采集過程

今天小編給大家詳細的講解一下Scrapy爬蟲框架,希望對大家的學習有幫助。

/ 01 / Scrapy爬蟲框架

Scrapy是一個使用Python編程語言編寫的爬蟲框架,任何人都可以根據自己的需求進行修改,并且使用起來非常的方便。它可以應用在數據采集、數據挖掘、網絡異常用戶檢測、存儲數據等方面。

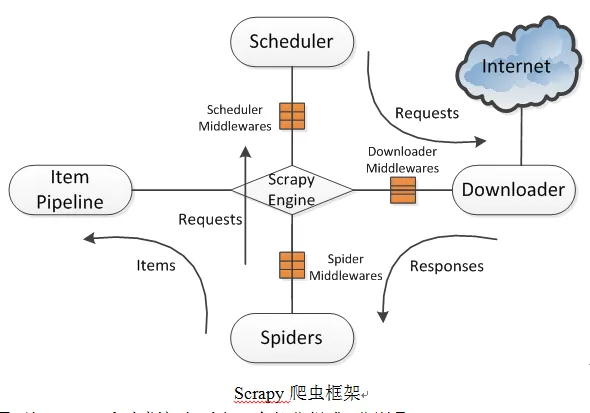

Scrapy使用了Twisted異步網絡庫來處理網絡通訊。整體架構大致如下圖所示。

/ 02 / Scrapy爬蟲框架組成

由上圖可知Scrapy爬蟲框架主要由5個部分組成,分別是:Scrapy Engine(Scrapy引擎),Scheduler(調度器),Downloader(下載器),Spiders(蜘蛛),Item Pipeline(項目管道)。爬取過程是Scrapy引擎發送請求,之后調度器把初始URL交給下載器,然后下載器向服務器發送服務請求,得到響應后將下載的網頁內容交與蜘蛛來處理,爾后蜘蛛會對網頁進行詳細的解析。蜘蛛分析的結果有兩種:一種是得到新的URL,之后再次請求調度器,開始進行新一輪的爬取,不斷的重復上述過程;另一種是得到所需的數據,之后會轉交給項目管道繼續處理。項目管道負責數據的清洗、驗證、過濾、去重和存儲等后期處理,最后由Pipeline輸出到文件中,或者存入數據庫等。

/ 03 / 五大組件及其中間件的功能

這五大組件及其中間件的功能如下:

1) Scrapy引擎:控制整個系統的數據處理流程,觸發事務處理流程,負責串聯各個模塊

2) Scheduler(調度器):維護待爬取的URL隊列,當接受引擎發送的請求時,會從待爬取的URL隊列中取出下一個URL返回給調度器。

3) Downloader(下載器):向該網絡服務器發送下載頁面的請求,用于下載網頁內容,并將網頁內容交與蜘蛛去處理。

4) Spiders(蜘蛛):制定要爬取的網站地址,選擇所需數據內容,定義域名過濾規則和網頁的解析規則等。

5) Item Pipeline(項目管道):處理由蜘蛛從網頁中抽取的數據,主要任務是清洗、驗證、過濾、去重和存儲數據等。

6) 中間件(Middlewares):中間件是處于Scrapy引擎和Scheduler,Downloader,Spiders之間的構件,主要是處理它們之間的請求及響應。

Scrapy爬蟲框架可以很方便的完成網上數據的采集工作,簡單輕巧,使用起來非常方便。

/ 04 / 基于Scrapy的網絡爬蟲設計與實現

在了解Scrapy爬蟲原理及框架的基礎上,本節簡要介紹Scrapy爬蟲框架的數據采集過程。

4.1 建立爬蟲項目文件

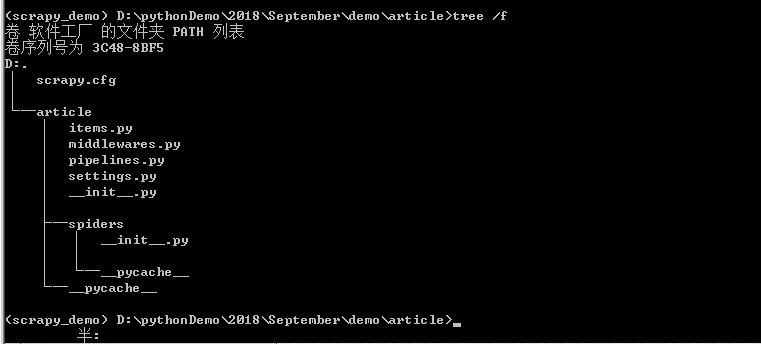

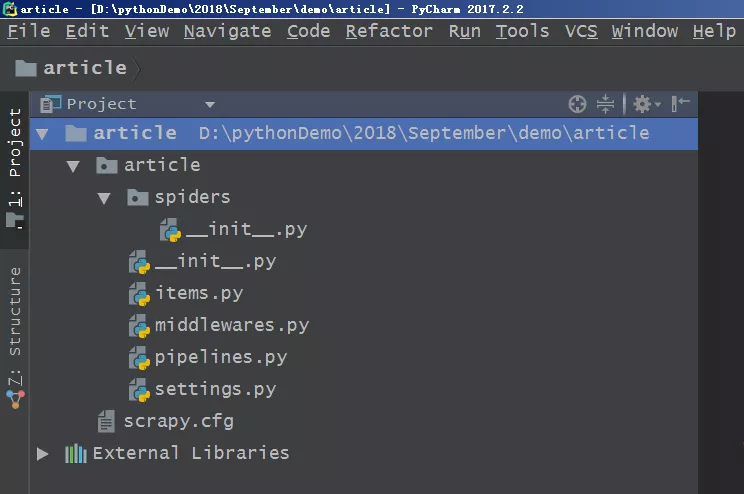

基于scrapy爬蟲框架,只需在命令行中輸入“scrapy startproject article”命令,之后一個名為article的爬蟲項目將自動創建。首先進入到article文件夾下,輸入命令“cd article”,之后通過“dir”查看目錄,也可以通過“tree /f”生成文件目錄的樹形結構,如下圖所示,可以很清晰的看到Scrapy創建命令生成的文件。

爬蟲項目目錄結構

頂層的article文件夾是項目名,第二層中包含的是一個與項目名同名的文件夾article和一個文件scrapy.cfg,這個與項目同名的文件夾article是一個模塊,所有的項目代碼都在這個模塊內添加,而scrapy.cfg文件是整個Scrapy項目的配置文件。第三層中有5個文件和一個文件夾,其中__init__.py是個空文件,作用是將其上級目錄變成一個模塊;items.py是定義儲對象的文件,決定爬取哪些項目;middlewares.py文件是中間件,一般不用進行修改,主要負責相關組件之間的請求與響應;pipelines.py是管道文件,決定爬取后的數據如何進行處理和存儲;settings.py是項目的設置文件,設置項目管道數據的處理方法、爬蟲頻率、表名等;spiders文件夾中放置的是爬蟲主體文件(用于實現爬蟲邏輯)和一個__init__.py空文件。

4.2 之后開始進行網頁結構與數據分析、修改Items.py文件、編寫hangyunSpider.py文件、修改pipelines.py文件、修改settings.py文件,這些步驟的具體操作后期會文章專門展開,在此不再贅述。

4.3 執行爬蟲程序

修改上述四個文件之后,在Windows命令符窗口中輸入cmd 命令進入到爬蟲所在的路徑,并執行“scrapy crawl article”命令,這樣就可以運行爬蟲程序了,最后保存數據到本地磁盤上。

/ 05 / 結束語

隨著互聯網信息的與日俱增,利用網絡爬蟲工具來獲取所需信息必有用武之地。使用開源的Scrapy爬蟲框架,不僅可以實現對web上信息的高效、準確、自動的獲取,還利于研究人員對采集到的數據進行后續的挖掘分析。