“中文版GPT-3”來了:會算術、可續寫紅樓夢,用64張V100訓練了3周

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

今年,OpenAI推出的自然語言模型GPT-3引起了巨大的轟動。

這是迄今為止最大的NLP模型,包含1750億參數,光是訓練就調用上萬塊GPU,花費了460萬美元的成本。

但GPT-3是基于英語語料庫進行訓練,而且并不開源,業內一直期待著能有一個中文的超大型NLP模型。

現在,它終于來了!

最近,北京智源人工智能研究院和清華大學研究團隊,合作開展了一項大規模預訓練模型開源計劃——清源CPM (Chinese Pretrained Models)。

11 月中旬,CPM將開放第一階段的26億參數規模的中文語言模型 (CPM-LM) 和217億參數規模的結構化知識表示模型 (CPM-KM) 下載,以及相應的Demo。

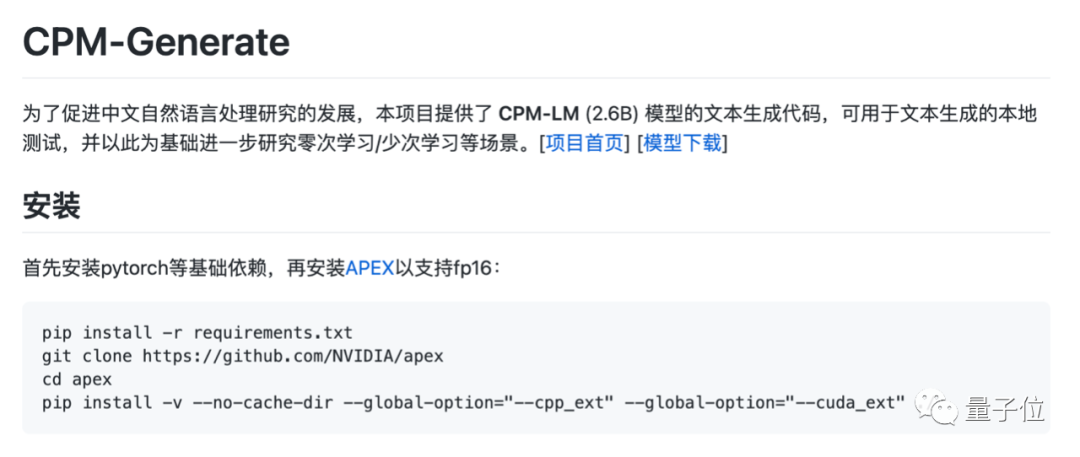

該項目的源代碼和模型已經在GitHub和官網開放下載。

CPM中文語言模型與GPT-3模型類似,僅需要通過少次、單次學習甚至零次學習,就能完成不同自然語言處理任務,具備一定的常識和認知的泛化能力。

官方表示,清源CPM計劃所有模型免費向學術界和產業界開放下載,供研究使用。

模型特點

與已有的中文預訓練模型相比,本次發布的清源 CPM 大規模預訓練模型具有以下特點:

1、語料豐富多樣:收集大量豐富多樣的中文語料,包括百科、小說、對話、問答、新聞等類型。

2、模型規模大:本次發布的 CPM-LM 的參數規模為 26 億,預訓練中文數據規模100 GB,使用了 64 塊 V100 GPU 訓練時間約為 3 周。

3、學習能力強:能夠在多種自然語言處理任務上,進行零次學習或少次學習達到較好的效果。

4、行文自然流暢:基于給定上文,模型可以續寫出一致性高、可讀性強的文本,達到現有中文生成模型的領先效果。

Demo展示

為了更直觀地展示清源CPM預訓練模型的效果,官方提供了一些文本生成的Demo。

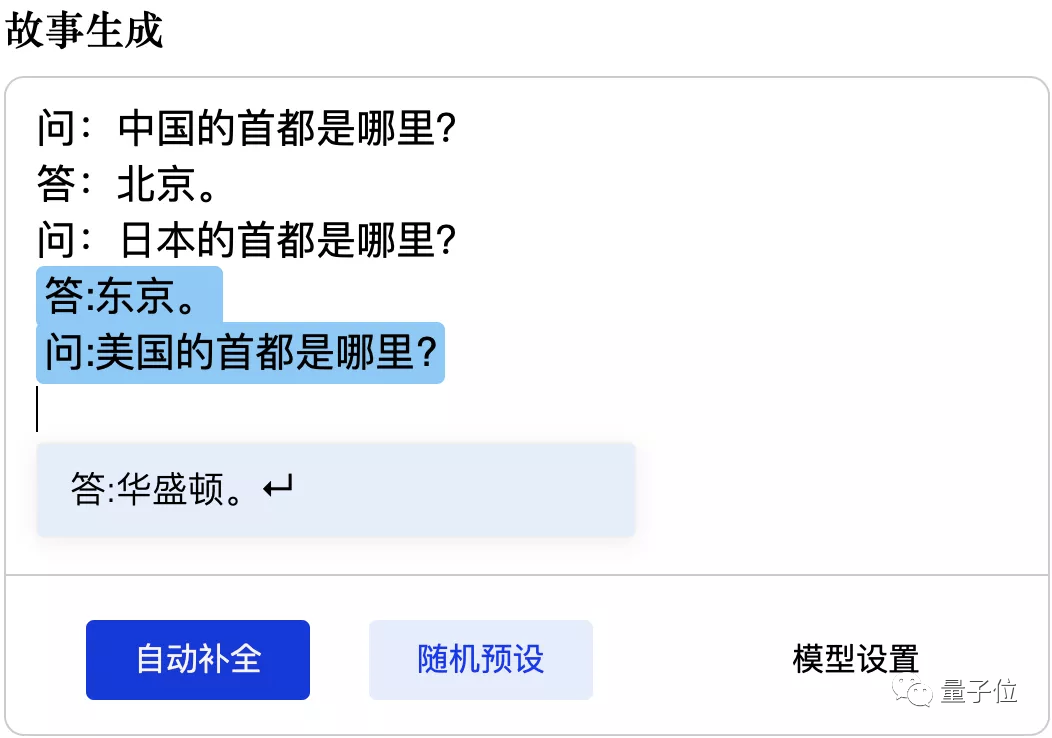

GPT-3能勝任的常識性問答,CPM預訓練模型一樣可以應對:

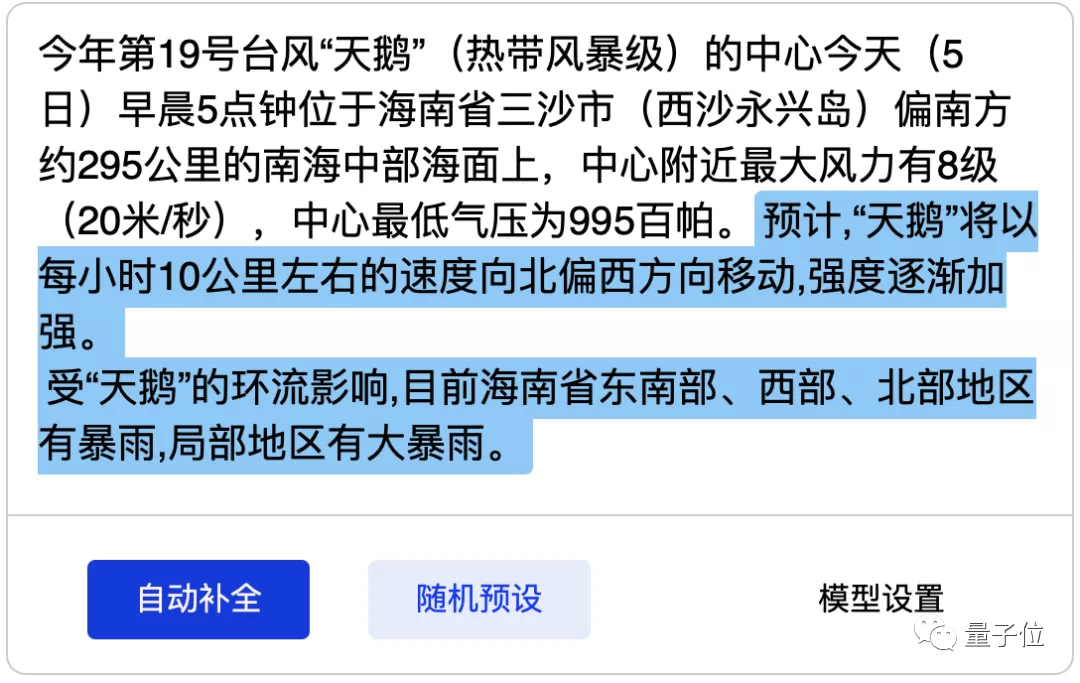

它能夠根據真實的天氣預報內容,生成天氣預報文本模板:

除了生成文字外,清源CPM還具有一定的數理推理,根據之前的規律生成計算結果:

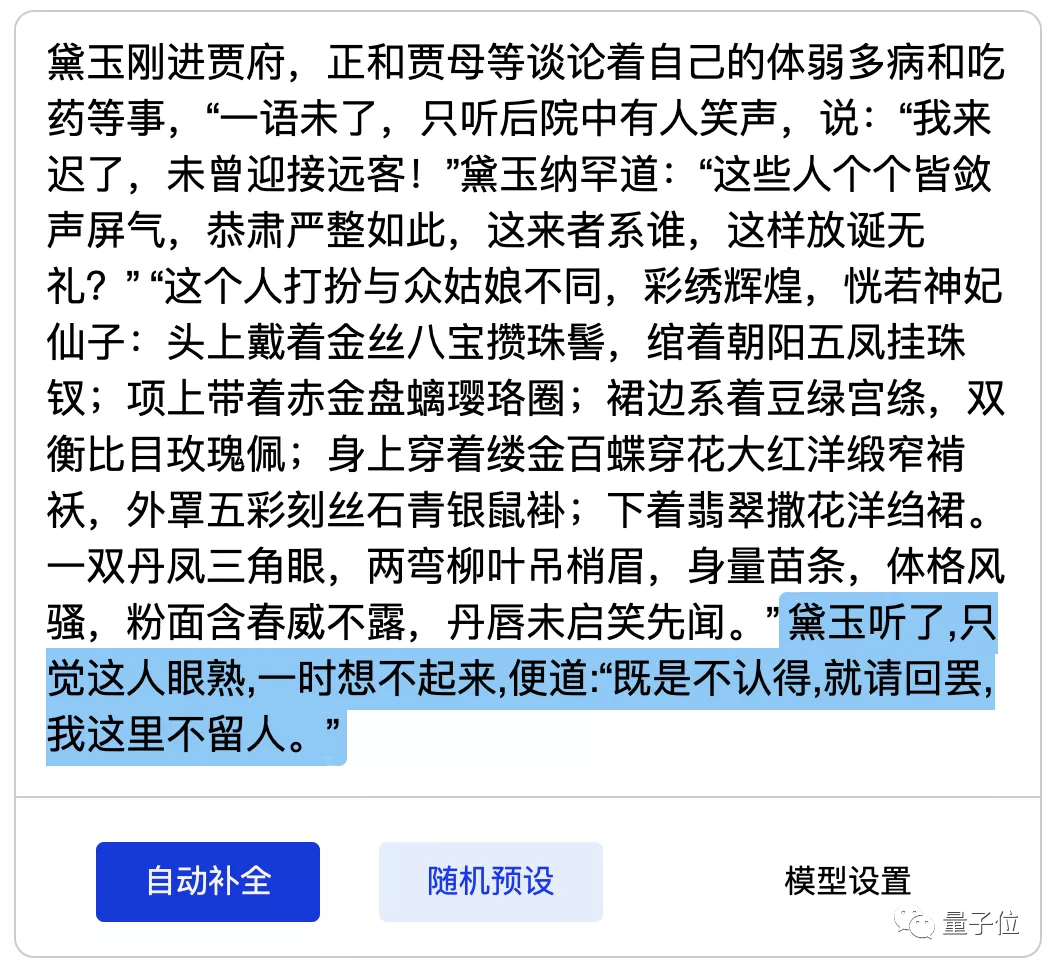

甚至可以續寫紅樓夢片段:

另外,智源和清華團隊還在幾項基準測試中驗證了清源CPM的實際性能。

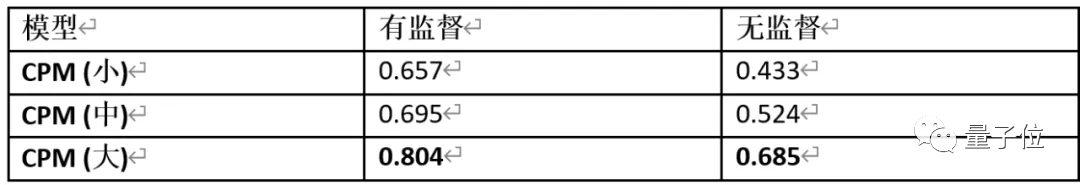

1、中文成語填空

ChID 是 2019 年清華大學對話交互式人工智能實驗室(CoAI)收集的中文成語填空數據集,其目標是對于給定的段落,在 10 個候選項中選擇最符合段意的成語進行填空。

表中匯報了預測的準確率,可以看到,CPM(大) 在無監督的設定下甚至達到了比有監督的 CPM (小) 更好的結果,反應了清源 CPM 強大的中文語言建模能力。

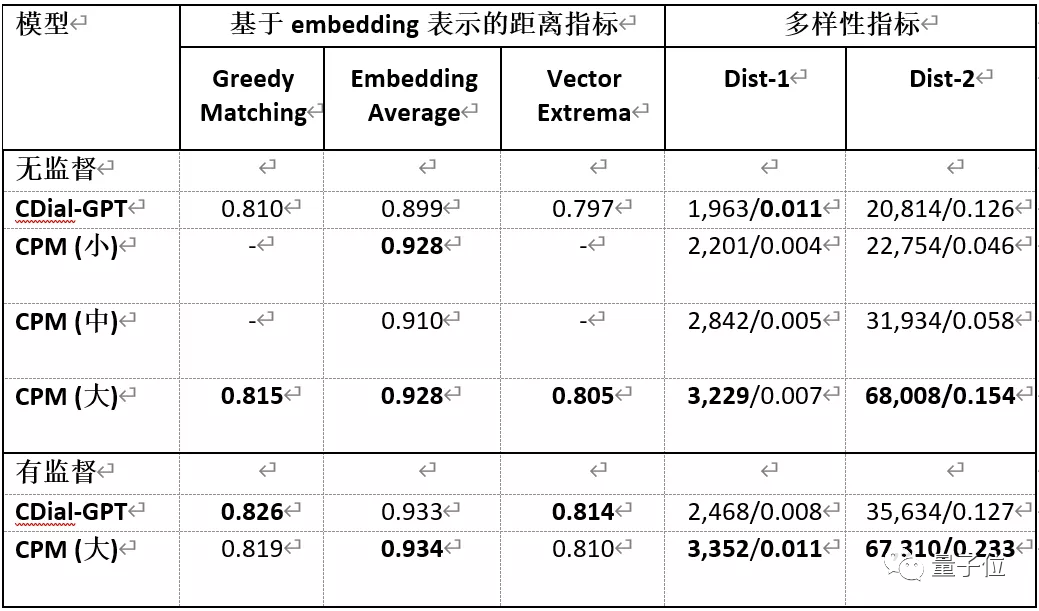

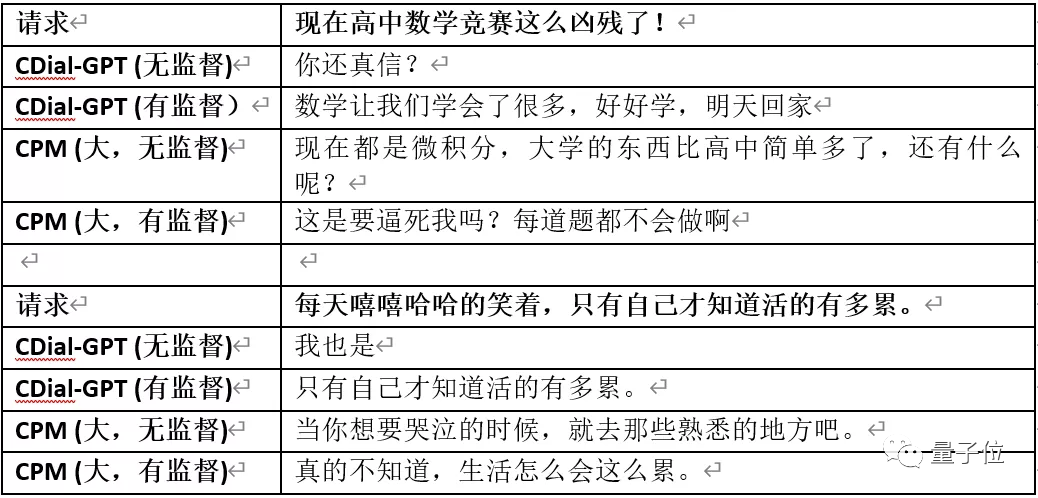

2、對話生成

STC是2015年華為諾亞方舟實驗室提出的短文本對話數據集,要求在給定上文多輪對話的條件下預測接下來的回復。

在無監督的設定下,清源 CPM 具有更好的泛化性,在有監督設定下,清源 CPM 能達到比 CDial-GPT 更優的效果,尤其在多樣性指標上表現更佳。以下為生成的對話樣例。

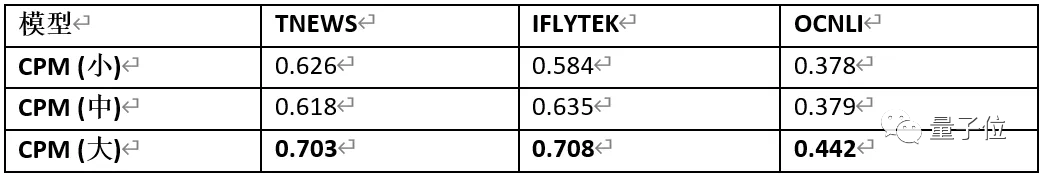

3、文本分類

清源 CPM 使用頭條新聞標題分類 (TNEWS,采樣為4分類),IFLYTEK應用介紹分類 (IFLYTEK,采樣為4分類),中文自然語言推斷 (OCNLI,3分類) 任務作為文本分類任務的基準。

可以看出,清源CPM能夠在無監督的設定下達到比隨機預測 (TNEWS/IFLYTEK/OCNLI 隨機預測精確度分別為0.25/0.25/0.33) 好得多的精確度。

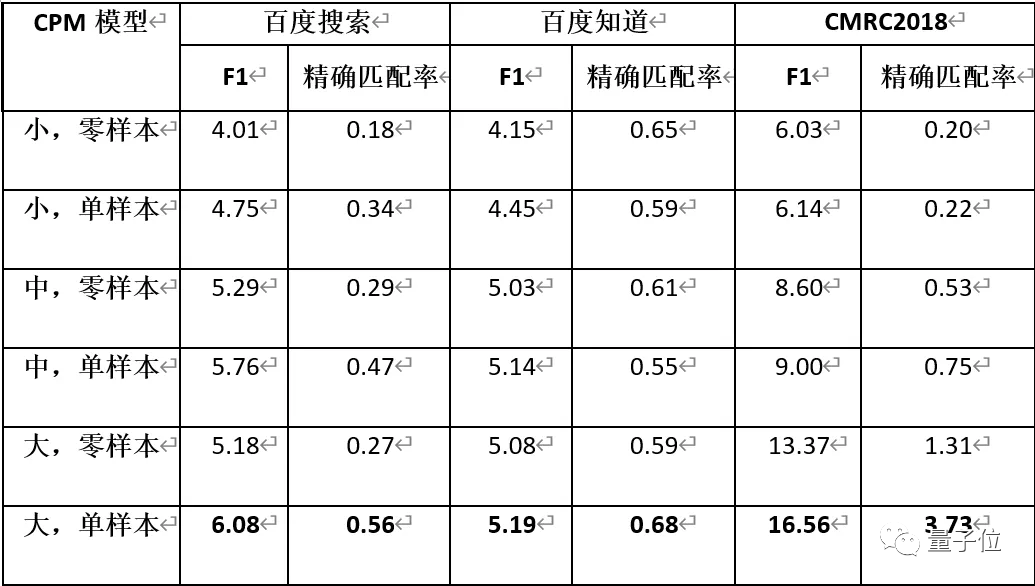

4、自動問答

CPM 使用 DuReader 和CMRC2018 作為自動問答任務的基準,要求模型從給定的段落中抽取一個片段作為對題目問題的答案。其中DuReader 由百度搜索和百度知道兩部分數據組成。

在單樣本設定下,CPM 能從給定的樣本中學習到生成答案的模式,因此效果總是比零樣本設定更好。由于模型的輸入長度有限,多樣本輸入的場景將在未來進行探索。

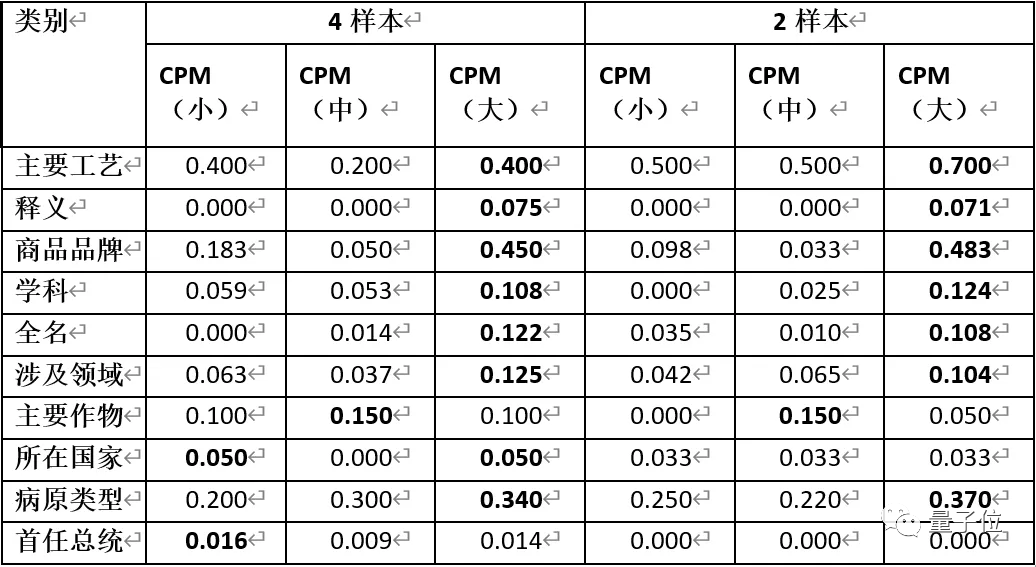

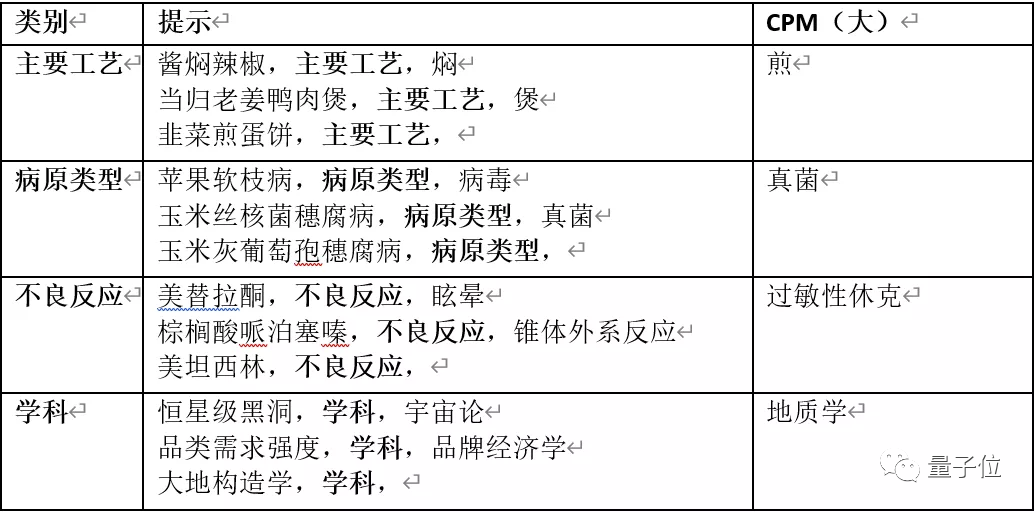

5、實體生成

CPM 采用 XLORE 中的幾種常見的關系三元組作為實體生成任務的基準。在少樣本設定 (把少量真實樣本拼在待預測樣本前作為提示) 下,不同規模的 CPM 模型的 BLEU-1 值如下表所示。

可以看出參數量越大時,模型對于預測實體效果越好。同時,模型在給定 2 個樣本時就可以達到不錯的效果,大部分時候 N=2 和 N=4 的效果是接近的。

64塊V100訓練3周

智源和清華本次發布的大規模預訓練模型,難以在單塊GPU上運行,因此需要將模型在多個 GPU之間分配參數,進行并行化訓練。

CPM正是基于英偉達的大規模并行計算訓練項目Megatron-LM。

CPM模型預訓練過程分布在多塊 GPU 上,采用層內并行的方法進行訓練,并基于當前已有的成熟技術,減少同步提高通訊速率。

本次發布的CPM-LM的參數規模為26億,預訓練中文數據規模100GB,使用64塊英偉達V100 GPU,訓練時間約為3周。

而CPM-KG的參數規模為217億,預訓練結構化知識圖譜為WikiData全量數據,包含近 1300 個關系、8500萬實體、4.8 億個事實三元組,使用了8塊英偉達V100 GPU訓練時間約為2周。

未來計劃

今年年底開源的兩個項目只是清源NLP研究計劃的第一步,據了解,清源 CPM 未來一年的研究和開源計劃是:

- 階段1 (2020年10月-12月):中文大規模預訓練語言模型,含約 30 億參數,訓練數據包括 100GB 中文數據。

- 階段2 (2021年01月-06月):以中文為核心多語言大規模預訓練語言模型,含約 200 億參數,訓練數據包括 500GB 以中文為核心的多語言數據。

- 階段3 (2021年07月-09月):知識指導的大規模預訓練語言模型,含約 1000 億參數,訓練數據包括 1TB 以中文為核心的多語言數據和億級實體關系圖譜。

清源 CPM 計劃將積極配備算力、數據和人力,注重開展原創研究,盡早實現與國際頂尖機構在超大規模預訓練模型技術方面并跑,提升中文自然語言的深度理解和生成能力。

與此同時,智源研究院也將積極與產業界合作,在智能客服、個性推薦、文本生成、自動編程等方面,探索新型的人工智能應用和商業模式。

關于清源CPM計劃

清源CPM計劃是以中文為核心的大規模預訓練模型。

首期開源內容包括預訓練中文語言模型和預訓練知識表示模型,可廣泛應用于中文自然語言理解、生成任務以及知識計算應用。

清源CPM計劃由北京智源人工智能研究院和清華大學研究團隊合作開展。“自然語言處理”是智源研究院重點支持的重大研究方向之一。

智源在該方向上集結了大量國內權威學者,這些學者在NLP領域積累了豐富的研究成果。

如清華大學孫茂松、劉知遠團隊和李涓子、唐杰團隊提出了知識指導的預訓練模型 ERNIE 和 KEPLER,循環智能楊植麟團隊提出了性能顯著優于 BERT 的 XLNet 模型,清華大學朱小燕和黃民烈團隊提出了面向情感分析的預訓練模型 SentiLARE,融合常識知識的預訓練語言生成模型 StoryGPT,面向中文對話生成的 CDial-GPT模型,等等。

研究團隊將在智源研究院大規模算力平臺的支持下,開展以中文為核心的超大規模預訓練模型研究,包括跨語言學習、文本生成、知識融合、模型并行和壓縮等前沿課題,并將相關模型及時通過智源社區開源共享。