能與 GPT-3 相媲美?EleutherAI 開源 GPT-J

2020 年,微軟與 OpenAI 達成了協議,微軟將擁有對 GPT-3 源代碼的獨家訪問權,自此 OpenAI 就不像以往一樣開放其 GPT-3 AI 模型,而 OpenAI 的 GPT-1 和 GPT-2 仍然是開源項目。

為了打破 OpenAI 和微軟對自然語言處理 AI 模型的壟斷,Connor Leahy、Leo Gao 和 Sid Black 創立了 EleutherAI,這是一個專注于人工智能對齊、擴展和開源人工智能研究的組織。近日 EleutherAI 研究團隊開源了一個基于 GPT-3 的自然語言處理 AI 模型 GPT-J。

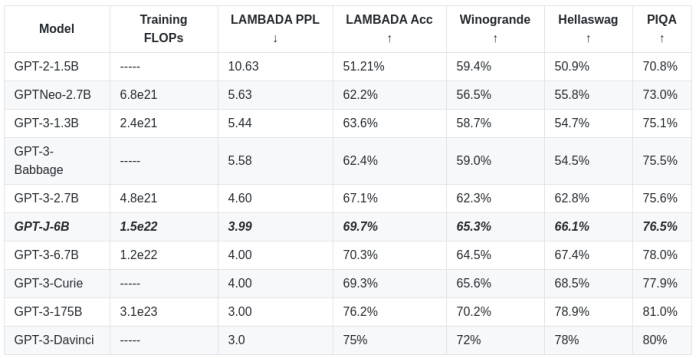

GPT-J 是一個基于 GPT-3,由 60 億個參數組成的自然語言處理 AI 模型。該模型在一個 800GB 的開源文本數據集上進行訓練,并且能夠與類似規模的 GPT-3 模型相媲美。

該模型通過利用 Google Cloud 的 v3-256 TPU 以及 EleutherAI 的 The Pile 數據集進行訓練的,歷時大約五周時間。GPT-J 在標準 NLP 基準工作負載上實現了與 OpenAI 報告的 67 億參數版本的 GPT-3 類似的準確性。模型代碼、預訓練的權重文件、Colab 文檔和一個演示網頁都包含在 EleutherAI 的開源項目中。

EleutherAI 在 2021 年 3 月發布了 27 億參數的 GPT-Neo 模型,這是他們對類 GPT 系統的第一個實現。GPT-Neo 是在 TensorFlow 中構建的,并通過 Mesh TensorFlow 并行庫在 TPU 上訓練。該團隊目前還正在開發 GPT-NeoX,這是一個基于微軟 DeepSpeed 的 GPU 解決方案;雖然代碼是開源的,但目前沒有模型文件可以訪問。

最新的模型 GPT-J 是用 Mesh-Transformer-JAX 這個新庫來訓練的。該庫沒有使用像 TensorFlow 這樣的特定深度學習框架,而是使用 Google 的 JAX 線性代數框架。GPT-J 提供了比 Tensorflow 更靈活、更快速的推理,該模型的開發時間遠遠少于早期的舉措。與 GPT-Neo 模型相比,GPT-J 的訓練效率提高了 125%。在幾個 Down-Streaming 工作負載的零點性能方面,GPT-J 是公開的 Transformer LM 中表現最好的。

EleutherAI 的開發者 Komatsuzaki 表示:“與 TensorFlow 和 TPU 的同類產品相比,它允許更靈活、更快速的推理。更重要的是,該項目需要的時間大大少于其他大規模模型。研究表明,JAX + xmap + TPU 是快速大規模模型開發的完美工具集合。”

開發者可以在 GitHub 上找到 GPT-J 的源代碼和模型,并能在 EleutherAI 的官方網站上找到互動演示。

本文轉自OSCHINA

本文標題:能與 GPT-3 相媲美?EleutherAI 開源 GPT-J

本文地址:https://www.oschina.net/news/150972/eleutherai-open-sources-gpt-j