ImageNet決定給人臉打碼,卻讓哈士奇圖片識別率猛增

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

315晚會讓大家意識到人臉識別有多可怕。在大洋彼岸,全球最具影響力的AI數據集也開始行動了。

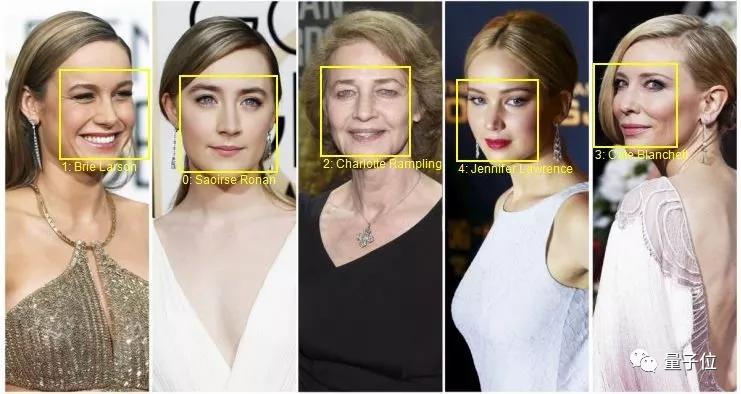

近日,ImageNet數據集決定:給所有人臉打碼,保護被收錄者隱私。

ImageNet管理者之一Olga Russakovsky與李飛飛團隊合作,一起“糾察”數據集中所有包含人臉的圖像。

ImageNet總共有1000多個標簽,其中只有3個標簽與人相關,而很多看似與人臉無關的標簽下,反而可能有大量人臉照片。

因此,研究團隊通過亞馬遜Rekognition的自動人臉識別以及眾包方式,在150萬張圖片中,找出了243198張包含人臉的圖片。

這些圖片中的562626張人臉都已被模糊處理。

給人臉打碼會影響AI模型效果嗎?這恐怕是“煉丹”人士最關心的問題了。

在修改數據集之后,普林斯頓大學的博士生楊凱峪對這個問題進行了一番研究。

偏差不大,但結果微妙

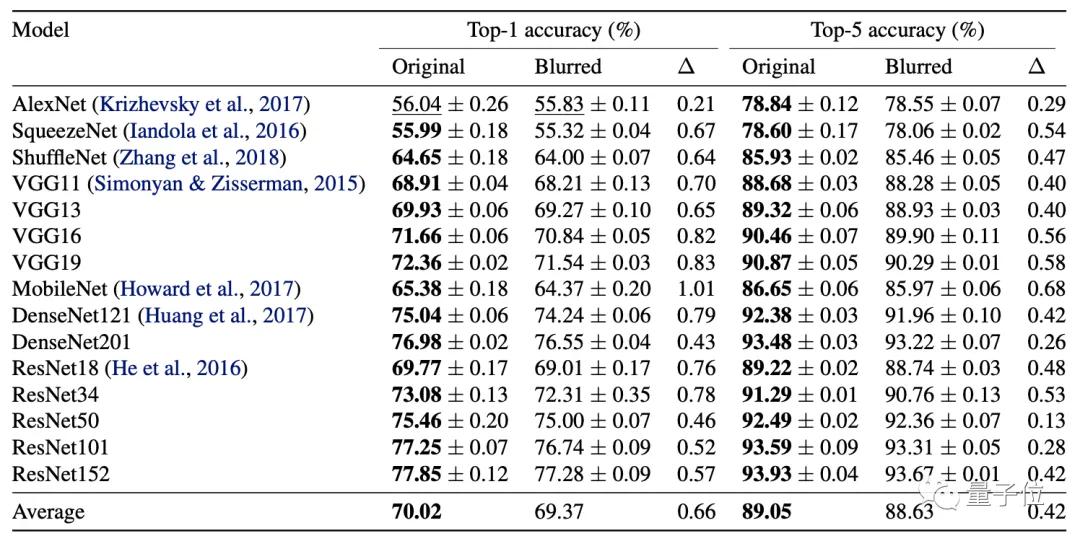

研究者使用模糊處理后的數據集進行目標檢測和場景檢測基準測試。

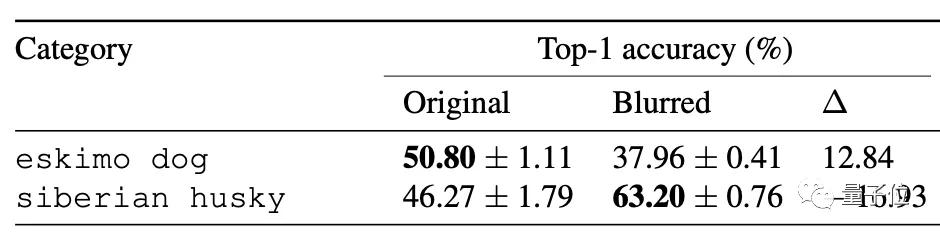

在AlexNet、VGG、ResNet等15種主流網絡模型上測試后發現,Top-1準確率最多下降1%,平均僅下降0.66%,Top-5準確率平均下降0.42%。

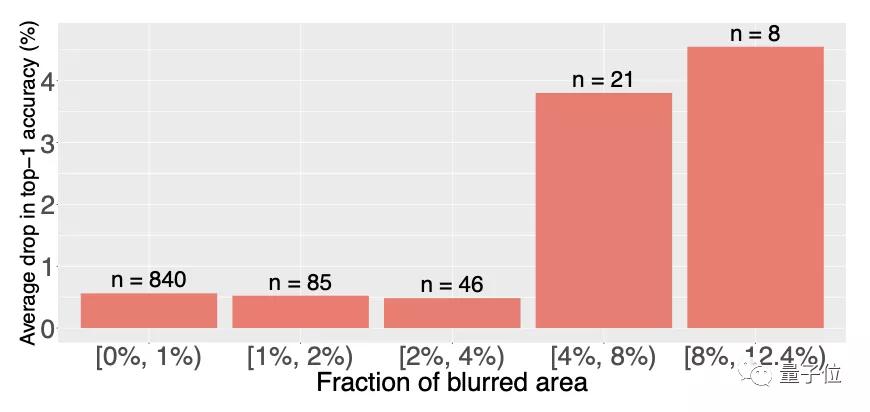

根據圖片中模糊區域比例的不同,Top-1準確率下降程度隨著模糊比例的增大,最高超過4%。

某些類別中離模糊人臉更近的目標,例如口琴或面具,會導致更高的分類錯誤率。

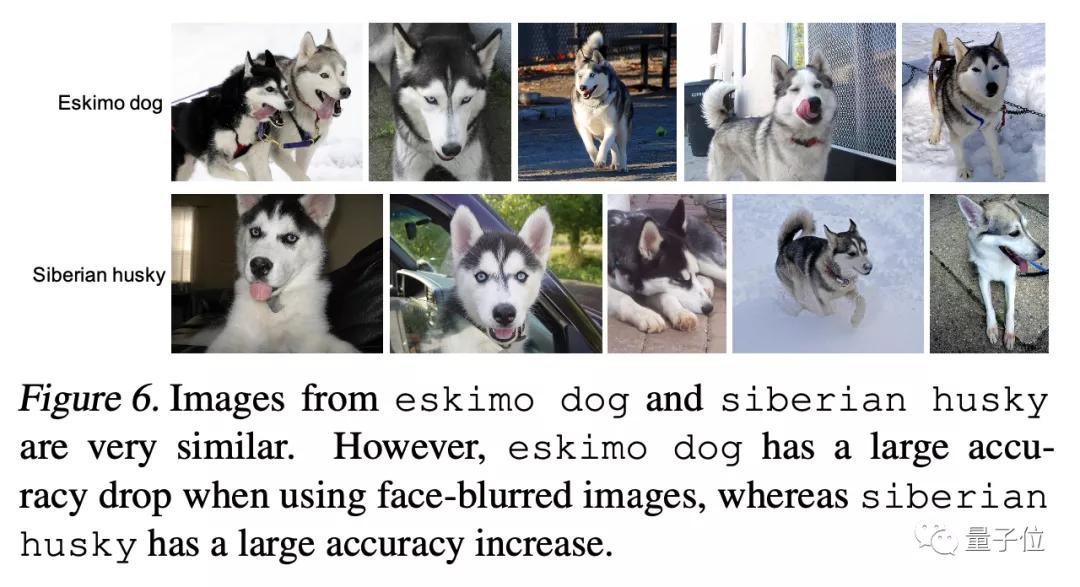

令人費解的是,一些沒有人臉的照片反而會有很大的準確率波動,比如“哈士奇”、“愛斯基摩犬”分類。

其中,愛斯基摩犬的識別準確率出現大幅下降,而哈士奇的識別準確率反而大幅上升。

連作者也覺得很奇怪,因為這兩個類別中的大多數圖像都沒有人臉。具體原因如何只有等待后續研究了。

MIT科學家Aleksander Madry認為,模糊人臉的數據集訓練的AI有時候很奇怪,數據中的偏差非常微妙,但可能會帶來嚴重的后果。

向隱私和偏見說不

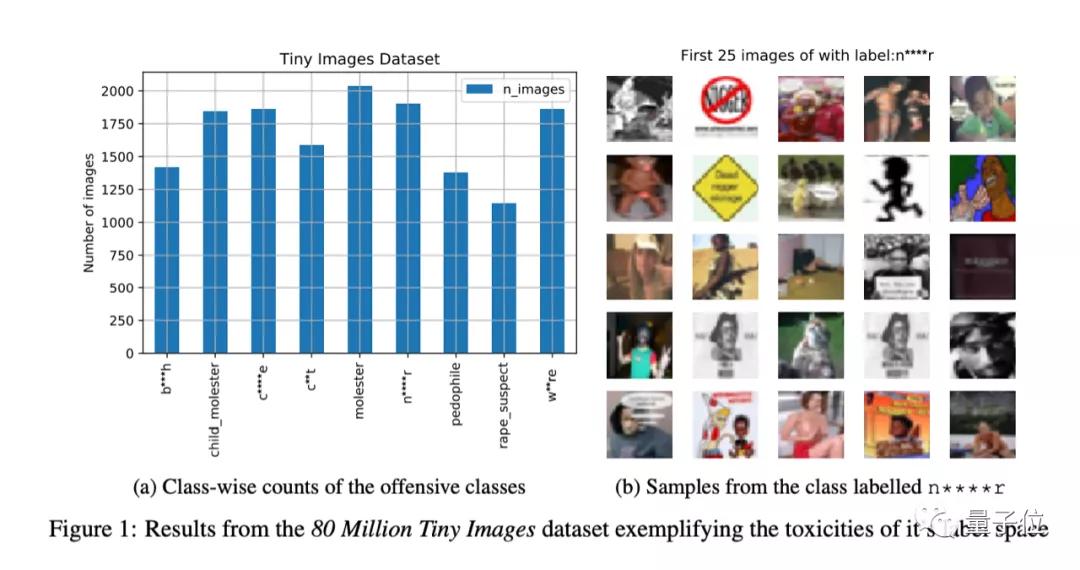

2020年,在計算機科學道德倫理學術會議FAccT上,ImageNet數據集刪除了“人”子樹中2702個同義集,因為這些類別中含有令人反感、貶義或污穢的表述。例如一些種族和性別歧視的內容。

雖然ImageNet此次對隱私問題做出了重大改變,但來自UnifyID的首席科學家Vinay Prabhu指出該數據集還有許多嚴重問題。

去年7月,Prabhu發表的一篇論文指出,ImageNet、Tiny Images等圖片數據集中不僅存在危害隱私的狀況,甚至還有一些不可描述的圖片。

在那篇論文中,Prabhu建議,對數據集中的人臉做模糊處理,并且要做到在參與者明確同意后才能收集圖片,不要為這類數據集創建數據共享許可證。

他曾給連續10個月給ImageNet團隊發送郵件反饋此問題,直到去年4月才收到李飛飛的回復。

而此次ImageNet團隊的論文并沒有引用他,在接受《連線》雜志采訪時,Prabhu表示對ImageNet團隊沒有承認他所做的工作感到失望。

Russakovsky回復稱,論文的更新版本將會把Prabhu的研究加入引文中。

2019年,微軟悄悄刪除了包含1000萬張圖片的人臉數據集MS Celeb,這些照片都未征得本人同意。

此前用公共攝像頭搜集的數據集,如杜克大學的MTMC、斯坦福大學的Brainwash,近年來都被悉數刪除。

在公眾隱私意識覺醒、法律逐漸完善的背景下,AI數據集到了必須要保護用戶隱私的時候了。