這年頭,機器翻譯都會通過文字腦補畫面了

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

現在,想象一個外國人面前擺了句「金石迸碎蕩塵埃,磐山紆水盡為開」。

除了痛苦地死摳復雜單詞和長難句語法,他還能怎么去理解這句話呢?

——想象。

想象這句詩詞中的“金石”、“塵埃”、“山水”各個詞匯的意象,再將意象匯聚成一個具體的畫面或場景。

而這時就有研究者靈機一動:

人類不是能根據非母語文本腦補畫面,進而做到更深入的理解嗎?

那機器是不是也能根據輸入文本腦補圖像,最終實現更好的翻譯呢?

于是,一個以視覺想象為引導的機器翻譯模型ImagiT就誕生了。

△已被NAACL 2021收錄。

論文作者來自南洋理工大學和字節跳動人工智能實驗室。

缺少圖片也能利用視覺

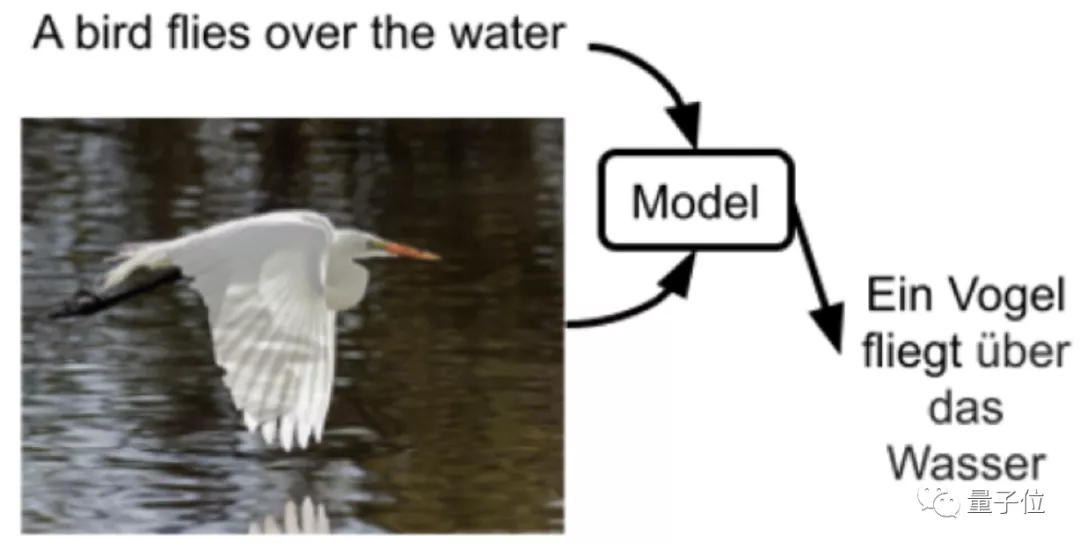

提到“利用視覺”,我們首先會想到多模態機器翻譯。

比起純文本的機器翻譯,多模態機器翻譯能夠利用語音、圖像這樣的模態信息來提高翻譯質量。

△多模態機器翻譯的輸入:源語言+標注的圖片

但多模態機器翻譯的質量是和數據集的可用性直接掛鉤的。

換句話說就是標注圖片的數量和質量會非常影響模型翻譯的有效性。

但偏偏人工圖片標注的成本又不低……所以現階段的多模態機器翻譯大都應用在Multi30K,一個包含了3萬張圖片標注的數據集上。

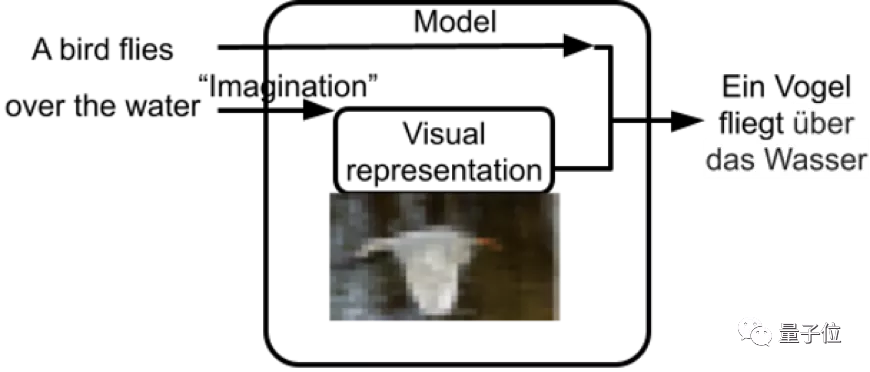

而新提出的ImagiT翻譯模型呢?

它在推理階段不需要標注圖片作為輸入,而是通過想象的方式利用視覺信號,在訓練階段將視覺語義蘊含到模型內部。

△多模態機器翻譯的輸入:源語言

做到了在缺少圖片標注的情況下也能利用視覺信息。

基于想象的翻譯模型到底什么樣

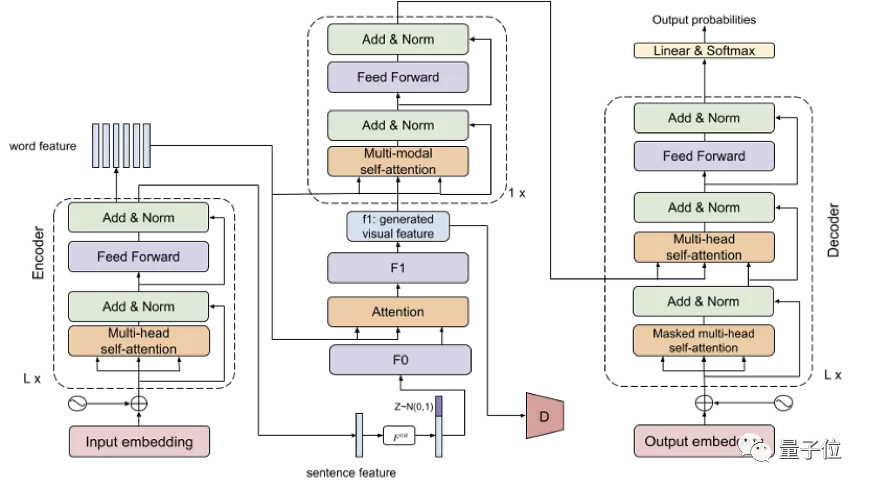

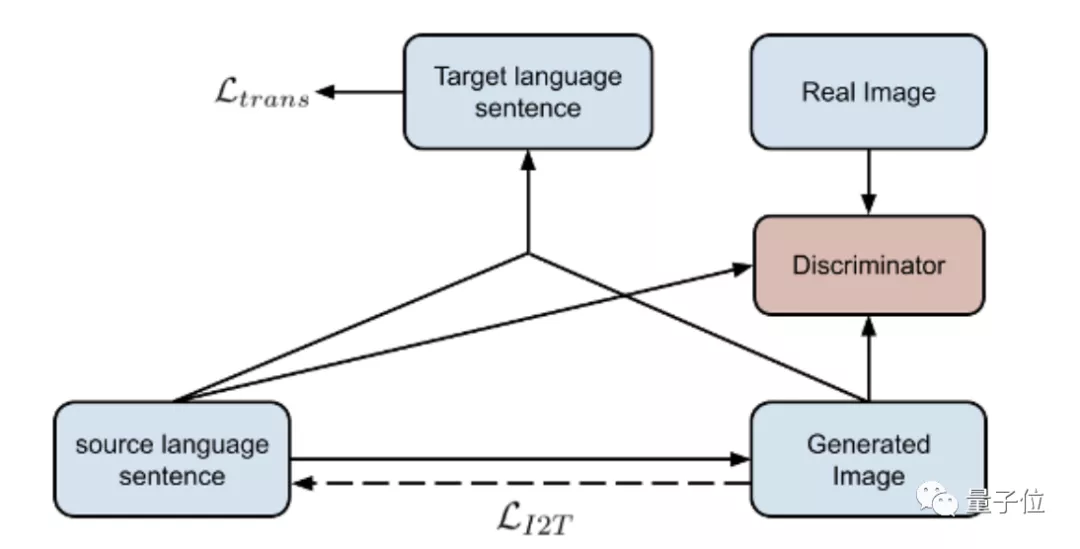

這是一個端到端的對抗學習架構。

架構左右端是我們熟悉的transformer的編碼器和解碼器,而中間則是這一框架獨特的生成想象網絡。

這一生成想象網絡主要由兩個轉化器和一個注意力層組成,具體做轉化時:

一、源文本通過F0輸入

F0包含一個全連接層和四個去卷積層。

基于GAN的思想,句子特征與噪聲拼接后會通過F0轉化成視覺表征。

二、將注意力放在詞層面

在注意力層關注源文本中的相關詞匯,并生成圖像不同子區域的細粒度細節,讓圖像特征的子區域與詞對應。

最終得到更加語義一致的視覺表征。

三、視覺表征通過F1輸出

F1包含兩個全連接層和一個去卷積層,以及一個殘差層。

通過這一轉化器,捕捉多層次(詞級和句級)的語義,輸出生成的視覺特征f1。

四、多模態聚合

把原本的文本模態和新合成的視覺特征聚合在一起。

五、翻譯

模型的學習目標結合了文本到圖片的生成,以及逆任務的圖像字幕和翻譯。

其中鑒別器源文本、生成圖像和真實圖像作為輸入,用來評估合成圖像是否與真實圖片一致。

同時,也會使用條件對抗損失來評估合成的圖像是否與源語言具有相同的語義。

“腦補”如何幫助翻譯?

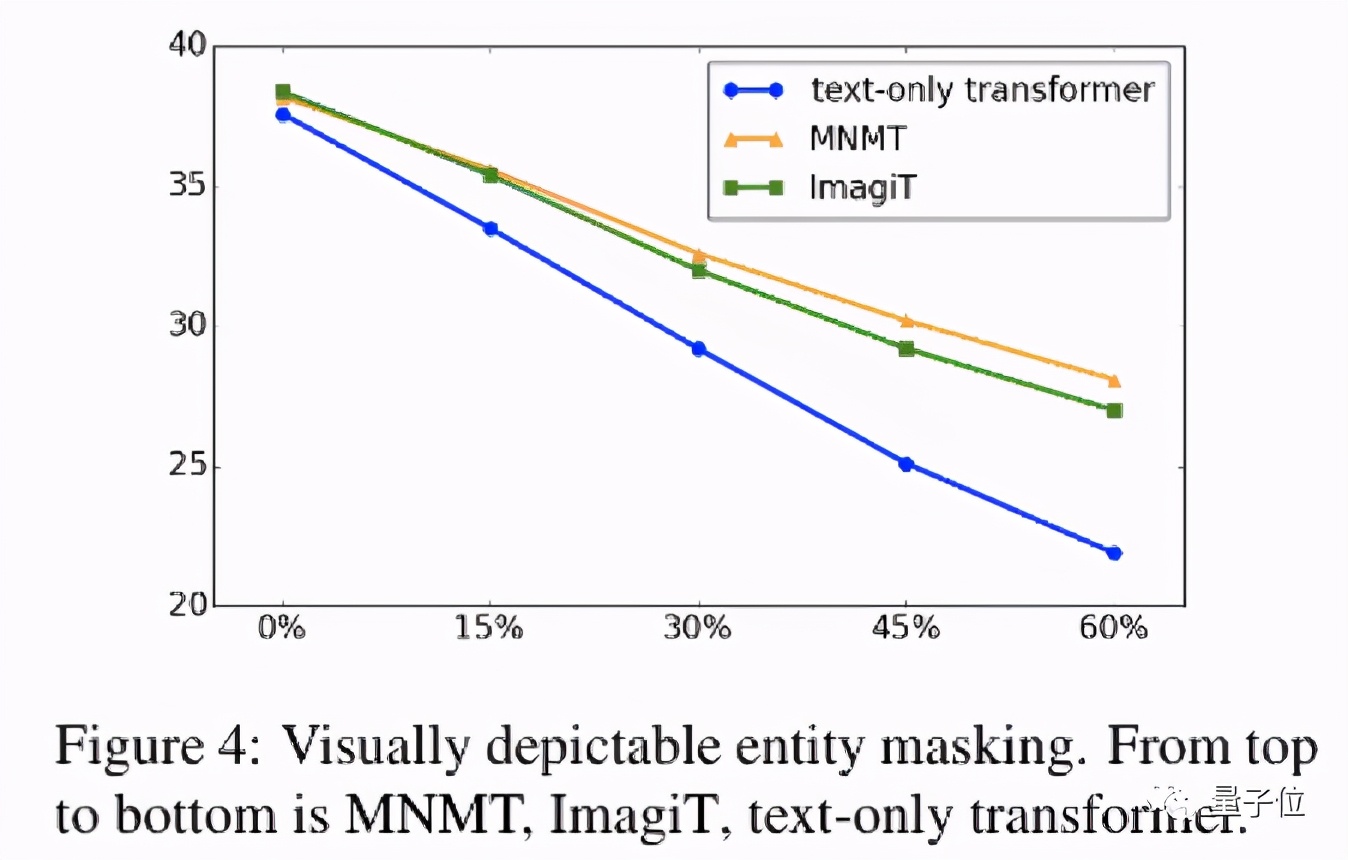

研究者使用了一種退化策略,即用特殊字符替換源語言文本中的重要詞語,來觀察模型的翻譯表現會下降多少。

在這這種情況下,純文本的翻譯模型只能通過丟失詞語的上下文和偏置來推理句子的翻譯。

多模態機器翻譯則會利用標注的圖片進行翻譯。

而ImagiT在缺少圖片標注的情況下,還能根據退化的文本想象并恢復丟失的信息。

通過這一特殊的探索實驗,可以看到ImagiT能在訓練階段學習特定詞語(色彩,可被具象化的實體詞等)與其他詞語之間相關性和共現。

△將源語言文本中所有的色彩詞全部替換為特殊字符。

而對比純文本翻譯,通過想象恢復被替換文本的ImagiT模型在翻譯質量上下降的幅度也最少。

效果如何?

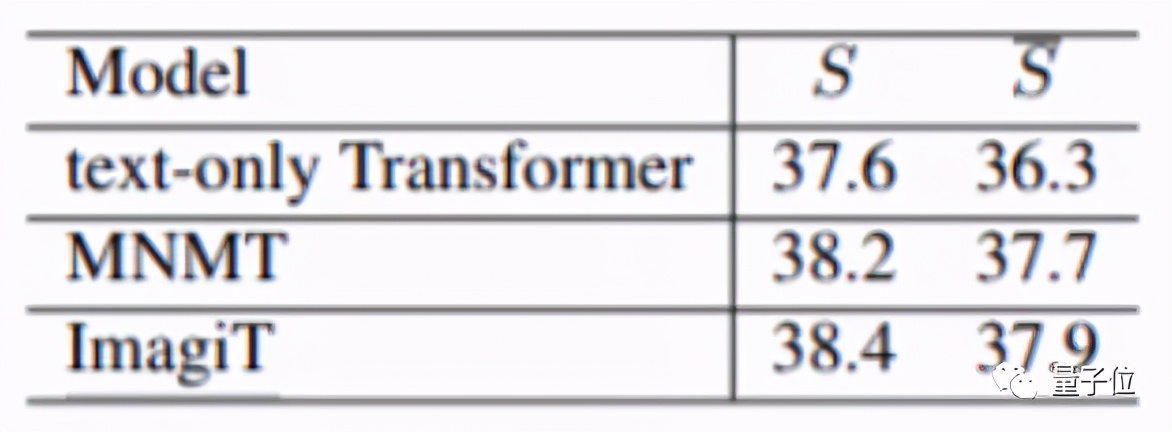

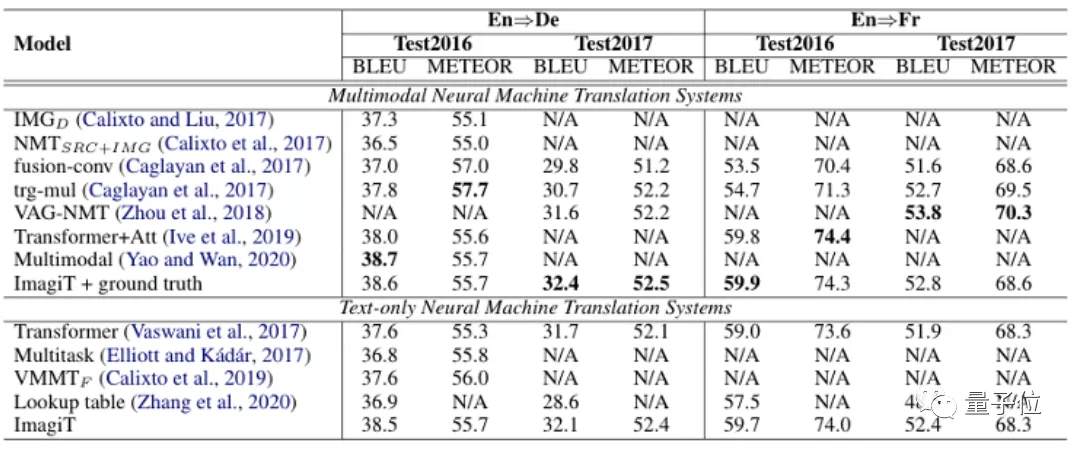

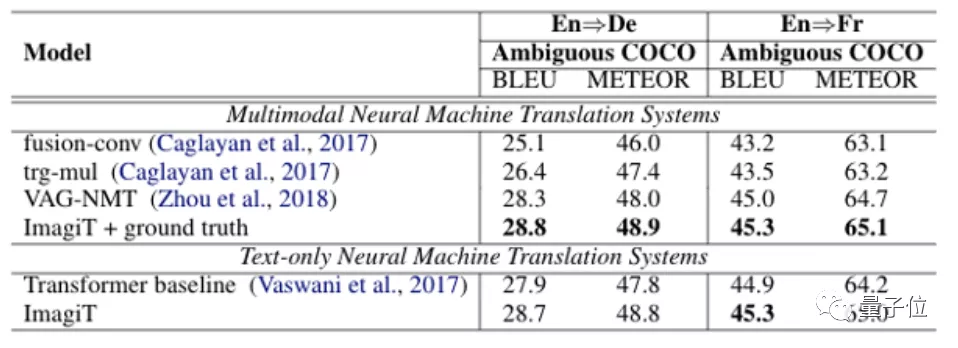

由于ImagiT不需要圖片作為輸入,所以在測試時選用純文本的transformer模型作為baseline。

在Multi30K的英法、英德Test2016,Test2017上進行測試時,ImagiT得到了與SOTA多模態翻譯系統相當的表現:

而在Ambiguous COCO上也展現出了不錯的測試結果:

論文地址:

https://arxiv.org/abs/2009.09654