刷新ImageNet最高分!谷歌大腦華人研究員發布超強Transformer

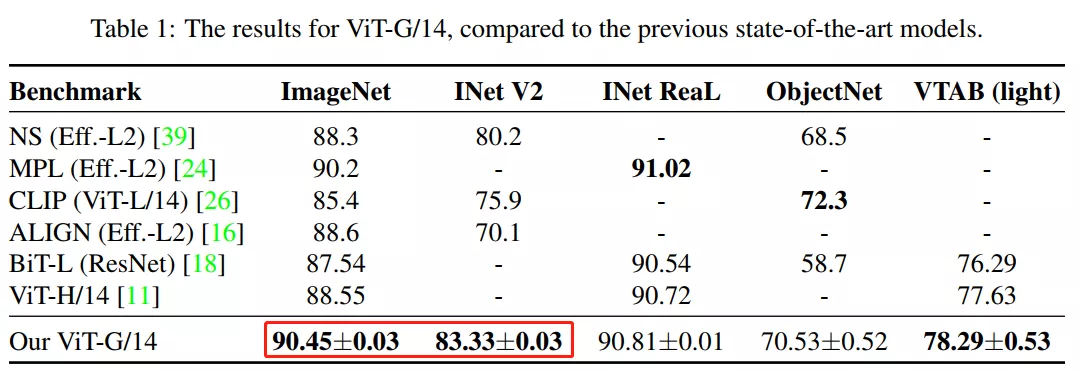

近日,谷歌大腦團隊公布了Vision Transformer(ViT)進階版ViT-G/14,參數高達20億的CV模型,經過30億張圖片的訓練,刷新了ImageNet上最高準確率記錄——90.45%,此前的ViT取得的最高準確率記錄是 88.36%,不僅如此,ViT-G/14還超過之前谷歌提出的Meta Pseduo Labels模型。

Vision Transformer模型的縮放規律

在多項基準測試中,ImageNet, ImageNet-v2和VTAB-1k,ViT-G/14的表現都刷新了記錄。

例如,在幾張照片的識別挑戰中,準確率提高了五個百分點以上。研究人員隨后訓練了多個更微型的模型版本,以尋找架構的縮放規律(scaling law),結果觀察到性能遵循冪律函數(power-law function),類似于用于NLP的Transformer模型。

2017年由谷歌首次引入的 Transformer 架構迅速成為最受歡迎的NLP深度學習模型設計,其中 OpenAI的GPT-3是最著名的。OpenAI 去年發布的一項研究描述了這些模型的縮放規則(Scaling rules)。

OpenAI 通過訓練幾個不同規模的可比模型,改變訓練數據的數量和處理能力,開發了一個用于評估模型準確性的冪律函數。此外,OpenAI 發現更大的模型不僅性能更好,而且計算效率也更高。

與 NLP 模型不同,大多數SOTA的 CV 深度學習模型,采用的是卷積神經網絡架構(CNN)。2012年, 一個CNN模型贏得了ImageNet競賽,CNN因此聲名鵲起。

隨著Transformer最近在 NLP 領域的成功,研究人員已經開始關注它在視覺問題上的表現; 例如,OpenAI 已經構建了一個基于 GPT-3的圖像生成系統。

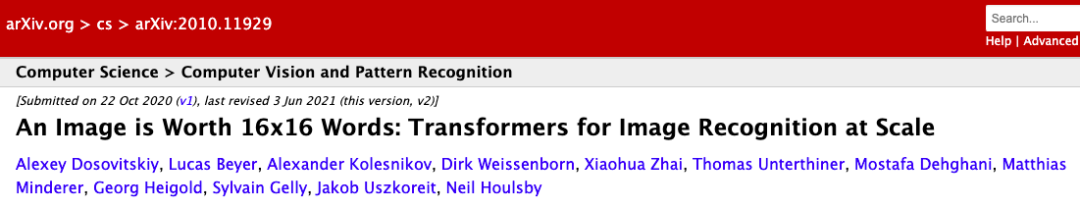

谷歌在這個領域一直非常活躍,在2020年年底使用他們專有的 JFT-300M 數據集訓練了一個600m 參數的 ViT 模型。

△ 去年10月,谷歌大腦團隊發布了Vision Transformer(ViT)

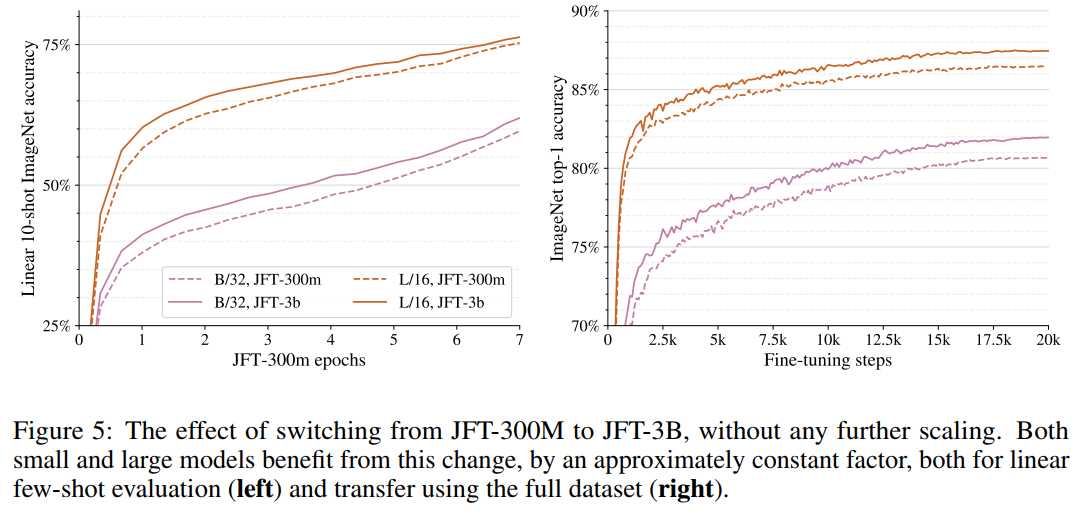

而新的ViT-G/14模型使用 JFT-3B 預先訓練,JFT-3B是升級版數據集,包含大約30億張圖片。

研究團隊改進了 ViT 架構,增加了內存使用,使模型能夠適應單個 TPUv3核心。研究人員在預先訓練的模型上使用少量和微調的遷移學習來評估 ViT-G/14和其他較小模型的性能。這些發現被用來創建縮放規則,類似于 NLP 規則:

根據冪律函數,縮放更多的計算、模型和數據可以提高準確性;

在較小的模型中,準確性可能是一個障礙;

大型數據集有助于大型模型。

目前,ViT-G/14得分在 ImageNet 排行榜上排名第一。下面的八個得分最高的模型同樣是由谷歌的研究人員創建的,而第十個模型來自Facebook。

作者團隊

本次論文團隊成員是此前發布ViT模型的4名成員,其中,第一作者是Xiaohua Zhai (翟曉華)。

https://sites.google.com/site/xzhai89/home

翟曉華目前是谷歌大腦研究員。研究領域為深度學習和計算機視覺。興趣范圍包括表征學習、遷移學習、自監督學習、生成模型、跨模態感知。

根據他的個人網站提供的信息,2009年,翟曉華本科畢業于南京大學,2014年取得北京大學計算機科學博士學位。

另外,論文作者Alexander Kolesnikov,同為谷歌大腦研究員,研究領域包括人工智能、機器學習、深度學習和計算機視覺。

畢業于奧地利Institute of Science and Technology Austria (IST Austria),博士論文為Weakly-Supervised Segmentation and Unsupervised Modeling of Natural Images(自然圖像的弱監督分割和無監督建模)。

另一名作者Neil Houlsby,研究領域為機器學習、人工智能、計算機視覺和自然語言處理。

第四名作者Lucas Beyer,是一名自學成才的黑客、研究科學家,致力于幫助機器人了解世界、幫助人類了解深度學習。