新技能get!用Python高效背單詞

Python中文社區(ID:python-china)

背景

作為一個程序員,經常需要閱讀英文論文、文檔、書籍。對于一些基礎不好的同學來說,最主要的攔路虎是英語單詞。計算機類文檔不同于小說,其語法、句式都比較簡單,可以說只要詞匯量有了,閱讀就很簡單。

如果能在平時提高詞匯量,那是最好不過了。雞湯警告!你必須暗自努力,然后驚艷所有人!這句話打在這里沒毛病吧,老鐵。但無所側重地背普通英語字典,恐怕效率并不高。不提前學習單詞,直接上手閱讀,遇到生詞再查,效率也提升不起來。

這里介紹一個針對專業文檔背單詞的方法:把當前文檔的所有單詞,建立一個專屬字典,先背誦這個字典,再去看書,一定能一目十行。

思路

總體思路是文件分詞統計,查找字典,生成新字典。

•首先,有一個需要閱讀的英文文檔,給它分詞,按照單詞頻率排序;•找一個已掌握的英語詞匯表(四六級或考研等),把上文中的單詞和本詞匯表重復的項刪除;•再找一個詞匯量大的字典,在其中查找對應解釋;•把結果存儲到一個字典文件中。

得到的字典,就是這本書的專屬字典了。業余背這個字典,相當于掌握了計算機專業英語。這個方法也適用于機械、電子等等任何專業英語的地方。

實現

下面,以 Python 神作《Fluent Python》為例,用 Python 自帶的庫實現分詞、統計功能。首先看下它的內容梗概。

- Fluent Python

- CLEAR, CONCISE, AND EFFECTIVE PROGRAMMING

- Luciano Ramalho

- ......

分詞

首先來分詞。

- from collections import Counter

- import re

- ct2 = Counter()

- patt = re.compile(r'\w+')

- with open('f1.txt','r',encoding='utf-8') as f:

- for l in f.readlines():

- ws = (n.lower() for n in patt.findall(l))

- ct2.update(ws)

以上代碼中,導入了 Counter 和 re 模塊。

Counter 負責統計單詞詞頻,re 正則表達式分割英語單詞。得到結果 ct2 中是所有單詞的詞頻。

下面,把它保存下來。

- with open('result_f1.txt','w',encoding='utf-8') as f:

- f.write(''.join(('%s %s\n'%(a,b) for a,b in ct2.most_common())))

現在,result_f1.txt 中存儲的是這本書出現的單詞,而且是按照詞頻排序的,如下。

- the 12414

- a 5639

- of 4900

- in 4837

- to 4689

- is 3848

- ......

和預想得很像,排名靠前的基本是介詞等常用詞。

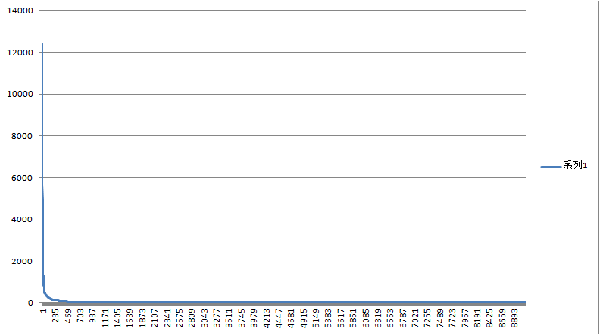

另外,比較有意思的數據是,《Fluent Python》共使用詞匯 9118 個,其中出現一次的單詞有 3168 個。出現頻次最高的 the 達到 12000 次。它的分布圖如下。

載入字典

下載一個比較全的字典,十萬個單詞。載入內存,存儲在字典數據變量 dicts 中。

這是 dict 結構第一次真正存儲字典!

- dictdicts = dict()

- with open('103976.txt','r',encoding='gbk') as f:

- for l in f.readlines():

- k = l[0:l.find('\t')]

- v = l[l.find('\t')+1:]

- dicts.update({k:v})

刪除認識的單詞

字典當中大量的 the a is,相當挑戰我們的容忍度,這讓旁人看了,還以為我們小學沒畢業呢。去掉去掉……

眾所周知,我們采用了小學二年級就掌握的 postgrade.txt 英文字典。

postgrade.txt 同學們肯定耳熟能詳。神奇的是第一個單詞。abandon vt.離棄,丟棄;遺棄,拋棄;放棄

- with open('postgrade.txt','r',encoding='utf-8') as f:

- f.readline()

- for l in f.readlines():

- k = l[:l.find(' ')]

- try:

- del dicts[k]

- except KeyError as e:

- pass

現在,字典 dicts 中,僅僅剩下所我們不認識的,103976 - 5000 = 98976 個單詞了。

生成新字典

以詞頻單詞來查找單詞表,再把單詞和釋義存到新單詞表中,就得到新單詞表了。

- with open('f1_res.txt','w',encoding='utf-8') as wf,open('result_f1.txt','r',encoding='utf-8')as f:

- for l in f.readlines():

- k = l[:l.find(' ')]

- v = dicts.get(k,None)

- if v:

- wf.write('%s %s'%(k,v))

- wf.close()

這里第一句,兩個 with 可以寫到一句話里。這樣代碼看起來比較和諧。

查字典方法,使用v = dicts.get(k,None),這樣查不著的單詞,返回 None,寫入新字典時判斷這個值,就可以了。

總結

除此處介紹的生生單個文檔字典外,還可多拿幾個領域專業文檔,提取它們的常用單詞,然后生成專屬字典,這字典,相當于相關領域的專業英語字典。

這里使用 Python 自帶庫寫程序,效率可能不高。如果需要,可以使用 pandas 之類的庫來實現,提高效率。