超級人工智能會毀滅人類嗎?

北京時間7月9日消息,以下為George Dvorsky對超級人工智能的看法:我相信,機器智能將是人類種下的最后禍根。這二十多年來,我所想的和寫的,大多和機器智能毀滅人類的潛力有關。我為此受到了諸多抨擊,但我還是想說,我們不能忽視這樣的未來可能性:人類文明或毀于自己發明的工具。

反對“超級人工智能毀滅人類”這個想法的觀點不在少數,其中一個反對觀點出乎意料地常見,而我卻覺得十分荒唐。它不是說超級人工智能本身不可能,也不是說我們無法阻止邪惡的機器毀滅我們。這個天真爛漫的反對觀點竟然認為,一臺無比聰明的計算機壓根沒有終結人類的手段或動機。

控制和理解的缺失

想象一下我們有這樣一些系統,無論是生物的還是人工的,它的智慧水平相當于或遠高于人類智慧。通過基因工程、納米技術、信息技術和認知科學的融合,我們可以從根本上增強人類的大腦(甚至于非人類的動物大腦),而超越人類的機器智能十分有可能來自于計算機科學、認知科學和全腦仿真的進步。

接著,這些系統中的一個出了問題,或者它們被故意用作武器。遺憾的是,一旦這些系統出現,我們大概率沒有辦法控制它們,也無法預測這些系統響應我們請求的方式。

蘇珊·施奈德是未來心靈中心的主任,也是“Artificial You: AI and the Future of the Mind”一書的作者。她在郵件中解釋說:“這就是我們常說的控制問題。簡單來說就是,如何控制一個比我們聰明得多的人工智能。”

施奈德提到了著名的回形針場景,作為類比。回形針場景,即一家回形針制造商有一個編程上很糟糕的人工智能,準備最大化自己的回形針生產效率。結果卻是,這個人工智能把地球上的一切都變成了回形針,從而毀滅了地球。牛津大學哲學家尼克·博斯特羅姆在他2014年的著作“Superintelligence: Paths, Dangers, Strategies”中將這類風險命名為“反常實例化”。或者用施奈德的話更簡單地來說,即有一個古老的魔法精靈故事,故事里三個愿望的實現“永遠不會順利”。在這里,普遍的擔憂是,我們想讓超級智能去做一些事情,而由于我們自己都不太了解要做的這些事情的細節,超級智能將嚴重曲解我們的愿望,從而導致一些我們不愿意看到發生的事情發生。

例如,我們可以“許愿”實現一種有效提取太陽能的方法,結果卻是超級智能篡奪我們整個地球的資源去建造一個超大型的太陽能陣列。正如博斯特羅姆推測的那樣,要求超級智能“最大化人類幸福感”,可能會迫使超級智能重新連接我們大腦中的快樂中心,或把我們的腦子上傳到超級計算機上,強迫我們永生永世體驗那五秒鐘的快樂循環。一旦超級人工智能出現,厄運將會以某種離奇且意想不到的方式降臨。

人工智能機器研究所的人工智能理論家埃利澤·尤德科夫斯基在他的論文中,將超級人工智能視為優化過程,或“在大型搜索空間中擊中小目標以產生合乎邏輯的現實世界效果的系統”。問題是,這些過程往往傾向于探索廣闊的可能性空間,其中很多是我們壓根無法想象的。尤德科夫斯基寫道:

“我正在訪問一座遙遠的城市,一位當地朋友主動提出開車送我去機場。我不知道附近情況。當朋友來到十字路口時,我無法預測他會超哪個方向拐彎。但是我仍然可以預測朋友的一系列不可預測行為的最后結果:我們會抵達機場。即便我朋友的家在這座城市的其他地方,因此他可能會做一系列完全不同的拐彎,但我仍然可以自信地預測我們的目的地。從科學角度來將,這難道不是一個奇怪的場景嗎?我可以預測過程的結果,卻無法預測這個過程中的任何一個中間步驟。”

脫離了人類環境,并受到其基于目標的編程驅動,機器在嘗試從A到B的過程中,可能會造成相當嚴重的附帶傷害。可怕的是,人工智能也可能在嘗試實現自己的目標時,利用和濫用預先存在的強大資源——人類,并且怎么利用和濫用,又是我們無法預測的。

讓人工智能對人類友好

用一組預先確定的道德考量進行編程的人工智能或許可以避免某些陷阱,但尤德科夫斯基指出,我們幾乎無法預測人工智能可能遵循的所有路徑。

針對控制問題的一個可能解決方案是向人工智能灌輸兼容人類的道德準則。根據這個思路,如果我們能成功,一臺強大的機器或許可以避免造成傷害,或避免以違反我們倫理道德感的方式做它自己的事情。施奈德說,但問題在于,我們如果想要“按照道德準則進行編程,那我們就需要一個良好的道德理論,然而在倫理道德領域,我們有太多太多的分歧”。

十分有道理。人類從來沒有達成一個人人都認同的共同道德準則。但凡對列車問題稍有一點了解的人都會告訴你,倉促之下,道德問題會變得超級復雜。通過向超級智能傳授人類道德,來達到使超級智能變得安全和可控的目的,這個想法,可能行不通。

方式和方法

路易斯維爾大學計算機科學和工程教授羅曼•揚波爾斯基解釋說:“如果我們可以預測超級智能的行為,那我們自己就是那個超級智能。根據定義,超級智能比任何一個人類都更加聰明,所以它可以想出一些未知的未知解決方案”,去完成我們交代它的任務,無論這個任務是設計一種治療瘧疾的新藥、制定戰場策略還是管理本地電網。盡管如此,揚波爾斯基相信,我們或許可以通過觀察聰明人會如何設法統治世界或摧毀世界,來預測超級智能的惡意行為。

他說:“比如,蛋白質折疊問題的解決方案”,即使用氨基酸序列來確定蛋白質的三維形狀,“這個解決方案可能被用于創建一支生物納米機器人軍隊。當然,還有很多不那么新奇的辦法可以利用。人工智能可以完成一些股票交易、或打撲克、或寫作,然后用獲得的收益雇傭人類聽它差遣。鑒于最近加密貨幣的流行,這樁買賣可以大規模地暗中進行。”

揚波爾斯基說,如果有足夠的財政資源,你可以輕易地從云端獲取計算資源,并通過社會工程來影響現實世界,或者,像揚波爾斯基說的那樣,雇傭一支“人類勞動力大軍”。超級智能或許可以通過財富的積累、CPU性能、存儲能力以及影響范圍的提升,逐漸變得更加強大、更有影響力。

西班牙馬德里自治大學的計算科學家曼努埃里•阿方索卡解釋說,令人恐懼的是,超級智能可以就如何在我們的指令之外采取行動,做出一些判斷。

他說,超級人工智能可能“得出結論,即沒有人類,這個世界會更美好,并消滅我們”。他還補充說,有些人引用這一可怕的可能性來解釋我們為什么到目前為止仍沒有找到外星智慧生命;也許,阿方索卡說,“所有外星智慧都已被超級人工智能所取代,而人類在這些超級人工智能看來,不過是一種低等的生命形式,因此它們無意與我們交流”。

對于想要故意毀滅人類的超級智能來說,成功的最簡單之道就是利用我們的生物弱點。人類在沒有食物的情況下可以生存大約30天,沒有水的話只能生存3到4天,但是缺了氧氣,我們連幾分鐘都撐不下去。一臺足夠智能的機器很有可能會發現一種方法,來徹底清除我們大氣中的氧氣,也許它可以通過某種自我復制的納米技術群來實現這個操作。未來主義者對此有一個專門的描述,叫做全球生態吞噬,或可怕的“灰蠱情景”。在這種情景下,大量精心設計的分子機器將尋找特定的資源,然后把它們變成其他東西,包括自身的副本。這種資源不一定是氧氣,只要清除對人類生存至關重要的關鍵資源就行了。

非科幻小說

這一切聽起來都極具科幻色彩,但阿方索卡說,帶有猜測性質的虛構故事有助于強調潛在的風險,特指《黑客帝國》。施奈德也相信虛構故事的力量,她提到了反烏托邦短片《屠戮機器》。在這部短片中,武裝無人機襲擊了一間教室。施奈德說,人們對于危險的人工智能和自主殺人機器的擔憂越來越“接近當下”。例如,無人機技術可以利用現有的面部識別軟件來瞄準人類。施奈德說:“這是一個嚴重的問題。”因此,她認為,《屠戮機器》非常值得一看。

麻省理工學院的機器學習研究員馬克思•泰格馬克在他一本2017年出版的書中寫道,諸如《終結者》這類影片雖然呈現了模糊的未來可能情景,但也“讓人們的關注點偏離了人工智能帶來的真正風險和機遇”。泰格馬克設想了一個更微妙、甚至更陰險的情景。在他的設想中,機器通過狡猾的社會工程和詭計以及穩定地收集有價值的資源,來統治全世界。在他的書中,泰格馬克提到了“普羅米修斯”。這是一種假設的通用人工智能(AGI),使用其自適應智能和多功能性,從而“以多種方式控制人類”,而那些反抗的人也沒辦法“簡單地用關掉普羅米修斯的方式”來擺脫控制。

就其本身而言,通用機器智能的出現注定是意義深遠的,且十分可能成為人類歷史的一個轉折點。一個通用人工智能“將有能力遞歸地設計出更優的通用人工智能。最終,物理定律將成為這個不斷改進的通用人工智能的唯一限制。當然,物理定律范圍內允許的智慧,似乎遠在人類智慧水平之上,”泰格馬克寫道。換句話說,人工智能可以用來發明超級智能。這樣一個時代,即我們人類或將有見證“智能爆炸”的時代,將出現一些嚴重的、我們不希望發生的后果。

泰格馬克寫道:“如果有一群人成功控制了智能爆炸,那么這群人可能會在幾年內統治全球。如果人類無法控制智能爆炸,那么人工智能自己將會更快地統治世界。”

永遠的旁觀者

另一個關鍵漏洞與人類越來越被排斥在技術循環之外的方式有關。眾所周知,算法如今掌管著大部分的股票交易;也許更臭名昭著的是,算法如今也可以在近距離空戰中擊敗人類的F-16飛行員。越來越多的人工智能被要求在無人類干預的情況下做出重大決策。

施奈德擔心,“軍隊中已經存在人工智能軍備競賽”,以及“對人工智能的日益依賴將導致人類的感知和認知能力無法以足夠快的方式應對軍事挑戰”。施奈德說,我們會要求人工智能去為我們完成這些任務,但我們仍不知道該如何繼續讓人類處于這個技術循環之中。她還解釋說,可以想象,面對軍事攻擊時,人工智能將最終代表我們人類去應戰——甚至在我們人類還未來得及合成傳入的數據之前。

人類容易犯錯,特別是在戰場上處于壓力之下時,但人工智能的誤判可能會帶來額外的風險。這樣我們不禁想起1983年曾發生的一次事故。當時,蘇聯的預警系統差點引發一場核戰爭。

科幻作家艾薩克•阿西莫夫已然預見到這一天的到來。在他的小說中,盡管受到機器人三大定律的約束,但他筆下的機器人依然遇到了各式各樣的麻煩,哪怕我們人類已經盡了最大的努力。如果我們試圖去做一些類似的事情的話,相似的問題或將浮現。盡管,施奈德表示,想要就指導我們機器人同胞的道德準則達成一致,這本身就很難。

但是,我們除了一試別無選擇。考慮到這其中的利害關系,對落敗一笑置之不是一個真正的選擇。正如博斯特羅姆所說,我們的“智慧必須優于我們的技術”。

眼下十分要緊的是一系列潛在的全球災難,這些問題甚至出現在超級人工智能問世以先。而我們人類顯然一點也不擅長應對全球性災難,這一點已經毋庸置疑。

新冠病毒及其棘手的變異體幾乎不具備什么智慧,但這種病毒仍能夠利用我們的弱點——無論是生物上的弱點還是社交上的弱點——被動地運作。這種導致了全球疫情的病毒可以適應我們的防范措施,不過只能通過隨機突變和選擇的過程,而這些過程始終受生物學的約束。更不祥的是,一個邪惡的人工智能可以設計自己的“低智慧”病毒,并不斷地調整該病毒以創造更致命的新變異體,來應對我們的防范措施。

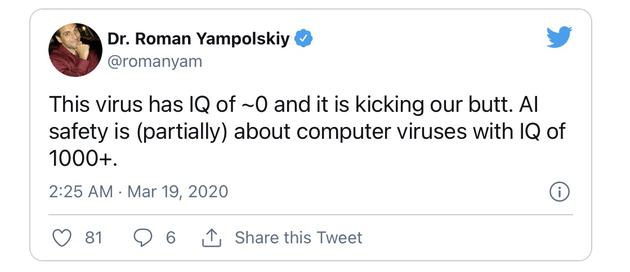

在疫情初期,揚波爾斯基曾說:“這個病毒智商幾乎為0,卻讓我們焦頭爛額。人工智能安全(部分地)相當于計算機病毒,但智商卻高達1000以上。”

遺憾的是,正如我們所知,超級人工智能不缺終結人類文明的辦法,不是通過簡單的蠻力,而是通過自適應的設計、強化的形勢感知和迅捷的計算反應,以更有效的方式來終結人類文明。那么,是不是有可能創建一個安全、有益且有道德的人工智能呢?唯一的選擇或許在于在全球范圍內禁止開發近乎超級智能的人工智能。這雖然不太可能,但確實十分有必要。(勻琳)