對比學習也會維度崩潰?LeCun和田淵棟團隊新作DirectCLR幫解決

自監督學習在計算機視覺中的應用十分廣泛,能夠在沒有人工標注的情況下學到輸入數據的有效表示。

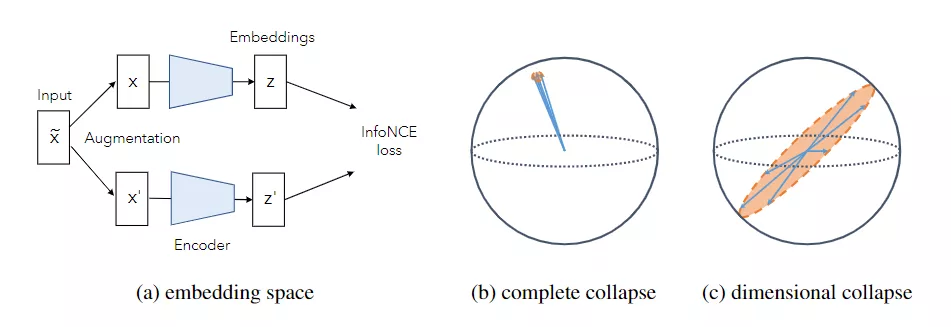

目前基于聯合嵌入方法(joint embedding method)的自監督視覺表征學習研究進展表明,自監督學習得到的表示性能和有監督表示相比相差不大。這些方法的目標通常是通過最大限度地利用同一圖像不同失真度的嵌入向量之間的一致性來學習對數據增強保持不變的表示。

但自監督模型存在崩潰問題,即將所有輸入映射到同一常數向量,因此研究人員提出了各種方法來解決該問題,這些方法依賴于不同的機制,雖然成功地防止了所有表示向量收縮到單個點的完全崩潰情況,但在非對比學習方法中可以觀察到,雖然嵌入向量不會完全崩潰,但它們會沿著特定的維度崩潰(dimensional collapse),這導致嵌入向量只能在較低維度的子空間中有效。

按照直覺來說,對比學習中應當不會出現這種崩潰問題,因為對比學習的方法中明確使用損失函數中的正例和負例,可以直觀地利用所有維度推測負例的排斥效來防止這種維度崩潰。然而,與直覺恰恰相反,對比學習方法仍然受到維度崩潰的影響。

對于這種現象的成因一直沒有定論,Facebook的LeCun和田淵棟博士最近發布了一篇文章,從理論上研究了這一現象背后的動因。

田淵棟博士是Facebook人工智能研究院研究員、研究經理,上海交通大學獲得計算機本科和碩士學位,2013年獲得卡耐基梅隆大學機器人系博士,致力于深度強化學習、表征學習和優化。

論文中,研究人員發現有兩種不同的機制可能會導致崩潰:

1、沿著特征方向,當數據增加引起的方差大于數據分布引起的方差時,權重會崩潰。

2、即使數據增強的協方差在所有維度上都小于數據方差,由于不同層面上權重矩陣的相互作用(隱式正則化),權重仍將崩潰,這種崩潰只發生在網絡具有多個層的網絡中。

受這種理論的啟發,文章提出了一種新的對比學習方法DirectCLR,它直接優化編碼器(即表示空間),而不依賴可訓練的投影(projector),DirectCLR在ImageNet上具有線性可訓練投影儀,其性能優于SimCLR。

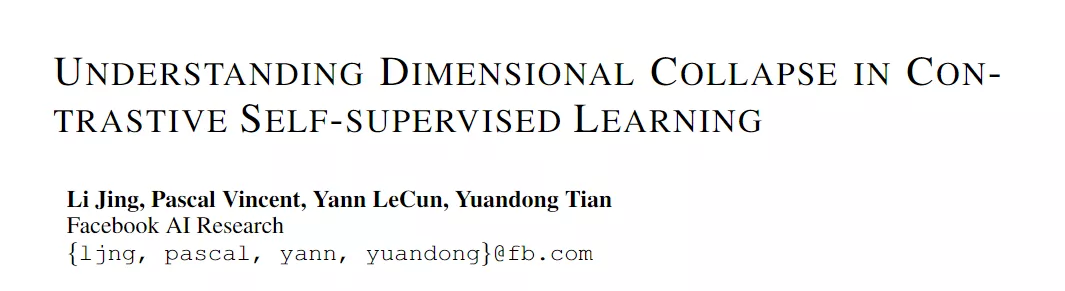

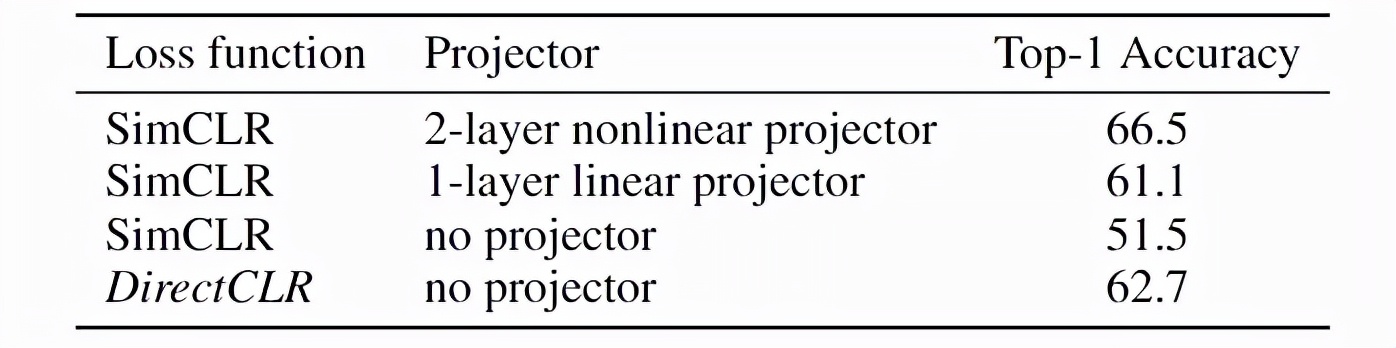

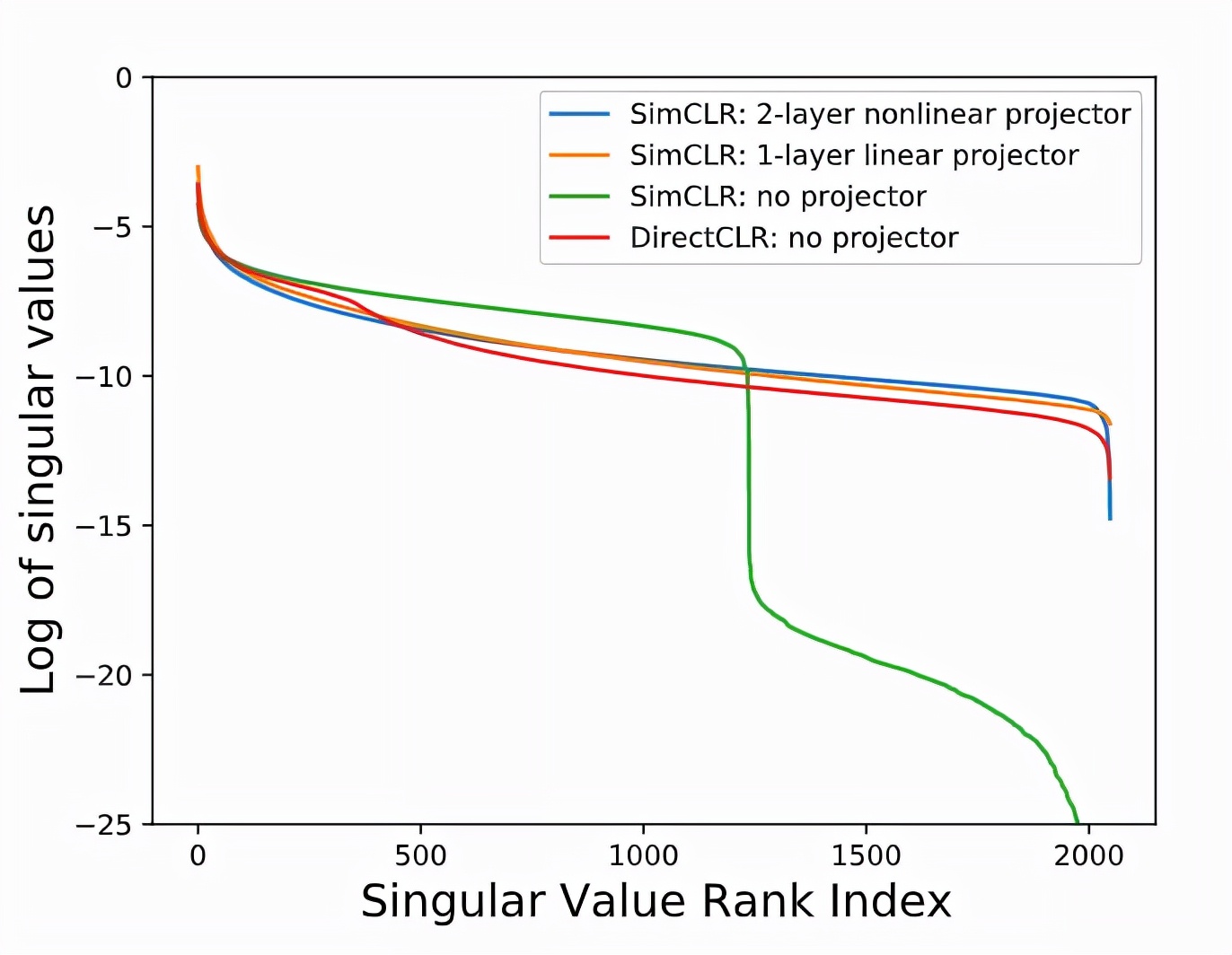

從經驗上看,增加projector可以顯著提高學習到的表現和下游表現的性能,檢查表示層的spectrum也會發現有無projector的差異。研究人員訓練了兩個帶projector和不帶projector的SimCLR模型,當模型在沒有projector的情況下進行訓練時,SimCLR 會發生表示空間中的維度崩潰。

對比學習中的projector對于防止表征空間中的維度崩潰至關重要,基于這個理論,研究人員提出:

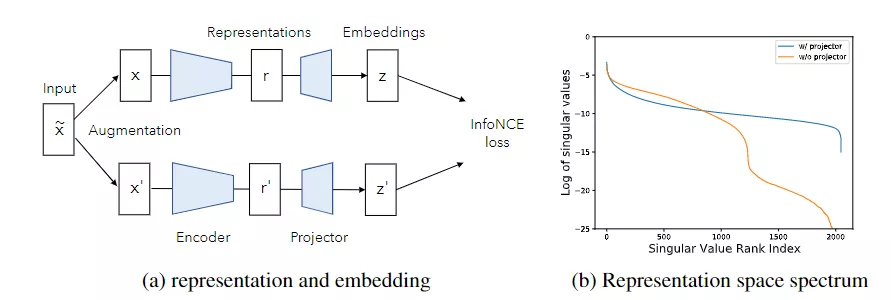

- 梯度將會驅動projector權重矩陣與編碼器主干的最后一層對齊,因此projector 權重矩陣只需要是對角的(diagonal)即可。

- projector 僅對表示的子空間應用梯度,因此權重矩陣只需是一個低秩矩陣。

作者提出在對比學習中通過直接向損失函數發送表示向量的子向量來移除projector,這個操作也稱為DirectCLR。與所有最新的自監督學習方法相比,這種方法能夠直接優化表示空間。

隨后研究人員在ImageNet上為DirectCLR訓練了100個epoch 的標準Sim-CLR,主干編碼網絡是一個ResNet50。DirectCLR與使用ImageNet上可訓練線性projector 的SimCLR相比表現出更好的性能。

DirectCLR 也能夠實現似于SimCLR中可訓練projector 的功能來防止表示空間中的維度崩潰。

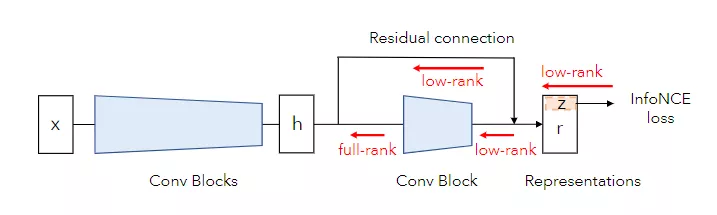

有人可能會認為DirectCLR 中的對比損失沒有在表示向量r[d0:]的其余部分應用梯度,事實上,整個表示向量r 經過訓練并包含有用的信息。表示向量的其余部分通過殘差連接從最后一個剩余塊之前的層復制。表示的這一部分不直接經歷來自損失函數的梯度,而是通過卷積塊由梯度更新,殘差連接通過最后一個卷積塊的滿秩梯度。

研究人員還進行了三項消融實驗:

- 固定的低秩projector:這時DirectCLR退化為一個帶有固定線性、對角矩陣projector的SimCLR。實驗結果觀察到,當使用固定的低秩矩陣作為projector 時,它在ImageNet上的性能類似,從而達到62.3%的線性probe 精度。該低秩矩陣的奇異值設置為d0數為1,其余為0。該矩陣對應的奇異向量都是隨機生成的。因此,它們唯一的區別是,這個固定的projector 有一個額外的固定正交矩陣。這表明表示空間(或相當于前一層)在訓練期間已進化為與該正交矩陣對齊。

- 可訓練的對角線projector:研究人員訓練了一個SimCLR模型,該模型帶有一個可訓練的projector ,但僅限于對角線的數值。該模型在ImageNet上實現了60.2%的線性probe 精度,與帶有1層線性投影儀的SimCLR相當。這也可以通過projector 與主干中的前一層對齊的對齊現象來解釋。但研究人員懷疑初始化問題是該模型比具有1層線性可訓練投影儀的SimCLR稍差的原因:隨機矩陣的奇異值不同于均勻分布。

- 在子向量z上的線性probe:對于DirectCLR,研究人員僅在子向量z上執行線性probe,并在ImageNet上獲得47.9%的精度。這表明即使r 沒有看到直接來自損失函數的梯度,但它其余部分仍然包含有用的信息。

為了保證論文可以成功復現,論文的附錄中還提供了每個引理和定理的詳細證明、代碼以及參數。