NLP大火的prompt能用到其他領(lǐng)域嗎?清華孫茂松組的CPT了解一下

從 GPT-3 開始,一種新的范式開始引起大家的關(guān)注:prompt。這段時(shí)間,我們可以看到大量有關(guān) prompt 的論文出現(xiàn),但多數(shù)還是以 NLP 為主。那么,除了 NLP,prompt 還能用到其他領(lǐng)域嗎?對(duì)此,清華大學(xué)計(jì)算機(jī)系副教授劉知遠(yuǎn)給出的答案是:當(dāng)然可以。

圖源:https://www.zhihu.com/question/487096135/answer/2143082483?utm

論文鏈接:https://arxiv.org/pdf/2109.11797.pdf

在細(xì)粒度圖像區(qū)域,定位自然語(yǔ)言對(duì)于各種視覺語(yǔ)言任務(wù)至關(guān)重要,如機(jī)器人導(dǎo)航、視覺問(wèn)答、視覺對(duì)話、視覺常識(shí)推理等。最近,預(yù)訓(xùn)練視覺語(yǔ)言模型(VL-PTM)在視覺定位任務(wù)上表現(xiàn)出了巨大的潛力。通常來(lái)講,一般的跨模態(tài)表示首先以自監(jiān)督的方式在大規(guī)模 image-caption 數(shù)據(jù)上進(jìn)行預(yù)訓(xùn)練,然后進(jìn)行微調(diào)以適應(yīng)下游任務(wù)。VL-PTM 這種先預(yù)訓(xùn)練再微調(diào)的范式使得很多跨模態(tài)任務(wù)的 SOTA 被不斷刷新。

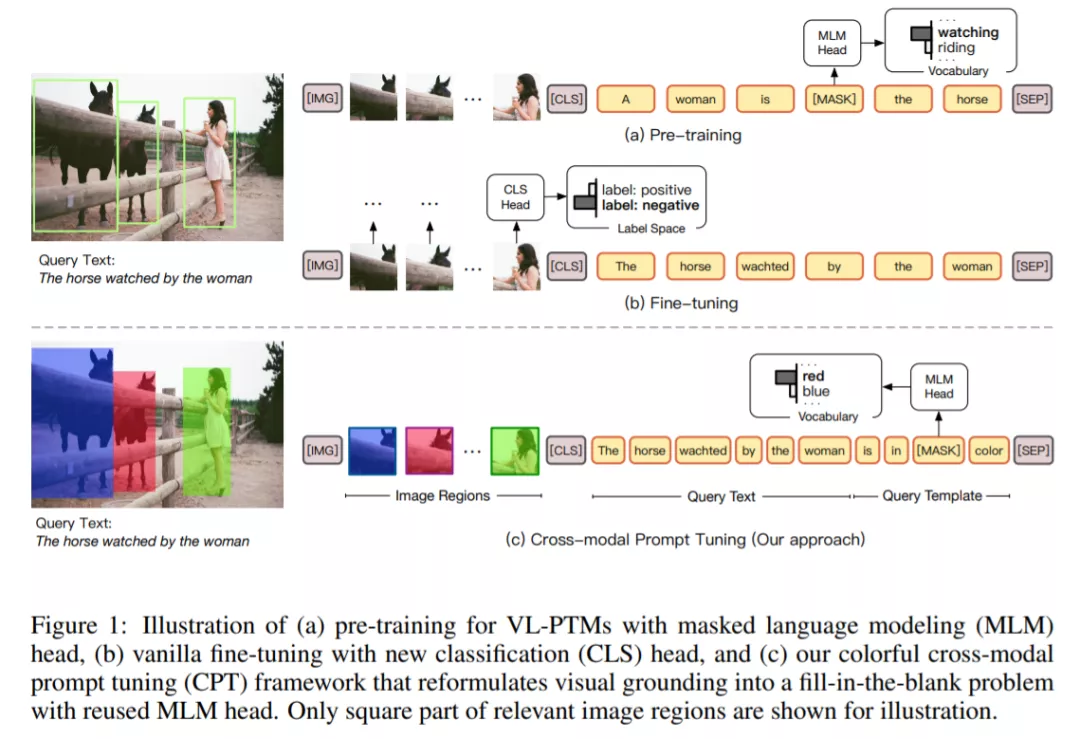

但盡管如此,清華大學(xué)、新加坡國(guó)立大學(xué)的研究者還是注意到,VL-PTM 的預(yù)訓(xùn)練與微調(diào)的 objective form 之間存在顯著差異。如下圖 1 所示,在預(yù)訓(xùn)練期間,多數(shù) VL-PTM 都是基于掩碼語(yǔ)言建模目標(biāo)進(jìn)行優(yōu)化,試圖從跨模態(tài)上下文恢復(fù) masked token。然而,在微調(diào)期間,下游任務(wù)通常通過(guò)將 unmasked token 表示歸為語(yǔ)義標(biāo)簽來(lái)執(zhí)行,這里通常會(huì)引入針對(duì)特定任務(wù)的參數(shù)。這種差異降低了 VL-PTM 對(duì)下游任務(wù)的適應(yīng)能力。因此,激發(fā) VL-PTM 在下游任務(wù)中的視覺定位能力需要大量標(biāo)記數(shù)據(jù)。

在這篇論文中,受到自然語(yǔ)言處理領(lǐng)域的預(yù)訓(xùn)練語(yǔ)言模型進(jìn)展啟發(fā),研究者提出了一種調(diào)整 VL-PTM 的新范式——CPT( Cross-modal Prompt Tuning 或 Colorful Prompt Tuning)。其中的核心要點(diǎn)是:通過(guò)在圖像和文字中添加基于色彩的共指標(biāo)記(co-referential marker),視覺定位可以被重新表述成一個(gè)填空題,從而盡可能縮小預(yù)訓(xùn)練和微調(diào)之間的差異。

如圖 1 所示,為了在圖像數(shù)據(jù)中定位自然語(yǔ)言表達(dá),CPT 由兩部分構(gòu)成:一是用色塊對(duì)圖像區(qū)域進(jìn)行唯一標(biāo)記的視覺 sub-prompt;二是將查詢文本放入基于色彩的查詢模板的一個(gè)文本 sub-prompt。針對(duì)目標(biāo)圖像區(qū)域的顯式定位可以通過(guò)從查詢模板中的 masked token 中恢復(fù)對(duì)應(yīng)顏色文本來(lái)實(shí)現(xiàn)。

通過(guò)縮小預(yù)訓(xùn)練和微調(diào)之間的差距,本文提出的 prompt tuning 方法使得 VL-PTM 具備了強(qiáng)大的 few-shot 甚至 zero-shot 視覺定位能力。實(shí)驗(yàn)結(jié)果表明,prompted VL-PTMs 顯著超越了它們的 fine-tuned 競(jìng)爭(zhēng)對(duì)手。

本文的貢獻(xiàn)主要體現(xiàn)在兩個(gè)方面:

1. 提出了一種用于 VL-PTM 的跨模態(tài) prompt tuning 新范式。研究者表示,據(jù)他們所知,這是 VL-PTM 跨模態(tài) prompt tuning+ zero-shot、few-shot 視覺定位的首次嘗試;

2. 進(jìn)行了全面的實(shí)驗(yàn),證明了所提方法的有效性。

CPT 框架細(xì)節(jié)

視覺定位的關(guān)鍵是建立圖像區(qū)域和文本表達(dá)之間的聯(lián)系。因此,一個(gè)優(yōu)秀的跨模態(tài) prompt tuning 框架應(yīng)該充分利用圖像和文本的共指標(biāo)記,并盡可能縮小預(yù)訓(xùn)練和微調(diào)之間的差距。

為此,CPT 將視覺定位重新構(gòu)建為一個(gè)填空問(wèn)題。具體來(lái)說(shuō),CPT 框架由兩部分構(gòu)成:一是用色塊對(duì)圖像區(qū)域進(jìn)行唯一標(biāo)記的視覺 sub-prompt;二是將查詢文本放入基于色彩的查詢模板的一個(gè)文本 sub-prompt。有了 CPT,VL-PTM 可以直接通過(guò)用目標(biāo)圖像區(qū)域的彩色文本填充 masked token 來(lái)定位查詢文本,目標(biāo)圖像區(qū)域的 objective form 與預(yù)訓(xùn)練相同。

視覺 sub-prompt

給定一個(gè)圖像 I 以及它的區(qū)域候選 R = {v_1, v_2, . . . , v_n},視覺 sub-prompt 旨在用自然視覺標(biāo)記對(duì)圖像區(qū)域進(jìn)行獨(dú)特標(biāo)記。有趣的是,研究者注意到,在文獻(xiàn)中,彩色邊界框被廣泛用于對(duì)圖像中的對(duì)象進(jìn)行獨(dú)特標(biāo)記,以實(shí)現(xiàn)可視化。受此啟發(fā),研究者通過(guò)一組顏色 C 來(lái)關(guān)聯(lián)圖像區(qū)域和文本表達(dá),其中每種顏色

是由它的視覺外觀

(如 RGB (255, 0, 0))和顏色文本

(如:red)來(lái)定義的。然后他們用一種獨(dú)特的顏色

標(biāo)記圖像中的每個(gè)區(qū)域候選 v_i,以此來(lái)定位,這會(huì)產(chǎn)生一組彩色圖像候選Ψ(R; C),其中 Ψ(·) 表示視覺 sub-prompt。

在實(shí)驗(yàn)中,研究者發(fā)現(xiàn),用實(shí)心塊給目標(biāo)著色比用邊界框效果更好,因?yàn)榧兩繕?biāo)在現(xiàn)實(shí)世界的圖像中更為常見(如紅色 T 恤、藍(lán)色車)。由于視覺 sub-prompt 被添加到原始圖像中,因此 VL-PTM 的架構(gòu)或參數(shù)不會(huì)發(fā)生變化。

文本 sub-prompt

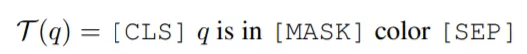

文本 sub-prompt 旨在提示 VL-PTM 建立查詢文本與被視覺 sub-prompt 標(biāo)記的圖像區(qū)域的聯(lián)系。具體來(lái)說(shuō),此處用一個(gè)如下所示的模板 T (·) 將查詢文本 q(如「the horse watched by the woman」)轉(zhuǎn)換為填空查詢:

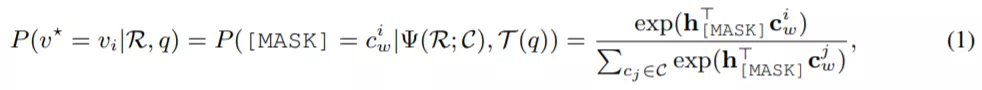

如此一來(lái),VL-PTM 會(huì)被提示決定哪個(gè)區(qū)域的顏色更適合填充掩碼(如紅色或黃色),如下所示:

其中,v^* 表示目標(biāo)區(qū)域,

是

在預(yù)訓(xùn)練 MLM head 中的嵌入。需要注意的是,這個(gè)過(guò)程并沒有引入任何新的參數(shù),而且還縮小了預(yù)訓(xùn)練和微調(diào)之間的差距,因此提高了 VL-PTM 微調(diào)的數(shù)據(jù)效率。

實(shí)驗(yàn)結(jié)果

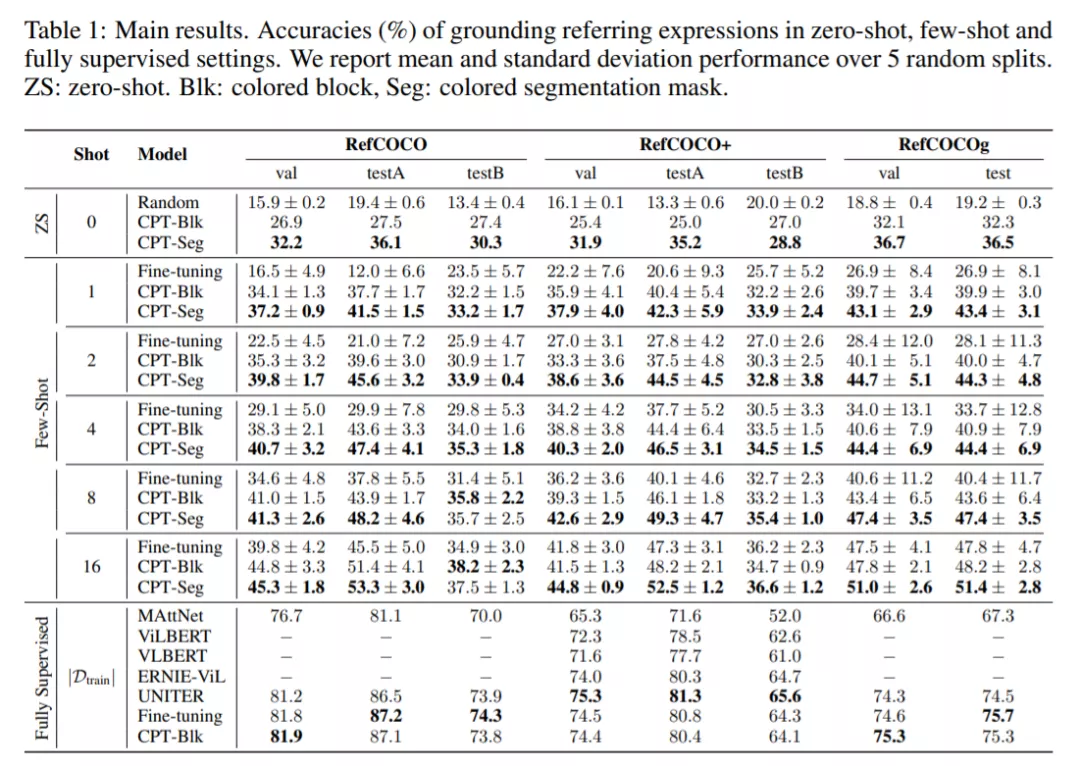

在實(shí)驗(yàn)部分,研究者對(duì) CPT 的能力進(jìn)行了評(píng)估,設(shè)置了 zero-shot、few-shot 和全監(jiān)督等多種情況,主要結(jié)果如下表 1 所示:

從表中可以看出:

1. 在 zero-shot 和 few-shot 設(shè)置中,CPT 的性能大大優(yōu)于隨機(jī)基線和強(qiáng)微調(diào)基線。例如,使用色塊作為視覺 sub-prompt,在 RefCOCO one shot 中,CPT 絕對(duì)準(zhǔn)確率提高了 17.3%,相對(duì)標(biāo)準(zhǔn)差平均降低了 73.8%。這表明 CPT 可以有效地提高 VL-PTM 微調(diào)的數(shù)據(jù)效率,并激發(fā) VL-PTM 的視覺定位潛力。

2. 在視覺 sub-prompts 中用分割掩碼給目標(biāo)著色(CPT-Seg)獲得了比塊(CPT-Blk)更好的結(jié)果。這是因?yàn)檫m合物體輪廓的純色在現(xiàn)實(shí)世界的圖像中更常見,這使得 CPT-Seg 成為更自然的視覺 sub-prompt(盡管需要更強(qiáng)的注釋來(lái)訓(xùn)練分割工具)。

3. 值得注意的是,CPT 實(shí)現(xiàn)的標(biāo)準(zhǔn)差明顯小于微調(diào)。例如,在 RefCOCO 評(píng)估中,CPT-Blk one-shot 相對(duì)標(biāo)準(zhǔn)差平均降低了 73.8%。這表明,來(lái)自預(yù)訓(xùn)練的連貫微調(diào)方法可以帶來(lái)更穩(wěn)定的 few-shot 訓(xùn)練,這是評(píng)估 few-shot 學(xué)習(xí)模型的關(guān)鍵因素。

4. 在 RefCOCO + 評(píng)估中,CPT-Blk 在 shot 數(shù)為 16 時(shí)比微調(diào)表現(xiàn)略差。原因是 RefCOCO + 有更多的基于顏色的表達(dá)(比如穿紅色襯衫、戴藍(lán)色帽子的人),這會(huì)干擾基于顏色的 CPT。然而,這個(gè)問(wèn)題可以通過(guò)在全監(jiān)督場(chǎng)景中使用更多的微調(diào)實(shí)例來(lái)緩解,在這種場(chǎng)景中,模型能夠?qū)W習(xí)如何更好地區(qū)分查詢文本和 promp 模板中的顏色。

5. 在全監(jiān)督的設(shè)置下,CPT 實(shí)現(xiàn)了與強(qiáng)微調(diào) VL-PTM 相當(dāng)?shù)男阅堋_@表明,即使在全監(jiān)督的場(chǎng)景中,CPT 也是 VL-PTM 的一種有競(jìng)爭(zhēng)力的調(diào)優(yōu)方法。

綜上所述,與普通的微調(diào)方法相比,CPT 在 zero-shot、few-shot 和全監(jiān)督的視覺定位任務(wù)中都實(shí)現(xiàn)了與之相當(dāng)或更優(yōu)越、更穩(wěn)定的性能。

更多細(xì)節(jié)請(qǐng)參見論文。