將點云與RGB圖像結合,谷歌&Waymo提出的4D-Net,檢測遠距離目標

如今自動駕駛汽車和機器人能夠通過激光雷達、攝像頭等各種傳感捕獲信息。作為一種傳感器,LiDAR 使用光脈沖測量場景中目標的 3D 坐標,但是其存在稀疏、范圍有限等缺點——離傳感器越遠,返回的點就越少。這意味著遠處的目標可能只得到少數幾個點,或者根本沒有,而且可能無法單獨被 LiDAR 采集到。同時,來自車載攝像頭的圖像輸入非常密集,這有利于檢測、目標分割等語義理解任務。憑借高分辨率,攝像頭可以非常有效地檢測遠處目標,但在測量距離方面不太準確。

自動駕駛汽車從 LiDAR 和車載攝像頭傳感器收集數據。每個傳感器測量值都會被定期記錄,提供 4D 世界的準確表示。然而,很少有研究算法將這兩者結合使用。當同時使用兩種傳感模式時會面臨兩個挑戰,1) 難以保持計算效率,2) 將一個傳感器的信息與另一個傳感器配對會進一步增加系統復雜性,因為 LiDAR 點和車載攝像頭 RGB 圖像輸入之間并不總是直接對應。

在發表于 ICCV 2021 的論文《 4D-Net for Learned Multi-Modal Alignment 》中,來自谷歌、Waymo 的研究者提出了一個可以處理 4D 數據(3D 點云和車載攝像頭圖像數據)的神經網絡:4D-Net。這是首次將 3D LiDAR 點云和車載攝像頭 RGB 圖像進行結合的研究。此外,谷歌還介紹了一種動態連接學習方法。最后,谷歌證明 4D-Net 可以更好地使用運動線索(motion cues)和密集圖像信息來檢測遠處目標,同時保持計算效率。

論文地址:https://openaccess.thecvf.com/content/ICCV2021/papers/Piergiovanni_4D-Net_for_Learned_Multi-Modal_Alignment_ICCV_2021_paper.pdf

4D-Net

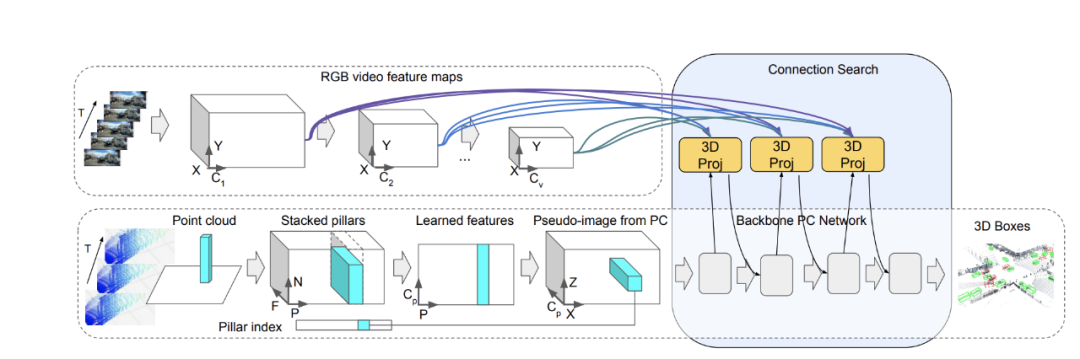

谷歌使用 4D 輸入進行目標 3D 邊框檢測。4D-Net 有效地將 3D LiDAR 點云與 RGB 圖像及時結合,學習不同傳感器之間的連接及其特征表示。

谷歌使用輕量級神經架構搜索來學習兩種類型的傳感器輸入及其特征表示之間的聯系,以獲得最準確的 3D 框檢測。在自動駕駛領域,可靠地檢測高度可變距離的目標尤為重要。現代 LiDAR 傳感器的檢測范圍可達數百米,這意味著更遠的目標在圖像中會顯得更小,并且它們最有價值的特征將在網絡的早期層中,與后面的層表示的近距離目標相比,它們可以更好地捕捉精細尺度的特征。基于這一觀察,谷歌將連接修改為動態的,并使用自注意力機制在所有層的特征中進行選擇。谷歌應用了一個可學習的線性層,它能夠將注意力加權應用于所有其他層的權重,并學習當前任務的最佳組合。

連接學習方法示意圖。

結果

谷歌在 Waymo Open Dataset 基準中進行了測試,之前的模型只使用了 3D 點云,或單個點云和相機圖像數據的組合。4D-Net 有效地使用了兩種傳感器輸入,在 164 毫秒內處理 32 個點云和 16 個 RGB 幀,與其他方法相比性能良好。相比之下,性能次優的方法效率和準確性較低,因為它的神經網絡計算需要 300 毫秒,而且比 4D-Net 使用更少的傳感器輸入。

3D 場景的結果。上圖:與檢測到的車輛相對應的 3D 框以不同顏色顯示;虛線框代表丟失的目標。底部:出于可視化目的,這些框顯示在相應的攝像機圖像中。

檢測遠處的目標

4D-Net 的另一個優點是,它既利用了 RGB 提供的高分辨率,可以準確地檢測到圖像上的目標,又利用了點云數據提供的精確深度。因此,點云方法無法探測到的遠距離目標可以被 4D-Net 探測到。這是由于相機數據的融合,能夠探測到遙遠的目標,并有效地將這一信息傳播到網絡的 3D 部分,以產生準確的探測。

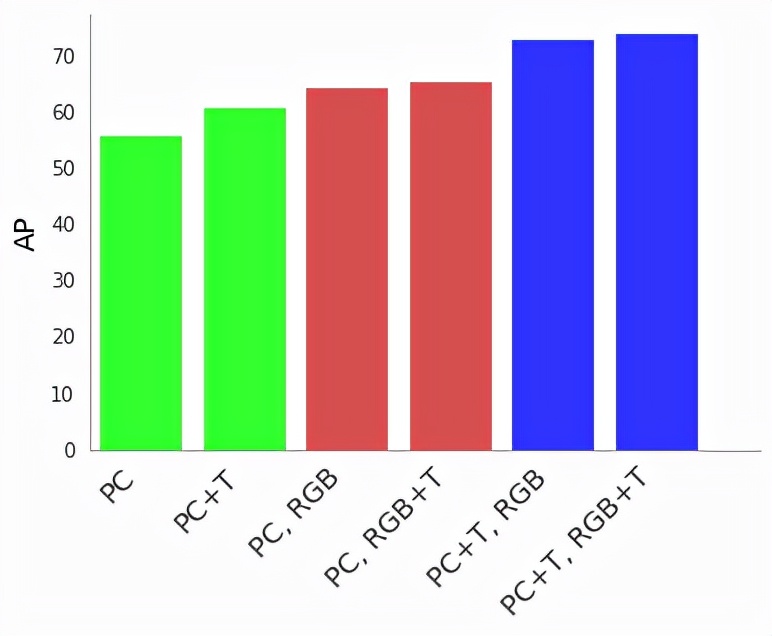

為了了解 4D-Net 帶來的優勢,谷歌進行了一系列消融研究。實驗發現,如果至少有一個傳感器輸入是及時流的,則可以顯著提高檢測準確率。及時考慮兩個傳感器輸入可以最大程度地提高性能。

使用點云 (PC)、時間點云 (PC + T)、RGB 圖像輸入 (RGB) 和時間 RGB 圖像 (RGB + T) 時,以平均精度 (AP) 測量 3D 目標檢測的 4D-Net 性能。

多流 4D-Net

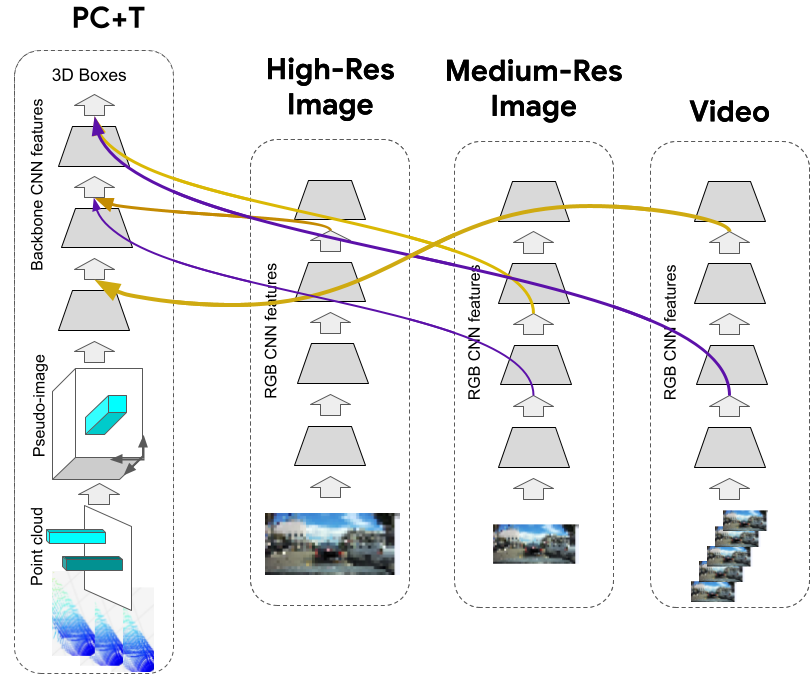

由于 4D-Net 動態連接學習機制是通用的,因此谷歌并沒有局限于僅將點云流與 RGB 視頻流結合起來。實際上,谷歌發現提供一個高分辨率單圖像流以及一個與 3D 點云流輸入結合的低分辨率視頻流非常劃算。因此,谷歌在下圖中展示了四流(four-stream)架構的示例,該架構比具有實時點云和圖像的兩流架構性能更好。

動態連接學習選擇特定的特征輸入以連接在一起。依托多個輸入流,4D-Net 必須學習多個目標特征表示之間的連接,這一點很好理解,因為算法沒有改變并且只需要從輸入中選擇特定的特征。這是一個使用可微架構搜索的輕量級過程,可以發現模型架構內部新的連接,并進而高效地找到新的 4D-Net 模型

多流 4D-Net 架構包含一個實時 3D 點云流以及多個圖像流(高分辨率單圖像流、中分辨率單圖像流和更低分辨率視頻流圖像)。

谷歌展示了 4D-Net 是一種高效的目標檢測方法,尤其適合檢測遠距離目標。研究者希望這項工作為未來的 4D 數據研究提供珍貴的資源。