解決Transformer訓練難題,微軟研究院把Transformer干到了1000層

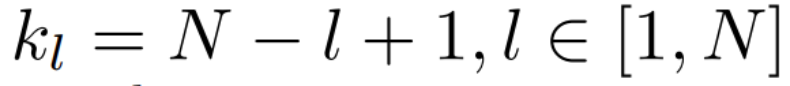

數小時前剛出爐的論文《DeepNet: Scaling Transformers to 1,000 Layers》,來自微軟研究院。

該研究直接把Transformer深度提升到1000層!

下面讓我們看下這篇研究說了什么。

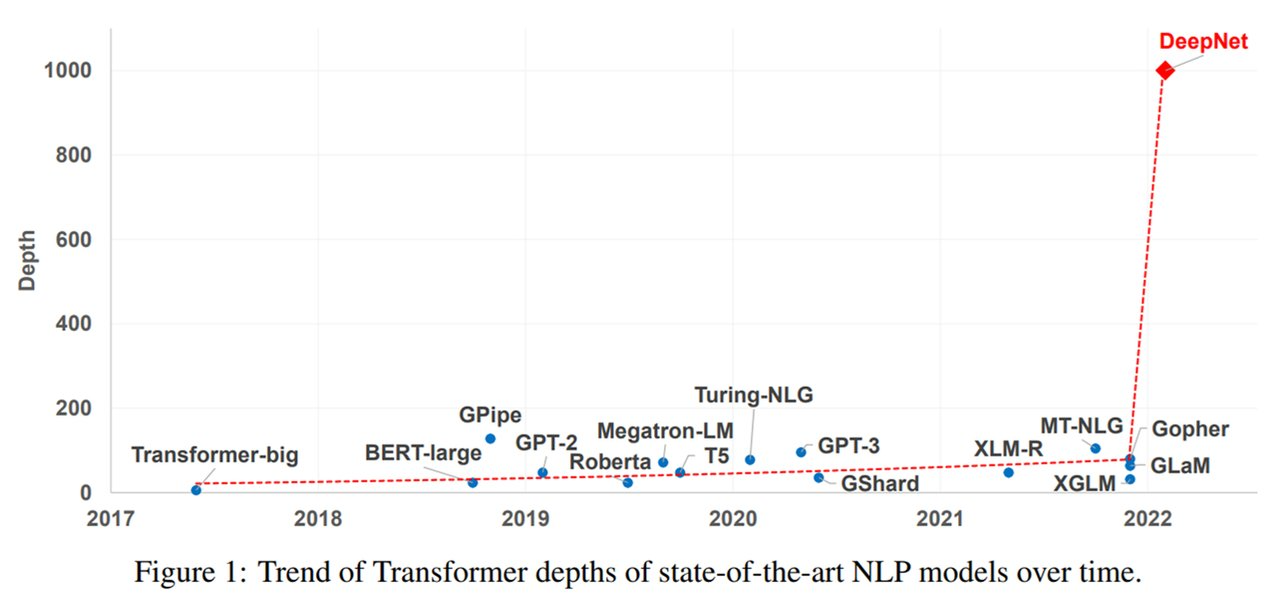

近年來,大規模 Transformer模型出現了這樣一種趨勢:隨著模型參數從數百萬增加至數十億甚至數萬億,性能相應地實現了顯著提升。大規模模型在一系列任務上都取得了SOTA性能,并在小樣本和零樣本學習設置下展現出了令人矚目的能力。如下圖1所示,盡管參數量已經很大了,但Transformer模型的深度(depth)卻受到了訓練不穩定的限制。

Nguyen和Salazar (2019)發現,基于post-norm連接(Post-LN),pre-norm 殘差連接(Pre-LN)能夠提升 Transformer的穩定性。但是,Pre-LN在底層的梯度往往大于頂層,因而導致與 Post-LN相比性能下降。為了緩解這一問題,研究人員一直努力通過更好的初始化或更好的架構來改進深度Transformer的優化。這些方法可以使多達數百層的Transformer模型實現穩定化,然而以往的方法沒有能夠成功地擴展至1000層。

微軟研究院在一篇新論文《DeepNet: Scaling Transformers to 1,000 Layers》中終于將Transformer的深度擴展到了1000層。

論文地址:

?https://arxiv.org/pdf/2203.00555.pdf

研究者的目標是提升 Transformer 模型的訓練穩定性,并將模型深度進行數量級的擴展。為此,他們研究了不穩定優化的原因,并且發現爆炸式模型更新是造成不穩定的罪魁禍首。基于這些觀察,研究者在殘差連接處引入了一個新的歸一化函數 —— DEEPNORM,它在將模型更新限制為常數時具有理論上的合理性。這一方法簡單但高效,只需要改變幾行代碼即可。最終,該方法提升了Transformer模型的穩定性,并實現了將模型深度擴展到了1000多層。

此外,實驗結果表明,DEEPNORM 能夠將 Post-LN 的良好性能和Pre-LN的穩定訓練高效結合起來。研究者提出的方法可以成為Transformers的首選替代方案,不僅適用于極其深(多于1000層)的模型,也適用于現有大規模模型。值得指出的是,在大規模多語言機器翻譯基準上,文中 32 億參數量的 200 層模型(DeepNet)比120億參數量的48層SOTA模型(即 Facebook AI的M2M模型)實現了 5% 的BLEU值提升。

DEEPNORM方法

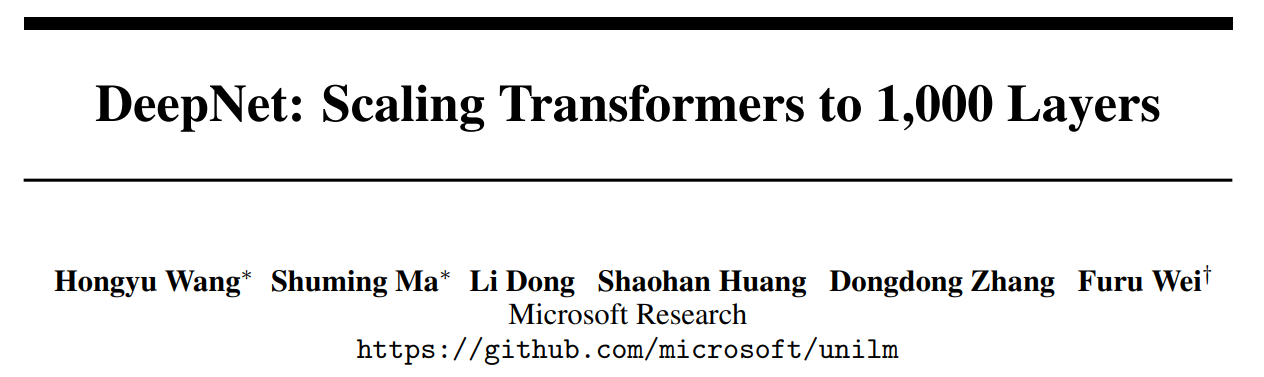

如下圖2所示,使用 PostLN 實現基于 Transformer 的方法很簡單。與 Post-LN 相比,DEEPNORM 在執行層歸一化之前up-scale了殘差連接。

(圖注)圖2:(a) DEEPNORM 的偽代碼,例如可以用其他標準初始化代替 Xavier 初始化 (Glorot and Bengio, 2010) ,其中α是一個常數。(b) 不同架構的 DEEPNORM 參數(N 層編碼器,M 層解碼器)。

此外,該研究還在初始化期間down-scale了參數。值得注意的是,該研究只擴展了前饋網絡的權重,以及注意力層的值投影和輸出投影。此外,殘差連接和初始化的規模取決于圖2中不同的架構。

深度Transformer的不穩定性

該研究分析了深度Transformer不穩定的原因。

首先,研究者觀察發現:更好的初始化方法可以讓 Transformer 的訓練更穩定。之前的工作(Zhang et al., 2019a; Huang et al., 2020; Xu et al., 2021)也證實了這一點。

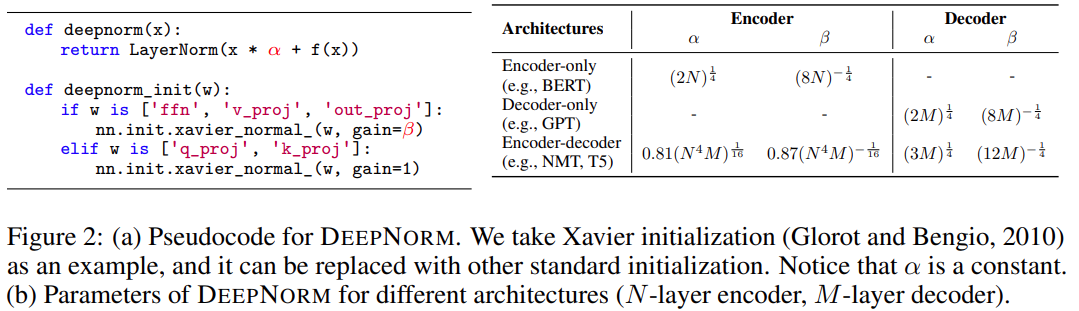

因此,研究者分析了有無適當初始化的 Post-LN 的訓練過程。通過更好的初始化,在執行 Xavier 初始化后通過

down-scale第l層的權重。例如,第l層 FFN 的輸出投影

被初始化為

其中d’是輸入和輸出維度的平均值。研究者將此模型命名為 Post-LN-init。請注意,與之前的工作(Zhang et al., 2019a)不同, Post-LN-init是縮窄了較低層的擴展而不是較高層。研究者相信這種方法有助于將梯度擴展的影響與模型更新區分開來。此外,Post-LN-init 與 Post-LN 具有相同的架構,從而消除了架構的影響。

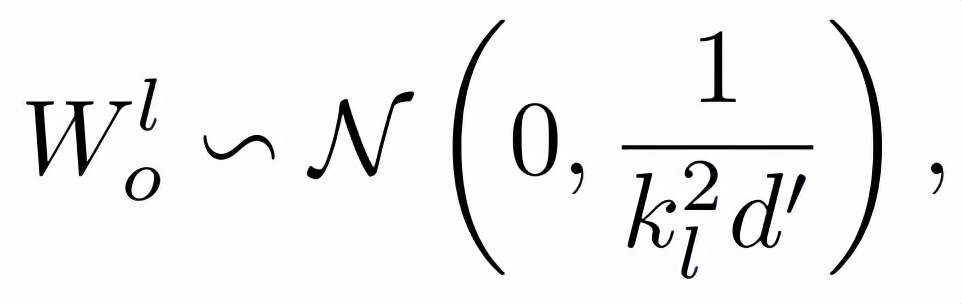

該研究在 IWSLT-14 De-En 機器翻譯數據集上訓練了 18L-18L Post-LN 和 18L-18L Post-LN-init。圖 3 可視化了它們的梯度和驗證損失曲線。如圖 3(c) 所示,Post-LN-init 收斂,而 Post-LN 沒有。 Post-LN-init 在最后幾層中具有更大的梯度范數,盡管其權重已按比例縮小。此外,研究者可視化最后一個解碼器層的梯度范數,模型深度從 6L-6L 到 24L-24L。

下圖 3 顯示,無論模型深度如何,最后一層 Post-LN-init 的梯度范數仍遠大于 Post-LN 的梯度范數。得出的結論是,深層梯度爆炸不應該是 Post-LN 不穩定的根本原因,而模型更新的擴展往往可以解釋這一點。

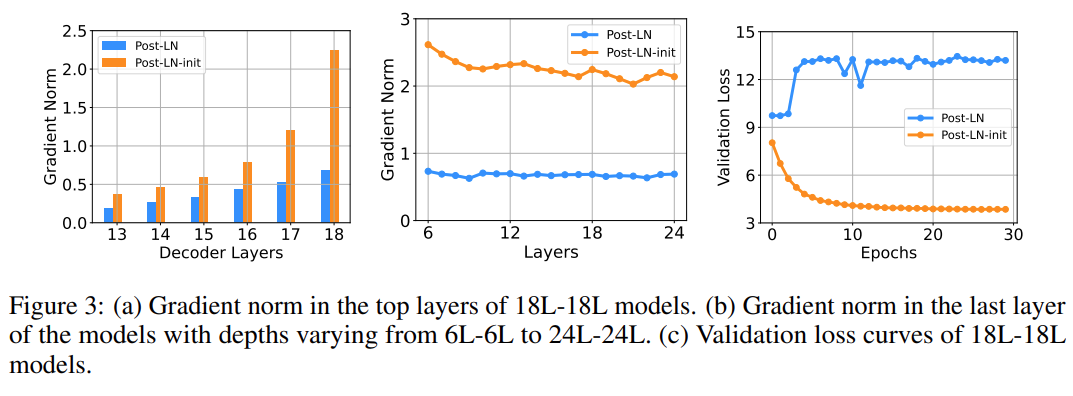

然后研究者證明 Post-LN 的不穩定性來自一系列問題,包括梯度消失以及太大的模型更新。如圖 4(a) 所示,他們首先可視化模型更新的范數 ||ΔF||在訓練的早期階段:

其中x和θ_i分別代表輸入和第i次更新后的模型參數。Post-LN在訓練一開始就有爆炸式的更新,然后很快就幾乎沒有更新了。這表明該模型已陷入虛假的局部最優。

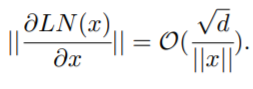

warm-up和更好的初始化都有助于緩解這個問題,使模型能夠順利更新。當更新爆炸時,LN 的輸入會變大(見圖 4(b) 和圖 4(c))。根據Xiong等人(2020)的理論分析,通過 LN 的梯度大小與其輸入的大小成反比:

相比于沒有warm-up或正確初始化的情況,圖 4(b) 和圖 4(c) 表明 ||x||的明顯大于

這解釋了 Post-LN 訓練中出現的梯度消失問題(見圖 4(d))。

最重要的是,不穩定性始于訓練開始時的大型模型更新。它使模型陷入糟糕的局部最優狀態,這反過來又增加了每個 LN 的輸入量。隨著訓練的繼續,通過 LN 的梯度變得越來越小,從而導致嚴重的梯度消失,使得難以擺脫局部最優,并進一步破壞了優化的穩定性。相反,Post-LN-init 的更新相對較小,對 LN 的輸入是穩定的。這減輕了梯度消失的問題,使優化更加穩定。

DeepNet:極深的Transformer模型

研究者首先介紹了極深的Transformer模型——DeepNet,該模型可以通過緩解爆炸式模型更新問題來穩定優化過程。

DeepNet基于Transformer架構。與原版Transformer相比,DeepNet在每個子層使用了新方法DEEPNORM,而不是以往的Post-LN。DEEPNORM的公式如下所示。

其中,α是一個常數,G_l(x_l , θ_l)是參數為θ_l的第l個Transformer子層(即注意力或前饋網絡)的函數。DeepNet還將殘差內部的權重θ_l擴展了β。

接著,研究者提供了對DeepNet模型更新預期大小(expected magnitude)的估計。

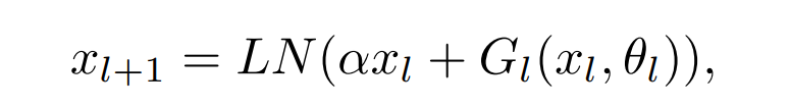

他們可視化了IWSLT-14 De-En翻譯數據集上,Post-LN和DeepNet在早期訓練階段的模型更新情況,如下圖5所示。可以看到,相較于Post-LN,DeepNet的模型更新幾乎保持恒定。

最后,研究者提供理論分析,以表明 DeepNet的更新受到了 DEEPNORM 的常數限制。具體地,他們展示了 DeepNet的預期模型更新受到了適當參數α 和 β的常數限制。研究者的分析基于 SGD 更新,并通過實證證明對 Adam 優化器效果很好。

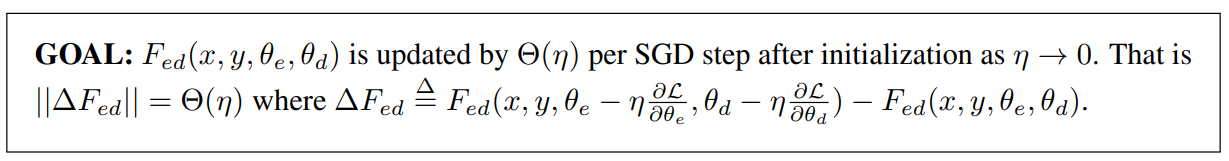

研究者提供了對編碼器-解碼器架構的分析,它能夠以相同的方式自然地擴展到僅編碼器和僅解碼器的模型。具體如下圖所示,他們將模型更新的目標設定如下:

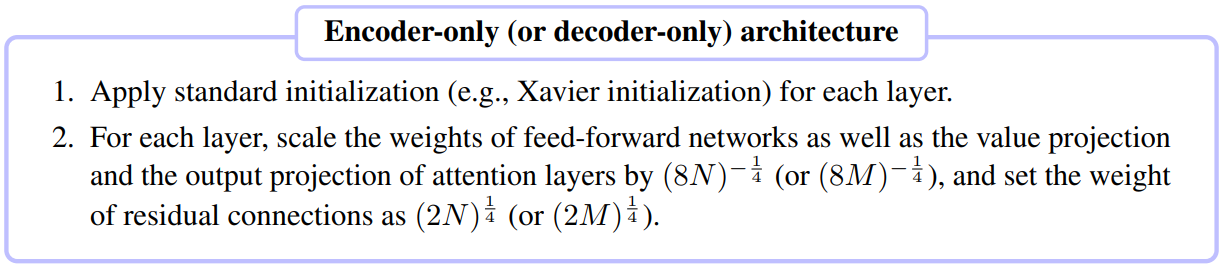

僅編碼器(例如 BERT)和僅解碼器(例如 GPT)架構的推導能夠以相同的方式進行。研究者將步驟總結如下:

神經機器翻譯

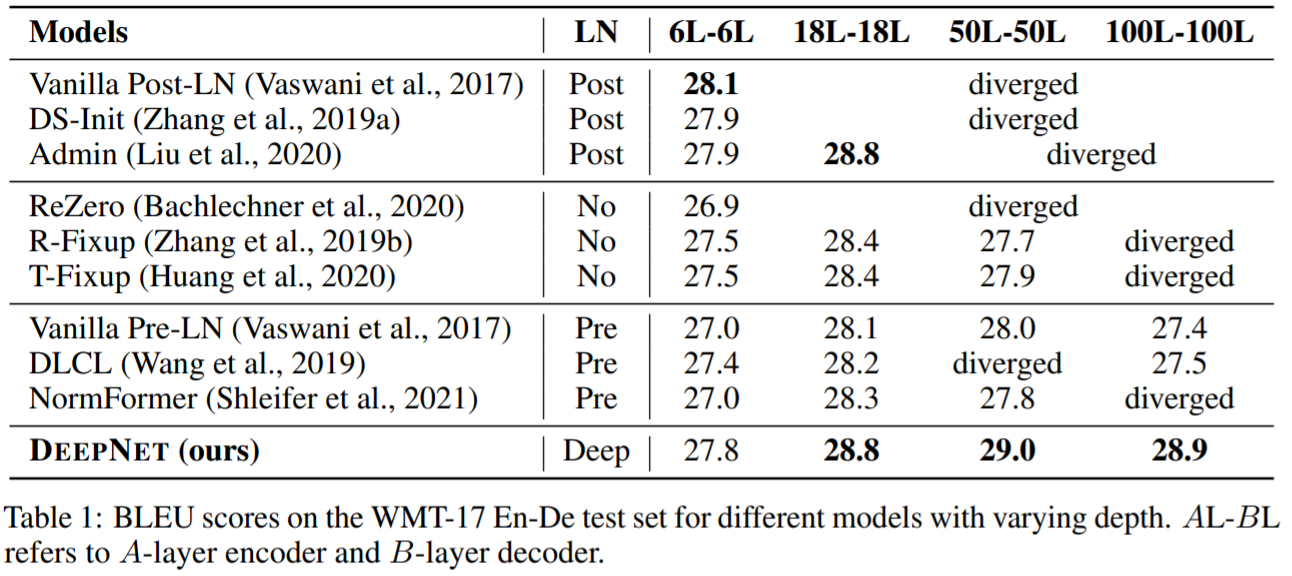

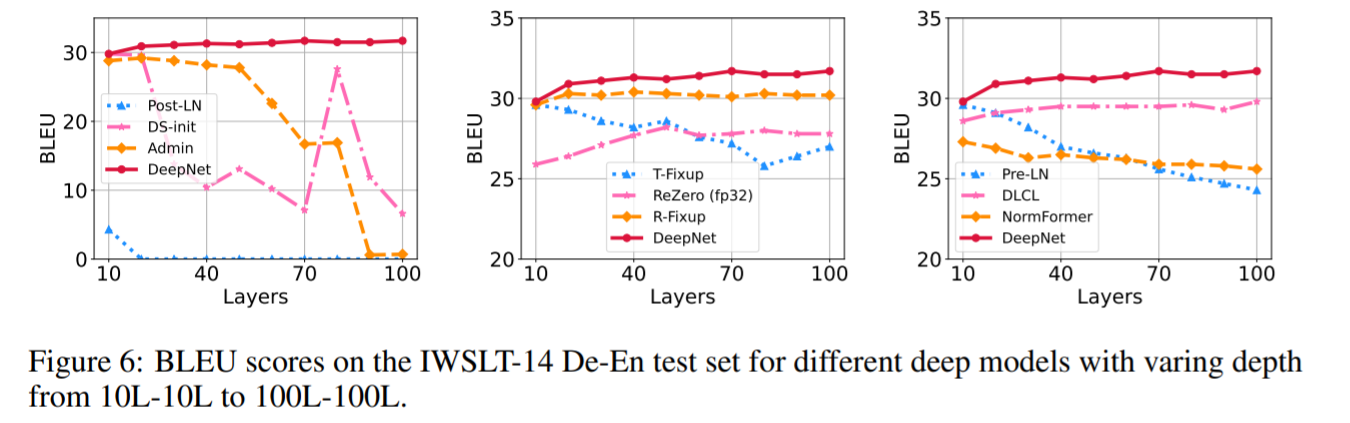

該研究驗證了DeepNet 在流行的機器翻譯基準上的有效性,包括 IWSLT-14 德語-英語 (De-En) 數據集和 WMT-17 英語-德語 (En-De) 數據集。該研究將DeepNet 與多個SOTA深度 Transformer 模型進行比較,包括 DLCL 、NormFormer 、ReZero 、R- Fixup 、T-Fixup 、DS-init 和 Admin。

表 1 報告了 WMT-17 En-De 翻譯數據集上的基線和DeepNet 的結果:

圖 6 顯示了 IWSLT-14 數據集的結果

圖 7 報告了 WMT-17 驗證集的損失曲線

大規模多語言神經機器翻譯

該研究首先使用 OPUS-100 語料庫來評估模型。OPUS100 是一個以英語為中心的多語言語料庫,涵蓋 100 種語言,是從 OPUS 集合中隨機抽取的。該研究將 DeepNet 擴展到 1,000 層,該模型有一個 500 層的編碼器、 500 層的解碼器、512 個隱藏大小、8 個注意力頭和 2,048 維度的前饋層。

表2總結了 DeepNet 和基線的結果。結果表明,增加網絡深度可以顯著提高 NMT 的翻譯質量:48 層的模型比 12 層的模型平均獲得 3.2 點的提高。 DeepNet 可以成功地將深度擴展到 1,000 層,比基線提高4.4 BLEU。值得注意的是,DeepNet 只訓練了 4 個 epoch,并且在計算預算更多的情況下,性能可以進一步提高。

深度擴展規律:該研究在OPUS100數據集上訓練具有{12,20,100,200,1000}層的DeepNet,圖8顯示了深度擴展曲線。與雙語NMT相比,多語NMT從擴展模型深度受益更多。可以觀察到多語 NMT 的 BLEU 值呈對數增長,規律可以寫成:L(d) = A log(d) + B,其中d是深度,A, B是關于其他超參數的常數。

更多數據和語言說明:為了探索DeepNet在多語NMT上的局限性,該研究隨后使用Schwenk等人提出的CCMatrix擴展訓練數據。此外,該研究還擴展了CCAligned 、OPUS 和Tatoeba的數據,以涵蓋Flores101評估集的所有語言。最終的數據由102種語言、1932個方向和12B對句子組成。利用這些數據,該研究用100層編碼器、100層解碼器、1024個隱藏維度、16個頭、4096個前饋層中間維度對DeepNet進行訓練。

該研究將 DeepNet 與SOTA多語 NMT 模型 M2M-100進行了比較。M2M-100 有一個 24 層的編碼器、一個 24 層的解碼器和 4,096 個隱藏大小,從而產生高達 12B 的參數。與M2M-100相比,DeepNet深而窄,參數只有3.2B。

在 M2M-100 之后,該研究在幾個多語言翻譯評估數據集上評估模型,包括 WMT、OPUS 、TED、 Flores。WMT的語言對是以英語為中心的。包括英語在內的10種語言,其中大部分是高資源語言。對于 OPUS 數據集,該研究從包含 30 個評估對的測試集中選擇非英語方向。TED評估集有28種語言和756個方向,數據來自口語領域。 Flores 數據集包含 102 種語言之間的所有翻譯對。該研究使用涵蓋 M2M-100 和 DeepNet 支持的語言的子集,產生 87 種語言和 7,482 個翻譯方向。

表 3 報告了結果,為了公平比較,該研究使用與基線相同的評估方法。結果表明 DeepNet 在所有評估數據集上的性能都明顯優于 M2M-100,表明深化模型是提高 NMT 模型質量的一個非常有前景的方向。

感興趣的讀者可閱讀論文原文,了解更多細節內容。