LeCun用62頁論文公布未來十年研究計劃:AI自主智能

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

這段時間,關于“AI未來往哪走的”討論,可以說是越來越激烈了。

先是Meta被曝AI相關部門大重組,又有谷歌AI是否具備人格大討論,幾乎每一次討論都能看到Yann LeCun的身影。

現在,LeCun終于坐不住了。

他用一篇長達62頁的最新論文,詳細介紹了他未來十年要做什么樣的AI研究:

自主機器智能(Autonomous Machine Intelligence)。

LeCun表示,在大數從業者都不會提前將自己的研究內容公布出來的“學術風氣”下,他這一舉動可以說是很特別了。

究其原因,除了發揚開放的科學研究精神,也是為了號召更多人一起加入其中,一起研究。

那么,他說的這個自主人工智能,究竟是什么,又要如何開展?

可以模擬世界運作的AI

在論文中,LeCun先是舉了一個例子:

一個年輕人可以最快在20小時內就學會開車;

一個當今世界最優秀的自動駕駛系統,卻要用到數百萬甚至數十億條帶標簽的訓練數據,并在虛擬環境中進行數百萬次強化學習才能得出——還完全達不到人類的水平。

從這個例子我們可以得出,盡管我們在人工智能方面的研究取得了不少進展,但離創造出一個能真正像人類一樣思考和學習的AI還差得遠。

LeCun所提出的自主人工智能就是要解決這個問題。

在他看來,對“世界模型”(世界如何運作的內部模型)進行學習的能力可能是關鍵。

眾所周知,人類和其他動物總是能通過觀察和少量互動,就能以無監督的方式學習到大量關于世間萬物如何運轉的背景知識。

這些知識就是我們所說的常識,而常識就是構成“世界模型”的基礎。

有了常識,我們在不熟悉的場景下也能開展行動。比如開頭那位從來沒有開過車的年輕人,碰到雪地,不用教也知道這樣的路很滑得慢慢開。

此外,常識還可以幫我們填補信息在時間和空間上的缺失。比如一名司機聽到了金屬等物質的碰撞聲,即使沒有看到現場,也能知道那可能是有車禍發生。

在這些概念之上,LeCun提出了構建自主人工智能的第一個挑戰:

如何設計一個學習范式和體系架構,讓機器能夠以自監督學習(也就是不需要標注數據)的方式學習“世界模型”,然后用這個模型去進行預測、推理和行動。

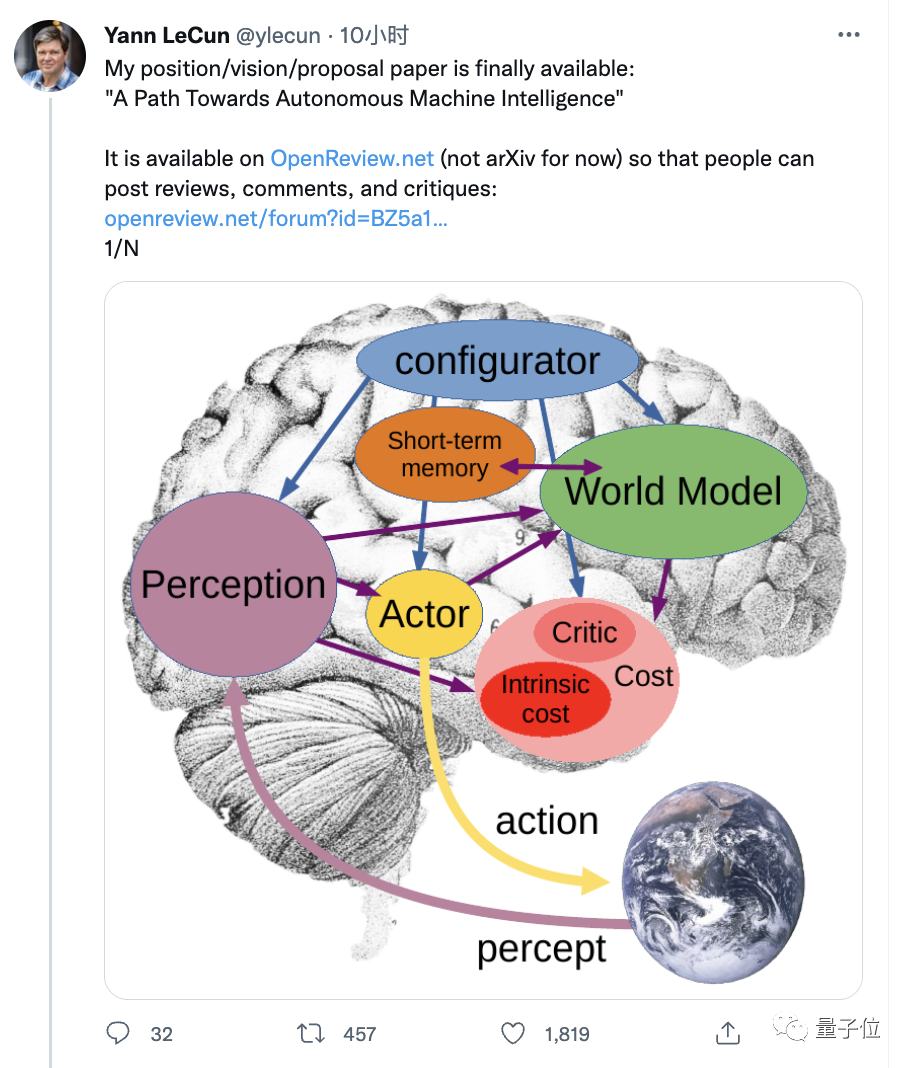

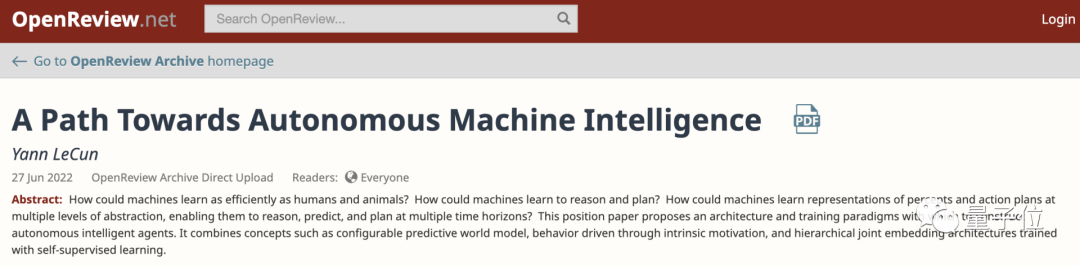

在這里,他重新組合了認知科學、系統神經科學、最優控制、強化學習和“傳統”人工智能等各個學科中提出的想法,并將它們與機器學習中的新概念相結合,提出了一個由六個獨立模塊組成的自主智能架構。

其中,每個模塊都是可微的,每一個都可以很容易地計算某個目標函數相對于自己的輸入的梯度估計,并將梯度信息傳播到上游模塊。

六模塊自主智能架構

LeCun設想的六個模塊分別為:

1、配置模塊:負責執行控制。給定要執行的任務,它可以通過調節其他模塊的參數,為任務預先配置感知模塊、世界模塊等其他三個模塊的值。

2、感知模塊:負責接收來自傳感器的信號并估計世界的當前狀態。

3、世界模型模塊:是這個架構中最復雜的一部分。有兩個作用:

(1)估計感知模塊無法提供的關于世界狀態缺失的信息;

(2)預測未來可能的狀態。由于世界充滿了不確定性,該模塊必須能夠涵蓋出多種可能的預測。

4、成本模塊:用來計算標量(scalar)的輸出,它可以預測智能體的不適程度(discomfort of the agent,智能體受到的損害、違反硬編碼的行為約束等)。

該模塊又有兩個子模塊:

(1)內在成本模塊(cost),用來即時計算“不適感”;

(2)評判家(critic):預測內在成本模塊的未來值。

5、行動模塊:用來計算要實現的動作序列。行動模塊可以找到一個使未來成本模塊最小化的最優動作序列,并以類似于經典最優控制的方式,以最優序列輸出第一個動作。

6、短期內存模塊:跟蹤當前和預測的世界狀態以及相關成本。

其中,對于這個架構的核心——世界模塊,最關鍵的挑戰是如何使其能夠表示出多個合理的預測。

此外,它在學習世界的抽象表示時,還要學會忽略不相關的信息,只保留最有用的細節。

比如在開車時,只需要預測駕駛員周圍的汽車會做什么,不需要預測道路兩旁樹木中每片葉子的詳細位置。

對此,LeCun也給了一個可能的解決方案:

聯合嵌入預測架構 (JEPA),用它來處理預測中的不確定性。

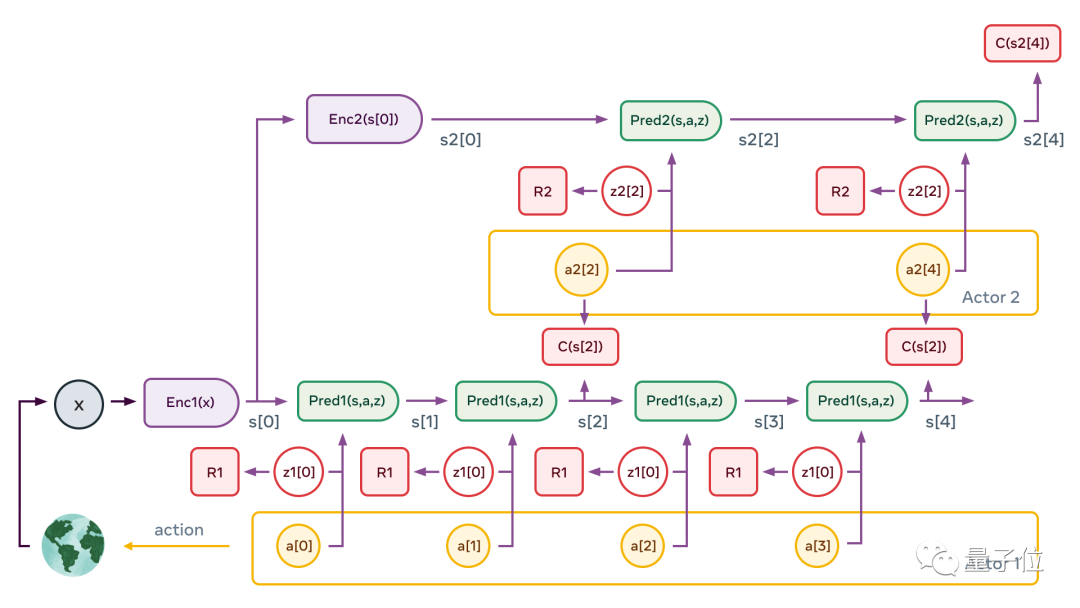

同時,他還提出用非對比自監督學習對JEPA進行訓練,以及從不同時間尺度上進行預測的分級JEPA,它可以將復雜任務拆解為一系列不那么抽象的子任務。

AI待解決的問題還有很多

LeCun表示,對于未來幾十年來說,訓練出來這樣一個世界模型是人工智能要取得突破性進展必須面對的最大挑戰。

目前來看,要想實現上面這個架構,還有很多方面都有待定義:比如如何精確地訓練critic、如何構造和訓練配置器、以及如何使用短期內存跟蹤世界狀態,并存儲世界狀態、動作和相關內在成本的歷史來調整critic……

除此之外,LeCun也在論文中指出,對于未來的自主人工智能研究:

(1)擴大模型規模有必要,但不夠;

(2)獎勵機制也不夠,基于觀察的自監督學習才是更有效的方式;

(3)推理(reason)和計劃(plan)實質上都歸結于推斷(inference):找到一系列動作和潛在變量,以最小化(可微)目標。這也是使推理與基于梯度的學習能夠兼容的辦法。

(4)在以上這種情況下,可能就不需要明確的符號操作機制了。

更多細節可以查看論文原文:

https://openreview.net/forum?id=BZ5a1r-kVsf