LeCun論文被指「洗稿」? LSTM之父發文怒懟:抄我的還標原創

?圖靈獎得主Yann Lecun,作為AI界的三巨頭之一,他發表的論文自然是被人當成「圣經」來學習的。

然而,最近突然有一個人跳出來炮轟LeCun「炒冷飯」:「無非就是把我的核心觀點換種說法罷了」。

莫非……

沒錯,此人正是「LSTM之父」Jürgen Schmidhuber。

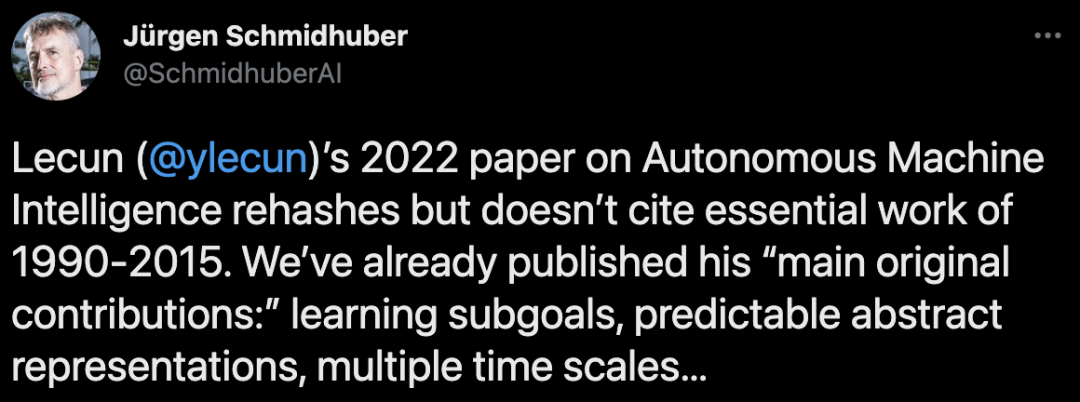

Schmidhuber表示,LeCun的這篇論文并未提及1990-2015年期間的重要成果,文中所提及的「主要原創成果」,包括「學習子目標、可預測的抽象表征、多個時間尺度」等概念,他們也已經發表過了。

原推中用的rehash這個詞,也就是把原先的idea用另一種方式表達而不做創新,妥妥的「洗稿」了。

同時,他還發長文詳細地列出了證據。當然,這只能算是Schmidhuber的一面之詞罷了。

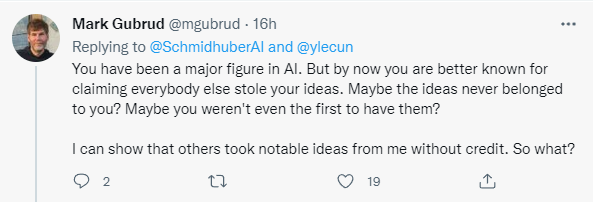

不過,網友們顯然并不買賬。

「你過去是AI界的一位重量級人物,但現在你出名的地方在聲稱每個人的學術成果都是剽竊了你的觀點」。

「神經網絡、transformers、LSTMS是你發明的,那廁紙和面包片是不是也是你們家發明的」。

所以,到底是個啥事?

讓我們先捋一捋事情的來龍去脈。

2022年6月14日,被Schmidhuber稱作Science Tabloid的一家「科學小報」(說的就是你MIT科技評論)發表了一篇LeCun的報告,其中闡述了他對AGI的新構想。

6月27日,Yann LeCun發表了自己積蓄幾年的論文「A Path Towards Autonomous Machine Intelligence」,并稱其為「指明AI未來發展方向之作」。

這篇論文系統講述了關于「機器如何能像動物和人類一樣學習」的問題,長達60多頁,感興趣的朋友可以去看看。

LeCun表示,此文不僅是自己關于未來5-10年內關于AI發展大方向的思考,也是自己未來幾年打算研究的內容,并希望能夠啟發AI界的更多人來一起研究。

大概是看LeCun這篇論文的影響越來越大,Schmidhuber終于決定在7月7日,放出自己寫的長文,怒斥Lecun抄襲他的idea。

Schmidhuber稱,在文章還沒公開發表之前,那家「科學小報」發來一份報告的草稿(還在保密期),并希望他能對此發表一些評論。

于是,Schmidhuber便洋洋灑灑地寫了一篇「控告」,表示LeCun的文章基本上就是自己以前工作的翻版,而且還沒有引用。

不出意料,他的評論石沉大海了。

LeCun只是重提我的工作,而且還沒標引用!

Schmidhuber在這篇長文中表示,希望讀者能研究原始論文,自己判斷這些評論的科學內容,并且還希望自己的工作得到承認和認可。

LeCun論文開頭部分說,本文描述的許多觀點(幾乎都是)由許多作者在不同的背景下以不同的形式提出,Schmidhuber則反駁稱不幸的是,這篇論文的大部分內容就和我們1990年以來的論文「似曾相識」,且沒有任何引用的標識。

先來看看他這次炮轟LeCun的證據(部分)。

證據1:

LeCun:今天的人工智能研究必須解決三個主要挑戰:(1)機器如何能學會代表世界,學會預測,并學會主要通過觀察來采取行動(2)機器如何以與基于梯度的學習兼容的方式進行推理和計劃(3)機器如何以分層的方式,在多個抽象層次和多個時間尺度上學習表征感知(3a)和行動計劃(3b)

Schmidhuber:這些問題在1990年、1991年、1997年和2015年發表的一系列論文中得到了詳細解決。

1990年,第一篇關于基于梯度的人工神經網絡(NN)用于長期規劃和強化學習(RL)以及通過人工好奇心進行探索的工作發表。

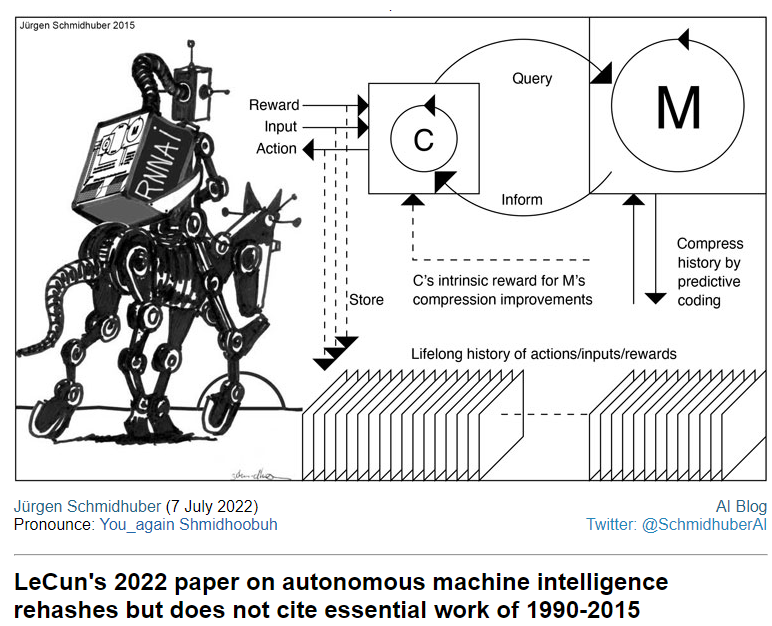

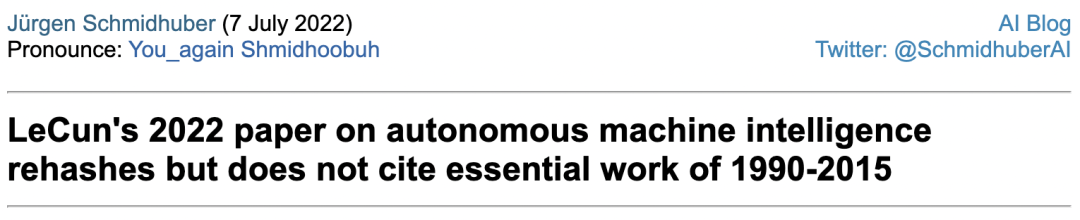

它描述了兩個遞歸神經網絡(RNN,最強大的NNN)的組合,稱為控制器和世界模型。

其中,世界模型學習預測控制器行動的后果,控制器可以利用世界模型提前規劃幾個時間步驟,選擇使預測獎勵最大化的行動序列。

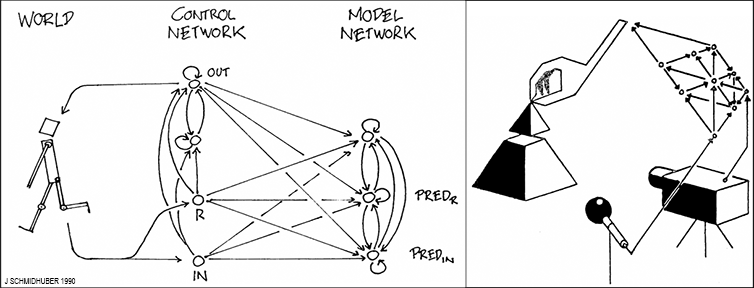

關于基于神經網絡的分層感知(3a)的答案,這個問題至少部分由我 1991年發表的「第一臺深度學習機器—神經序列分塊器」解決。

它在遞歸神經網絡 (RNN) 的深層層次結構中使用無監督學習和預測編碼,以在多個抽象級別和多個時間尺度(正是 LeCun 所寫的內容)上找到「長數據序列的內部表征」。

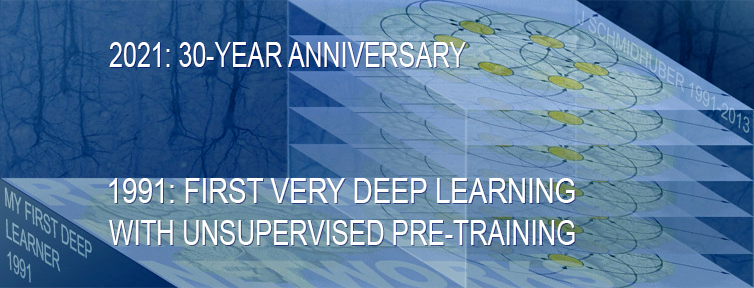

關于基于神經網絡的分層行動計劃(3b)的答案,已在 1990 年通過我的分層強化學習 (HRL)這篇論文至少部分解決了這個問題。

證據2:

LeCun :由于成本模塊的兩個子模塊都是可微的,所以能量梯度可以通過其他模塊反向傳播,特別是世界模塊、表演模塊和感知模塊。

Schmidhuber:這正是我在 1990 年發表的內容,引用了 1980 年發表的「具有前饋神經網絡的系統識別」論文。

2000年,我的前博士后 Marcus Hutter 甚至發表了用于學習世界模型和控制器的理論上最優、通用、不可微的方法。(另請參考稱為哥德爾機的數學上最優的自我參照 AGI)

證據3:

LeCun :短期記憶模塊架構可能類似于鍵值記憶網絡。

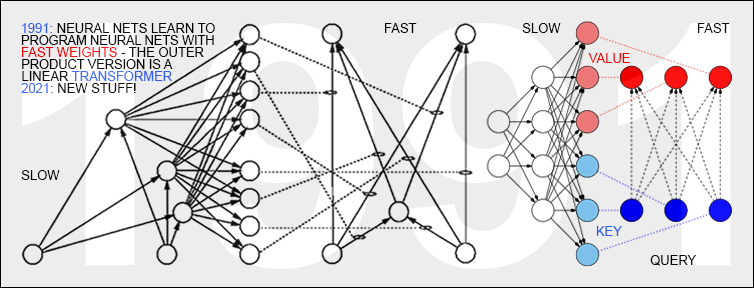

Schmidhuber:然而,他沒有提到我在 1991 年發表了第一個這樣的「鍵值記憶網絡」,當時我描述了序列處理「Fast Weight Controllers」或 Fast Weight Programmers (FWPs)。FWP 擁有一個慢速的神經網絡,它通過反向傳播學習以快速修改另一個神經網絡的快速權重。

證據4:

LeCun:這篇論文的主要原創貢獻在于:(I)一個整體認知架構,其中所有模塊都是可區分的,其中許多模塊是可訓練的。(II)H-JEPA:預測世界的非生成層次架構在多個抽象級別和多個時間尺度上學習表示的模型。(III)一系列非對比自我監督學習范式,產生同時提供信息和可預測的表示。(IV)使用 H-JEPA 作為不確定性下分層規劃的預測世界模型的基礎。

對此,Schmidhuber也按照LeCun列出的這四個模塊一一校對,并給出了與他論文中有重合的點。

文章最后,他表示這篇文章的重點不是攻擊發表的論文或是其作者所反映的想法,關鍵是這些想法并不像LeCun 的論文中寫的那樣「原創」。

他說,這些觀點的提出中許多都有著我和我的同事的努力,LeCun現在所提出的他的「Main original contribution」其實與我幾十年來研究的貢獻密不可分,我希望讀者自己判斷我的評論的有效性。

從LSTM之父到……

其實,這位大爺聲稱別人抄襲他的成果也不是第一回了。

早在去年9月,他就在博客上發文表示,現在引用最多的神經網絡論文成果,都是建立在我實驗室完成的工作之上的:

「LSTM不用說了,其他還有今天鼎鼎大名的開創性工作比如ResNet,比如AlexNet、GAN、Transformer,都和我的工作有關系。有些工作的第一版就是我做出來的,但是現在這些人不講武德,引用不規范,搞得這些成果現在的歸屬認知有問題。」雖然大爺氣性很大,但不得不說Jürgen Schmidhuber這么多年來確實有些意難平。同為AI領域的前輩級人物,開創性成果沒少做,但獲得的聲譽和認可度似乎總與期望值有很大差距。

尤其是在2018年,深度學習三巨頭:Yoshua Bengio、Geoffrey Hinton、Yann LeCun榮獲圖靈獎時,就有不少的網友發出了質疑:圖靈獎為什么沒頒給LSTM之父Jürgen Schmidhuber?他也是深度學習領域的大家啊。

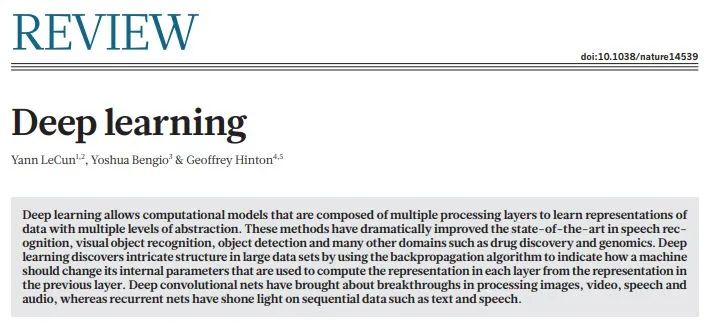

時間回到2015年,當時Bengio、Hinton和LeCun三位大神聯手在Nature上發了一篇review,題目直接就叫《Deep Learning》。

文章從傳統的機器學習技術講起,總結了現代機器學習的主要架構和方法,描述了訓練多層網絡架構的反向傳播算法,以及卷積神經網絡的誕生,分布式表示和語言處理,以及遞歸神經網絡及其應用等等。

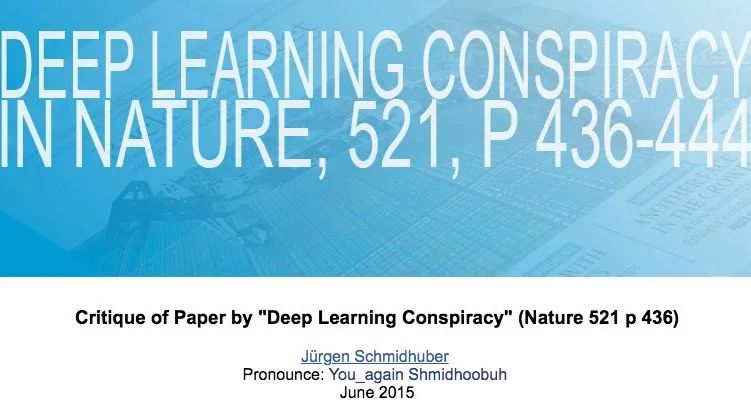

不到一個月后,Schmidhuber就在自己的博客上發文進行了批評。

Schmidhuber表示,這篇文章讓他非常不爽,因為全文多次引用三位作者自己的研究成果,而對于其他先驅人物對深度學習更早的貢獻則只字不提。

他認為,獲得圖靈獎的「深度學習三巨頭」儼然成了貪他人之功,以為己利的雞賊、借助江湖地位互相吹捧,壓制老前輩的學閥。

2016年,Jürgen Schmidhuber又在NIPS大會的Tutorial上和「GAN之父」Ian Goodfellow正面交鋒。

當時,Goodfellow正講到GAN與其他模型相比較時,Schmidhuber便站出來提問打斷。

Schmidhuber的問題很長,大概說了兩分鐘,主要內容是強調說自己在1992年就已經提出來PM,接著說了一大堆它的原理、實現過程等等,最后圖窮匕見:你說說你的GAN和我的PM有沒有相似之處?

Goodfellow也不示弱:你說的問題我們之前在郵件里已經交流過很多次了,我也早就公開回應過你了,不想在現在的場合浪費聽眾的耐心。

等等,等等……

或許Schmidhuber的這些「蜜汁操作」,可以用LeCun曾經的一封郵件來解釋:

「Jürgen 對眾人的認可過于癡迷,總是說自己沒有得到應得的很多東西。幾乎是慣性地,他總是在別人每次講話結束時都要站起來,說剛剛提出的成果有他的功勞,大體上看,這種行為并不合理。」?