LSTM之父再次約戰LeCun:你那5點「創新」都是抄我的!卻慘遭「已讀不回」

最近,LSTM之父Jürgen Schmidhuber一言不合又跟LeCun干上了!

其實之前稍微熟悉這位暴脾氣大爺的同學都知道,特立獨行的Jürgen Schmidhuber和機器學習社區的幾位大佬級人物之間都有過不愉快。

尤其是當「那三個人」一起拿了個圖靈獎,而Schmidhuber卻沒有之后,這位老爺子就更氣了……

說到底Schmidhuber一直認為,現在這幾個ML領軍人物,什么Bengio、Hinton、LeCun,包括「GAN」之父Goodfellow等人,他們的很多所謂「開創性成果」都是自己先提出來的,而這些人在論文中根本就沒提過他。

為此,Schmidhuber曾經專門撰文把Bengio、Hinton、LeCun于2015年發在Nature上的綜述性文章「Deep Learning」一文拿出來批判過一番。

主要是說這篇文章里的成果,哪些東西是他先提的,哪些東西是別的前輩先提的,反正不是這仨作者先提的。

怎么又吵起來了?

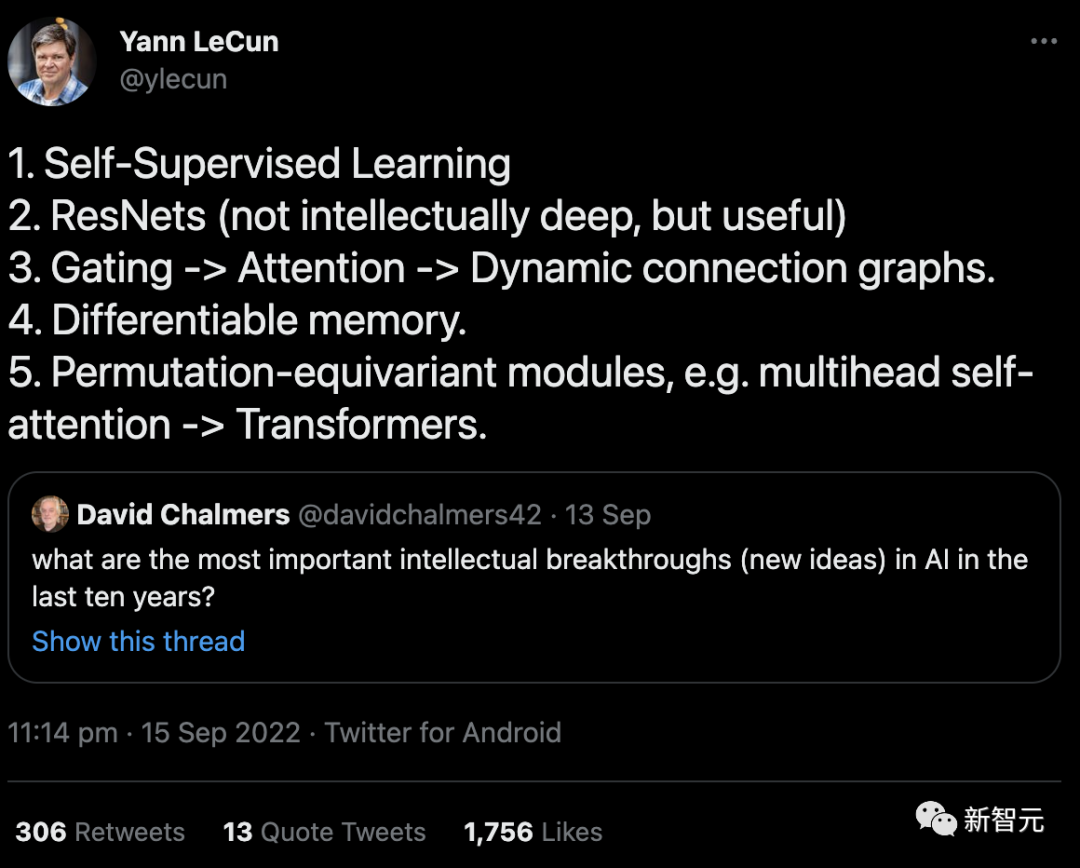

回到這次事件起因,實際上是LeCun在9月份發的一條推文。

內容是對David Chalmers教授提問的回答:「在過去十年中,AI最重要的智力突破(新想法)是什么?」

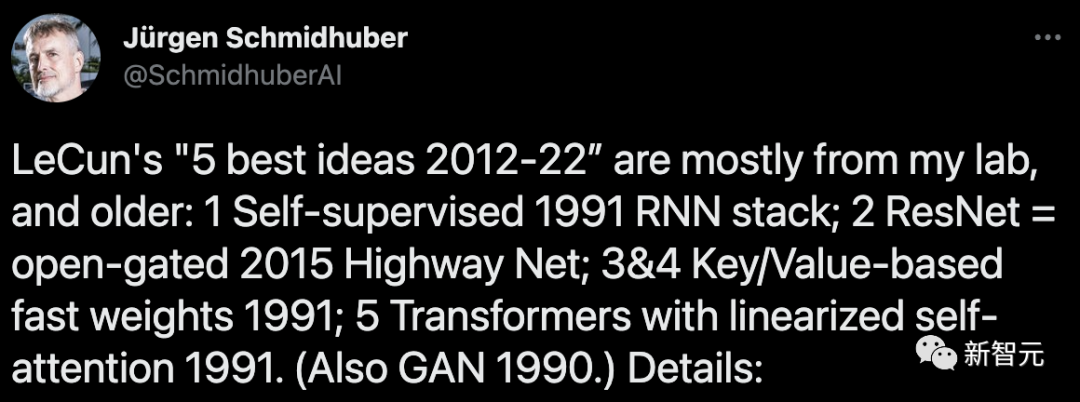

10月4日,Schmidhuber在他的博客上撰文怒斥:這5個「best idea」大部分都來自于我的實驗室,而且提出的時間要遠遠早于「10年」這個時間節點。

文中Schmidhuber詳細列舉了六大證據來支撐自己的論述。

但估計是因為看到的人太少,Schmidhuber又在11月22日發推,重新把這個「冷飯」炒了一遍。

然而,相比于上一次還算激烈的爭辯,這回LeCun連理都沒理……

LSTM之父擺出「六大證據」

1. 通過神經網絡(NN)自動生成標注的「自監督學習」:至少可以追溯到我1990-91年的工作。

(I) 通過預測編碼在一個循環神經網絡(RNN)中進行自監督的目標生成,來學習在多個時間尺度和抽象層次上壓縮數據序列。

在這里,一個「自動機」RNN學會了「預測下一個輸入」的前置任務,并將傳入數據流中的意外觀察作為目標發送給「分塊機」RNN,后者學習更高層次的規律性,隨后通過適當的訓練目標將其獲得的預測知識提煉回自動機中。

這大大促進了以前無法解決的序列分類的下游深度學習任務。

(II) 通過GAN類型的內在動機進行自監督的標注生成,其中一個世界模型NN學習預測對抗性的、標注生成的、實驗發明的控制器NN的行為后果。

此外,我于1990年發表的論文標題中,就已經出現了「自監督」的說法。

但是吧,在更早期(1978年)的論文中,也用到了這個詞……

2. 「ResNets」:實際上就是我早期提出的Highway Nets。但LeCun卻認為ResNets的智力「不深」,這讓我非常傷心。

在我提出Highway Nets之前,前饋網絡最多只有幾十層(20-30層),而Highway Nets是第一個真正的深度前饋神經網絡,有數百層。

在1990年代,我的LSTM給有監督的遞歸NN帶來了基本無限的深度。在2000年代,LSTM啟發的Highway Nets給前饋NN帶來了深度。

由此帶來的是,LSTM已經成為20世紀被引用最多的NN,而Highway Nets(ResNet)是21世紀被引用最多的NN。

可以說,它們代表了深度學習的精髓,而深度學習就是關于NN的深度。

3. 「門控->注意力->動態連通圖」:至少可以追溯到我的Fast Weight Programmers和1991-93年的Key-Value Memory Networks(其中的「Key-Value」被稱為「FROM-TO」)。

1993年,我引入了現在使用的術語「注意力」。

不過值得注意的是,NN中的第一個乘法門可以追溯到1965年Ivakhnenko & Lapa的深度學習機。

4. 「Differentiable memory」:同樣可以追溯到我的Fast Weight Programmers或1991年的Key-Value Memory Networks。

像傳統計算機中那樣分離存儲和控制,但以端到端差分、自適應、完全神經的方式(而不是以混合方式)。

5. 「置換等變模塊,例如多頭自注意力->Transformer」:我在1991年發表了帶有線性化自注意的Transformer。相應的「注意力」術語(internal spotlights of attention)可以追溯到1993年。

6. 「GAN是過去10年中最好的機器學習理念」?

你提到的這個GAN(2014年)的原理,實際上是我在1990年以人工智能好奇心的名義提出的。

上一次,還是在幾個月之前

其實這已經不是Schmidhuber和LeCun之間今年第一次發生爭執了。

在六七月間,兩人就關于LeCun發表的一篇「自主機器智能未來方向」的展望報告有來有回地吵了一番。

6月27日,Yann LeCun發表了自己積蓄幾年的論文「A Path Towards Autonomous Machine Intelligence」,并稱其為「指明AI未來發展方向之作」。

這篇論文系統講述了關于「機器如何能像動物和人類一樣學習」的問題,長達60多頁。

LeCun表示,此文不僅是自己關于未來5-10年內關于AI發展大方向的思考,也是自己未來幾年打算研究的內容,并希望能夠啟發AI界的更多人來一起研究。

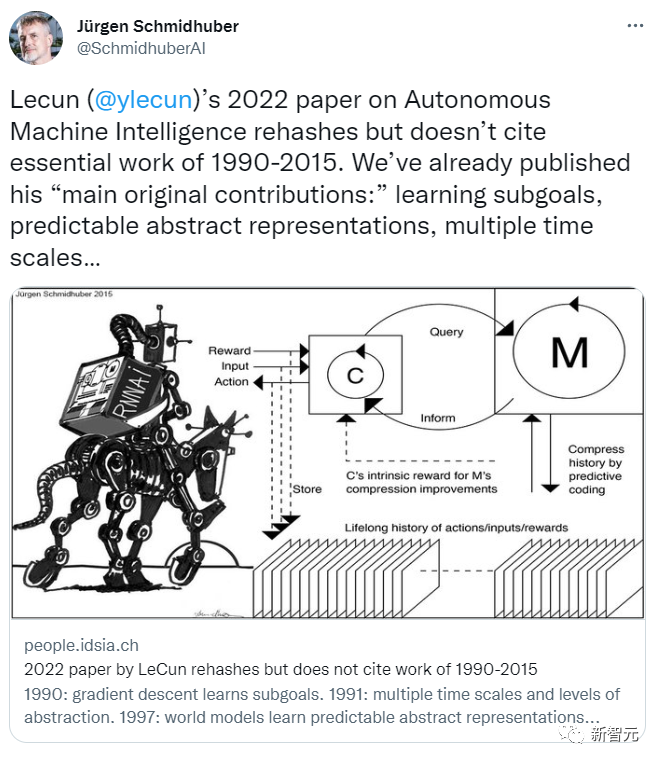

而Schmidhuber大概提前十幾天就得知這個消息,并拿到了這篇論文,當即就寫了一篇文章反駁。

按照Schmidhuber自己在博客上文章的說法,當時事情是這樣的:

2022年6月14日,一家科學媒體發布消息,說LeCun在6月27日要發布一篇報告,給我發了一份報告的草稿(當時還在保密期),并要求我發表評論。

我寫了一篇評論,告訴他們這基本上是我們以前工作的翻版,而LeCun的文章中并沒有提到。

然而,我的意見被置若罔聞。

實際上,早在他這篇東西發表以前,我們就提出了LeCun在這篇文中所謂的「主要原創貢獻」的大部分內容,主要有:

(1) 「認知架構,其中所有模塊都是可分的,而且許多模塊是可訓練的」(我們在1990年提出)。

(2) 「預測世界模型的分層結構,在多個抽象層次和多個時間尺度上學習表征」 (我們在1991年提出)。

(3) 「自我監督的學習范式,產生同時具有信息性和可預測性的表征」(我們的模型自1997年起就用于強化學習和世界建模了)

(4) 「用于不確定性下的分層規劃」的預測模型,包括基于梯度的神經子目標生成器(1990年)、抽象概念空間的推理(1997年)、「主要通過觀察學習行動」的神經網絡(2015年),以及學習思考(2015年),都是我們先提出的。

7月14日,Yann LeCun回應,說討論要有建設性,他是這么說的:

我不想陷入一場關于「某個概念是誰發明的」這種無謂爭論中,也不想在你的回應文章中列出的160個參考文獻中深究。我認為更有建設性的做法是,指出你認為可能包含我列出的4項貢獻中的觀點和方法的4篇出版物。

正如我在論文的開頭所說,有許多概念已經存在了很長時間,你和我都不是這些概念的發明人:比如,可微調世界模型的概念,可以追溯到早期的優化控制工作。

訓練世界模型利用神經網絡學習世界模型的系統識別,這個想法可以追溯到80年代末,由Michael Jordan, Bernie Widrow, Robinson & Fallside, Kumpathi Narendra, Paul Werbos進行的工作,都比你的工作早。

在我看來,這個稻草人式的回答似乎是LeCun在轉移話題,對他的所謂「主要原創貢獻」中貪他人之功的問題避而不談。

我在7月14日回復:

關于你說的「你我都沒有發明的東西」:你的論文聲稱,用神經網絡進行系統識別可以追溯到20世紀90年代初。然而,在你的之前的回應中,你似乎同意我的觀點:這方面的第一篇論文出現在1980年代。

至于你的「主要原創貢獻」,實際上都用了我早年間的工作成果。

(一) 關于你提出的「認知架構,其中所有模塊都是可分化的,且許多模塊都是可訓練的」,「通過內在動機驅動行為」:?

我在1990年就提出了用于在線學習和規劃的可分化架構,這是第一個具有 「內在動機」的控制器,用以改善世界模型,它既是生成性的,也是對抗性的;你文中引用的2014年的GAN是這個模型的一個衍生版本。

(二)關于你提出的 「在多個抽象層次和時間尺度上學習表征的預測性世界模型的分層結構」:?

這是由我1991年的神經歷史壓縮機實現的。它使用預測編碼,以自監督的方式學習長序列數據的分層內部表征,大大促進了下游的學習。使用我1991年的神經網絡提煉程序,這些表征可以被折疊成一個單一的循環神經網絡(RNN)。

(三)關于你在控制方面的「自監督學習范式,產生同時具有信息性和可預測性的表征」:?

這一點我在1997年提出構建的系統中已經提出。它不是預測未來輸入的所有細節,而是可以提出任意的抽象問題,并在你所說的「表征空間」中給出可計算的答案。在這個系統中,兩個名為「左腦」和「右腦」的學習模型,選擇獎勵最大化的對手進行零和博弈,偶爾還會在這種計算實驗的結果上打賭。

(四)關于你的可用于不確定情況下的分層規劃預測性可微分模型,你的文章里是這么寫的:?

「一個尚未回答的問題是,配置器如何學習將一個復雜的任務分解為一連串可以由智能體單獨完成的子目標。我將把這個問題留給未來的調查。」

就別說什么未來了,實際上我在30多年前就發表過這樣的文章:

一個控制器神經網絡負責獲得額外的命令輸入,其形式為(開始,目標)。一個評估器神經網絡負責學習預測從開始到目標的預期成本。一個基于可微調循環神經網絡的子目標生成器看到了這個(開始,目標)的輸入,并使用評估器神經網絡,通過梯度下降學習一系列成本最小的中間子目標。

(五)你還強調了 「主要通過觀察來學習行為」的神經網絡。實際上我們很早就解決了這個問題,比2015年這篇文章,討論了部分可觀察環境中強化學習(RL)的一般問題。

世界模型M可能擅長預測一些事情,但對其他事情不確定。控制器C通過學習通過自我發明的問題序列(激活模式)來查詢并解釋答案(更多的激活模式)來最大化其目標函數。

C可以從學習從M中提取任何類型的算法信息中獲益,比如用于分層規劃和推理,利用M中編碼的被動觀察等等。