七月超受歡迎的AI研究榜單出爐,馬毅最新「標準模型」排名第九

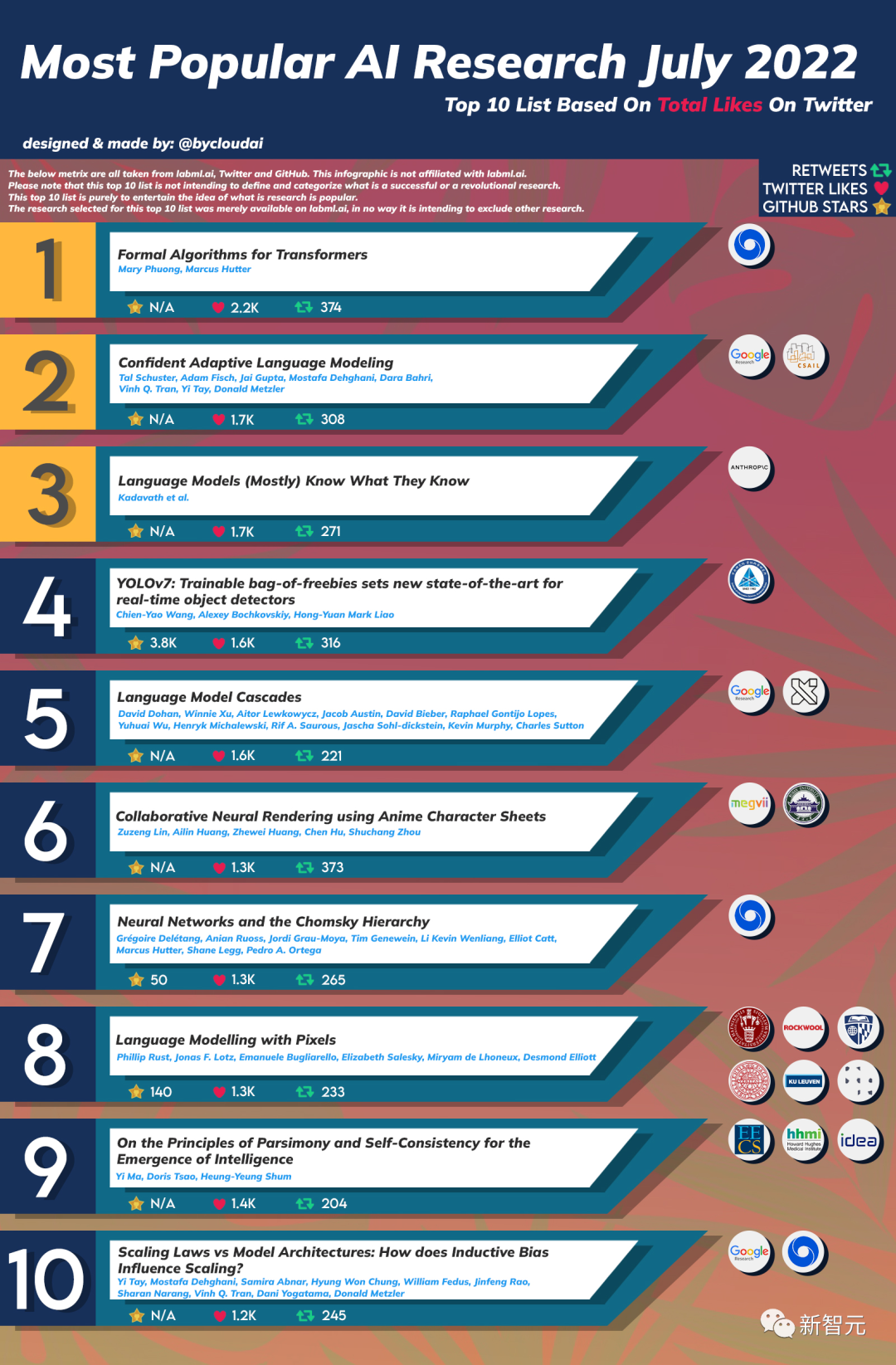

七月最受歡迎的AI研究榜單出爐啦!

這份由Reddit網友@bycloudai整理的榜單,根據推特點贊、轉發和Github星數排序,列入了2022年七月排名前十的AI研究,其中包括DeepMind、Google、MIT CSAIL等知名機構。

下面一起來看看上榜的都是何方大佬~

TOP1: Formal Algorithms for Transformers

作者:Mary Phuong,Marcus Hutter

機構:DeepMind

摘要:本文旨在成為一個獨立的、數學上精確的Transformer架構和算法概述。它涵蓋了Transformer是什么、它們是如何訓練的、它們的用途、它們的關鍵架構組件以及最突出的模型的預覽。

Top2:Confident Adaptive Language Modeling

作者:Tal Schuster, Adam Fisch, Jai Gupta, Mostafa Dehghani, Dara Bahri, Vinh Q Tran, Yi Tay, Donald Metzler

機構:谷歌,MIT CSAIL

摘要:基于Transformer 的大型語言模型 (LLM) 的最新進展已推動許多任務的性能顯著提高。然而性能提升的同時模型的大小也在急劇增加,這可能導致推理過程復雜以及成本增加。然而在實踐中,大型語言模型產生的一系列迭代是由不同程度的難度組成的。

在這項工作中,我們介紹了 Confident Adaptive Language Model-ing (CALM),這是一個動態分配不同數量的計算機輸入和生成時長的框架。

早期退出解碼涉及我們在這里解決的幾個問題,例如:(1)使用什么置信度度量;(2) 將序列級約束與本地token的退出決策聯系起來;(3) 回溯由于先前token提前退出而丟失的隱藏表示。通過對三種不同文本生成任務的理論分析和實驗,我們證明了我們的框架在減少計算方面的功效——潛在加速高達3倍,同時可保持高性能。

Top3:Language Models (Mostly) Know What They Know

作者:Saurav Kadavath, Tom Conerly, Amanda Askell, Tom Henighan等

機構:Anthropic

摘要:本文研究了語言模型是否可以評估自己主張的有效性并預測他們將能夠正確回答哪些問題。我們首先表明,當以正確的格式提供較大的模型時,它們可以很好地針對各種多項選擇和真/假問題進行校準。因此,我們可以通過要求模型首先提出答案,然后評估其答案正確的概率P(True)來對開放式抽樣任務進行自我評估。

我們發現 P(True) 在各種任務中的性能、校準和縮放都令人興奮。當我們允許模型在預測一種特定可能性的有效性之前考慮許多自己的樣本時,自我評估的性能會進一步提高。接下來,我們研究是否可以訓練模型來預測P(IK),即「我知道問題的答案」的概率,而不參考任何特定的建議答案。

Top4:YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time objectdetectors

作者:Chien-Yao Wang, Alexey Bochkovskiy, Hong-Yuan Mark Liao

機構:Institute of Information Science, Academia Sinica

Top5:Language Model Cascades

作者:David Dohan, Winnie Xu, Aitor Lewkowycz等

機構:谷歌

Top6:Collaborative Neural Rendering using AnimeCharacter Sheets

作者:Zuzeng Lin, Ailin Huang, Zhewei Huang等

機構:武漢大學,曠視科技

Top7:Neural Networks and the Chomsky Hierarchy

作者:Grégoire Delétang, Anian Ruoss, Jordi Grau-Moya, Tim Genewein等

機構:DeepMind

Top8:Language modelling with Pixels?

Top8:Language modelling with Pixels?

作者:Phillip Rust, Jonas F. Lotz, Emanuele Bugliarello等

機構:哥本哈根大學,約翰霍普金斯大學,烏普薩拉大學

Top9: On the Principles of Parsimony and Self-Consistencyfor the Emergence of Intelligence

作者:馬毅,曹穎,沈向洋

機構:加利福尼亞大學伯克利分校,粵港澳大灣區數字經濟研究院

這篇論文是馬毅教授聯手計算機科學家沈向洋博士、神經科學家曹穎教授發表的一篇對人工智能出現及發展的研究綜述,堪稱對近70年來AI發展的提綱挈領之作。

Top10:Scaling Laws vs Model Architectures:How does Inductive Bias Influence Scaling

作者:Yi Tay, Mostafa Dehghani, Samira Abnar

機構:谷歌,DeepMind

看完了Top10的各方大佬的論文,再來說說這次榜單有趣的幾個細節。

眾所周知,推特點贊是可以用機器人刷的,作者用點贊數作為榜單的關鍵指標確實有待商榷。

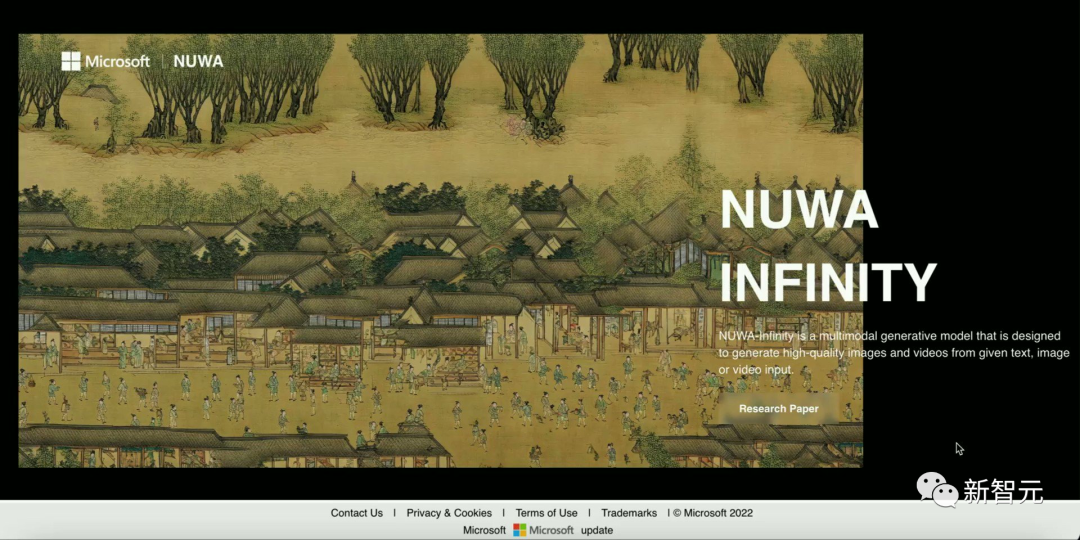

另外,此前呼聲極高的「無限視覺生成模型NUWA-Infinity」在推特點贊數方面只排在第12位,但Github星數已超過2.4k。

由于NUWA Infinity早在2021年11月就發布了首個版本,而本次榜單只計入了之后的第二版的點贊數,因此只排在第12位。