AI論文“高引用轉(zhuǎn)化率”排名出爐:OpenAI第一,曠視第二,谷歌位居第九

為了弄清這個(gè)問(wèn)題,美國(guó)Zeta Alpha平臺(tái)統(tǒng)計(jì)了2020-2022三年之間全世界引用次數(shù)前100的AI論文,得出了一些很有意思的結(jié)果。

比如:

“當(dāng)紅明星”O(jiān)penAI,在論文引用次數(shù)最多的機(jī)構(gòu)中名列第9。

然而,在論文發(fā)表數(shù)量最多的機(jī)構(gòu)榜單上,根本找不到它的名字。

再比如,來(lái)自工業(yè)界的谷歌Meta微軟總是在各項(xiàng)數(shù)據(jù)都名列前茅,然而總的看下來(lái),學(xué)術(shù)界也并沒有落后工業(yè)界。

此外,此前關(guān)于“中國(guó)AI研究的產(chǎn)出數(shù)量和質(zhì)量可能超過(guò)美國(guó)”的觀點(diǎn)在這份報(bào)告中似乎也被破解——

更多以及具體的數(shù)據(jù),我們一個(gè)一個(gè)來(lái)看。

中國(guó)第二,OpenAI、DeepMind質(zhì)量取勝

在具體分析之前,Zeta Alpha先統(tǒng)計(jì)出了2020-2022每年引用次數(shù)最多的論文,它們分別是:

2022年:

1、AlphaFold Protein Structure Database: Massively expanding the structural coverage of protein-sequence space with high-accuracy models

引用次數(shù):1372

機(jī)構(gòu):DeepMind

主題:利用AlphaFold增加蛋白質(zhì)結(jié)構(gòu)數(shù)據(jù)庫(kù)的覆蓋范圍

2、ColabFold: making protein folding accessible to all

引用次數(shù):1162

機(jī)構(gòu):多家合作完成

主題:一種開源且高效的蛋白質(zhì)折疊模型

3、Hierarchical Text-Conditional Image Generation with CLIP Latents

引用次數(shù):718

機(jī)構(gòu):OpenAI

主題:DALL·E 2

4、A ConvNet for the 2020s

引用次數(shù):690

機(jī)構(gòu):Meta和UC伯克利大學(xué)

主題:在Transformer繁榮時(shí)期成功實(shí)現(xiàn)CNN現(xiàn)代化

5、PaLM: Scaling Language Modeling with Pathways

引用次數(shù):452

機(jī)構(gòu):谷歌

主題:谷歌的540B大型語(yǔ)言模型,一個(gè)新的MLOps范式,包含它的實(shí)現(xiàn)過(guò)程

2021年

1、Highly accurate protein structure prediction with AlphaFold

引用次數(shù):8965

機(jī)構(gòu):DeepMind

主題:AlphaFold,利用深度學(xué)習(xí)進(jìn)行蛋白質(zhì)結(jié)構(gòu)預(yù)測(cè)的巨大突破

2、Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

引用次數(shù):4810

機(jī)構(gòu):微軟

主題:ViT的強(qiáng)大變體

3、Learning Transferable Visual Models From Natural Language Supervision

引用次數(shù):3204

機(jī)構(gòu):OpenAI

主題:CLIP

4、On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?

引用次數(shù):1266

機(jī)構(gòu):美國(guó)華盛頓,Black in AI,The Aether

主題:著名的立場(chǎng)論文,對(duì)不斷增長(zhǎng)的語(yǔ)言模型的趨勢(shì)持批評(píng)態(tài)度,強(qiáng)調(diào)了它們的局限性和危險(xiǎn)

5、Emerging Properties in Self-Supervised Vision Transformers

引用次數(shù):1219

機(jī)構(gòu):Meta

主題:DINO,揭示了圖像的自監(jiān)督如何導(dǎo)致Transformers中出現(xiàn)某種原型對(duì)象分割

2020年:

1、An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

引用次數(shù):11914

機(jī)構(gòu):谷歌

主題:第一個(gè)展示普通Transformer如何在計(jì)算機(jī)視覺領(lǐng)域中表現(xiàn)出色的作品

2、Language Models are Few-Shot Learners

引用次數(shù):8070

機(jī)構(gòu):OpenAI

主題:GPT-3

3、YOLOv4: Optimal Speed and Accuracy of Object Detection

引用次數(shù):8014

機(jī)構(gòu):中國(guó)臺(tái)灣“中研院”

主題:YOLOv4

4、Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

引用次數(shù):5906

機(jī)構(gòu):谷歌

主題:對(duì)Transformer的遷移學(xué)習(xí)進(jìn)行了嚴(yán)格的研究,產(chǎn)生了著名的T5

5、Bootstrap your own latent: A new approach to self-supervised Learning

引用次數(shù):2873

機(jī)構(gòu):DeepMind和帝國(guó)理工學(xué)院

主題:表明negative對(duì)于表征學(xué)習(xí)來(lái)說(shuō)不是必需的

想必大家能從中找到不少“熟悉的面孔”。

接著,Zeta Alpha就對(duì)近三年的高引用論文背后的信息進(jìn)行了一番分析。

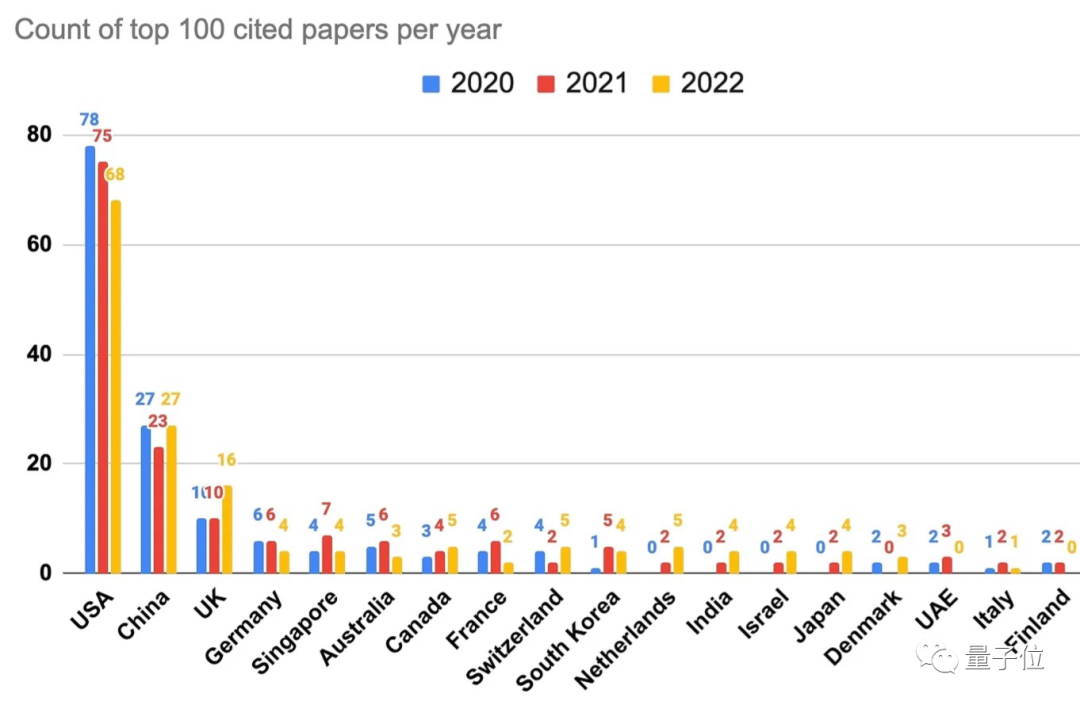

首先是“每年論文引用次數(shù)進(jìn)前100最多”的國(guó)家(地區(qū))。

可以看到美國(guó)強(qiáng)勢(shì)第一,中國(guó)與之的差距比較明顯。

因此Zeta Alpha也認(rèn)為,此前關(guān)于“中國(guó)在AI方面的研究可能超過(guò)美國(guó)”的說(shuō)法至少在這項(xiàng)數(shù)據(jù)上是不成立的。

除此之外,新加坡和澳大利亞的排名也比較出人意料,分別為第五和第六。

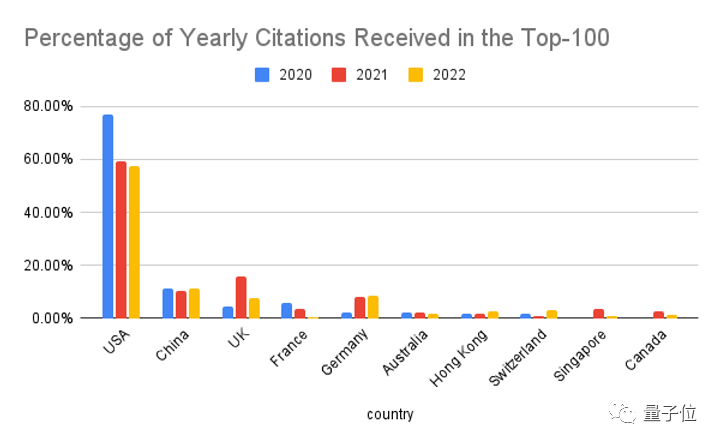

“為了正確評(píng)估美國(guó)的主導(dǎo)地位”,Zeta Alpha又換了一種統(tǒng)計(jì)方式,計(jì)算引用次數(shù)前100的百分比。

當(dāng)然,美國(guó)仍然第一,但可以看到三年間的占比有所下降。

英國(guó)是中美以外最大的競(jìng)爭(zhēng)對(duì)手,不過(guò)英國(guó)表現(xiàn)突出的2022年,其實(shí)主要都是由DeepMind貢獻(xiàn)的(占比69%)。

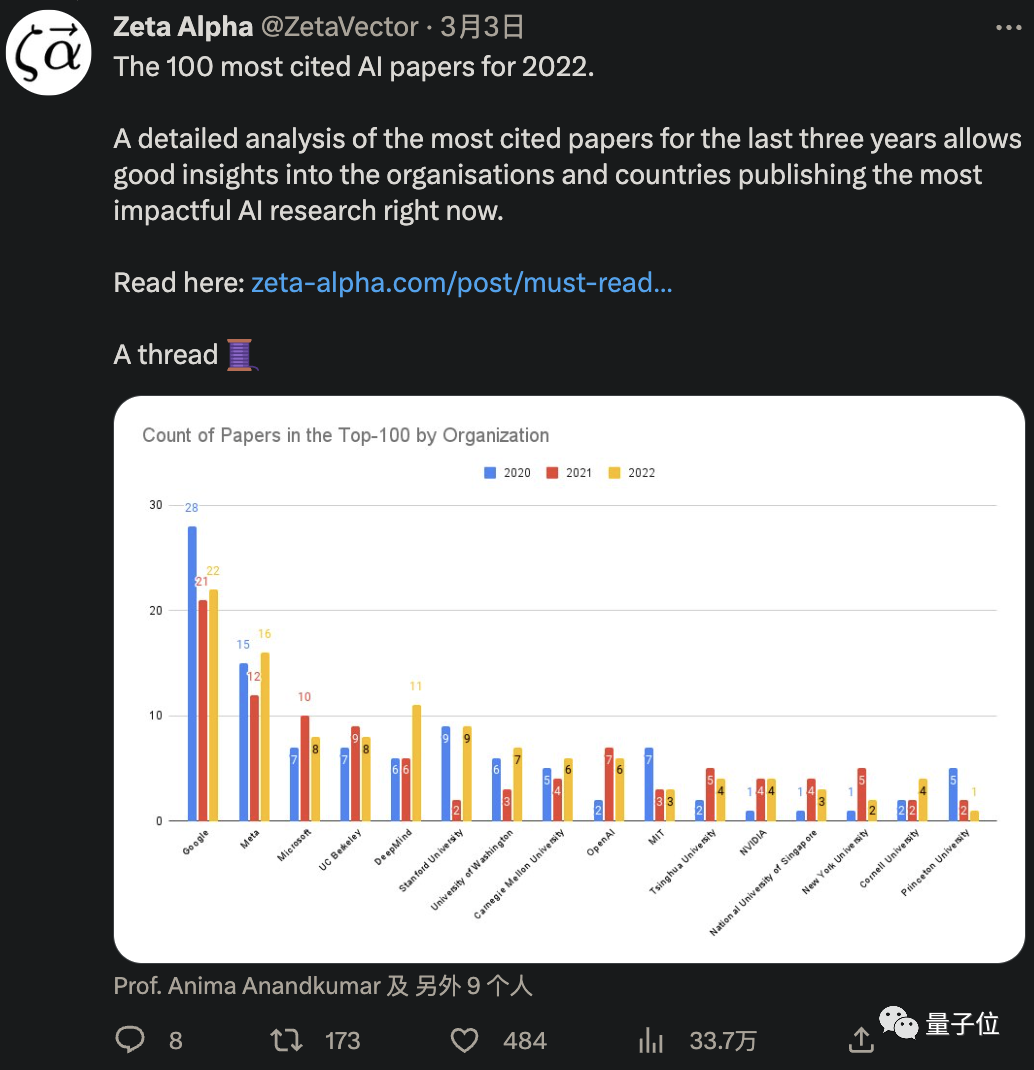

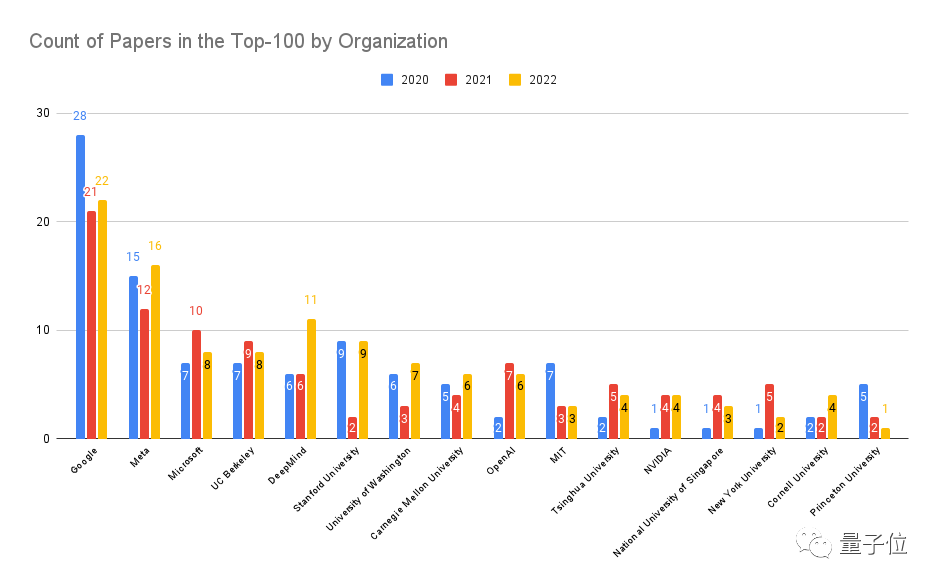

接下來(lái)是按組織或機(jī)構(gòu)評(píng)比論文引用次數(shù)進(jìn)前100最多的個(gè)體。

不太意外,谷歌與Meta微軟分列前三,隨后是UC伯克利、DeepMind和斯坦福。

OpenAI也收獲了一個(gè)還不錯(cuò)的名次,第九。第十是MIT,第十一是清華大學(xué)。

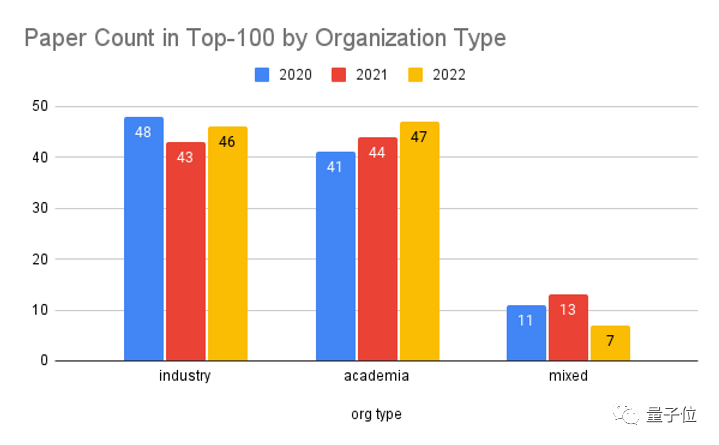

盡管前三名選手都來(lái)自工業(yè)界,但是如果只按照機(jī)構(gòu)類型來(lái)分,學(xué)術(shù)界和它的表現(xiàn)其實(shí)基本不相上下。

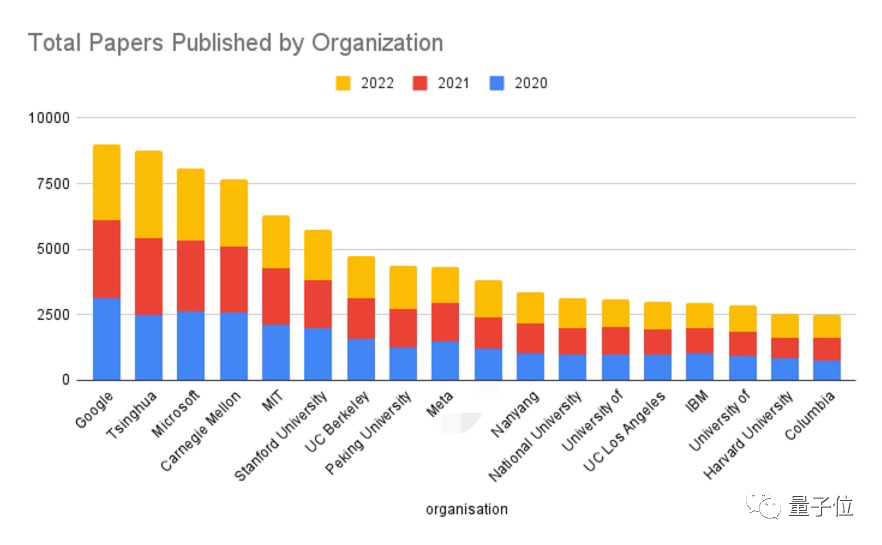

再接著,是過(guò)去三年各組織或機(jī)構(gòu)發(fā)表的論文總數(shù)排名。

老大還是谷歌。第二名比較亮眼,是清華大學(xué),隨后是微軟、CMU、MIT、斯坦福、UC伯克利、北京大學(xué)(第八)、Meta……

可以看到,前十里隸屬于學(xué)術(shù)界的機(jī)構(gòu)或組織占據(jù)了大片江山。

而我們找了半天,也沒有看到OpenAI和DeepMind的名字——

顯然它們發(fā)表的論文數(shù)量較少,主要靠質(zhì)量取勝。

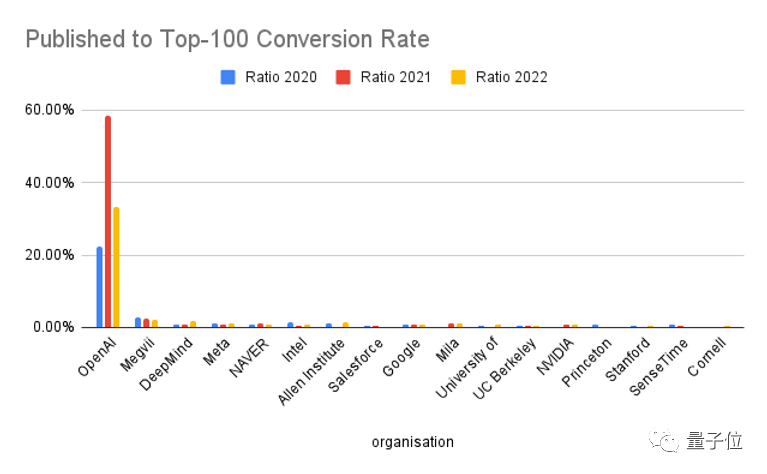

為了驗(yàn)證這一猜測(cè),Zeta Alpha也做了一個(gè)高引論文轉(zhuǎn)化率的排名。

果不其然,OpenAI摘得桂冠,DeepMind獲得第三。

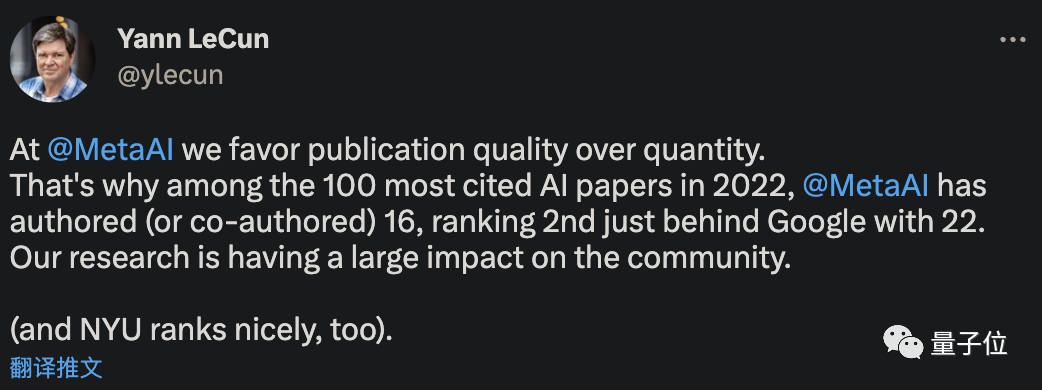

當(dāng)然,Meta也不錯(cuò),第四,引得LeCun都出來(lái)“現(xiàn)身說(shuō)法”了一下:

我們Meta確實(shí)是更注重質(zhì)量而不是數(shù)量的。

相比之下,高引多但發(fā)得更多的谷歌才排第九,差點(diǎn)出前10。

除了這幾位,第二名也是亮點(diǎn)——它就是曠視。

以及國(guó)內(nèi)還有商湯也上榜了。

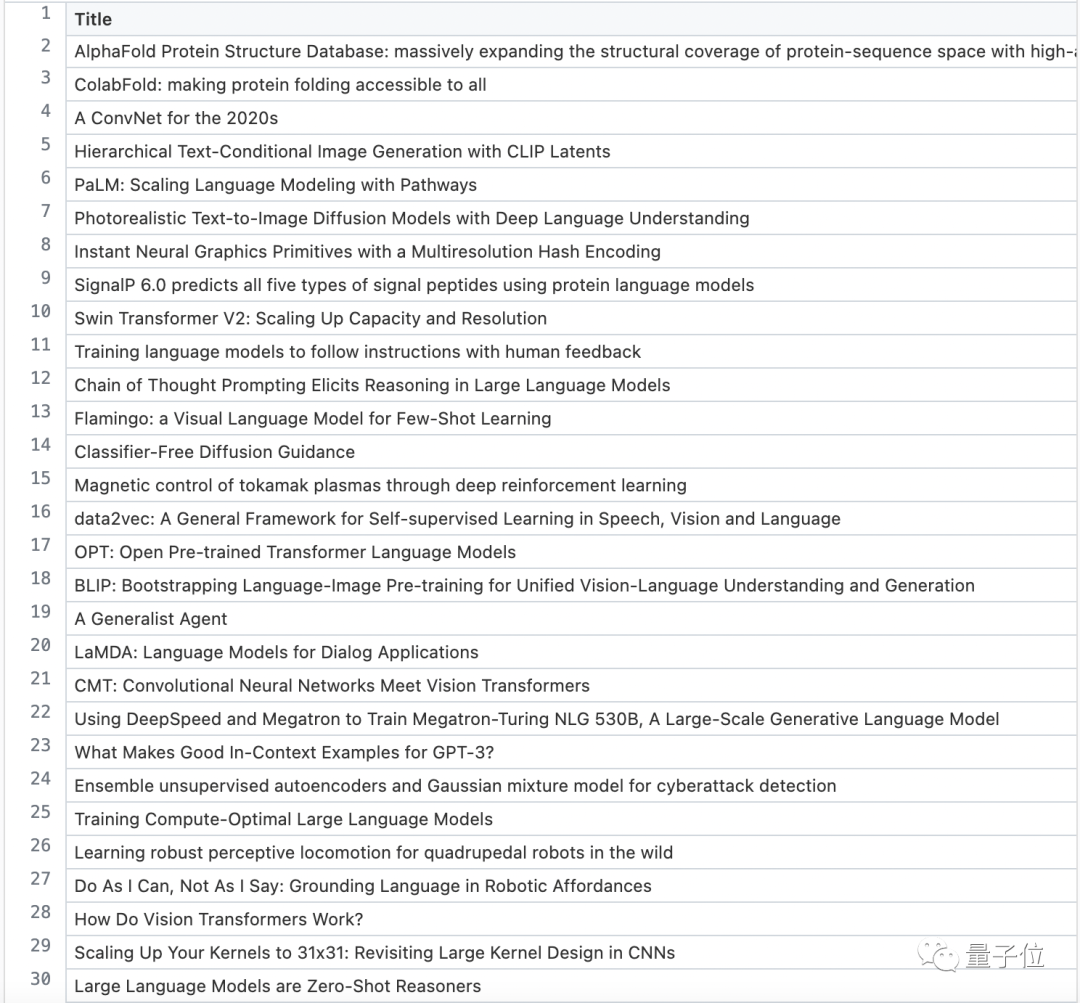

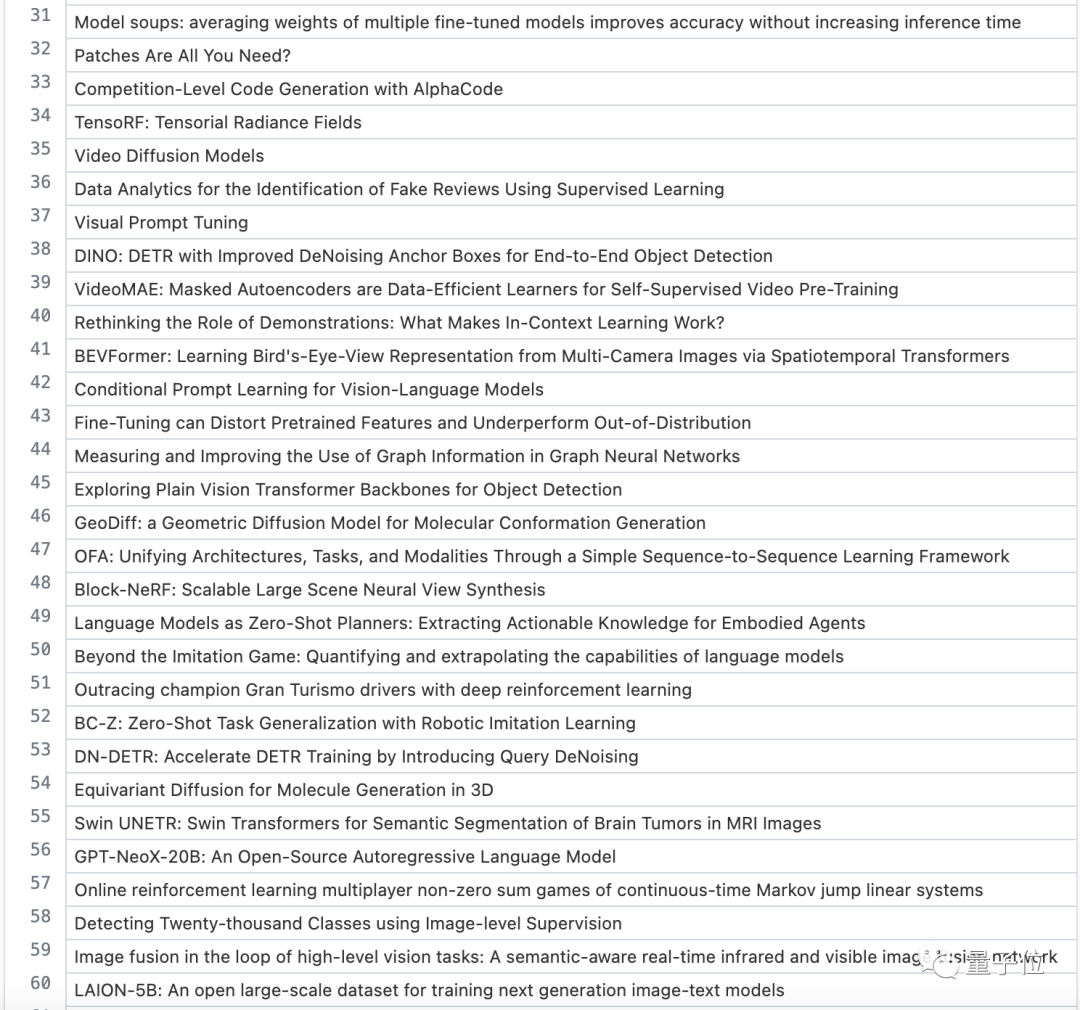

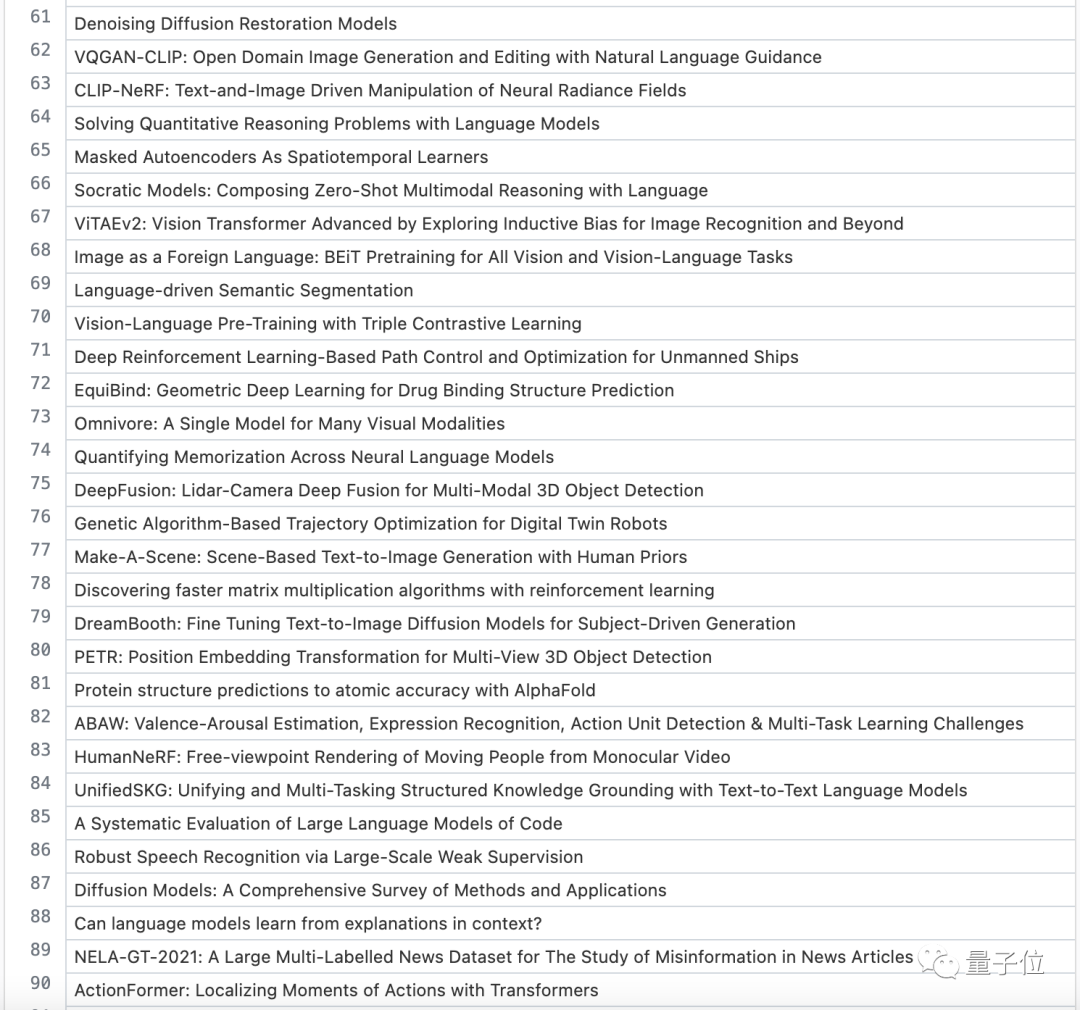

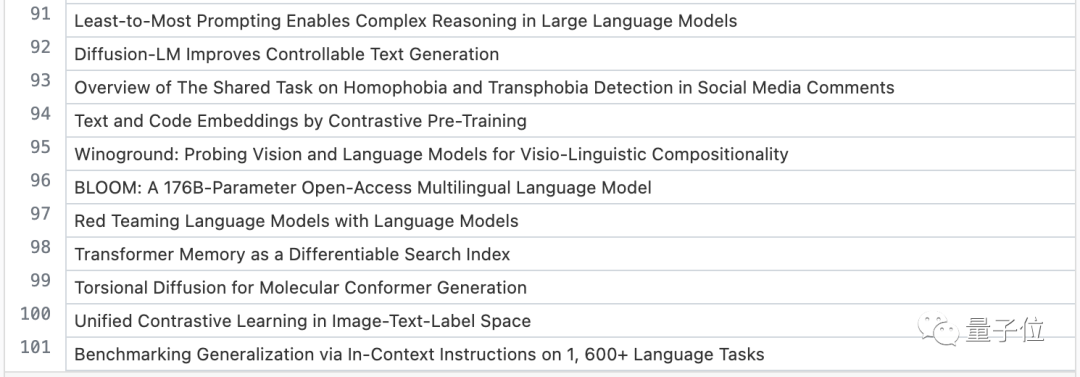

附2022引用Top100完整名單

ChatGPT的火著實(shí)盤活了AI產(chǎn)業(yè),最新前沿研究究竟會(huì)指往哪些方向?我們也需要更加敏銳地進(jìn)行觀察。

為此,Zeta Alpha也給出了2022年引用進(jìn)100的所有AI論文的名單,或許對(duì)大家有所啟發(fā)。

1-30:

31-60:

61-90:

91-100:

那么,Zeta Alpha這份報(bào)告的全部?jī)?nèi)容就是這些。

原文可戳:???https://www.zeta-alpha.com/post/must-read-the-100-most-cited-ai-papers-in-2022??