爬蟲與反爬蟲技術簡介

作者 | vivo 互聯網安全團隊- Xie Peng

互聯網的大數據時代的來臨,網絡爬蟲也成了互聯網中一個重要行業,它是一種自動獲取網頁數據信息的爬蟲程序,是網站搜索引擎的重要組成部分。通過爬蟲,可以獲取自己想要的相關數據信息,讓爬蟲協助自己的工作,進而降低成本,提高業務成功率和提高業務效率。

本文一方面從爬蟲與反反爬的角度來說明如何高效的對網絡上的公開數據進行爬取,另一方面也會介紹反爬蟲的技術手段,為防止外部爬蟲大批量的采集數據的過程對服務器造成超負載方面提供些許建議。

爬蟲指的是按照一定規則自動抓取萬維網信息的程序,本次主要會從爬蟲的技術原理與實現,反爬蟲與反反爬蟲兩個方面進行簡單的介紹,介紹的案例均只是用于安全研究和學習,并不會進行大量爬蟲或者應用于商業。

一、爬蟲的技術原理與實現

1.1 爬蟲的定義

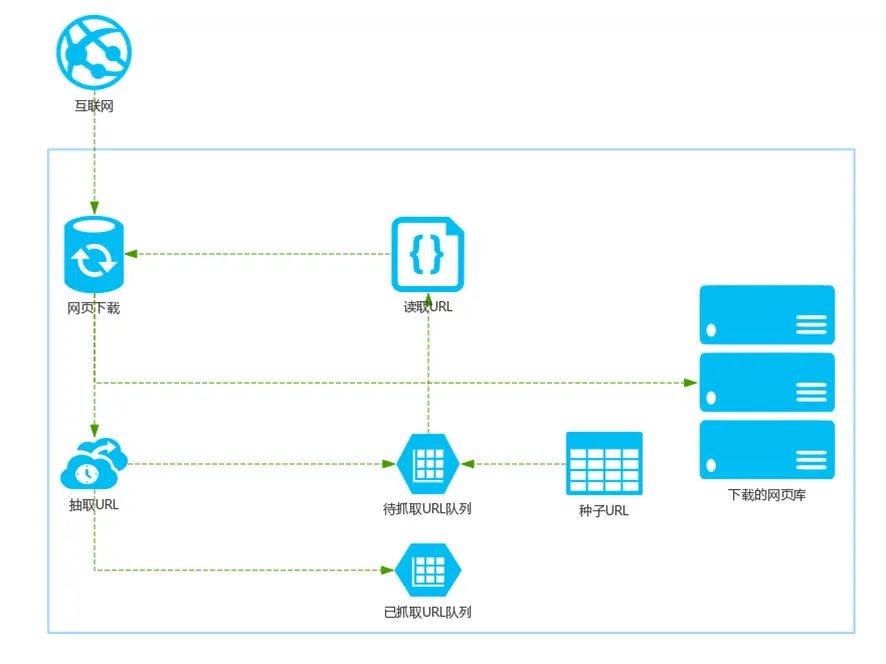

爬蟲分為通用爬蟲和聚焦爬蟲兩大類,前者的目標是在保持一定內容質量的情況下爬取盡可能多的站點,比如百度這樣的搜索引擎就是這種類型的爬蟲,如圖1是通用搜索引擎的基礎架構:

- 首先在互聯網中選出一部分網頁,以這些網頁的鏈接地址作為種子URL;

- 將這些種子URL放入待抓取的URL隊列中,爬蟲從待抓取的URL隊列依次讀取;

- 將URL通過DNS解析,把鏈接地址轉換為網站服務器對應的IP地址;

- 網頁下載器通過網站服務器對網頁進行下載,下載的網頁為網頁文檔形式;

- 對網頁文檔中的URL進行抽取,并過濾掉已經抓取的URL;

- 對未進行抓取的URL繼續循環抓取,直至待抓取URL隊列為空。

圖1.通用搜索引擎的基礎架構

爬蟲通常從一個或多個 URL 開始,在爬取的過程中不斷將新的并且符合要求的 URL 放入待爬隊列,直到滿足程序的停止條件。

而我們日常見到的爬蟲基本為后者,目標是在爬取少量站點的情況下盡可能保持精準的內容質量。典型的比如圖2搶票軟件所示,就是利用爬蟲來登錄售票網絡并爬取信息,從而輔助商業。

圖2.搶票軟件

了解了爬蟲的定義后,那么應該如何編寫爬蟲程序來爬取我們想要的數據呢。我們可以先了解下目前常用的爬蟲框架,因為它可以將一些常見爬蟲功能的實現代碼寫好,然后留下一些接口,在做不同的爬蟲項目時,我們只需要根據實際情況,手寫少量需要變動的代碼部分,并按照需要調用這些接口,即可以實現一個爬蟲項目。

1.2 爬蟲框架介紹

常用的搜索引擎爬蟲框架如圖3所示,首先Nutch是專門為搜索引擎設計的爬蟲,不適合用于精確爬蟲。Pyspider和Scrapy都是python語言編寫的爬蟲框架,都支持分布式爬蟲。另外Pyspider由于其可視化的操作界面,相比Scrapy全命令行的操作對用戶更加友好,但是功能不如Scrapy強大。

圖3.爬蟲框架對比

1.3 爬蟲的簡單示例

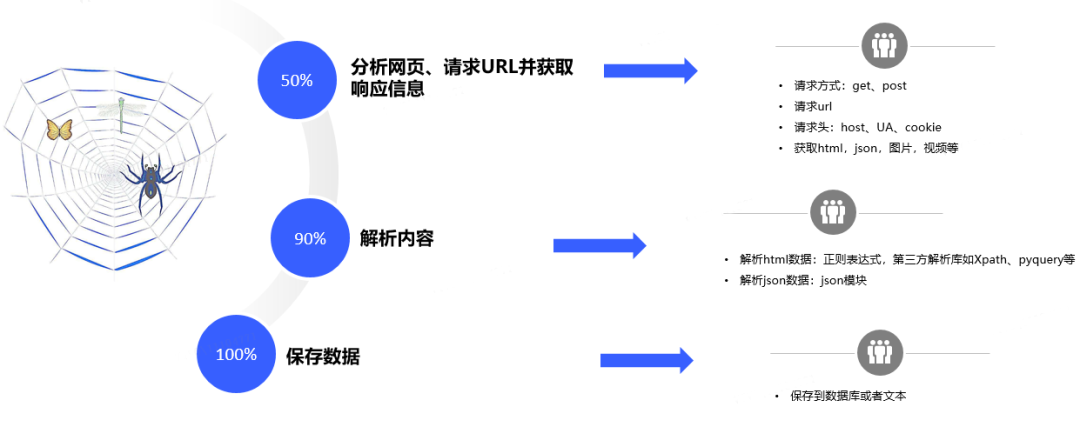

除了使用爬蟲框架來進行爬蟲,也可以從頭開始來編寫爬蟲程序,步驟如圖4所示:

圖4.爬蟲的基本原理

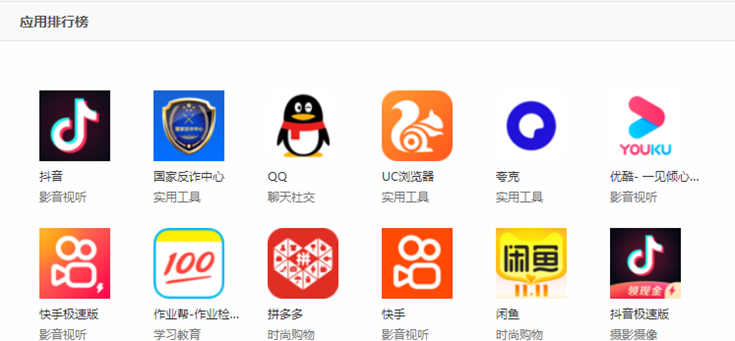

接下來通過一個簡單的例子來實際演示上述的步驟,我們要爬取的是某應用市場的榜單,以這個作為例子,是因為這個網站沒有任何的反爬蟲手段,我們通過上面的步驟可以輕松爬取到內容。

圖5.網頁與其對應的源代碼

網頁與其對應的源代碼如圖5所示,對于網頁上的數據,假定我們想要爬取排行榜上每個app的名稱以及其分類。

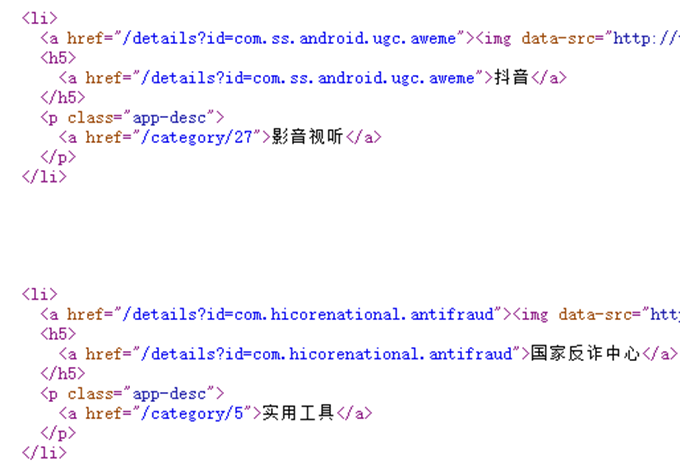

我們首先分析網頁源代碼,發現可以直接在網頁源代碼中搜索到“抖音”等app的名稱,接著看到app名稱、app類別等都是在一個<li>標簽里,所以我們只需要請求網頁地址,拿到返回的網頁源代碼,然后對網頁源代碼進行正則匹配,提取出想要的數據,保存下來即可,如圖6所示。

圖6.爬蟲的代碼以及結果

二、反爬蟲相關技術

在了解具體的反爬蟲措施之前,我們先介紹下反爬蟲的定義和意義,限制爬蟲程序訪問服務器資源和獲取數據的行為稱為反爬蟲。爬蟲程序的訪問速率和目的與正常用戶的訪問速率和目的是不同的,大部分爬蟲會無節制地對目標應用進行爬取,這給目標應用的服務器帶來巨大的壓力。爬蟲程序發出的網絡請求被運營者稱為“垃圾流量”。開發者為了保證服務器的正常運轉或降低服務器的壓力與運營成本,不得不使出各種各樣的技術手段來限制爬蟲對服務器資源的訪問。

所以為什么要做反爬蟲,答案是顯然的,爬蟲流量會提升服務器的負載,過大的爬蟲流量會影響到服務的正常運轉,從而造成收入損失,另一方面,一些核心數據的外泄,會使數據擁有者失去競爭力。

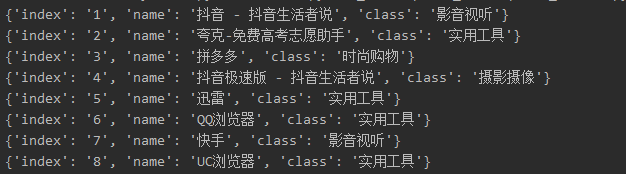

常見的反爬蟲手段,如圖7所示。主要包含文本混淆、頁面動態渲染、驗證碼校驗、請求簽名校驗、大數據風控、js混淆和蜜罐等,其中文本混淆包含css偏移、圖片偽裝文本、自定義字體等,而風控策略的制定則往往是從參數校驗、行為頻率和模式異常等方面出發的。

圖7.常見的反爬蟲手段

2.1 CSS偏移反爬蟲

在搭建網頁的時候,需要用CSS來控制各類字符的位置,也正是如此,可以利用CSS來將瀏覽器中顯示的文字,在HTML中以亂序的方式存儲,從而來限制爬蟲。CSS偏移反爬蟲,就是一種利用CSS樣式將亂序的文字排版成人類正常閱讀順序的反爬蟲手段。這個概念不是很好理解,我們可以通過對比兩段文字來加深對這個概念的理解:

- HTML 文本中的文字:我的學號是 1308205,我在北京大學讀書。

- 瀏覽器顯示的文字:我的學號是 1380205,我在北京大學讀書。

以上兩段文字中瀏覽器顯示的應該是正確的信息,如果我們按之前提到的爬蟲步驟,分析網頁后正則提取信息,會發現學號是錯的。

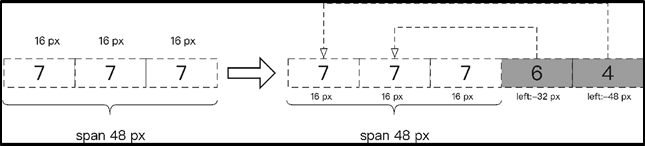

接著看圖8所示的例子,如果我們想爬取該網頁上的機票信息,首先需要分析網頁。紅框所示的價格467對應的是中國民航的從石家莊到上海的機票,但是分析網頁源代碼發現代碼中有 3 對 b 標簽,第 1 對 b 標簽中包含 3 對 i 標簽,i 標簽中的數字都是 7,也就是說第 1 對 b 標簽的顯示結果應該是 777。而第 2 對 b 標簽中的數字是 6,第 3 對 b 標簽中的數字是 4,這樣的話我們會無法直接通過正則匹配得到正確的機票價格。

圖8.CSS 偏移反爬蟲例子

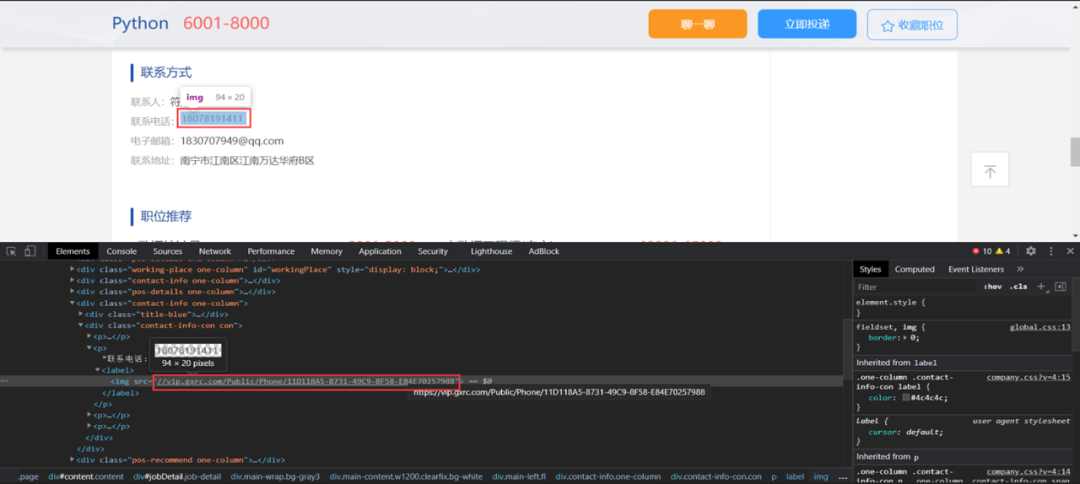

2.2 圖片偽裝反爬蟲

圖片偽裝反爬蟲,它的本質就是用圖片替換了原來的內容,從而讓爬蟲程序無法正常獲取,如圖9所示。這種反爬蟲的原理十分簡單,就是將本應是普通文本內容的部分在前端頁面中用圖片來進行替換,遇到這種案例可以直接用ocr識別圖片中的文字就可以繞過。而且因為是用圖片替換文本顯示,所以圖片本身會相對比較清晰,沒有很多噪聲干擾,ocr識別的結果會很準確。

圖9. 圖片偽裝反爬蟲例子

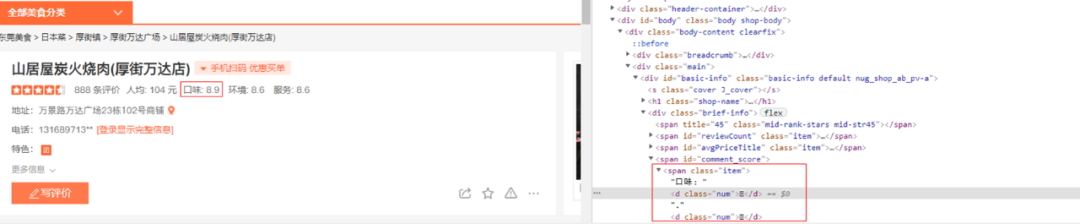

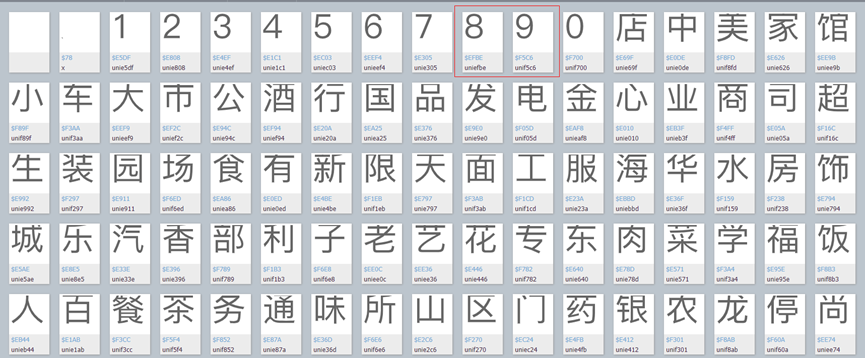

2.3 自定義字體反爬蟲

在 CSS3 時代,開發者可以使用@font-face為網頁指定字體。開發者可將心儀的字體文件放在 Web 服務器上,并在 CSS 樣式中使用它。用戶使用瀏覽器訪問 Web 應用時,對應的字體會被瀏覽器下載到用戶的計算機上,但是我們在使用爬蟲程序時,由于沒有相應的字體映射關系,直接爬取就會無法得到有效數據。

如圖10所示,該網頁中每個店鋪的評價數、人均、口味、環境等信息均是亂碼字符,爬蟲無法直接讀取到內容。

圖10. 自定義字體反爬蟲例子

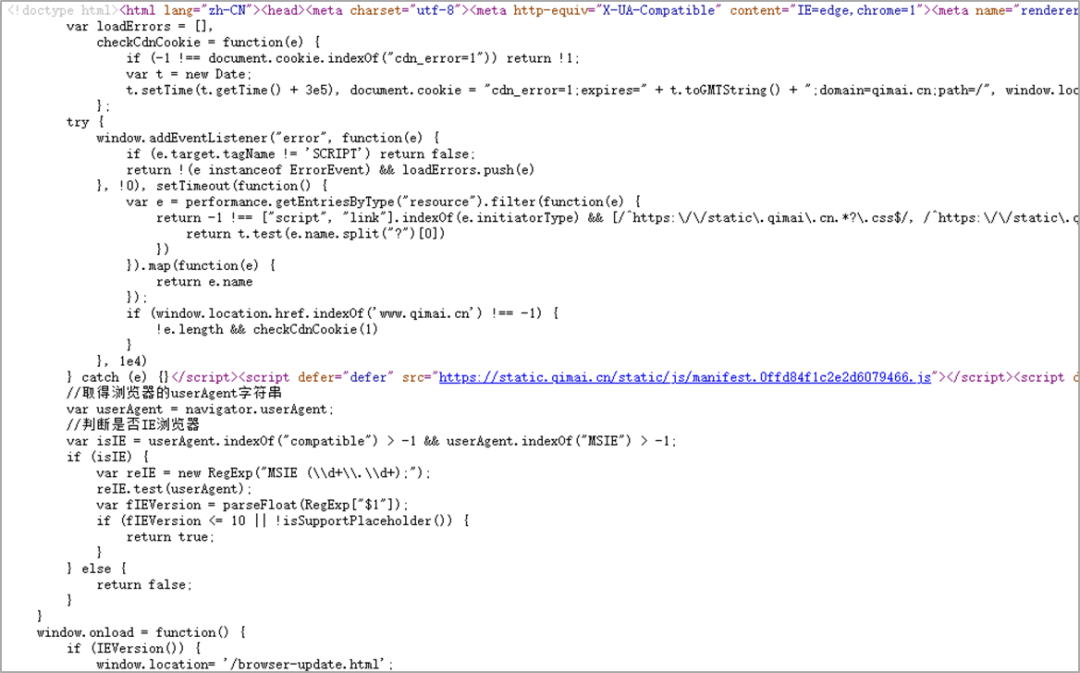

2.4 頁面動態渲染反爬蟲

網頁按渲染方式的不同,大體可以分為客戶端和服務端渲染。

- 服務端渲染,頁面的結果是由服務器渲染后返回的,有效信息包含在請求的 HTML 頁面里面,通過查看網頁源代碼可以直接查看到數據等信息;

- 客戶端渲染,頁面的主要內容由 JavaScript 渲染而成,真實的數據是通過 Ajax 接口等形式獲取的,通過查看網頁源代碼,無有效數據信息。

客戶端渲染和服務器端渲染的最重要的區別就是究竟是誰來完成html文件的完整拼接,如果是在服務器端完成的,然后返回給客戶端,就是服務器端渲染,而如果是前端做了更多的工作完成了html的拼接,則就是客戶端渲染。

圖11.客戶端渲染例子

2.5 驗證碼反爬蟲

幾乎所有的應用程序在涉及到用戶信息安全的操作時,都會彈出驗證碼讓用戶進行識別,以確保該操作為人類行為,而不是大規模運行的機器。那為什么會出現驗證碼呢?在大多數情形下是因為網站的訪問頻率過高或者行為異常,或者是為了直接限制某些自動化行為。歸類如下:

- 很多情況下,比如登錄和注冊,這些驗證碼幾乎是必現的,它的目的就是為了限制惡意注冊、惡意爆破等行為,這也算反爬的一種手段。

- 一些網站遇到訪問頻率過高的行為的時候,可能會直接彈出一個登錄窗口,要求我們登錄才能繼續訪問,此時的驗證碼就直接和登錄表單綁定在一起了,這就算檢測到異常之后利用強制登錄的方式進行反爬。

- 一些較為常規的網站如果遇到訪問頻率稍高的情形的時候,會主動彈出一個驗證碼讓用戶識別并提交,驗證當前訪問網站的是不是真實的人,用來限制一些機器的行為,實現反爬蟲。

常見的驗證碼形式包括圖形驗證碼、行為驗證碼、短信、掃碼驗證碼等,如圖12所示。對于能否成功通過驗證碼,除了能夠準確的根據驗證碼的要求完成相應的點擊、選擇、輸入等,通過驗證碼風控也至關重要;比如對于滑塊驗證碼,驗證碼風控可能會針對滑動軌跡進行檢測,如果檢測出軌跡非人為,就會判定為高風險,導致無法成功通過。

圖12.驗證碼反爬蟲手段

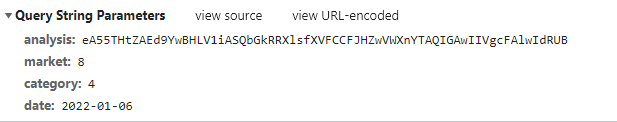

2.6 請求簽名校驗反爬蟲

簽名驗證是防止服務器被惡意鏈接和篡改數據的有效方式之一,也是目前后端API最常用的防護方式之一。簽名是一個根據數據源進行計算或者加密的過程,用戶經過簽名后會一個具有一致性和唯一性的字符串,它就是你訪問服務器的身份象征。由它的一致性和唯一性這兩種特性,從而可以有效的避免服務器端,將偽造的數據或被篡改的數據當初正常數據處理。

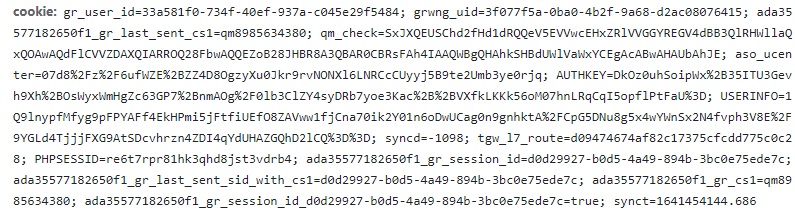

前面在2.4節提到的網站是通過客戶端渲染網頁,數據則是通過ajax請求拿到的,這種在一定程度上提升了爬蟲的難度。接下來分析ajax請求,如圖13所示,會發現其ajax請求是帶有請求簽名的,analysis就是加密后的參數,而如果想要破解請求接口,就需要破解該參數的加密方法,這無疑進一步提升了難度。

圖13. 請求榜單數據的ajax請求

2.7 蜜罐反爬蟲

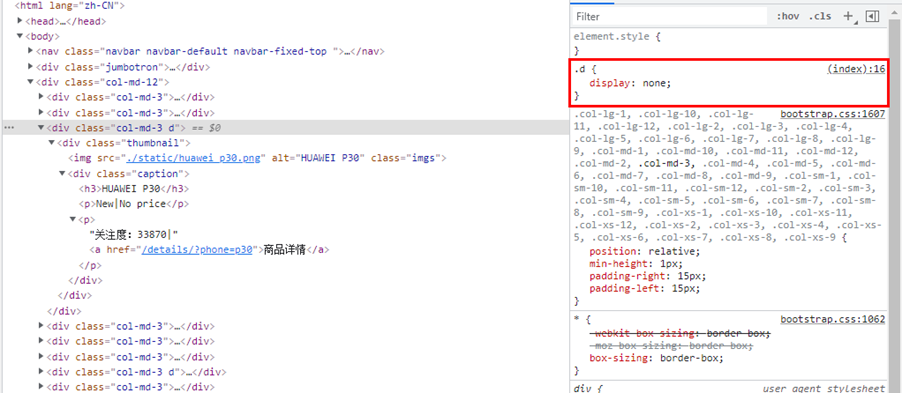

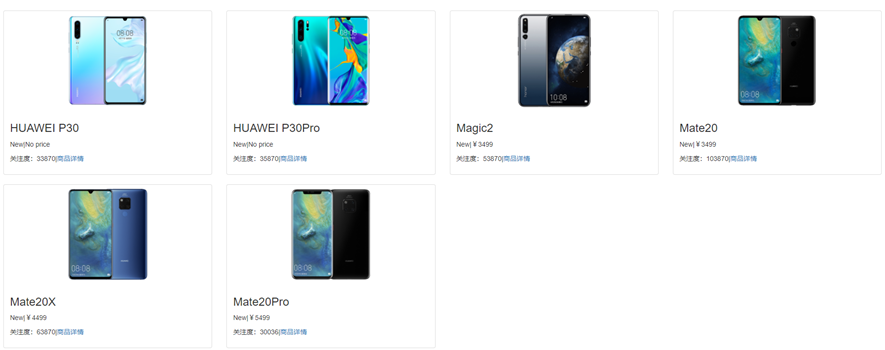

蜜罐反爬蟲,是一種在網頁中隱藏用于檢測爬蟲程序的鏈接的手段,被隱藏的鏈接不會顯示在頁面中,正常用戶無法訪問,但爬蟲程序有可能將該鏈接放入待爬隊列,并向該鏈接發起請求,開發者可以利用這個特點區分正常用戶和爬蟲程序。如圖14所示,查看網頁源碼,頁面只有6個商品,col-md-3的 <div>標簽卻有 8 對。該 CSS 樣式的作用是隱藏標簽,所以我們在頁面只看到 6 件商品,爬蟲程序會提取到 8 件商品的 URL。

圖14.蜜罐反爬蟲例子

三、反反爬相關技術

針對上一節提到的反爬蟲相關技術,有以下幾類反反爬技術手段:css偏移反反爬、自定義字體反反爬、頁面動態渲染反反爬、驗證碼破解等,下面對這幾類方法進行詳細的介紹。

3.1 CSS偏移反反爬

3.1.1 CSS偏移邏輯介紹

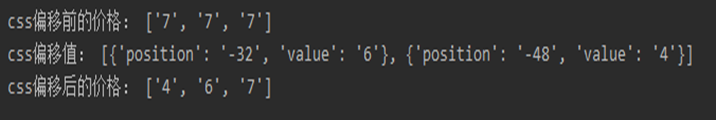

那么對于以上2.1css偏移反爬蟲的例子,怎么才能得到正確的機票價格呢。仔細觀察css樣式,可以發現每個帶有數字的標簽都設定了樣式,第 1 對 b 標簽內的i 標簽對的樣式是相同的,都是width: 16px;另外,還注意到最外層的 span 標簽對的樣式為width:48px。

如果按照 css樣式這條線索來分析的話,第 1 對 b 標簽中的 3 對 i 標簽剛好占滿 span 標簽對的位置,其位置如圖15所示。此時網頁中顯示的價格應該是 777,但是由于第 2 和第 3 對 b 標簽中有值,所以我們還需要計算它們的位置。由于第 2 對 b 標簽的位置樣式是 left:-32px,所以第 2 對 b 標簽中的值 6 就會覆蓋原來第 1 對 b 標簽中的中的第 2 個數字 7,此時頁面應該顯示的數字是 767。

按此規律推算,第 3 對 b 標簽的位置樣式是 left:-48px,這個標簽的值會覆蓋第 1 對 b 標簽中的第 1 個數字 7,最后顯示的票價就是 467。

圖15.偏移邏輯

3.1.2 CSS偏移反反爬代碼實現

因此接下來我們按以上css樣式的規律來編寫代碼對該網頁爬取獲取正確的機票價格,代碼和結果如圖16所示。

圖16. CSS 偏移反反爬代碼與結果

3.2 自定義字體反反爬

針對于以上2.3自定義字體反爬蟲的情況,解決思路就是提取出網頁中自定義字體文件(一般為WOFF文件),并將映射關系包含到爬蟲代碼中,就可以獲取到有效數據。解決的步驟如下:

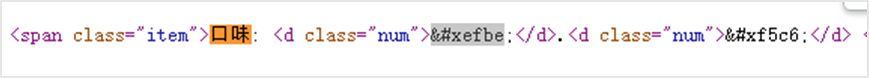

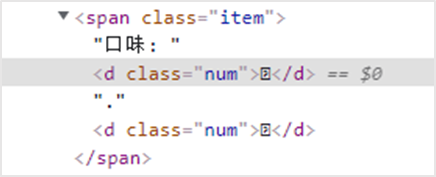

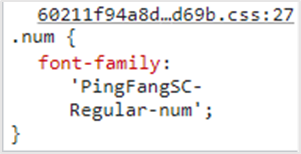

發現問題:查看網頁源代碼,發現關鍵字符被編碼替代,如

分析:檢查網頁,發現應用了css自定義字符集隱藏

查找:查找css文件url,獲取字符集對應的url,如PingFangSC-Regular-num

查找:查找和下載字符集url

比對:比對字符集中的字符與網頁源代碼中的編碼,發現編碼的后四位與字符對應,也即網頁源代碼對應的口味是8.9分

3.3 頁面動態渲染反反爬

客戶端渲染的反爬蟲,頁面代碼在瀏覽器源代碼中看不到,需要執行渲染并進一步獲取渲染后結果。針對這種反爬蟲,有以下幾種方式破解:

- 在瀏覽器中,通過開發者工具直接查看ajax具體的請求方式、參數等內容;

- 通過selenium模擬真人操作瀏覽器,獲取渲染后的結果,之后的操作步驟和服務端渲染的流程一樣;

- 如果渲染的數據隱藏在html結果的JS變量中,可以直接正則提取;

- 如果有通過JS生成的加密參數,可以找出加密部分的代碼,然后使用pyexecJS來模擬執行JS,返回執行結果。

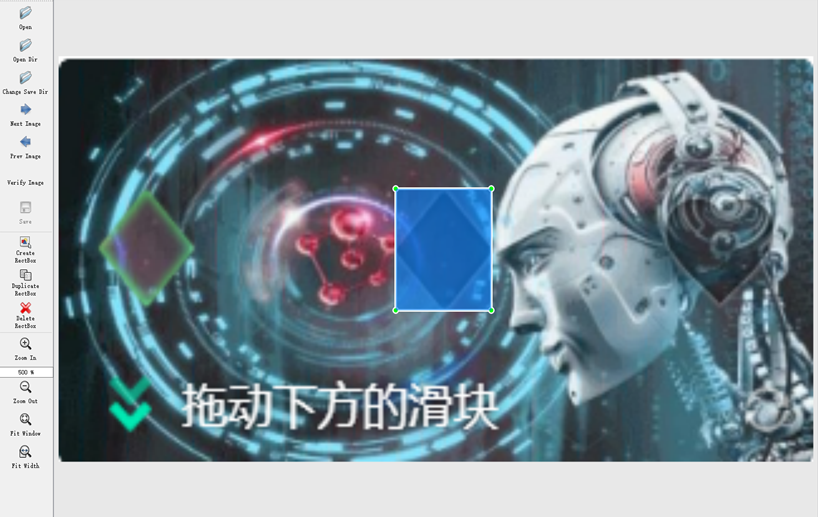

3.4 驗證碼破解

下面舉例一個識別滑塊驗證碼的例子,如圖17所示,是使用目標檢測模型來識別某滑塊驗證碼缺口位置的結果示例,這種破解滑塊驗證碼的方式對應的是模擬真人的方式。不采用接口破解的原因一方面是破解加密算法有難度,另一方面也是加密算法可能每天都會變,這樣破解的時間成本也比較大。

圖17. 通過目標檢測模型識別滑塊驗證碼的缺口

3.4.1 爬取滑塊驗證碼圖片

因為使用的目標檢測模型yolov5是有監督學習,所以需要爬取滑塊驗證碼的圖片并進行打標,進而輸入到模型中訓練。通過模擬真人的方式在某場景爬取部分驗證碼。

圖18. 爬取的滑塊驗證碼圖片

3.4.2 人工打標

本次使用的是labelImg來對圖片人工打標簽的,人工打標耗時較長,100張圖片一般耗時40分鐘左右。自動打標代碼寫起來比較復雜,主要是需要分別提取出驗證碼的所有背景圖片和缺口圖片,然后隨機生成缺口位置,作為標簽,同時將缺口放到對應的缺口位置,生成圖片,作為輸入。

圖19. 對驗證碼圖片打標簽以及打標簽后生成的xml文件

3.4.3 目標檢測模型yolov5

直接從github下clone yolov5的官方代碼,它是基于pytorch實現。

接下來的使用步驟如下:

- 數據格式轉換:將人工標注的圖片和標簽文件轉換為yolov5接收的數據格式,得到1100張圖片和1100個yolov5格式的標簽文件;

- 新建數據集:新建custom.yaml文件來創建自己的數據集,包括訓練集和驗證集的目錄、類別數目、類別名;

- 訓練調優:修改模型配置文件和訓練文件后,進行訓練,并根據訓練結果調優超參數。

轉換xml文件為yolov5格式的部分腳本:

訓練參數設置:

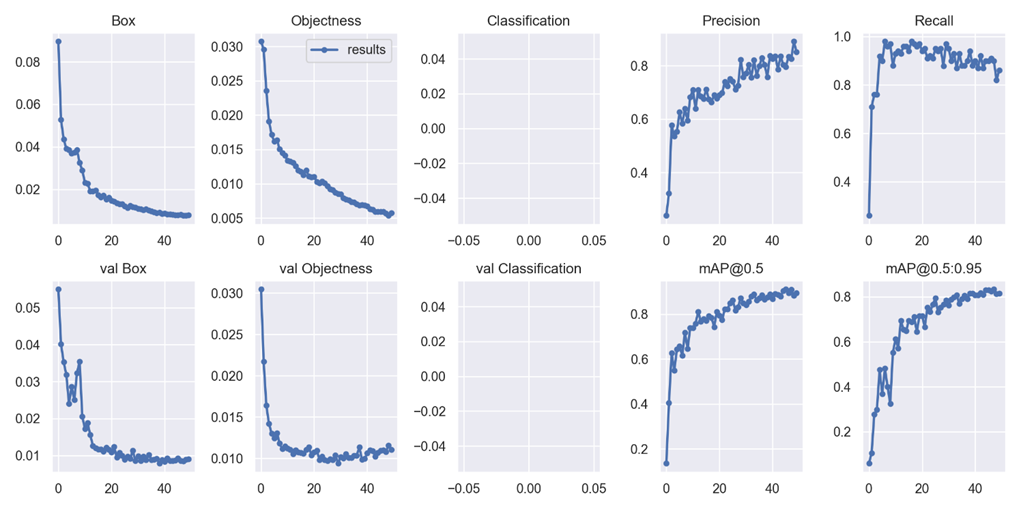

3.4.4 目標檢測模型的訓練結果

模型基本在50次迭代的時候在precision和recall以及mAP上已經達到了瓶頸。預測結果也有如下問題:大部分能夠是能夠準確框出缺口,但也出現少量框錯、框出兩個缺口、框不出缺口的情況。

圖20. 上:模型的訓練結果走勢圖;

下:模型對部分驗證集的預測結果

四、總結

本次簡單對爬蟲以及反爬蟲的技術手段進行了介紹,介紹的技術和案例均只是用于安全研究和學習,并不會進行大量爬蟲或者應用于商業。

對于爬蟲,本著爬取網絡上公開數據用于數據分析等的目的,我們應該遵守網站robots協議,本著不影響網站正常運行以及遵守法律的情況下進行數據爬取;對于反爬蟲,因為只要人類能夠正常訪問的網頁,爬蟲在具備同等資源的情況下就一定可以抓取到。所以反爬蟲的目的還是在于能夠防止爬蟲在大批量的采集網站信息的過程對服務器造成超負載,從而杜絕爬蟲行為妨礙到用戶的體驗,來提高用戶使用網站服務的滿意度。