Text-to-3D!建筑學小哥自稱編程菜鳥,攢了個AI作畫三維版,還是彩色的

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

AI畫師,技術(shù)又精進了——

直接一句話/一張圖,生成3D模型、環(huán)繞視頻、NeRF實例那種。

還是帶顏色的。

輸入“一幅美麗的花樹畫,作者Chiho Aoshima,長鏡頭,超現(xiàn)實主義”,就能瞬間得到一個長這樣的花樹視頻,時長13秒。

這個文本/圖片-3D生成AI,叫Dreamfields-3D,來自一個自稱編程菜鳥的建筑學在讀博士。

Demo剛被小哥放在微博、推特等平臺,許多網(wǎng)友已經(jīng)急著蹲內(nèi)測了:

現(xiàn)在,小哥已經(jīng)將它開源,colab上也能運行。

一起來上手玩玩看~

AI作畫3D版在線玩

Dreamfields-3D玩法十分低門檻,大致只需要三步。這里介紹一下colab上在線玩的步驟。

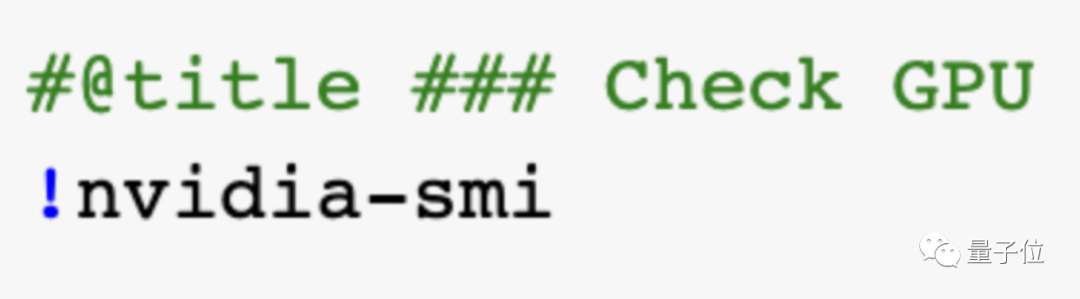

首先,檢查一下GPU,再安裝個谷歌驅(qū)動器。

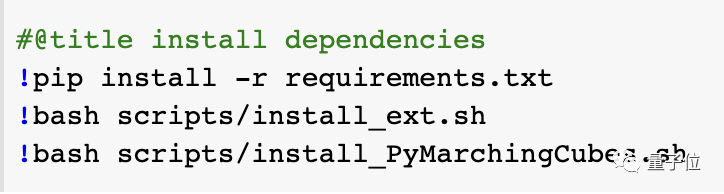

第二步,調(diào)出工具開始運行,并安裝依賴項。

然后定義一些必要的功能,就可以在colab上訓練和測試了~

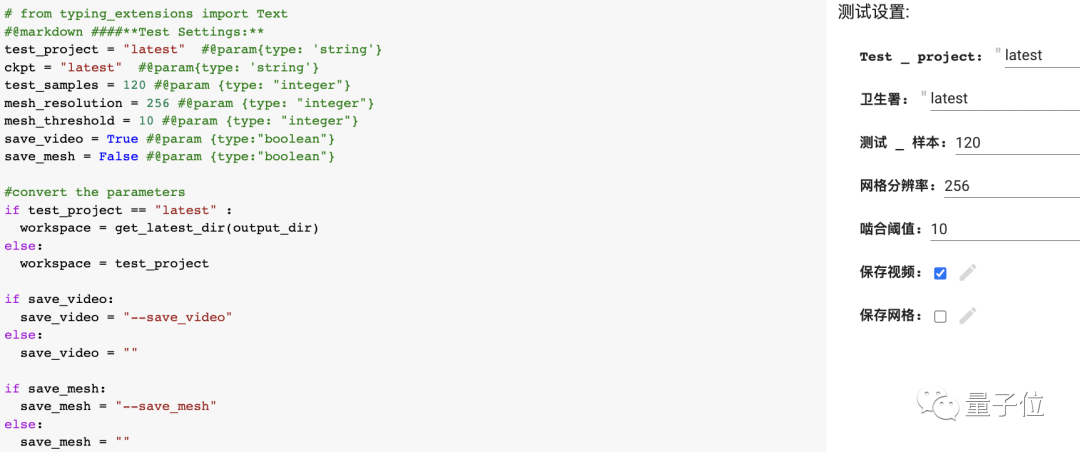

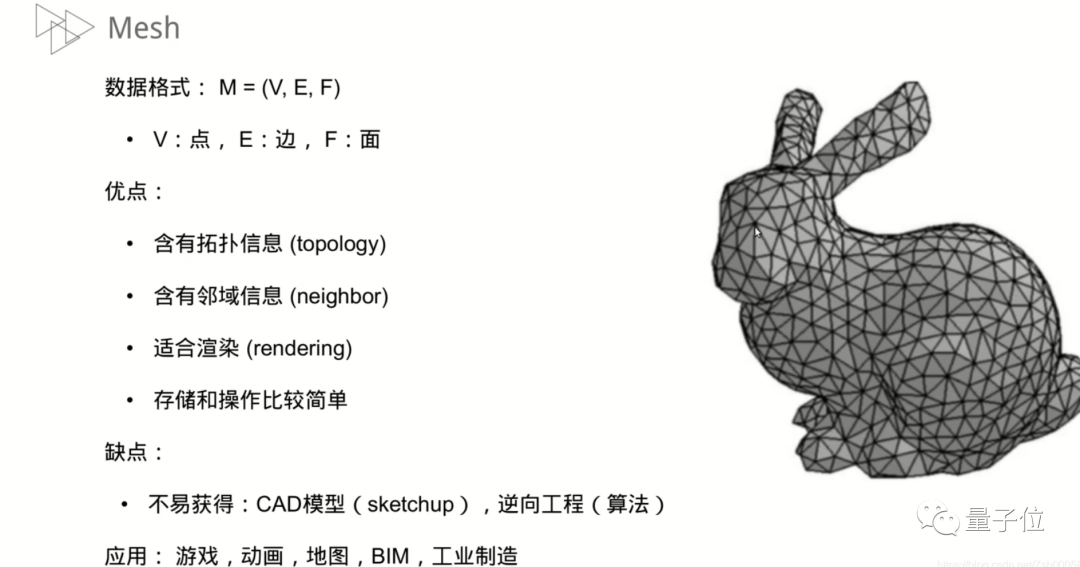

玩的時候需要輸入一些參數(shù),保存格式有視頻和網(wǎng)格兩種,輸出模型格式為帶頂點色的obj和ply。

萬事俱備,讓我們現(xiàn)在開始。

試試輸入“一個賽博朋克風格的飛行霓虹燈汽車,格雷格魯特科夫斯基和西蒙斯大林風格,長鏡頭,CG社會,虛幻的引擎,史詩游戲”?

會得到一個果然很賽博的汽車的視頻。

如果你是《千與千尋》重度愛好者,想搞張吉卜力風格的視頻玩玩。

沒問題,prompt輸入“一張美麗的天空城市的插圖,吉卜力工作室,藝術(shù)站,8k HD,CG社會”,這不就來了——

有網(wǎng)友迫不及待上手,做出了個小計算機。

當然在鵝妹子嚶的驚嘆中,也有網(wǎng)友表達了希望Dreamfields-3D更好的期許。

當然,除了文本輸入,Dreamfield3D是支持圖片作為prompt的。

不過現(xiàn)在版本還有待完善,如果輸入圖片,會造成過擬合,簡單說就是如果喂它一張車的正面圖,生成的3D視頻中,那輛車可能4個面都是正面……

想要玩兒圖片輸入的友友們,怕是要再等等了。

基于現(xiàn)狀,小哥在GitHub表達了未來的改進目標:

- 同時使用不同的CLIP模型。

- 僅在指定方向應用圖像提示。未來可能要加一個圖片角度的約束,例如只有在輸入圖片相同角度時,輸出才參考該圖片。

- 作為NeRF實例讀取現(xiàn)有網(wǎng)格,然后通過文本/圖像prompt進行修改。

- 在訓練中減少GPU RAM的使用。

(但小哥說了,自己是個編程菜鳥,后續(xù)可不保證哦)doge

基于谷歌Dreamfields-Torch

小哥是建筑學出身,據(jù)他講,Dreamfield3D是他從創(chuàng)作者角度出發(fā),對Dreamfield-Torch做了些優(yōu)化,主要的代碼工作還是來自上游的Dreamfields-Torch和Dreamfields。

介紹下,Dreamfields來自谷歌,它的特點是無需照片樣本,簡簡單單一句話,就能生成3D圖像,還可以生成多種物品組合成的復合結(jié)構(gòu)。

在生成3D場景時,通常會選用神經(jīng)輻射場(NeRF)參數(shù)方案。

NeRF的特點是可分別渲染場景,但需要很多張3D照片,才能實現(xiàn)360°視覺重建。

相比之下,Dreamfields生成3D模型不需要照片,因為它基于NeRF 3D場景技術(shù)、OpenAI文本生成模型DALL·E以及CLIP的3D生成系統(tǒng)開發(fā),通過神經(jīng)網(wǎng)絡來儲存3D模型。

DALL·E和CLIP同樣師出谷歌,前者通過文本生成圖像,后者通過文本分類圖片。用CLIP來分類DALL·E生成的圖像,可以提升圖像生成的準確性。

Dreamfields-Torch則是一個經(jīng)過修改的Dreamfields的Pytorch實現(xiàn),主要是把原Dreamfields的后端,從原始NeRR換成了instant-ngp。

以此為基礎,小哥做出的Dreamfields-3D基本上靠CLIP + NERF運作。

作者簡介

作者蒙勝宇(Simon Meng),奧地利因斯布魯克大學(UIBK)建筑學在讀博士。

碩士畢業(yè)于倫敦大學學院(UCL)建筑學,現(xiàn)為UIBK及UCL技術(shù)課程助教及特邀評圖嘉賓,從事建筑設計、藝術(shù)、AI及生物學跨領(lǐng)域研究。

小哥從去年6、7月份開始關(guān)注AI圖像生成。

他發(fā)現(xiàn),很多破圈技術(shù),如clip guide diffusion,disco diffusion,都是一些懂代碼的跨界者做的。

去年年末谷歌發(fā)布Dreamfields,他就動了用它做3D輸出的心思。

于是,在拿到動畫后,他用AI做了超采樣放大和插幀,然后導出幀到普通的多目重建軟件(類似colmap),成功重建mesh(一個用3D模型數(shù)據(jù)還原的模型圖)。

小哥把mesh發(fā)在推特上,結(jié)果Dreamfields論文的原作者Ajay Jain聯(lián)系到他,表示了歡迎,還鼓勵他保持優(yōu)化更新——雖然那時候他用的是普通航拍實景重建軟件,不是編程方法。

上個月,小哥在Dreamfield-Torch的基礎上做了colab版,本月在GitHub開源,讓大家能夠愉快地玩耍。

以及,現(xiàn)在這個已經(jīng)是基于Marching cubes的船新版本啦~

GitHub地址:https://github.com/shengyu-meng/dreamfields-3D

colab地址:https://colab.research.google.com/drive/1u5-zA330gbNGKVfXMW5e3cmllbfafNNB?usp=sharing#scrollTo=_VDLFG_gUEKa