超牛的NLP都在研究啥?統計400多篇頂會論文發現:統一泛化標準是關鍵

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

一篇NLP (自然語言處理)研究綜述文章火了。

根據paperswithcode統計,此文目前已經獲贊超800,轉發超200次。

來自Meta AI、亞馬遜、劍橋大學和紐約大學等的研究人員,針對NLP目前的最關鍵任務:泛化——

提出了一種分類評價系統,以解決目前圈內缺乏分類及評判體系的問題。

為此,他們對過去400多篇泛化相關論文進行分析與歸類,共進行600多個單獨實驗,通過回顧過去泛化相關的研究,也對未來提出更多展望。

此外,研究者們還自建了一個網站,便于泛化領域研究者們搜尋同行成果(鏈接已附在文末)。

目前,此項內容已在arxiv公布并被圈內研究者關注到。

有網友表示以往很難搜尋相關內容,向團隊表示致敬:

也有日本相關愛好者關注轉發:

所以,這篇綜述具體提出了些什么?

創立針對泛化的分類法

說研究成果前,先簡述下什么是泛化。

該任務可大致理解為根據過去經驗遷移到新任務、問題上的能力,按中學老師的口吻,也就是舉一反三的水平。

人們在日常組詞造句時其實都有一定的泛化傾向。比如,當你理解了“紅”可用于形容蘋果,自然就會說“紅番茄”、“紅草莓”等詞,但這對機器卻是個難題。

泛化能力還需依靠大量基本常識,否則詞匯自由組合難免會出現啼笑皆非的效果。比如“綠色吃小狗”、“量子位大于美女”……

玩笑歸玩笑,放NLP領域中,泛化的確一直被視為重點攻堅方向,不少從業者更將該能力視為通往AGI的關鍵。

但長期以來,對于NLP模型到底應該怎樣進行泛化操作,及評估其泛化性能的條件,卻鮮有一致的標準和意見,泛化行為一直被簡單地用“隨機訓練-測試分割”來評估。

在本篇文章中,研究者通過回顧過去數十年NLP領域泛化能力的成果,希望用一個系統來定義和討論泛化問題——

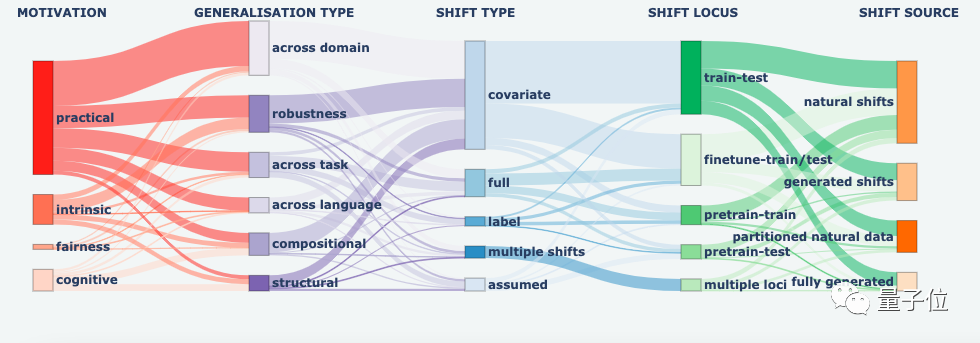

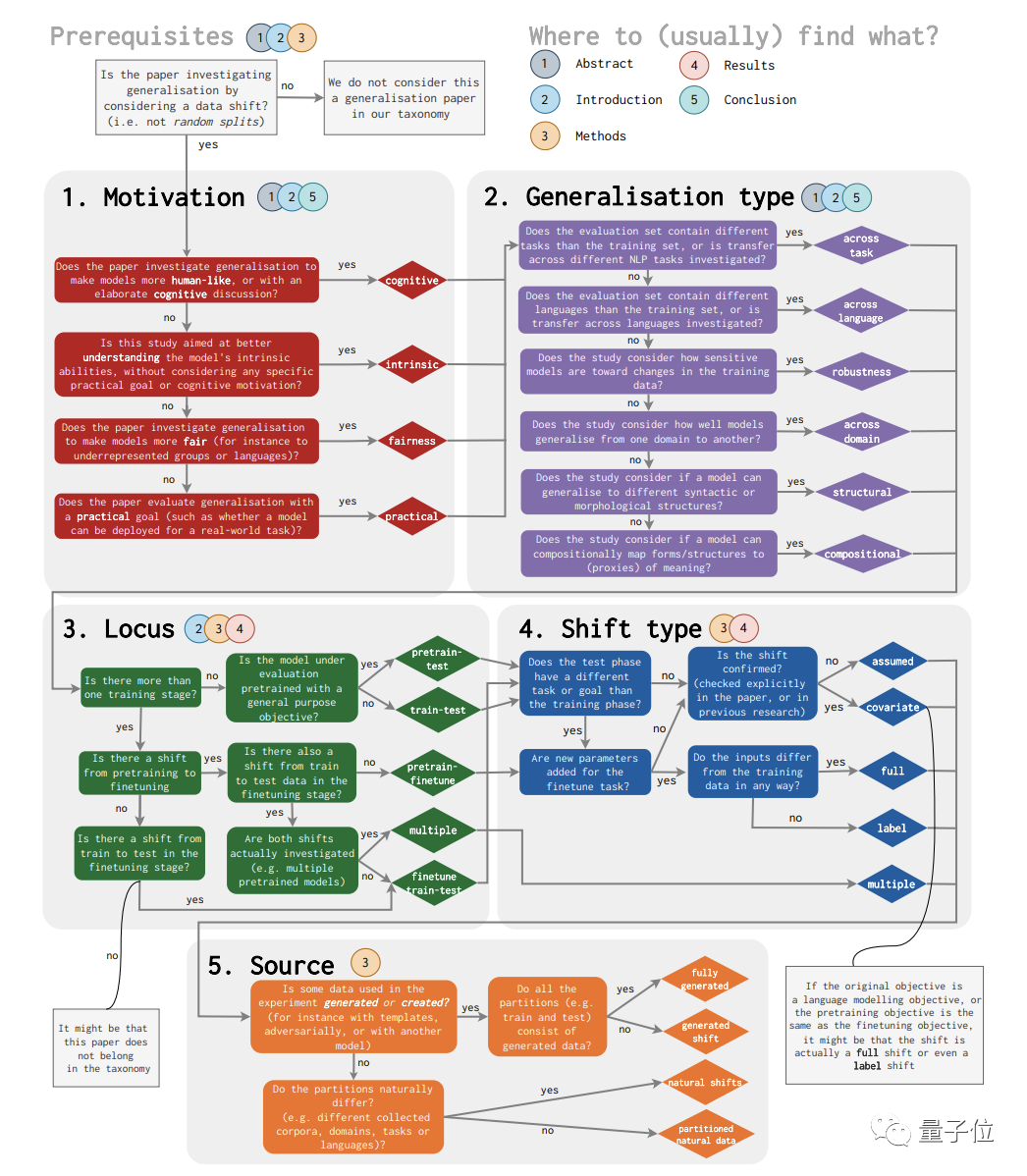

由此,他們提出了一套分類法,設計出五個維度供泛化領域的同行們參考:

(1)motivation 動機

(2)generalisation type 泛化類型

(3)shift type 偏移類型

(4)shift source 偏移源

(5)shift locus 偏移軌跡

還統計了哪些類型研究多,哪些類型相對小眾,以圖呈現(整得挺像樣):

下面來展開說說這些分類維度。

(1)動機 維度

所謂的動機維度,源于根據泛化任務的底層目的來對各種問題進行分類。

比如市面上主流泛化任務,意在提升模型的實用性,希望模型在經過某一類文本數據集訓練后,也能在其他場景給出合理回應并具備足夠的魯棒性,其動機在于提升實用性。

但有的泛化研究不聚焦實用場景,而是純粹就想拔升模型的認知能力,希望它具備更快學習的能力,此前有科學家研究LSTM如何優化嵌套語法結構,也是為該目的服務。

除此之外,動機維度還包括研究模型是否正確理解任務,是否在應用中保證公平和包容性。

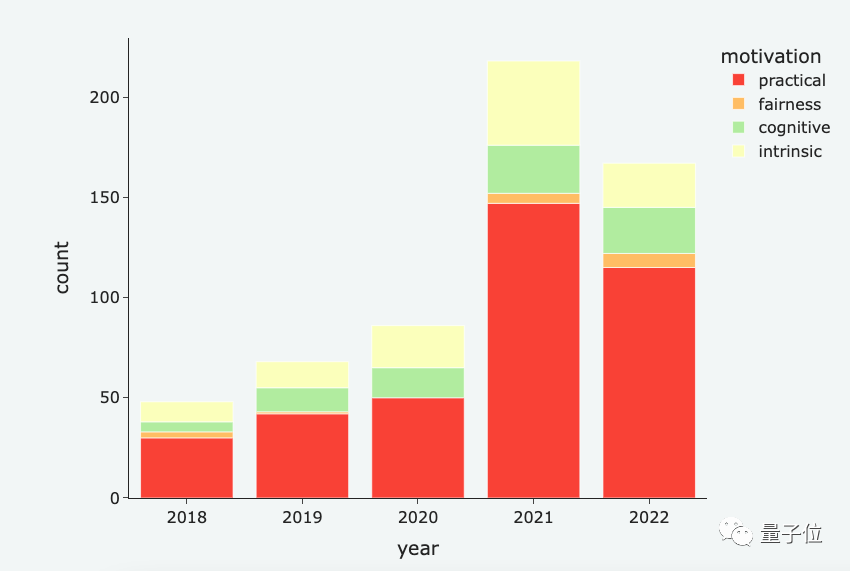

下圖展示了2018-2022年不同動機泛化研究的占比數量,其中實用性仍為大頭:

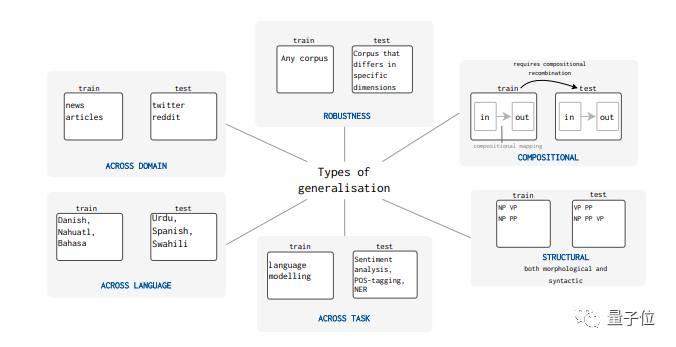

(2)泛化類型 維度

該維度從泛化任務的類型出發進行分類。

在實際研究中,有的泛化研究聚焦各種信息的重組結合,本文前面提及的「紅蘋果——>紅草莓」就屬于此類。

此外還有語句內容結構變化的泛化問題、跨不同任務之間的泛化、跨不同語言的泛化…都屬于從類型維度進行分類。

研究者們給出了6個類型的分類,情況如下:

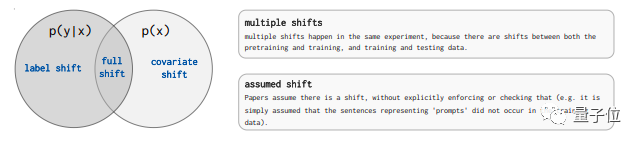

(3)偏移類型 維度

該維度從技術實現過程中分類,根據不同泛化任務中測試集、訓練集與預測結果各種變量概率分布的偏移情況,研究者分出3個主要類型:

協變量偏移、標簽偏移、全偏移。

這其中,協變量偏移在諸多研究中占比最多,這是由于訓練模型過程中,經常難以保證每次輸入滿足穩定分布,基于泛化任務定義,直觀也能想象此類情況發生不會少見。

除卻上述三種,研究人員還進一步加入了兩種偏移分類,即假設偏移和多重偏移。

(4)偏移源 維度

正如上段提到,泛化研究中變量偏移是普遍情況,研究者們又從造成偏移的源頭出發對不同研究進行了分類。

這其中包括了:自然產生偏移、訓練模型及調整語料庫等過程中人為造成的偏移、使用生成數據造成的偏移等類型。

值得一提的是,不同數據集之間自然產生的變量偏移占比最高。

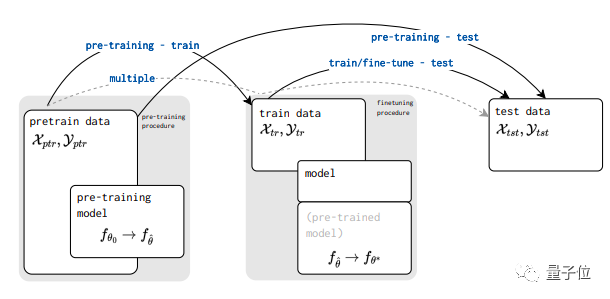

(5)偏移軌跡 維度

最后,研究者基于變量偏移發生的部位,提出一個新分類維度。

考慮從頭到尾整個模型訓練調參驗證步驟,變量概率分布發生偏移的位置有——

訓練到測試過程之間、微調到測試之間、預訓練到訓練過程之間、預訓練到測試過程之間以及整個流程發生多次偏移的情況。

這其中,早期研究論文發生變量偏移集中在訓練到測試過程中,但2020年后,更多偏移問題發生在微調到測試過程之間。

為NLP泛化測試統一標準打基礎

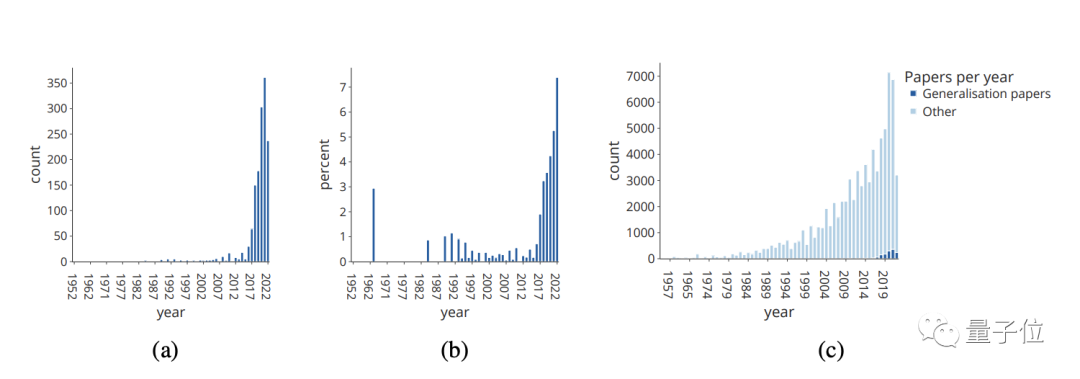

研究者分析發現,近幾年來,和泛化相關的論文數量飆升:

他們先用計算機從ACL(NLP與計算語言學領域頂會)文集中篩選出標題或摘要中包含generalisation、generalization、generalise或generalize等詞的論文。(這些詞都和“泛化”有關)

并人工檢查了被選出來的論文,以去除那些實際上并沒有展開講泛化問題的論文。

然后他們統計出這些論文的數量,以及其在每年的ACL總論文數中的占比。

結果顯示,這些論文不論是絕對數量還是相對占比都在大幅提升,而且從2018年起至今尤為明顯。

接下來,他們使用了前文介紹的分類法對這些論文進行注釋。

對每篇論文而言,第一位注釋者給其5個標簽,然后第二位注釋者將會檢查這些標簽。

如果這兩位注釋者之間產生了分歧,他們會先進行討論來試圖解決問題。如果這兩位沒法達成一致的話,這時第三位注釋者就會登場了。

不止上述一個步驟,整個注釋過程都相當嚴謹。(可以看看這張圖感受一下…)

經過細致的分類統計工作,結果顯示,跨領域的泛化問題是最被關注的,占比超過30%,其次是魯棒性和任務理解方面。

此外,超過一半的研究都碰到了自然造成的變量偏移問題,這也是相關從業者最關心的。

分類的意義不止于此。研究者通過這種方式提出一個新的框架來系統化和理解泛化研究,最終目的旨在為NLP的泛化測試建立可靠的統一標準奠定基礎。

他們相信,他們的系統性分類框架為泛化發展提供了必要基礎,為相關研究者提供了更有效的工具,幫助大家能快速找到可參考的相近成果。

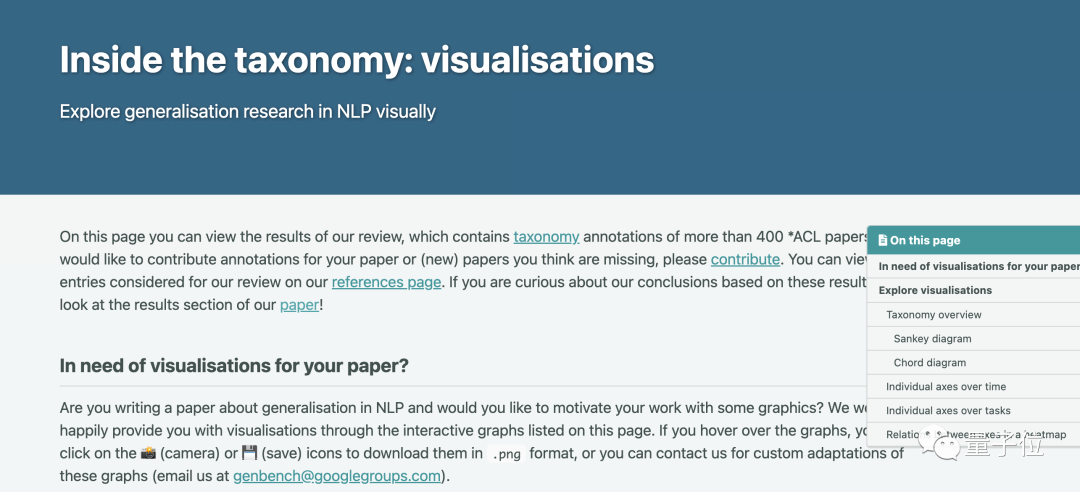

在發表本文的同時,這群研究人員還發布了一個網頁,并打算及時跟進NLP泛化研究的最新進展。

研究者指出,他們希望通過這些系統化的框架和這個在線工具,來盡可能地統一大伙兒對“NLP泛化測試”的理解,因為現有研究幾乎都處于“各抒己見”的狀態。

(畢竟這個領域的研究幾乎從2018年才活躍起來)

他們認為,關于NLP模型的重要泛化測試應該被托管在一個共享平臺上,同時還得有個排行榜,來使其更加方便和透明化。

在一個大型社區上(像GitHub這種),NLP研究人員和領域專家們共同探討并決定哪些測試應該優先進行。

當然,研究者們也明確表示,目前的工作還沒有為泛化測試提供標準化的數據或程序,這些還得一步步來。

研究者來自科技巨頭和頂尖大學

這篇綜述的作者可謂“群星璀璨”。

除了有來自Meta和亞馬遜等科技巨頭的研究員,還有來自愛丁堡大學、劍橋大學、NYU和香港科技大學等高校的學者。

論文一作Dieuwke Hupkes現任Meta AI的研究科學家,主要研究方向為用于NLP的人工神經網絡。

這些研究者補充道,下一步他們將會分析判定關于NLP的哪些泛化測試將優先進行。

他們指出,如果研究進展得比較順利的話,甚至在明年,關于NLP的泛化測試標準就會發生重大改變。

論文地址:https://arxiv.org/abs/2210.03050

網頁傳送門:

?https://genbench.github.io/visualisations