擊敗申真谞陪練的圍棋AI,卻輸給了業余人類棋手

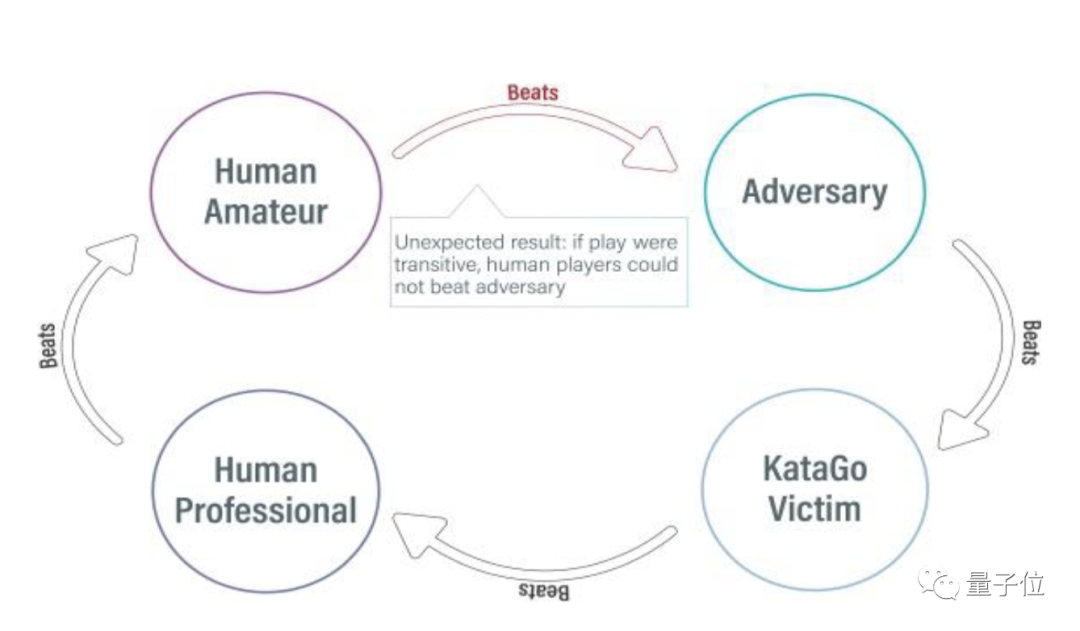

一個連業余棋手都打不過的新模型,竟然擊敗了世界最強圍棋AI——KataGo?

沒錯,這驚掉人下巴的結果來自MIT、UC伯克利等的最新論文。

研究人員利用對抗攻擊方法,抓住了KataGo的盲點,并基于該技術使一個菜鳥級圍棋程序成功打敗了KataGO。

在沒有搜索的情況下,這一勝率甚至達到了99%。

這么算下來,圍棋界的食物鏈瞬間變成了:業余棋手>新AI>頂級圍棋AI?

等等,這個神奇的新AI是怎么做到又菜又厲害的?

刁鉆的攻擊角度

在介紹新AI之前,讓我們先來了解一下這次被攻擊的主角——KataGo。

KataGo,目前最強大的開源圍棋AI,由哈佛AI研究員開發。

此前,KataGo戰勝了超人類水平的ELF OpenGo和Leela Zero,即使沒有搜索引擎的情況下,其水平也與歐洲前100名圍棋專業選手相當。

剛剛拿下三星杯冠軍、實現“三年四冠”的韓國圍棋“第一人”申真谞,就一直用的KataGo進行陪練。

△圖源:Hangame

面對實力如此強勁的對手,研究人員選擇的方法可以說是四兩撥千斤了。

他們發現,盡管KataGo通過與自己進行數百萬次游戲來學習圍棋,但這仍然不足以涵蓋所有可能的情況。

于是,這次他們不再選擇自我博弈,而是選擇對抗攻擊方法:

讓攻擊者(adversary)和固定受害者(victim,也就是KataGo)之間進行博弈,利用這種方式訓練攻擊者。

這一步改變讓他們僅用訓練KataGo時0.3%的數據,訓練出了一個端到端的對抗策略(adversarial policy)。

具體來說,該對抗策略并不是完全在做博弈,而是通過欺騙KataGo在對攻擊者有利的位置落子,以過早地結束游戲。

以下圖為例,控制著黑子的攻擊者主要在棋盤的右上角落子,把其他區域留給KataGo,并且還心機的在其他區域下了一些容易被清理的棋子。

論文共同一作Adam Gleave介紹:

這種做法會讓KataGo誤以為自己已經贏了,因為它的地盤(左下)比對手的要大得多。

但左下角的區域并沒有真正貢獻分數,因為那里仍留有黑子,這意味著它并不完全安全。

由于KataGo對勝利過于自信——認為如果游戲結束并計算分數自己就會贏——所以KataGo會主動pass,然后攻擊者也pass,從而結束游戲,開始計分。(雙方pass,棋就結束)

但正如Gleave分析的一樣,由于KataGo圍空中的黑子尚有活力,按照圍棋裁判規則并未被判定為“死子”,因此KataGo的圍空中有黑子的地方都不能被計算為有效目數。

因此最后的贏家并不是KataGo,而是攻擊者。

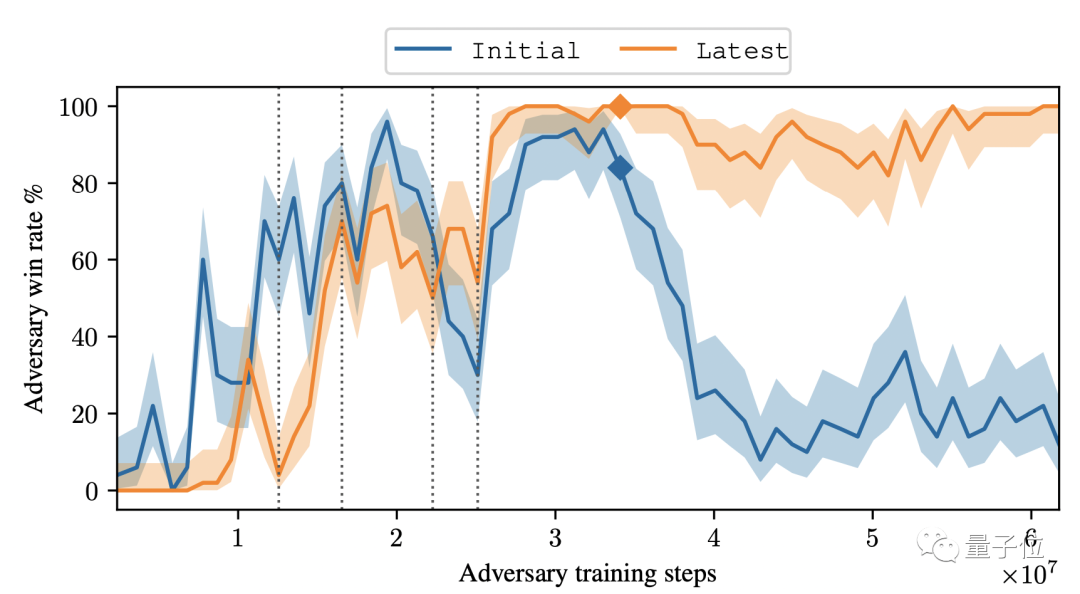

這一勝利并不是個例,在沒有搜索的情況下,該對抗策略對KataGo的攻擊達到了99%的勝率。

當KataGo使用足夠的搜索接近超人的水平時,他們的勝率達到了50%。

另外,盡管有這種巧妙的策略,但攻擊者模型本身的圍棋實力卻并不強:事實上,人類業余愛好者都可以輕松地擊敗它。

研究者表示,他們的研究目的是通過攻擊KataGo的一個意想不到的漏洞,證明即使高度成熟的AI系統也會存在嚴重的漏洞。

正如共同一作Gleave所說:

(這項研究)強調了對AI系統進行更好的自動化測試以發現最壞情況下的失敗模式的必要性,而不僅僅是測試一般情況下的性能。

研究團隊

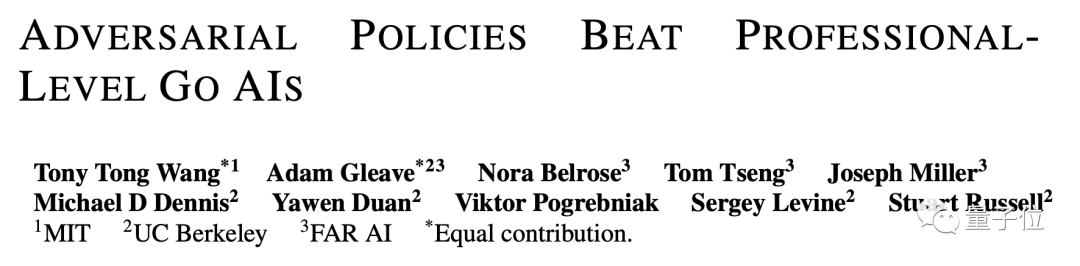

該研究團隊來自MIT、UC伯克利等,論文共同一作為Tony Tong Wang和Adam Gleave。

Tony Tong Wang,麻省理工學院計算機科學專業博士生,有過在英偉達、Genesis Therapeutics等公司實習的經歷。

Adam Gleave,加州大學伯克利分校人工智能博士生,碩士和本科畢業于劍橋大學,主要研究方向是深度學習的魯棒性。

論文的鏈接附在最后,感興趣的小伙伴們可以自取~

論文鏈接:https://arxiv.org/abs/2211.00241

參考鏈接:https://arstechnica.com/information-technology/2022/11/new-go-playing-trick-defeats-world-class-go-ai-but-loses-to-human-amateurs/