76小時動捕,最大規模數字人多模態數據集開源

隨著元宇宙的火爆以及數字人建模技術的商業化,AI 數字人驅動算法,作為數字人動畫技術鏈的下一關鍵環節,獲得了學界和工業界越來越廣泛的興趣和關注。其中談話動作生成 (由聲音等控制信號生成肢體和手部動作)由于可以降低 VR Chat, 虛擬直播,游戲 NPC 等場景下的驅動成本,在近兩年成為研究熱點。然而,由于缺乏開源數據,現有的模型往往在由姿態檢測算法提供的偽標簽數據集或者單個說話人的小規模動捕數據集上進行測試。由于數據量,數據標注的缺乏和數據質量的限制,現有的算法很難生成個性化,高手部質量,情感相關,動作 - 語義相關的動作。

針對上述問題,華為東京研究所 - Digital Human Lab 與東京大學等合作進行了研究,提出了目前為止最大規模的數字人多模態數據集:BEAT (Body-Expression-Audio-Text),由 76 小時動捕設備采集的談話數據和語義 - 情感標注組成。原始數據包含肢體和手部動捕數據,AR Kit 標準 52 維面部 blendshape 權重,音頻與文本,標注數據包含 8 類情感分類標簽,以及動作類型分類和語義相關度打分。在 BEAT 的基礎上提出的新基線模型 CaMN (Cascade-Motion-Network) 采取級聯神經網絡結構,由 BEAT 中其余三種模態和標注作為輸入,在動作生成任務上顯著優于現有 SoTA (state-of-the-art) 算法。論文《BEAT: A Large-Scale Semantic and Emotional Multi-Modal Dataset for Conversational Gestures Synthesis》已于 ECCV2022 上發表,數據集已經開源。

- 作者: Haiyang Liu, Zihao Zhu, Naoya Iwamoto, Yichen Peng, Zhengqing Li, You Zhou, Elif Bozkurt, Bo Zheng.

- 單位:Digital Human Lab - 華為東京研究所,東京大學,慶應大學,北陸先端科技大學.

- 論文地址:https://www.ecva.net/papers/eccv_2022/papers_ECCV/papers/136670605.pdf

- 項目主頁:https://pantomatrix.github.io/BEAT/

- 數據集主頁:https://pantomatrix.github.io/BEAT-Dataset/

- 視頻結果:https://www.youtube.com/watch?v=F6nXVTUY0KQ

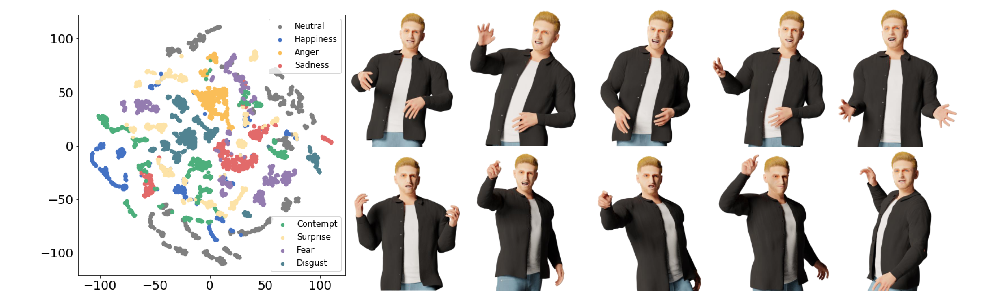

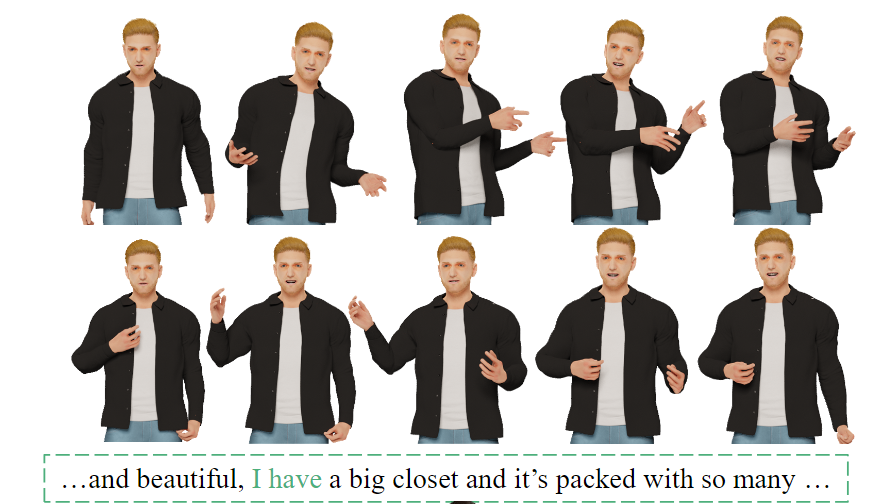

部分渲染后的數據如下(從上到下依次為,生氣 - 恐懼 - 驚訝 - 傷心情感下人的動作):

渲染結果使用了 HumanGeneratorV3 產生的身體和臉部模型。

BEAT 數據集細節

動作 - 文本語義相關度標注

談話動作生成領域的關鍵問題是:如何生成和評估生成的動作和文本在語義上的關聯程度。該關聯程度很大程度上影響了人對生成動作質量的主觀評價。由于缺乏標注,現有的研究往往挑選一系列主觀結果用于評估,增加了不確定性。在 BEAT 數據集中,對于動作給出了基于動作類別分類的相關度分數,共分為四類 10 檔:beat(1),deictic (2-4), icnoic(5-7),metaphoic(8-10)。該分類參考 McNeill 等人在 1992 年對談話動作的分類,其中后三類各自存在低 - 中 - 高質量三檔。

然而,實際談話中,與當前文本語義對應的動作可能提前或滯后出現,為了解決這個問題,在標注過程中,標注者判斷當前動作所屬類別之后:

1. 以動作的開始和結束確定標注范圍,保證了動作的完整性。

2. 輸入與當前動作最相關的關鍵字,獲取動作和對應文本的準確出現時間。

基于情感的對話

BEAT 數據集要求每個演講者必須錄制 8 種不同情緒下的談話動作,用于分析動作與情感之間的內在聯系。在演講環節中,自然情緒占比 51%,憤怒、快樂、恐懼、厭惡、悲傷、蔑視和驚訝這七類情緒分別占比 7%。對動作進行聚類的結果證明,動作和情感之間存在相關性,如下圖所示。

數據規模及采集細節

BEAT 采用了 ViCon,16 個攝像頭的動作捕捉系統來記錄演講和對話數據,最終所有數據以 120FPS, 記載關節點旋轉角的表示形式的 bvh 文件發布。對于面部數據,BEAT 采用 Iphone12Pro 錄制談話人的 52 維面部 blendsshape 權重,并不包括每個人的頭部模型,推薦使用 Iphone 的中性臉做可視化。BEAT 采用 16KHZ 音頻數據,并通過語音識別算法生成文本偽標簽,并依此生成具有時間標注的 TextGrid 數據。

BEAT 包含四種語言的數據:英語,中文,西班牙語,日語,數據量分別為 60,12,2,2 小時。由來自 10 個國家的 30 名演講者進行錄制。其中中文,西班牙語,日語的演講者也同時錄制了英語數據,用于分析不同語言下的動作差異。

在演講部分(數據集的 50%),30 個演講者被要求讀相同的大量文本,每段文本長度約 1 分鐘,總計 120 段文本。目的是控制文本內容相同來研究不同演講者之間的風格差異,來實現個性化的動作生成。談話部分(50%)演講者將和導演在給定話題下進行 10 分鐘左右的討論,但為了去除噪聲,只有演講者的數據被記錄。

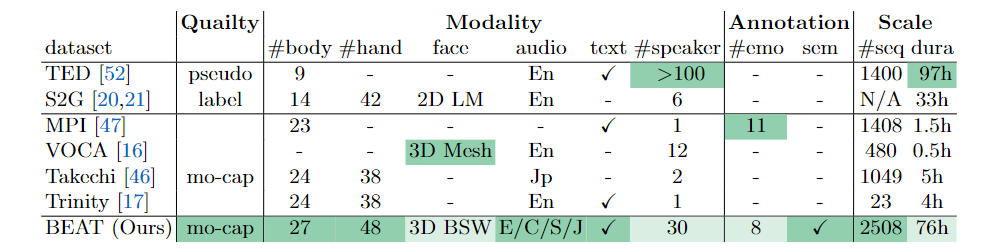

下表還將 BEAT 與現有的數據集進行了比較,綠色高光表示最佳值,可以看出,BEAT 是現階段包含多模態數據和標注的最大的運動捕捉數據集。

多模態驅動的動作生成基線模型

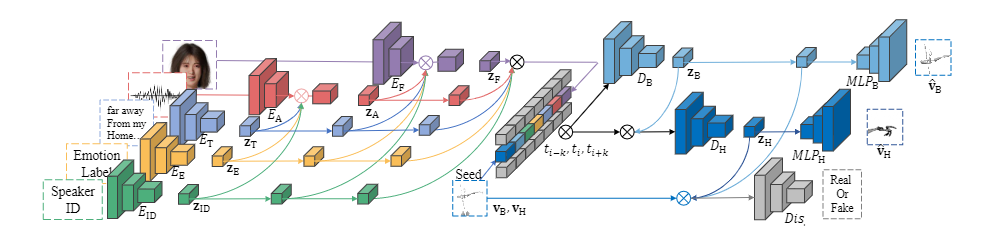

BEAT 提出了一個多模態驅動的動作生成基線模型,CaMN(Cascade Montion Network),將音頻 - 文本 - 面部數據以及情感,語義標注作為輸入,以生成更高質量的談話動作。網絡主干由多個級聯編碼器和兩個級聯 LSTM+MLP 解碼器組成,生成軀體和手部動作,數據被降頻到 15FPS,單詞句子被插入填充標記以對應音頻的沉默時間。具體的網絡結構如下圖所示。

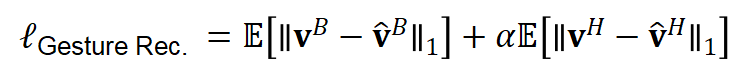

文本、語音和 Speaker-ID 編碼器的網絡選擇是基于現有研究,并針對 BEAT 數據集在結構上進行了修改。對于面部 blendshape weight 數據,采用了基于殘差網絡的一維 TCN 結構。最終網絡的損失函數來自語義標注權重和動作重建損失的組合:

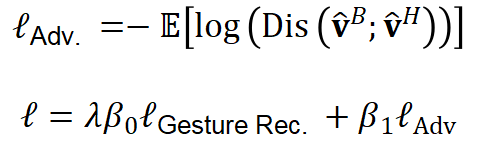

其中針對不同演講者的數據,網絡也采取了不同的對抗損失來輔助提升生成動作的多樣性。

實驗結果

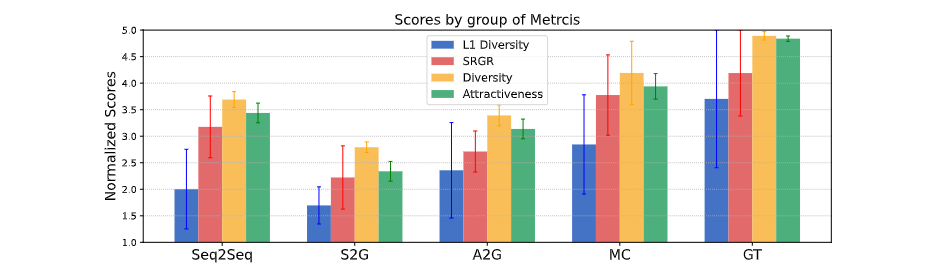

研究者首先驗證了一個新的評價指標 SRGR,然后基于主觀實驗驗證了 BEAT 的數據質量,并將提出的模型與現有的方法進行了比較。

SRGR 的有效性

為了驗證 SRGR 的有效性,研究者將動作序列被隨機切割成 40 秒左右的片段,要求參與者根據動作的正確性,多樣性和吸引力對每個片段進行評分。最終共有 160 人參與評分,平均每個人對 15 個隨機的手勢片段打分。圖表顯示,與 L1 多樣性相比,SRGR 在評估手勢多樣性方面與人類感官更為相似。

數據質量

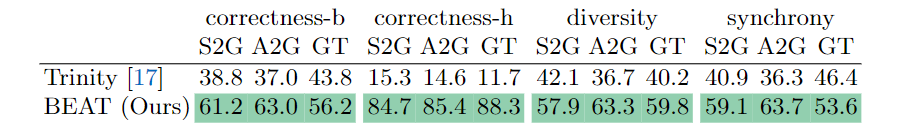

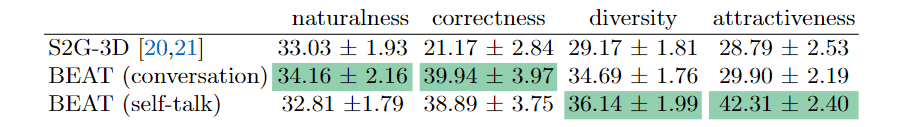

為了評估 BEAT 這一新型數據集的質量,研究者使用了現有研究中廣泛使用的動捕數據集 Trinity 作為對比目標。每個數據集被分成 19:2:2 的比例,分別作為訓練 / 驗證 / 測試數據,并使用現有方法 S2G 和 audio2gestures 進行比較。評估主要針對不同數據集訓練結果的正確性(身體動作的準確性)、手部正確性(手部動作的準確性)、多樣性(動作的多樣性)和同步性(動作和語音的同步性)。結果見下表。

表中顯示,BEAT 在各方面的主管評分都很高,表明這個數據集遠遠優于 Trinity。同時在數據質量上也超過了現有的視頻數據集 S2G-3D。

對 Baseline 模型的評價

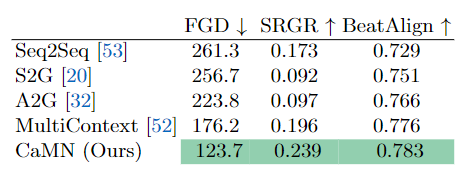

為了驗證本文提出的模型 CaMN 的性能,在以下條件下與現有方法 Seq2Seq,S2G,A2G 和 MultiContext 進行了比較驗證。一些實驗的細節如下:

- 使用數據集中四名演講者的數據進行 15 小時的訓練,選取不同模型在驗證集上最優的權重在測試集上測試。

- FGD 被采用為評價指標,因為已被證明 L1 損失不適合于評價生成動作的性能。

- 為了評估手勢的多樣性和與語音的同步性,研究者采用了本文提出的 SRGR 和舞蹈動作生成中常用的指數 BeatAlign。

驗證結果如下表所示,CaMN 在所有評價指標上得分最高。

下面是一個由 CaMN 生成的手勢的例子。

圖中展示了一個真實數據樣本(上)和一個 CaMN 生成的動作(下),生成的動作具備語義相關性。

總結

本文研究者提出大規模的多模態數字人驅動數據集 BEAT,用于生成更生動的談話動作。該數據集還可應用于數字人驅動的其他領域,如 LipSync,表情識別,語音風格轉換等等。