亞馬遜云科技:全面底層技術創新,持續優化云服務性價比

原創以往我們說,云計算顛覆性地改變了人類的生活和工作方式。現在,人們對于云計算性價比的追求越來越高。

企業用戶希望通過云來獲得更強的數據處理能力、更快的響應速度和更低的成本,且不增加能耗。如何實現“高性能、高安全性和低成本”一個都不能少呢?作為連續11年在云基礎設施和平臺服務Gartner魔力象限 (CIPS) 被評為領導者的廠商,亞馬遜云科技的看法是:芯片創新是最底層的創新,是最具顛覆性的創新,也是改變云計算游戲規則的能力。

亞馬遜全球副總裁、亞馬遜云科技大中華區執行董事張文翊曾表示,云計算技術和服務的實際效果,主要基于底層的性能。發生在底層的創新,往往是最具顛覆性的。系統架構和芯片這種底層的創新升級,不僅能讓客戶的云體驗有質的躍升,還能改變傳統IT行業的游戲規則。

第五代虛擬化芯片Nitro

首先,云服務的計算資源如何才能更好地滿足用戶的工作負載要求,讓用戶不必擔心云計算資源底層的網絡、存儲和安全控制的復雜性?Amazon Nitro就是亞馬遜云科技給出的最佳答案。

從2017年起,為了讓用戶的應用能夠獲得更佳的性能表現,亞馬遜云科技自研了Amazon Nitro 系統,將計算、存儲、網絡等傳統負載Offload到專屬硬件層面,大幅提升虛擬化及客戶實例的性能。Nitro系統全面提升EC2實例的安全表現,并能更好地提升計算、存儲和網絡的性能。Nitro系統還支持裸金屬EC2實例,能夠讓所有的服務器資源都充分調用到客戶的負載上去。

在日前召開的2022亞馬遜云科技 re:lnvent 全球大會上,Amazon Nitro v5重磅發布。與第四代相比,第五代Nitro芯片擁有兩倍的晶體管數量,兩倍的計算性能,兩倍的PCI-E帶寬,同時內存訪問速度提升50%。Nitro v5支持每秒增加60%的數據包,并減少30%的延遲,同時每瓦性能提升40%。第五代Nitro提供專門的I/O功能模塊,進一步降低EC2實例的性能負擔,從而將更多資源用于工作負載。

Amazon EC2 C7gn實例是首個基于Nitro v5的實例,為網絡密集型工作負載提供極佳性能,具有更高的網絡帶寬、更高的數據包轉發性能和更低的延遲。與當前一代網絡優化型實例C6gn相比,C7gn為每個CPU提供了多達2倍的網絡帶寬,從100Gbps提升至200Gbps,同時將每秒數據包轉發性能提升50%。

高性能計算服務器CPU芯片Graviton 3E

基于對客戶工作負載的深刻理解,亞馬遜云科技逆向設計了多種更具有針對性和特定性的自研芯片,不斷突破行業傳統認知和習慣,加速云計算產業的高速發展。比如基于ARM的Amazon Graviton自研芯片,就打破了傳統IT行業依賴獨立芯片制造商的格局。為進一步提升性能并降低成本,讓更多人有機會上云,亞馬遜云科技在去年推出了性能較前代提升25%,能耗降低60%的Graviton 3。而在今年的re:lnvent 全球大會上,亞馬遜云科技又推出了Amazon Graviton3E芯片。

Amazon Graviton3E是Gravtion3芯片的定制產品,針對高性能計算工作負載中常見的浮點和矢量運算進行了優化與Gravition3相比,Graviton3在線性代數運算基準測試HPL中性能提升35%;分子動力學測試Gromacs中性能提升12%;金融期權定價工作負載測試中性能提升30%。

Hpc7g實例采用了Graviton3E芯片,與采用Graviton2處理器的當前一代C6gn實例相比,Hpc7g實例的浮點性能提高了2倍,與當前一代Hpc6a實例相比性能提高了20%,讓客戶能夠在多達數萬個內核的高性能計算集群中進行復雜的計算。Hpc7g實例還提供高內存帶寬和200Gbps的EFA (Elastic Fabric Adapter,彈性結構適配器)網絡帶寬,可以更快的運行并完成高性能計算應用。客戶可以通過開源的集群管理工具Amazon ParallelCluster使用Hpc7g實例,與其它實例類型一起配置Hpc7g實例,這讓客戶在同一個高能性計算集群中靈活運行不同的工作負載類型。

AI推理芯片Inferentia和訓練芯片Trainium

除了 Amazon Graviton系列外,亞馬遜云科技還自研了面向機器學習推理和訓練的加速芯片Amazon Inferentia和Amazon Trainium,為客戶提供更好的性價比。

大型語言模型的出現推動深度學習進入了下一個階段,但龐大的參數量加大了推理所需的算力和成本。2019年,亞馬遜云科技的Inferentia芯片第一代出現在Inf1實例上,為用戶提供了性價比優于GPU實例的選項。當時深度學習模型大多是數百萬個,而如今某些深度學習模型的參數已經超過數百億,比如百度的PLATO-XL對話生成模型、亞馬遜的AlexaTM等。

為此,亞馬遜云科技推出了全新的Inferentia2芯片,最高可支持到1750億參數的大型深度學習模型。基于Inferentia2芯片的Inf2實例也首次支持分布式推理,將大型模型分布到多個芯片上進行推理。與上一代Inf1實例相比,Inf2可以提供高達4倍的吞吐量和十分之一的延遲,與GPU實例相比更是將能效提高了50%之多。

在AI大模型訓練中,從傳統的幾千參數的Backprop,到百萬級的Bert,十億級的GPT-3、PAML,甚至超大規模的Switch-C,都在對計算芯片提出新的需求,同時在數據網絡層面,計算芯片也正面臨著新的挑戰。

面向下一代計算、內存加速、并行訓練及低網絡延遲的AI 訓練需求,亞馬遜云科技推出了Trn1n實例,針對Trn1實例進行了網絡優化,增加了1600Gbps EFA 網絡功能,使之能夠更快地面對超大規模分布式模型訓練場景。

網絡協議再創新

為了改善高性能計算常用的EFA網絡接口性能、Amazon EBS塊存儲網絡性能,以及ENA網絡性能,亞馬遜云科技還對核心的底層SRD網絡協議進行了創新,同時基于SRD網絡協議正式推出了高速虛擬網卡ENA Express。

相比于傳統的 TCP 單路徑路由網絡,亞馬遜云科技自己的 SRD(Scalable Reliable Datagram )協議使用了多路徑路由,這項協議不按順序傳輸數據包,但可以在數據包亂序到達時進行整理。

SRD將“以微秒而不是毫秒”重新傳輸丟棄的數據包,并加速托管在亞馬遜云科技上的網絡。其性能優于TCP,因為它基于Nitro硬件進行了調整和優化,亞馬遜云科技通過 Nitro 系統將計算、網絡和存儲事務與主機隔離開來,以提升硬件性能。

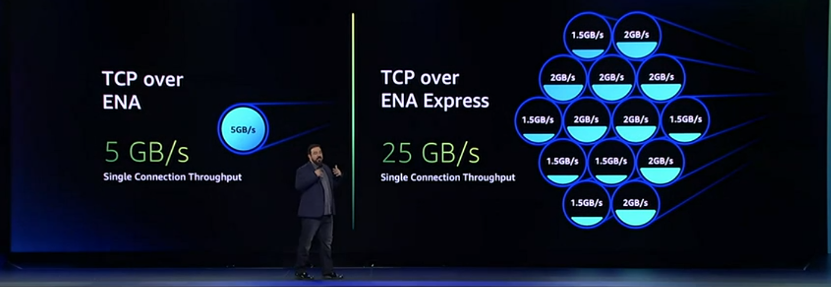

ENA Express以為 Elastic Fabric Adapters 提供支持的SRD協議為基礎,將流量的 P99 延遲減少了50%,將 P99.9 延遲減少85%(與 TCP 相比),同時還將最大單流帶寬從 5Gbps 到增加到了 25Gbps,可以獲得更多的每流帶寬和更少的可變性。

結語

在云計算新的發展階段,云基礎設施部署所依賴的芯片,已經成為了各大云廠商提升“內功”的必爭之地。亞馬遜云科技在虛擬化芯片Nitro、服務器芯片Graviton、AI/ML芯片三條產品線上持續發力,一次又一次地突破技術邊界,旨在不需要犧牲安全的情況下,減少成本,同時提高性能,讓客戶應用更好地在云上持續發展。