無需注意力的預訓練;被GPT帶飛的In-Context Learning

論文 1:ClimateNeRF: Physically-based Neural Rendering for Extreme Climate Synthesis

- 作者:Yuan Li等

- 論文地址:https://arxiv.org/pdf/2211.13226.pdf

摘要:本文介紹了一種將物理模擬與場景 NeRF 模型相融合的全新方法,生成這些場景中物理現象的逼真影片。就具體效果而言,該方法能夠逼真地模擬出氣候變化可能產生的影響 —— 在一場小范圍的洪水爆發后,操場會變成什么樣子?大洪水后呢?暴雪后呢?

推薦:一秒起霧、入冬、發洪水,新 NeRF 模型渲染出逼真物理大片。

論文 2:Pretraining Without Attention

- 作者:Junxiong Wang 等

- 論文地址:https://arxiv.org/pdf/2212.10544.pdf

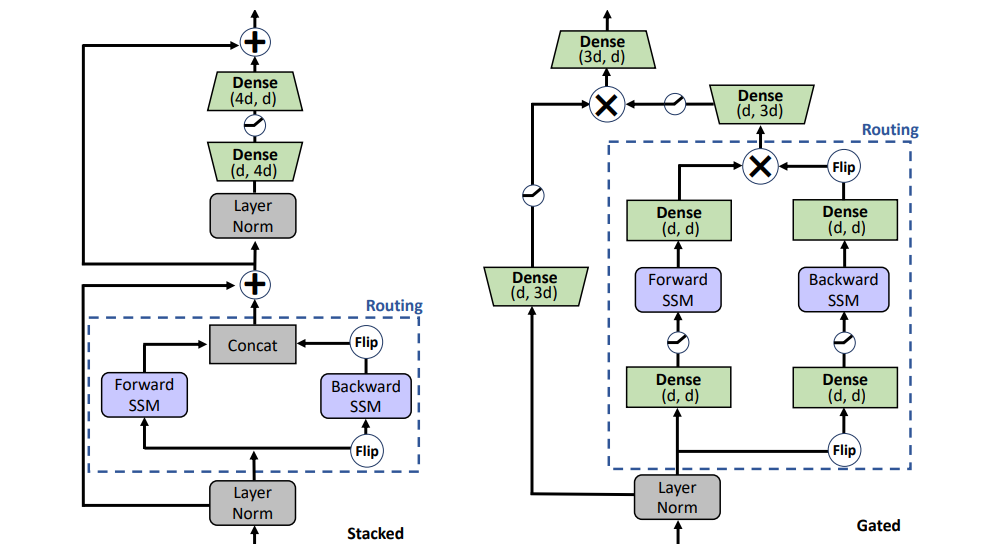

摘要:本文提出了雙向門控 SSM(BiGS)模型,結合基于狀態空間模型(SSM)的 Routing 層和基于乘法門的模型架構,在不使用注意力的情況下能夠復制 BERT 預訓練結果,并可擴展到 4096 個 token 的長程預訓練,不需要近似。

推薦:預訓練無需注意力,擴展到 4096 個 token 不成問題,與 BERT 相當。

論文 3:One Model to Edit Them All: Free-Form Text-Driven Image Manipulation with Semantic Modulations

- 作者:Yiming Zhu 等

- 論文地址:https://arxiv.org/pdf/2210.07883.pdf

摘要:最近用文本來引導圖像編輯取得了非常大的進展以及關注度,特別是基于去噪擴散模型如 StableDiffusion 或者 DALLE 等。但基于 GAN 的文本 - 圖像編輯依舊有一些問題等待解決,例如經典的 StyleCILP 中針對每一個文本必須要訓練一個模型,這種單文本對單模型的方式在實際應用中是不方便的。

本文提出 FFCLIP 并解決了這個問題,針對靈活的不同文本輸入,FFCLIP 只需要一個模型就能夠對圖片進行相應的編輯,無需針對每個文本重新訓練模型,并且在多個數據集上都取得了非常不錯的效果。本文已被 NeurIPS 2022 接收。

推薦:文本圖片編輯新范式,單個模型實現多文本引導圖像編輯。

論文 4:SELF-INSTRUCT: Aligning Language Model with Self Generated Instructions

- 作者:Yizhong Wang 等

- 論文地址:https://arxiv.org/pdf/2212.10560v1.pdf

摘要:華盛頓大學等機構近期聯合發表了一篇論文,提出的新框架 SELF-INSTRUCT 通過引導模型自己的生成過程,提高了預訓練語言模型的指令遵循能力。SELF-INSTRUCT 是一種半自動化過程,使用來自模型本身的指令信號對預訓練的 LM 進行指令調整。

推薦:無需人工標注,自生成指令框架打破 ChatGPT 等 LLM 的成本瓶頸。

論文 5:Ab Initio Calculation of Real Solids via Neural Network Ansatz

- 作者:Xiang Li 等

- 論文地址:https://www.nature.com/articles/s41467-022-35627-1

摘要:機器學習能夠處理海量數據,解決復雜場景下的科學難題,帶領科學探索抵達過去無法觸及的新領域。比如 DeepMind 用人工智能軟件 AlphaFold 對科學界已知的幾乎所有蛋白質結構進行了高度準確的預測;Christian Lagemann 提出的基于深度學習的粒子圖像測速 (PIV) 方法一改原本的純手動設置參數,大大提升模型的應用范圍,對汽車、航空航天和生物醫學工程等多個領域的研究具有至關重要的意義。

最近,字節跳動 AI Lab Research 團隊和北京大學物理學院陳基課題組的工作《 Ab initio calculation of real solids via neural network ansatz》 給出了研究凝聚態物理的新思路,該工作提出了業內首個適用于固體系統的神經網絡波函數,實現了固體的第一性原理計算,并將計算結果推向了熱力學極限。其有力地證明了神經網絡是研究固體物理的高效工具,也預示著深度學習技術將在凝聚態物理中發揮越來越重要的作用。相關研究成果于 2022 年 12 月 22 日發表于國際頂級刊物 Nature Communication 雜志上。

推薦:業界首個適用于固體系統的神經網絡波函數,登上 Nature 子刊。

論文 6:Why Can GPT Learn In-Context? Language Models Secretly Perform Gradient Descent as Meta-Optimizers

- 作者:Damai Dai 等

- 論文地址:https://arxiv.org/pdf/2212.10559v2.pdf

摘要:In-Context Learning(ICL)在大型預訓練語言模型上取得了巨大的成功,但其工作機制仍然是一個懸而未決的問題。本文中,來自北大、清華、微軟的研究者將 ICL 理解為一種隱式微調,并提供了經驗性證據來證明 ICL 和顯式微調在多個層面上表現相似。

推薦:被 GPT 帶飛的 In-Context Learning 為什么起作用?模型在秘密執行梯度下降。

論文 7:Experimental Indications of Non-classical Brain Functions

- 作者:Christian Matthias Kerskens 等

- 論文地址:https://iopscience.iop.org/article/10.1088/2399-6528/ac94be

摘要:幾十年來,科學家們一直在探索人腦的計算和思考機制。但人腦的構成太過復雜,包含幾百億個神經元,相當于上萬億塊芯片,我們很難一探究竟。因對黑洞的研究貢獻而獲得諾貝爾物理學獎的羅杰?彭羅斯曾大膽地提出「量子意識」觀點,即人腦本身就是量子結構,或者說是量子計算機。但這一觀點一直備受質疑。

近期都柏林圣三一大學的一項研究表明我們的大腦執行的是量子計算,該研究認為人腦中存在與意識相關的大腦功能介導的糾纏。如果這些大腦功能必須以非經典的方式運作,那么這意味著意識是非經典的,即大腦的認知過程涉及量子計算。

推薦:大腦的思考是量子計算,這一猜測有了新證據。

ArXiv Weekly Radiostation

機器之心聯合由楚航、羅若天發起的ArXiv Weekly Radiostation,在 7 Papers 的基礎上,精選本周更多重要論文,包括NLP、CV、ML領域各 10 篇精選,并提供音頻形式的論文摘要簡介,詳情如下:

10 NLP Papers音頻:00:0020:18?

本周 10 篇 NLP 精選論文是:

1. Does unsupervised grammar induction need pixels?. (from Serge Belongie, Kilian Q. Weinberger, Jitendra Malik, Trevor Darrell)

2. Understanding Stereotypes in Language Models: Towards Robust Measurement and Zero-Shot Debiasing. (from Bernhard Sch?lkopf)

3. Tackling Ambiguity with Images: Improved Multimodal Machine Translation and Contrastive Evaluation. (from Cordelia Schmid, Ivan Laptev)

4. Cross-modal Attention Congruence Regularization for Vision-Language Relation Alignment. (from Ruslan Salakhutdinov, Louis-Philippe Morency)

5. Original or Translated? On the Use of Parallel Data for Translation Quality Estimation. (from Dacheng Tao)

6. Toward Human-Like Evaluation for Natural Language Generation with Error Analysis. (from Dacheng Tao)

7. Can Current Task-oriented Dialogue Models Automate Real-world Scenarios in the Wild?. (from Kyunghyun Cho)

8. On the Blind Spots of Model-Based Evaluation Metrics for Text Generation. (from Kyunghyun Cho)

9. Beyond Contrastive Learning: A Variational Generative Model for Multilingual Retrieval. (from William W. Cohen)

10. The Impact of Symbolic Representations on In-context Learning for Few-shot Reasoning. (from Li Erran Li, Eric Xing)

10 CV Papers音頻:00:0023:15?

本周 10 篇 CV 精選論文是:

1. Revisiting Residual Networks for Adversarial Robustness: An Architectural Perspective. (from Kalyanmoy Deb)

2. Benchmarking Spatial Relationships in Text-to-Image Generation. (from Eric Horvitz)

3. A Brief Survey on Person Recognition at a Distance. (from Rama Chellappa)

4. MetaCLUE: Towards Comprehensive Visual Metaphors Research. (from Leonidas Guibas, William T. Freeman)

5. Aliasing is a Driver of Adversarial Attacks. (from Antonio Torralba)

6. Reversible Column Networks. (from Xiangyu Zhang)

7. Hi-LASSIE: High-Fidelity Articulated Shape and Skeleton Discovery from Sparse Image Ensemble. (from Ming-Hsuan Yang)

8. Learning Object-level Point Augmentor for Semi-supervised 3D Object Detection. (from Ming-Hsuan Yang)

9. Unleashing the Power of Visual Prompting At the Pixel Level. (from Alan Yuille)

10. From Images to Textual Prompts: Zero-shot VQA with Frozen Large Language Models. (from Dacheng Tao, Steven C.H. Hoi)