LLM | Yuan 2.0-M32:帶注意力路由的專家混合模型

圖片

圖片

一、結論寫在前面

Yuan 2.0-M32,其基礎架構與Yuan-2.0 2B相似,采用了一個包含32位專家的專家混合架構,其中2位專家處于活躍狀態。提出并采用了一種新的路由網絡——注意力路由器,以更高效地選擇專家,相比采用經典路由網絡的模型,其準確率提升了3.8%。Yuan 2.0-M32從零開始訓練,使用了2000B的token,其訓練計算消耗僅為同等參數規模密集模型的9.25%。

Yuan 2.0-M32在編碼、數學及多個專業領域展現了競爭力的能力,僅使用了400億總參數中的37億活躍參數,以及每token7.4 GFlops的前向計算,這兩項指標均僅為Llama3-70B的1/19。Yuan 2.0-M32在MATH和ARC-Challenge基準測試中超越了Llama3-70B,準確率分別達到55.89%和95.8%。Yuan 2.0-M32的模型及源代碼已在GitHub:https://github.com/IEIT-Yuan/Yuan2.0-M32。

二、論文的簡單介紹

2.1 論文的背景

在每個token固定計算量的情況下,采用專家混合(MoE)結構的模型可以通過增加專家數量輕松構建得比密集模型更大規模,從而實現更高的準確性表現。實際上,通常在有限的計算資源下訓練模型,MoE被視為減少與模型、數據集規模和有限計算能力相關的巨大成本的良好候選方案。

MoE的概念可追溯至1991年。總損失是每個專家加權損失的組合,這些專家具有獨立判斷的能力。稀疏門控MoE的概念最初由Shazeer等人(2017年)在翻譯模型中提出。采用這種路由策略,推理時只有極少數專家被激活,而非所有專家同時被調用。這種稀疏性使得模型能夠在計算效率損失極小的情況下,在堆疊的LSTM層之間擴展至1000倍。噪聲可調的Top-K門控路由網絡向softmax函數引入可調噪聲并保持前K值,以平衡專家利用率。近年來,隨著模型規模的不斷擴大,路由策略在高效分配計算資源方面的作用受到了更多關注。

專家路由網絡是MoE結構的核心。該結構通過計算token分配給每個專家的概率來選擇參與計算的候選專家。目前,在大多數流行的MoE結構中,普遍采用經典路由算法,該算法執行token與每個專家特征向量之間的點積,并選擇點積值最大的專家。在這種變換中,專家的特征向量是獨立的,忽略了專家之間的相關性。然而,MoE結構通常每次選擇不止一個專家,并且多個專家經常協同參與計算,這意味著專家之間應存在固有相關性。如果在選擇專家的過程中考慮專家間的關系,無疑會提高模型的準確性。

2.2 論文的方法

2.2.1模型架構

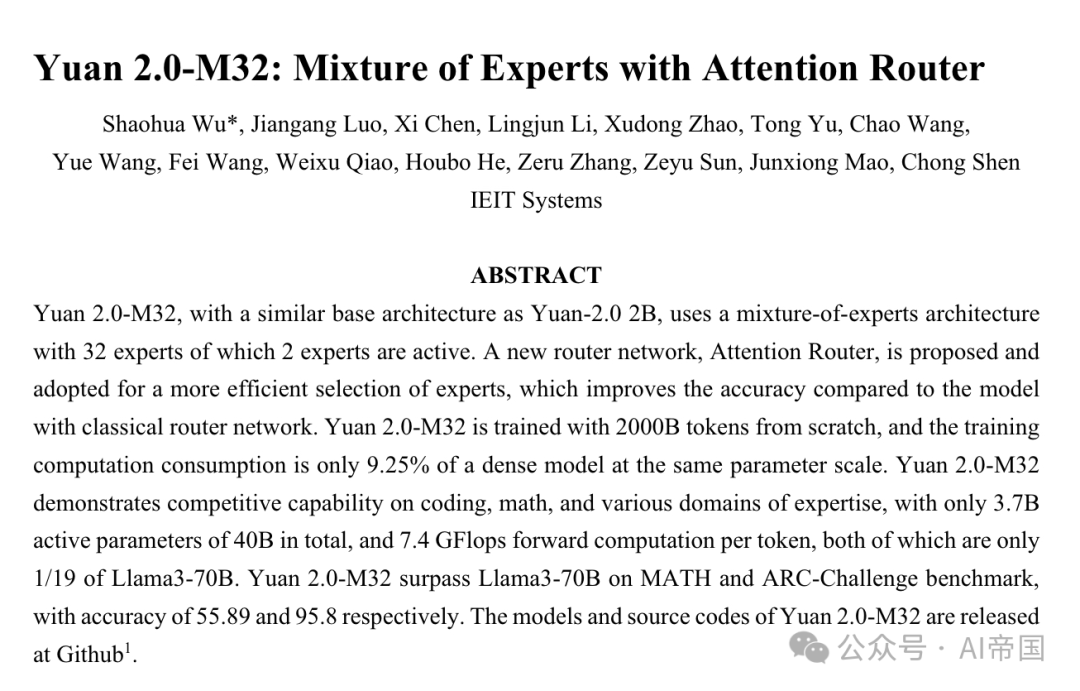

Yuan 2.0-M32 基于 Yuan 2.0-2B 的模型結構。Yuan 2.0 引入了基于局部過濾的注意力(LFA)以考慮輸入token的局部依賴性,從而提高模型的準確性。在 Yuan 2.0-M32 中,每一層的密集前饋網絡(FFN)被替換為 MoE 組件。

圖1展示了論文模型中應用的MoE層的架構。以四個FFN為例(實際上有32個專家),每個MoE層由一組獨立的FFN作為專家組成。位于專家之前的路由網絡將輸入token分派給相關的專家。經典的路由網絡本質上為每個專家建立了一個特征向量,并計算輸入token與每個專家特征向量之間的點積,以獲得token與專家之間的具體似然度。具有最強似然度的專家被選中激活,并參與后續的計算。

圖片

圖片

圖1:Yuan 2.0-M32的說明。左側圖展示了Yuan 2.0架構中MoE層的擴展情況。MoE層替代了Yuan 2.0中的前饋層。右側圖展示了MoE層的結構。在論文的模型中,每個輸入token將被分配給總共32個專家中的2個,而在圖中論文以4個專家為例進行展示。MoE的輸出是所選專家的加權和。N表示層的數量  圖2展示了注意力路由器結構的概覽

圖2展示了注意力路由器結構的概覽

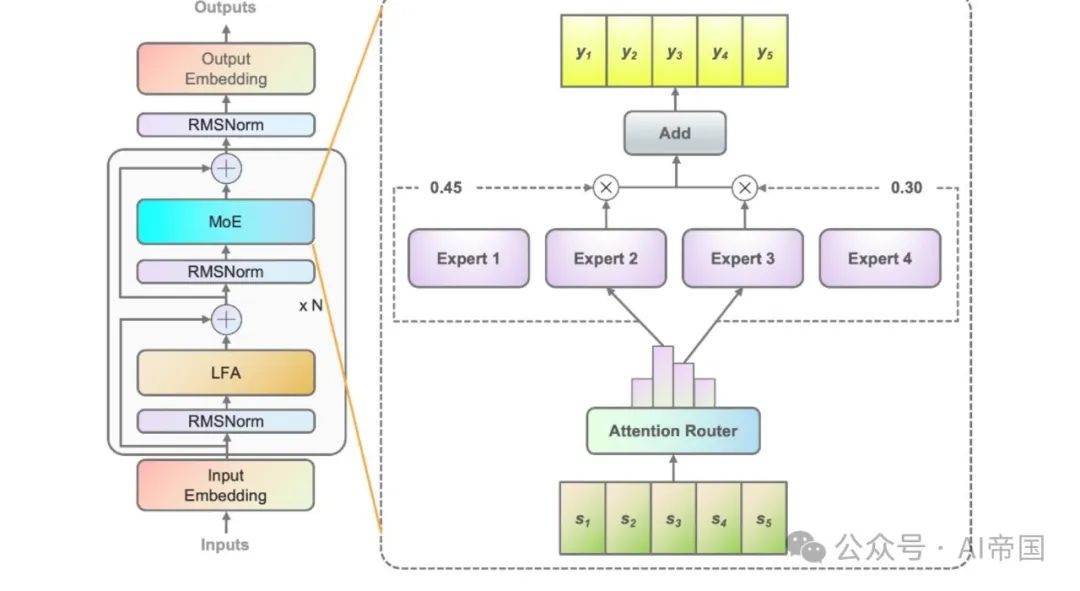

圖2(a)展示了經典路由網絡的結構。每個專家的特征向量彼此獨立,計算概率時忽略了專家之間的相關性。實際上,在大多數MoE模型中,通常會選擇兩個或更多的專家參與后續計算,這自然帶來了專家間的強相關性。考慮專家間的相關性無疑有助于提高準確性。

圖2(b)展示了本工作提出的注意力路由器的架構,該新穎的路由網絡通過采用注意力機制來整合專家間的相關性。構建了一個表示專家間相關性的系數矩陣,并應用于最終概率值的計算中。

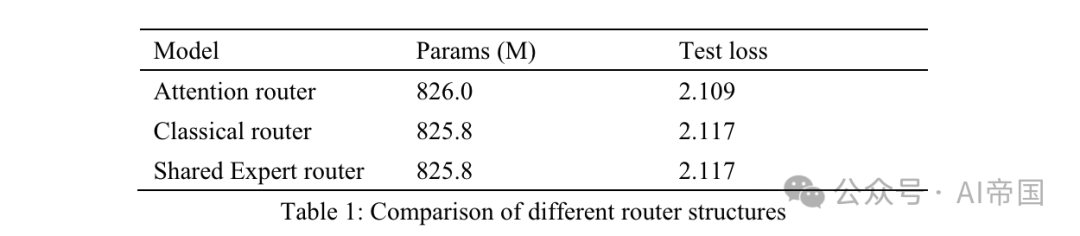

表1:不同路由結構的比較

表1:不同路由結構的比較

表1列出了不同路由器的準確性結果。論文的模型在8個可訓練專家上測試了注意力路由器。經典路由器模型有8個可訓練專家,以確保相似的參數規模,并且路由結構與應用于Mixtral 8*7B的結構相同,即一個線性層上的Softmax。共享專家路由器采用共享專家隔離策略與經典路由架構。有兩個固定專家捕捉通用知識,以及14個可選專家中前兩名作為專業專家。

MoE的輸出是固定專家和路由器選出的專家的組合。所有三個模型都使用30Btoken進行訓練,并使用另外10Btoken進行測試。考慮到經典路由器和共享專家路由器之間的結果,論文發現后者在訓練時間增加了7.35%的情況下獲得了完全相同的測試損失。共享專家的計算效率相對較低,并沒有帶來比經典MOE策略更好的訓練準確性。因此,在論文的模型中,論文采用了不帶任何共享專家的經典路由策略。與經典路由網絡相比,注意力路由器的測試損失提高了3.8%。

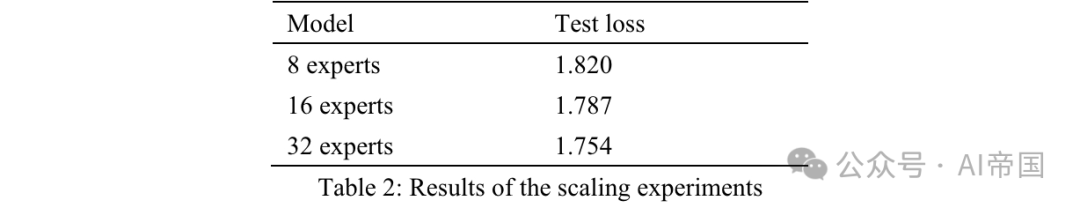

論文通過增加專家數量并固定每個專家的參數大小來測試模型的可擴展性。訓練專家數量的增加僅改變模型容量,而不改變實際激活的模型參數。所有模型均使用500億個token進行訓練,并使用另外的100億個token進行測試。論文將激活的專家設置為2,三個模型的訓練超參數相同。專家擴展效果通過訓練500億個token后的測試損失來衡量(表2)。與具有8個可訓練專家的模型相比,具有16個專家的模型顯示出2%的損失降低,而具有32個專家的模型顯示出3.6%的損失降低。考慮到其準確性,論文為Yuan 2.0-M32選擇了32個專家。

表2:擴展實驗結果

表2:擴展實驗結果

2.2.2 模型訓練

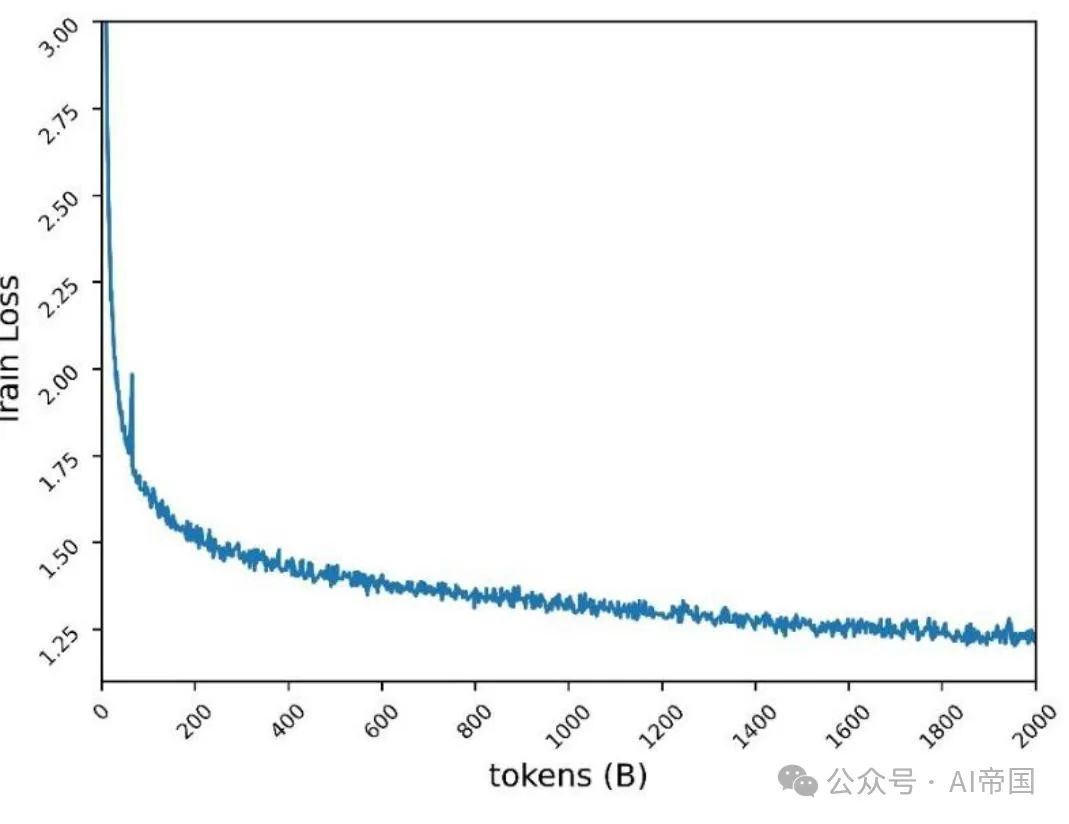

Yuan 2.0-M32通過數據并行和流水線并行的組合進行訓練,但不使用張量并行或優化器并行。圖3展示了損失曲線,最終訓練損失為1.22。

圖3:Yuan2.0-M32在2000Btoken上的預訓練損失

圖3:Yuan2.0-M32在2000Btoken上的預訓練損失

2.2.3 微調

在微調過程中,論文將序列長度擴展至16384。遵循CodeLLama(Roziere et al., 2023)的工作,論文重置旋轉位置嵌入(RoPE)的基頻值,以避免隨著序列長度增加,注意力分數的衰減。論文沒有簡單地將基值從1000增加到一個非常大的值(例如1000000),而是使用NTK感知(bloc97, 2023)計算新的基值。

論文還比較了預訓練的Yuan 2.0-M32模型與NTK感知風格的新基值,以及與其他基值在序列長度高達16K的針檢索任務中的性能。論文發現NTK感知風格的新基值40890表現更好。因此,在微調過程中應用了40890。

2.2.4 預訓練數據集

Yuan 2.0-M32 從零開始使用包含 2000B token 的雙語數據集進行預訓練。預訓練的原始數據包含超過 3400B token,并根據數據質量和數量調整每個類別的權重。

綜合預訓練語料庫由以下內容組成:

44個子數據集,涵蓋了網絡爬取數據、維基百科、學術論文、書籍、代碼、數學和公式以及特定領域的專業知識。其中一些是開源數據集,其余由Yuan 2.0創建。

部分常見的網絡爬蟲數據、中文書籍、對話及中文新聞數據繼承自 Yuan 1.0(吳等人,2021年)。Yuan 2.0 中的大部分預訓練數據也得到了重新利用。

關于每個數據集的構建和來源的詳細信息如下:

網絡(25.2%):網站爬蟲數據是從開源數據集和論文之前工作(Yuan 1.0)中處理過的公共爬蟲數據中收集的。關于從網絡上下文中提取高質量內容的Massive Data Filtering System(MDFS)的更多詳情,請參考Yuan 1.0。

百科全書(1.2%)、論文(0.84%)、書籍(6.49%)和翻譯(1.1%):數據繼承自Yuan 1.0和Yuan 2.0數據集。

代碼(47.5%):與Yuan 2.0相比,代碼數據集得到了極大的擴展。論文采用了Stack v2(Lozhkov等人,2024年)中的代碼。Stack v2中的注釋被翻譯成中文。通過與Yuan 2.0相似的方法生成了代碼合成數據。

數學(6.36%):所有來自Yuan 2.0的數學數據都被重新使用。這些數據主要來自開源數據集,包括proof-pile vl(Azerbayev,2022年)和v2(Paster等人,2023年),AMPS(Hendrycks等人,2021年),MathPile(Wang,Xia和Liu,2023年)以及StackMathQA(Zhang,2024年)。使用Python創建了一個數值計算的合成數據集,以利于四則運算。

特定領域(1.93%):這是一個包含不同背景知識的數據集。

2.2.5 微調數據集

微調數據集基于Yuan 2.0中應用的數據集進行了擴展。

代碼指令數據集。所有帶有中文指令及部分帶有英文注釋的編程數據均由大型語言模型(LLMs)生成。約30%的代碼指令數據為英文,其余為中文。合成數據在提示生成和數據清洗策略上模仿了帶有中文注釋的Python代碼。

帶有英文注釋的Python代碼收集自Magicoder-Evol-Instruct-110K和CodeFeedback-Filtered-Instruction。從數據集中提取帶有語言標簽(如“python”)的指令數據。

其他如C/C++/Go/Java/SQL/Shell等語言的代碼,帶有英文注釋,源自開源數據集,處理方式與Python代碼類似。清洗策略與Yuan 2.0中的方法相似。設計了一個沙箱以提取生成的代碼中可編譯和可執行的行,并保留至少通過一個單元測試的行。

數學指令數據集。數學指令數據集全部繼承自Yuan 2.0中的微調數據集。為提高模型通過編程方法解決數學問題的能力,論文構建了Thoughts(PoT)提示的數學數據。PoT將數學問題轉換為使用Python進行計算的代碼生成任務。

安全指令數據集。除了元2.0的聊天數據集外,論文還基于一個開源的安全對齊數據集構建了一個雙語安全對齊數據集。論文僅從公共數據集中提取問題,并增加問題的多樣性,利用大型語言模型重新生成中文和英文答案。

2.2.6 Tokenizer

對于 Yuan 2.0-M32,英文和中文分詞器繼承自 Yuan 2.0 中應用的分詞器。

2.3 論文的效果

論文在HumanEval上評估了Yuan 2.0-M32的代碼生成能力,在GSM8K和MATH上評估了數學問題解決能力,在ARC上評估了科學知識和推理能力,并在MMLU上作為一個綜合基準進行評估。

2.3.1 代碼生成

代碼生成能力的評估使用HumanEval基準。評估方法和提示與元2.0中提到的相似。

表3:Yuan 2.0-M32與其他模型在HumanEval pass @1上的比較

表3:Yuan 2.0-M32與其他模型在HumanEval pass @1上的比較

模型預期在后完成函數。生成的函數將通過單元測試進行評估。表3展示了Yuan 2.0-M32在零樣本學習中的結果,并與其它模型進行了比較。Yuan 2.0-M32的結果僅次于DeepseekV2和Llama3-70B,并且遠超其他模型,即使其活躍參數和計算消耗遠低于其他模型。

與DeepseekV2相比,論文的模型使用的活躍參數不到其四分之一,每token的計算量不到其五分之一,同時達到了其超過90%的準確度水平。與Llama3-70B相比,模型參數和計算量的差距更大,論文仍能達到其91%的水平。Yuan 2.0-M32展示了可靠的編程能力,通過了四分之三的問題。Yuan 2.0-M32擅長小樣本學習,通過14次嘗試將HumanEval的準確率提高到78.0。

2.3.2 數學

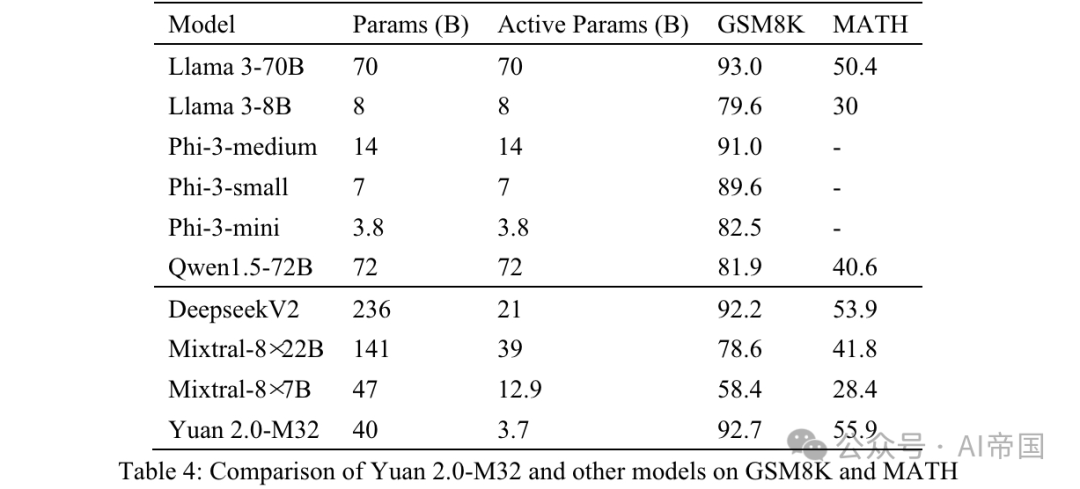

Yuan 2.0-M32的數學能力通過GSM8K和MATH基準進行評估。GSM8K的提示和測試策略與應用于Yuan 2.0的相似,唯一不同的是論文使用8次嘗試(表4)。

表4:Yuan 2.0-M32與其他模型在GSM8K和MATH上的比較

表4:Yuan 2.0-M32與其他模型在GSM8K和MATH上的比較

MATH是一個包含12,500個挑戰性數學競賽問答問題的數據集。該數據集中的每個問題都有一個完整的逐步解決方案,引導模型生成答案推導和解釋。問題的答案可以是數值,或數學表達式(如y=2x+5,x-+2x-1,2a+b等)。Yuan 2.0-M32使用鏈式思維(CoT)方法,通過4次嘗試生成最終答案。答案將從分析中提取并轉換為統一格式。

對于數值結果,所有格式的數學等價輸出均被接受。例如,分數1/2,12,0.5,0.50都轉換為0.5并被視為相同結果。對于數學表達式,論文移除制表符和空格符號,并統一了節奏或音符的正則表達式。55 '5'均被接受為相同答案。處理后的最終結果與標準答案進行比較,并使用EM(精確匹配)分數進行評估。

從表4所示的結果可以看出,Yuan 2.0-M32在MATH基準上得分最高。與Mixtral-8x7B相比,后者活躍參數是Yuan 2.0-M32的3.48倍,但Yuan的得分幾乎是其兩倍。在GSM8K上,Yuan 2.0-M32的得分也非常接近Llama 3-70B,并優于其他模型。

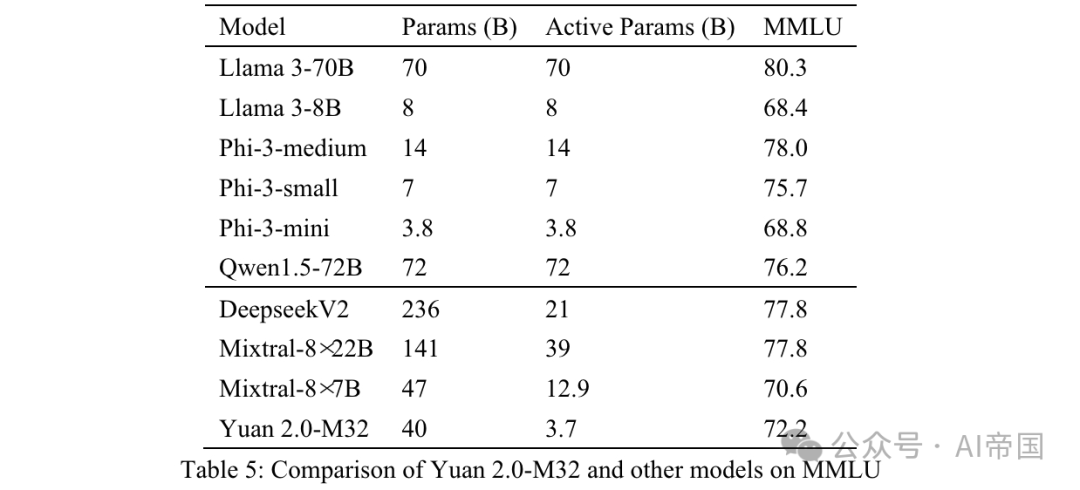

2.3.3MMLU

大規模多任務語言理解(MMLU)涵蓋了STEM、人文科學、社會科學等57個學科,從基礎語言任務到高級邏輯推理任務不等。MMLU中的所有問題都是英語的多選QA問題。模型預期生成正確的選項或相應的分析。

Yuan 2.0-M32的輸入數據組織如附錄B所示。之前的文本被發送給模型,所有與正確答案或選項標簽相關的答案被視為正確。

最終準確性通過MC1(表5)進行衡量。MMLU上的結果展示了論文模型在不同領域的能力。Yuan 2.0-M32在性能上超過了Mixtral-8x7B、Phi-3-mini和Llama 3-8B。

表5:Yuan 2.0-M32與其他模型在MMLU上的比較

表5:Yuan 2.0-M32與其他模型在MMLU上的比較

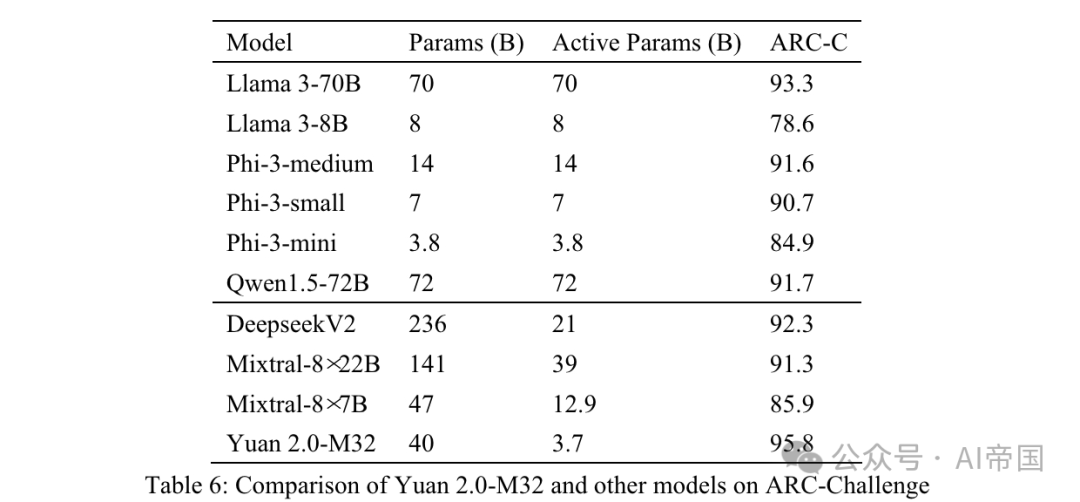

2.3.4 ARC

AI2推理挑戰(ARC)基準是一個多選QA數據集,包含從3年級到9年級科學考試的問題。它分為簡單和挑戰兩部分,后者包含需要進一步推理的更復雜部分。論文在挑戰部分測試論文的模型。

表 6:Yuan 2.0-M32 與其他模型在 ARC-Challenge 上的比較

表 6:Yuan 2.0-M32 與其他模型在 ARC-Challenge 上的比較

問題和選項直接連接并用 分隔。 之前的文本發送給模型,模型預期生成一個標簽或相應的答案。生成的答案與真實答案進行比較,結果使用 MC1 目標計算。

表 6 顯示的結果 ARC-C 表明,Yuan 2.0-M32 在解決復雜科學問題方面表現出色——它在這一基準上超越了 Llama3-70B。

圖片

圖片

表 7:Yuan 2.0-M32 與其他模型在質量與大小上的比較。平均準確度是根據 GSM-8K、Math、Humaneval、MMLU 和 ARC-C 的分數平均得出的

論文將論文的性能與三種MoE模型(Mixtral家族、Deepseek)和六種密集模型(Qwen(Bai等,2023)、Llama家族和Phi-3家族(Abdin等,2024))進行比較,以評估Yuan 2.0-M32在不同領域的性能。表7展示了Yuan 2.0-M32與其他模型在準確度與計算量之間的比較。Yuan 2.0-M32僅使用3.7B活躍參數和每token 22.2 GFlops進行微調,這是最經濟的,以獲得與表中列出的其他模型相當甚至超越的結果。表7暗示了論文模型在推理過程中的卓越計算效率和性能。Yuan 2.0-M32的平均準確度為79.15,與Llama3-70B相當。而平均準確度/每token GFlops的值為10.69,是Llama3-70B的18.9倍。

論文標題:Yuan 2.0-M32: Mixture of Experts with Attention Router

論文鏈接:https://arxiv.org/pdf/2405.17976