首個(gè)3D人像視頻生成模型來(lái)了:僅需1張2D人像,眨眼、口型都能改變

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

只需1張普通照片,就能合成全角度動(dòng)態(tài)3D視頻。

眨個(gè)眼、動(dòng)動(dòng)嘴,都是小case~

最近AIGC爆火,3D人像模型生成這邊也沒(méi)閑著。

如StyleNerf、StyleSDF、EG3D等方法相繼出世。

但到目前為止,這種生成模型都還停留在單幀人像上。

最近,來(lái)自新加坡國(guó)立大學(xué)(NUS)和字節(jié)跳動(dòng)的研究人員,在靜態(tài)3D模型的基礎(chǔ)上,提出了首個(gè)3D人像視頻生成模型:PV3D(3D model for Portrait Video generation)。

PV3D的訓(xùn)練繼承了3D GAN模型的優(yōu)點(diǎn),即無(wú)需動(dòng)態(tài)的三維數(shù)據(jù)監(jiān)督,只需要在足夠數(shù)量的單視角2D視頻數(shù)據(jù)上進(jìn)行訓(xùn)練。

該生成框架將人像和動(dòng)作進(jìn)行解耦,基于視頻的時(shí)間戳生成各自的三維表征,讓視頻可以從任意角度進(jìn)行渲染。

長(zhǎng)視頻也能挑戰(zhàn):

3D動(dòng)態(tài)人像生成

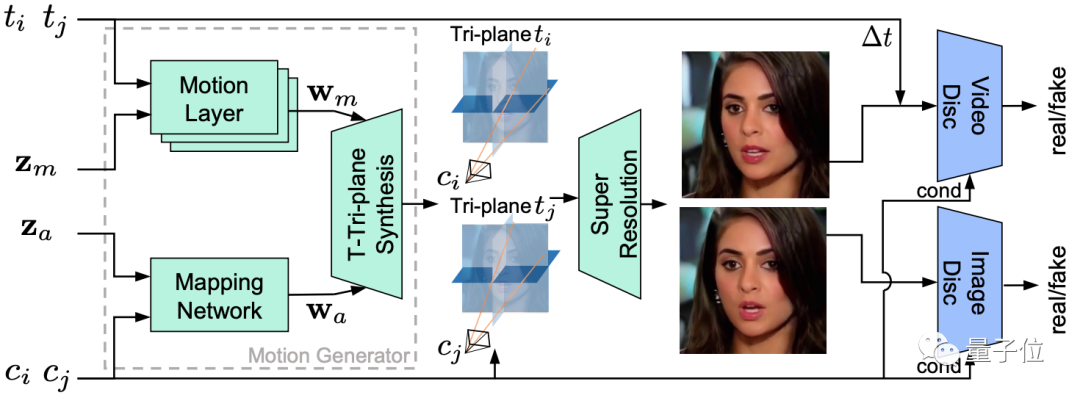

PV3D分別從獨(dú)立的高斯分布中采樣隨機(jī)噪聲來(lái)表征外表和運(yùn)動(dòng),外表噪聲生成視頻的主體內(nèi)容,控制人像的ID以及人臉的各個(gè)部分,運(yùn)動(dòng)噪聲配合視頻幀的時(shí)間戳控制當(dāng)前幀的動(dòng)作。

為了確保生成內(nèi)容的真實(shí)性以及外表和運(yùn)動(dòng)的解耦,PV3D訓(xùn)練兩個(gè)獨(dú)立的判別器分別判定外表和運(yùn)動(dòng)的合理性。

該方法可以生成隨機(jī)的人像視頻以及相應(yīng)的高質(zhì)量的動(dòng)態(tài)幾何表面,讓視頻可以從任意角度進(jìn)行渲染。

同時(shí),該方法可以支持下游的應(yīng)用任務(wù),比如靜態(tài)人像驅(qū)動(dòng),人像視頻的重建以及對(duì)人像動(dòng)作的修改,所有的結(jié)果均可以保持高的多視角一致性。

主流的3D GAN模型都脫胎于StyleGAN結(jié)構(gòu)。

因此這些模型均會(huì)將采樣得到的噪聲先映射到一個(gè)高維度的中間隱式編碼(intermidate latent code),大量現(xiàn)有的研究表明這種結(jié)構(gòu)的隱式空間包含了豐富的語(yǔ)義信息,可以用來(lái)控制生成的圖像內(nèi)容。

因此,最直接的拓展方式就是使用預(yù)訓(xùn)練的單幀3D GAN模型,通過(guò)學(xué)習(xí)一個(gè)額外的在隱式空間進(jìn)行推理的時(shí)序模型對(duì)生成的內(nèi)容進(jìn)行合理的改變,從而生成3D人像視頻。

然而,該方法的缺點(diǎn)是圖片生成器和時(shí)序推理模型在不同的階段分別被優(yōu)化,導(dǎo)致最終的視頻很難保持時(shí)間上的一致性。

另一種主流的視頻生成模型使用稀疏訓(xùn)練的方式,在訓(xùn)練階段直接隨機(jī)生成視頻中的少量幀,使用少數(shù)幀的時(shí)間戳編碼運(yùn)動(dòng)信息,進(jìn)一步的改變中間隱式編碼從而一次性優(yōu)化完整的生成器。

然而這種做法將全部的時(shí)序信息都包含在隱式空間中,導(dǎo)致最終的模型多樣性較差、生成質(zhì)量較低。

與上述方法不同,PV3D在原有GAN模型的基礎(chǔ)上在特定尺度的生成模塊中插入運(yùn)動(dòng)信息的編碼層,這些編碼層獨(dú)立地將控制運(yùn)動(dòng)的噪聲映射為隱式編碼,使用modulated convolution操縱外表特征,再將操縱后的特征與原始特征融合,從而提高生成視頻的時(shí)序一致性和運(yùn)動(dòng)多樣性。

此外,本工作還研究了以下問(wèn)題:

如何有效地在視頻生成任務(wù)中利用渲染的視角先驗(yàn)信息

針對(duì)3D視頻生成,如何設(shè)計(jì)合理的外表和運(yùn)動(dòng)判別器

PV3D模型基于最新的靜態(tài)3D GAN模型EG3D進(jìn)行開(kāi)發(fā),EG3D采用高效的3D表征Tri-plane實(shí)現(xiàn)圖像生成。

在訓(xùn)練階段,PV3D采用稀疏訓(xùn)練的策略,對(duì)于一個(gè)視頻采樣兩個(gè)噪聲、兩個(gè)時(shí)間戳以及各自時(shí)刻對(duì)應(yīng)的相機(jī)視角。

相對(duì)應(yīng)的,模型生成兩幀對(duì)應(yīng)的3D表征進(jìn)行渲染得到粗糙的結(jié)果。隨后使用超分辨率模塊將圖片上采樣。

PV3D設(shè)計(jì)了兩個(gè)獨(dú)立的判別器監(jiān)督網(wǎng)絡(luò)的學(xué)習(xí),其中視頻判別器會(huì)編碼兩幀的相機(jī)視角以及時(shí)間間隔去判斷生成結(jié)果的合理性。

實(shí)驗(yàn)部分

評(píng)價(jià)指標(biāo)

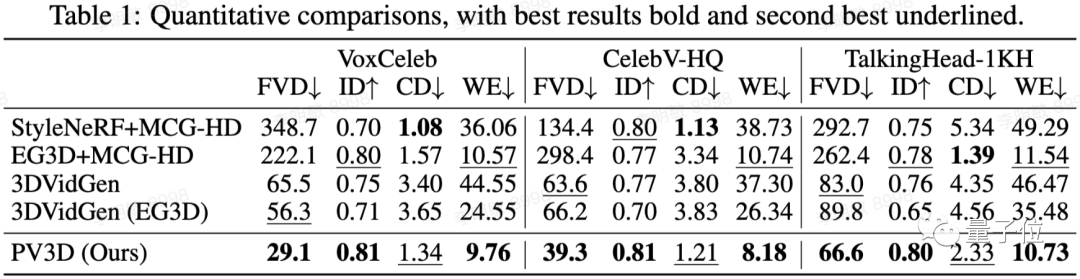

研究人員使用FVD來(lái)評(píng)估生成視頻的質(zhì)量。此外,為了評(píng)估多視角的一致性以及3D幾何結(jié)構(gòu)的質(zhì)量,研究人員將3D GAN工作中常用的評(píng)價(jià)指標(biāo)(生成人像的ID一致性、Chamfer距離、多視角的重投影誤差)拓展到視頻任務(wù)中。

與基線的對(duì)比

研究人員首先采用同期的3D視頻生成工作3DVidGen作為基線。此外,研究人員還基于SOTA的單幀3D GAN (EG3D和StyleNerf) 和2D視頻生成模型構(gòu)建了三個(gè)基線模型。在3個(gè)公開(kāi)數(shù)據(jù)集(VoxCeleb, CelebV-HQ, TalkingHead-1KH)上的實(shí)驗(yàn)結(jié)果表明,PV3D在生成視頻的多樣性,3D幾何的質(zhì)量,以及多視角一致性上均超越基線模型。

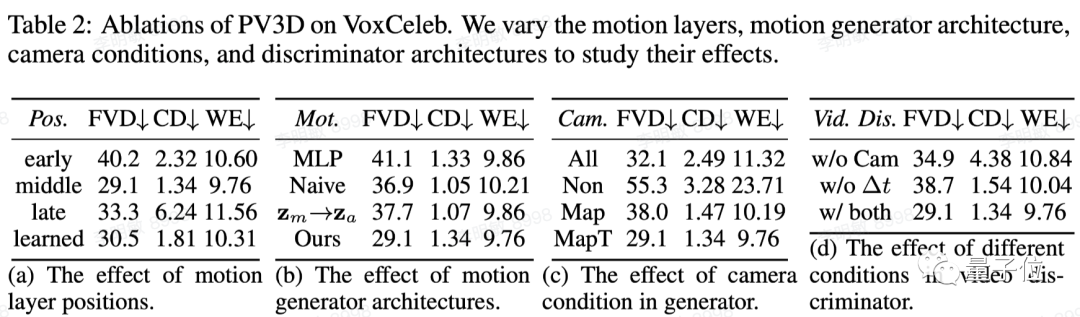

消融實(shí)驗(yàn)

研究人員對(duì)PV3D的各部分設(shè)計(jì)進(jìn)行了消融實(shí)驗(yàn),例如:運(yùn)動(dòng)信息的編碼和注入的位置,運(yùn)動(dòng)信息的插入方式,相機(jī)視角的采樣策略,以及視頻判別器的設(shè)計(jì)。

團(tuán)隊(duì)介紹

目前,該論文已被ICLR 2023接收。

作者團(tuán)隊(duì)由新加坡國(guó)立大學(xué)Show Lab和字節(jié)跳動(dòng)組成。

論文地址:https://openreview.net/pdf?id=o3yygm3lnzS

項(xiàng)目主頁(yè):https://showlab.github.io/pv3d/