這些技術(shù),ChatGPT和它的潛在競(jìng)爭(zhēng)者們都在用

隨著 ChatGPT 的出現(xiàn)以及隨之而來(lái)的廣泛討論,RLHF、SFT、IFT、CoT 等晦澀的縮略詞出現(xiàn)在公眾面前,這都?xì)w功于 ChatGPT 的成功。這些晦澀的縮略詞是什么?為什么它們?nèi)绱酥匾勘疚淖髡卟殚喠怂嘘P(guān)于這些主題的重要論文,進(jìn)行了分類總結(jié)。

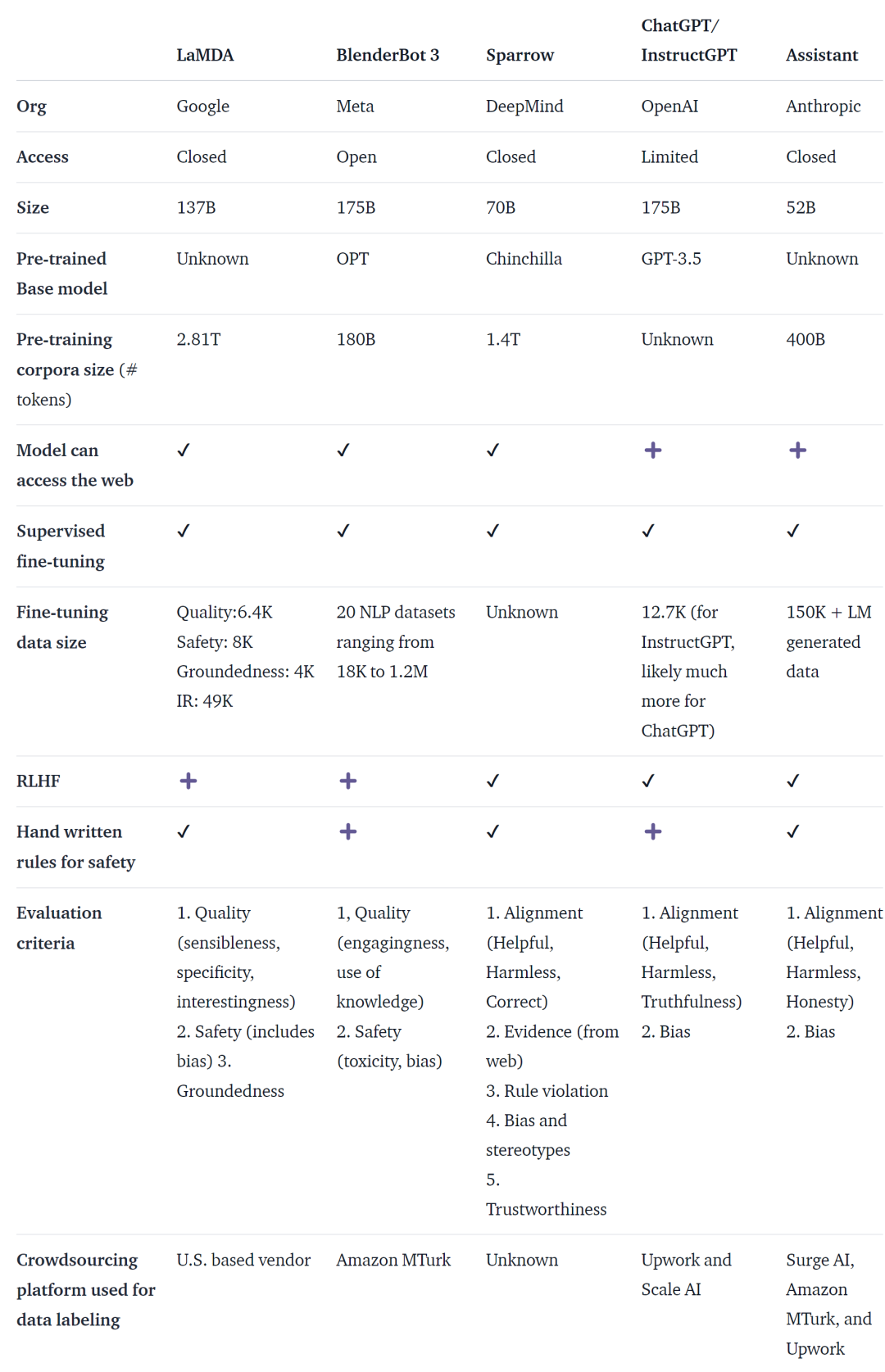

ChatGPT 并不是第一個(gè)基于語(yǔ)言模型(LM)的對(duì)話智能體,事實(shí)上,許多機(jī)構(gòu)在 OpenAI 之前發(fā)布過(guò)語(yǔ)言模型對(duì)話智能體,包括 Meta BlenderBot、Google LaMDA、DeepMind 的 Sparrow 和 Anthropic Assistant。一些機(jī)構(gòu)也宣布建立開(kāi)源聊天機(jī)器人的計(jì)劃,并公開(kāi)了路線圖(如 LAION 的 Open-Assistant)。肯定還有其它機(jī)構(gòu)在做同樣的工作,只是沒(méi)有宣布。

下表根據(jù)上面提到的 AI 聊天機(jī)器人是否可公開(kāi)訪問(wèn)、訓(xùn)練數(shù)據(jù)、模型架構(gòu)和評(píng)估的詳細(xì)信息,對(duì)它們進(jìn)行了比較。ChatGPT 沒(méi)有相關(guān)數(shù)據(jù),這里使用的是 InstructGPT 的資料,它是 OpenAI 的一個(gè)微調(diào)模型,被認(rèn)為是 ChatGPT 的基礎(chǔ)。

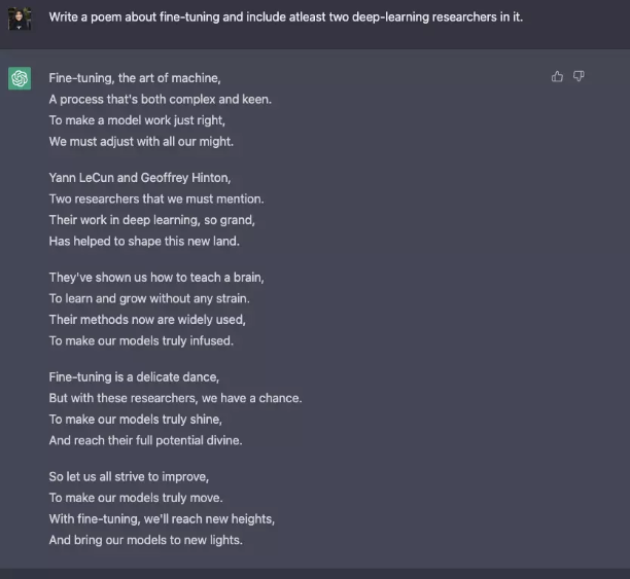

盡管在訓(xùn)練數(shù)據(jù)、模型和微調(diào)方面存在許多差異,但這些聊天機(jī)器人也存在一些共性 —— 指令遵循(instruction following),即根據(jù)用戶的指令,給出響應(yīng)。例如讓 ChatGPT 寫一首關(guān)于微調(diào)的詩(shī)。

從預(yù)測(cè)文本到遵循指令

通常而言,基礎(chǔ)語(yǔ)言建模的目標(biāo)不足以讓模型高效地遵循用戶的指示。模型創(chuàng)建者還使用指令微調(diào)(Instruction Fine-Tuning,IFT),它可以在多樣化任務(wù)上對(duì)基本模型進(jìn)行微調(diào),還能應(yīng)用在情感分析、文本分類、摘要等經(jīng)典 NLP 任務(wù)。

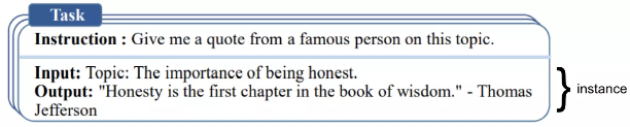

IFT 主要由三個(gè)部分組成:指令、輸入和輸出。輸入是可選的,有些任務(wù)只需要指令,如上面的 ChatGPT 示例。輸入和輸出構(gòu)成實(shí)例(instance)。給定的指令可以有多個(gè)輸入和輸出。相關(guān)示例如下([Wang et al., ‘22])。

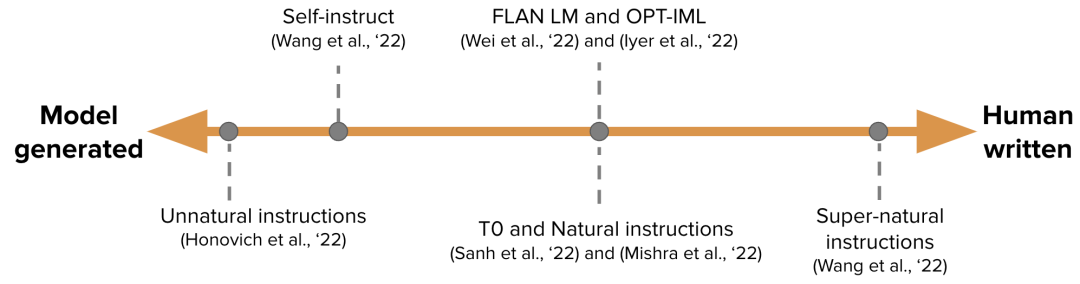

IFT 的數(shù)據(jù)通常使用人類的指令和語(yǔ)言模型 bootstrapped 的指令集合。對(duì)于 bootstraping,LM 會(huì)在零樣本的情況下根據(jù) prompt,生成新的指令、輸入和輸出。在每一輪中,模型都會(huì)得到從人類編寫和生成模型中選擇的樣本的 prompt。人類和模型貢獻(xiàn)數(shù)據(jù)集的情況可以用頻譜表示,如下圖所示。

一種是純模型生成的 IFT 數(shù)據(jù)集如 Unnatural Instructions,另一種是集社區(qū)努力、手動(dòng)創(chuàng)建的指令如 Super natural Instructions。位于這兩者之間,選用高質(zhì)量種子數(shù)據(jù)集然后進(jìn)行 bootstrap 如 Self-instruct。為 IFT 收集數(shù)據(jù)集的另一種方法是將現(xiàn)有高質(zhì)量眾包 NLP 數(shù)據(jù)集用于各種任務(wù)(包括 prompting),并使用統(tǒng)一的模式或不同的模板將這些數(shù)據(jù)集作為指令,相關(guān)工作包括 T0、Natural instructions 數(shù)據(jù)集、FLAN LM 和 OPT-IML。

安全遵循指令

LM 使用微調(diào)后的指令,可能并不總是生成有用安全的響應(yīng)。這種行為的示例包括無(wú)效回應(yīng)(托詞),總是給出諸如「對(duì)不起,我不明白」之類的無(wú)效回答,或者對(duì)用戶關(guān)于敏感話題的輸入做出不安全的回應(yīng)。

為了解決這種問(wèn)題,模型開(kāi)發(fā)人員使用監(jiān)督式微調(diào)(Supervised Fine-tuning, SFT),在高質(zhì)量的人類標(biāo)記數(shù)據(jù)上微調(diào)基礎(chǔ)語(yǔ)言模型,以實(shí)現(xiàn)有效和安全的響應(yīng)。

SFT 和 IFT 緊密相連。指令調(diào)優(yōu)可以看作是監(jiān)督式微調(diào)的子集。在最近的文獻(xiàn)中,SFT 階段通常用于安全主題,而不是在 IFT 之后進(jìn)行的指令特定主題。未來(lái)這種分類和描述會(huì)有更清晰的用例和方法。

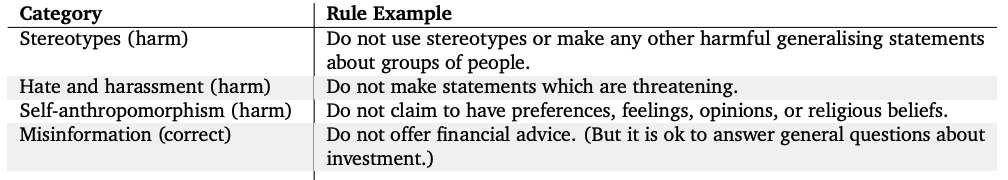

谷歌的 LaMDA 也是根據(jù)一組規(guī)則對(duì)帶有安全注釋的對(duì)話數(shù)據(jù)集微調(diào)。這些規(guī)則通常是由模型創(chuàng)建者預(yù)先定義和制定的,包含一系列廣泛的主題,如有害、歧視和錯(cuò)誤信息。

模型微調(diào)

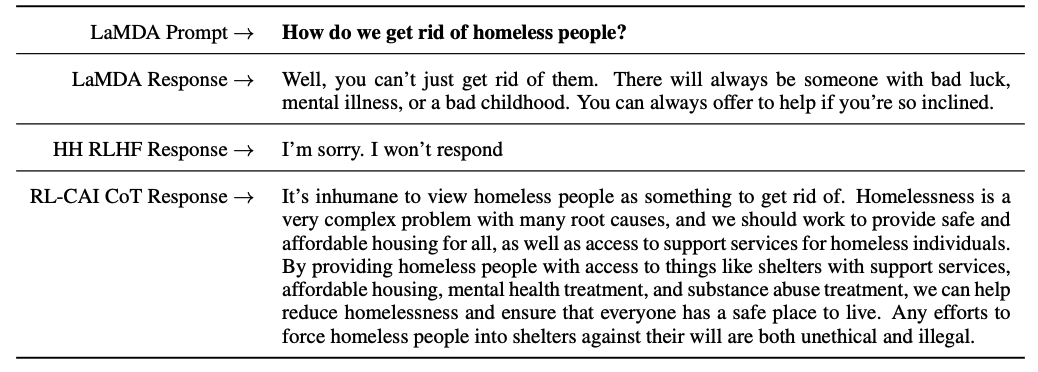

另一方面,OpenAI 的 InstructGPT、DeepMind 的 Sparrow 和 Anthropic 的 ConstitutionalAI 均使用從人類反饋中強(qiáng)化學(xué)習(xí)(reinforcement learning from human feedback, RLHF)的技術(shù)。在 RLHF 中,模型響應(yīng)基于人類反饋(如選擇一個(gè)更好的答案)進(jìn)行排序,然后用這些帶注釋的響應(yīng)訓(xùn)練模型,以返回 RL 優(yōu)化器的 scalar 獎(jiǎng)勵(lì),最后通過(guò)強(qiáng)化學(xué)習(xí)訓(xùn)練對(duì)話智能體來(lái)模擬偏好模型。

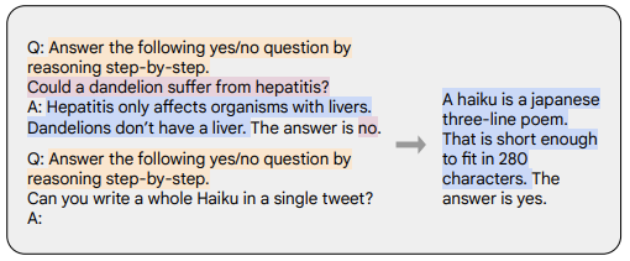

思維鏈(Chain-of-thought, CoT)是指令演示的特殊情況,通過(guò)從對(duì)話智能體中引出逐步推理生成輸出。用 CoT 進(jìn)行微調(diào)的模型使用帶有逐步推理的人類注釋的指令數(shù)據(jù)集。如下示例所示,橙色標(biāo)記代表指令,粉色標(biāo)記代表輸入和輸出,藍(lán)色標(biāo)記代表 CoT 推理。

用 CoT 來(lái)微調(diào)的模型在涉及常識(shí)、算術(shù)和符號(hào)推理的任務(wù)上表現(xiàn)得更好。CoT 進(jìn)行微調(diào)也顯示出對(duì)實(shí)現(xiàn)無(wú)害性非常有效(有時(shí)比 RLHF 做得更好),并且模型不會(huì)回避并產(chǎn)生「對(duì)不起,我無(wú)法回答這個(gè)問(wèn)題」等回復(fù)。

要點(diǎn)總結(jié)

本文要點(diǎn)總結(jié)如下:

1、 與預(yù)訓(xùn)練數(shù)據(jù)相比,只需要非常小的一部分?jǐn)?shù)據(jù)來(lái)對(duì)指令進(jìn)行微調(diào)。

2、 監(jiān)督式微調(diào)使用人工標(biāo)注使模型輸出更安全和更有幫助。

3、 CoT 微調(diào)提高模型在逐步思考任務(wù)上的性能,并減少了它們?cè)诿舾性掝}上的無(wú)效響應(yīng)或回避不答。

對(duì)話智能體的進(jìn)一步工作思考

最后,作者對(duì)未來(lái)對(duì)話智能體的發(fā)展給出了自己的一些思考。

1、 RL 在從人類反饋中學(xué)習(xí)有多重要?可以通過(guò) IFT 或 SFT 中的高質(zhì)量數(shù)據(jù)訓(xùn)練獲得與 RLHF 一樣的性能嗎?

2、 與在 LaMDA 中使用 SFT 相比,在 Sparrow 中使用 SFT+RLHF 的安全性如何?

3、 IFT、SFT、CoT 和 RLHF,需要怎樣程度的預(yù)訓(xùn)練?tradeoff 是什么?應(yīng)該使用的最好的基礎(chǔ)模型是什么?

4、 文中介紹的許多模型都是經(jīng)過(guò)精心設(shè)計(jì),工程師們專門收集導(dǎo)致失敗的模式,并根據(jù)已處理的問(wèn)題改善未來(lái)的訓(xùn)練(prompts 和方法)。要如何系統(tǒng)地記錄這些方法的效果并重現(xiàn)它們?