狂飆一個虛擬人,AI作畫+表情遷移+唇形合成

哈嘍,大家好。

ChatGPT 爆火之后,最近大家又開始關注AI作畫了,AI作畫的出現比ChatGPT早,只不過沒有形成全行業性的關注。

AI作畫 現在用的比較多的是擴散模型?,二次元作畫網站Novel AI?的模型泄漏,被爆出用的就是Stable Diffusion(穩定擴散模型)

今天,教大家在本地搭建一個web版AI作畫工具,可以生成自己的二次元圖片,然后用 FOM? 模型進行表情遷移,讓人臉動起來,在用wav2lip讓嘴唇隨著聲音動起來。

權重文件和測試數據已經打包好了,評論區獲取。

首先,下載stable-diffusion-webui源碼

提示一下,安裝步驟沒必要按照官方的,官方的方式太死板了,反而制造更多麻煩。

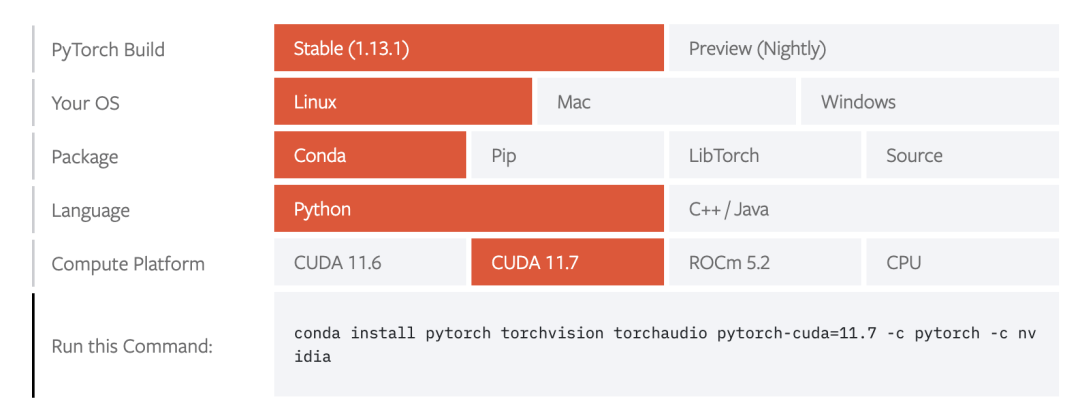

安裝 pytorch

選擇對應 cuda? 版本和 pytorch 版本安裝即可。

安裝stable-diffusion-webui依賴包

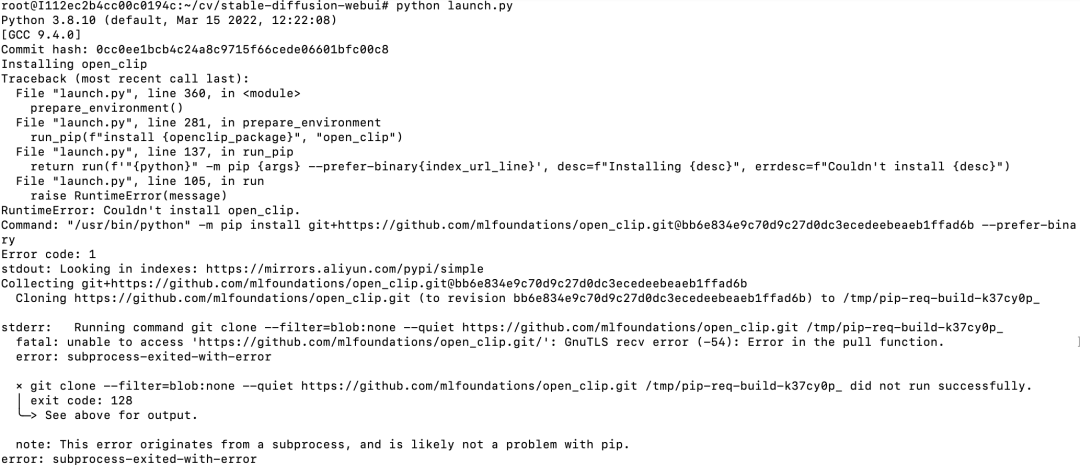

安裝結束后,執行python launch.py命令,運行后,發現還要安裝一些包,如:

發現Installing open clip?一行,說明還需要安裝open clip?,這個是從github?下載源碼安裝,但github經常訪問不了,所以這里經常以失敗告終。

不過,觀察上面的信息,可以找他安裝命令

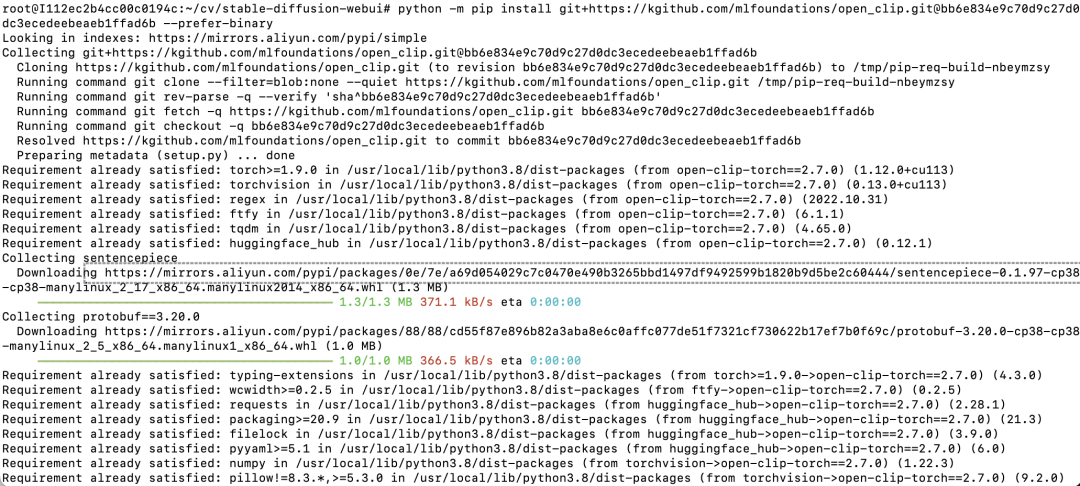

我們可以將github.com改為國內的鏡像,手動安裝這個包

把github.com?改為kgithub.com,可以看到安裝速度很快。

重復執行python launch.py命令,用同樣的方式把依賴包都安裝上即可。

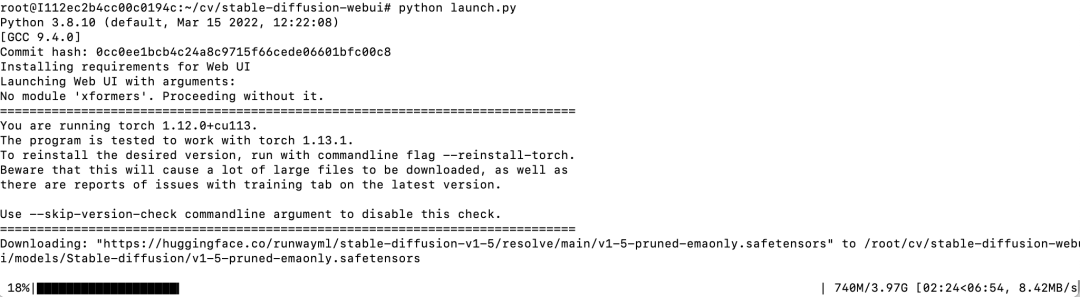

最后,看到如下輸出,說明stable-diffusion-webui成功啟動了

可以看到,這里自動下載的stable diffusion?模型是v1-5-pruned-emaonly。

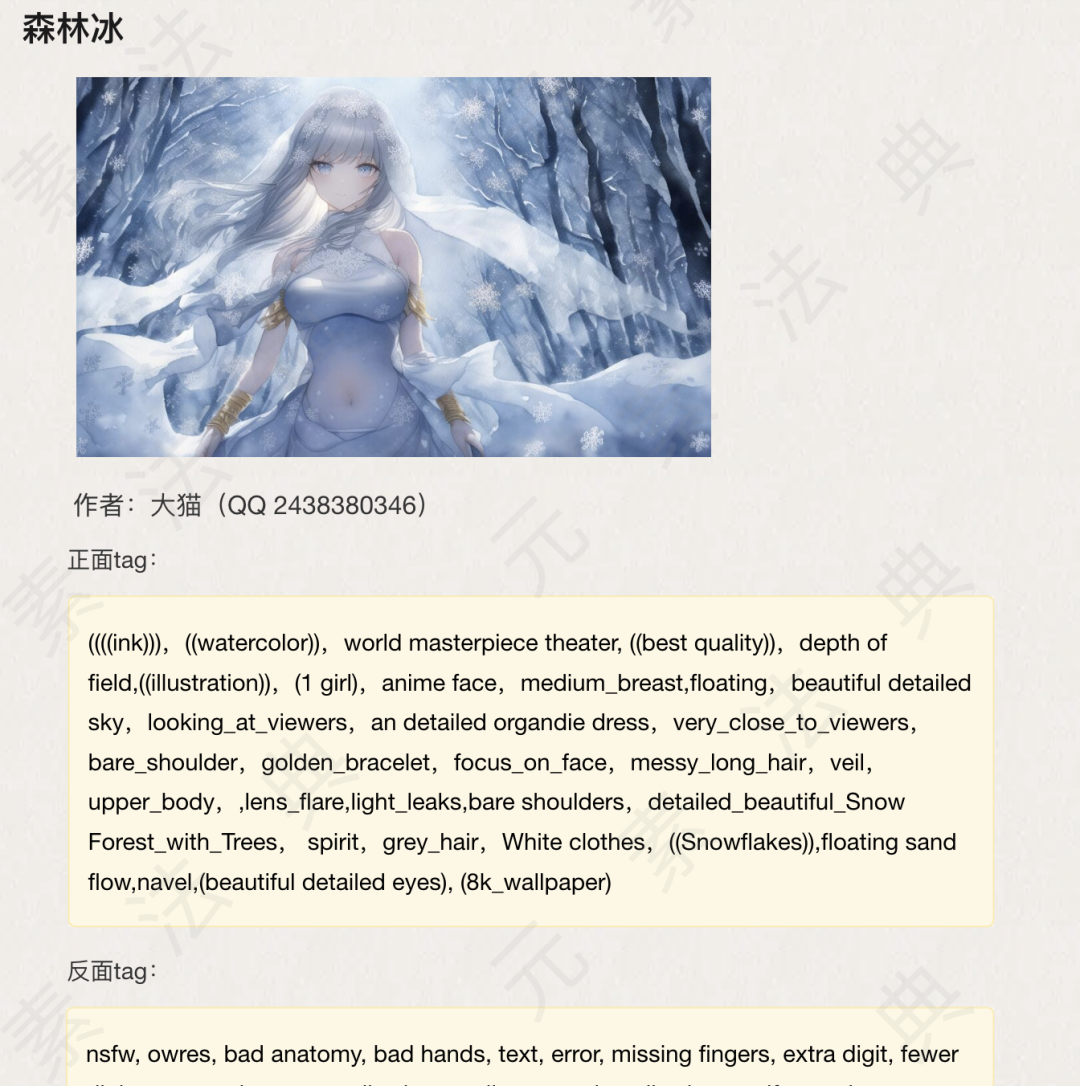

我提供了novel ai?模型,效果更好,大家可以下載。覆蓋models下Stable-diffusion目錄即可。

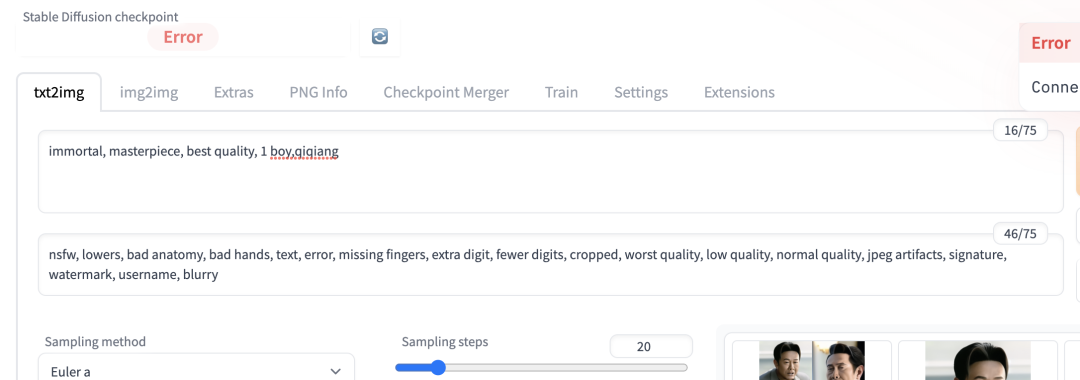

打開webui?,填入正面tag和反面tag就可以自動生成圖片了。

分享一個地址 https://docs.qq.com/doc/DWHl3am5Zb05QbGVs

這里有大量tag可以直接使用

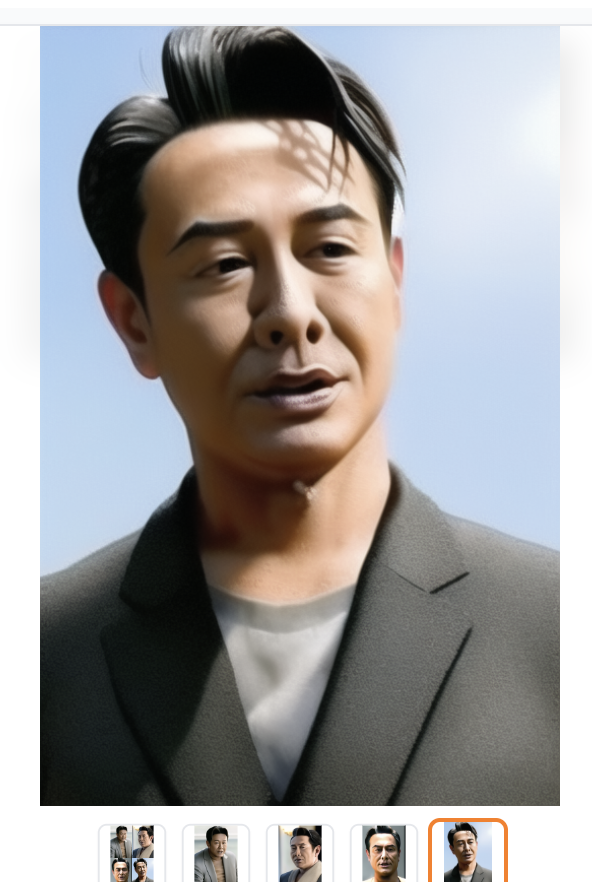

也可以訓練embedding?生成特定人物或風格的圖片,比如:我訓練兩個一個高啟強的embedding,生成的圖片如下:

接下來,我們就驅動圖片動起來。

我是基于Paddle?實現的,首先安裝Paddlehub

FOM 模型進行表情遷移

Wav2lip嘴唇動起來

本文轉載自微信公眾號「 渡碼」,可以通過以下二維碼關注。轉載本文請聯系 渡碼公眾號。