中山大學HCP實驗室新突破:用因果范式再升級多模態大模型

中山大學人機物智能融合實驗室(HCP)在 AIGC 及多模態大模型方面成果豐碩,在近期的 AAAI 2023、CVPR 2023 先后入選了十余篇,位列全球研究機構的第一梯隊。

?其中一個工作實現了用因果模型來顯著提升多模態大模型在調優中的可控及泛化性——《Masked Images Are Counterfactual Samples for Robust Fine-tuning》。

鏈接:https://arxiv.org/abs/2303.03052

使用預訓練的大規模模型在下游任務上進行微調是當前流行的深度學習范式。尤其是近期預訓練語言大模型 ChatGPT 的出色表現,使得這套技術范式得到了廣泛的認可。經過海量數據的預訓練,這些預訓練大模型能夠適應現實環境中多變的數據分布,因而在通用場景中表現出較強的魯棒性。

然而,當用下游場景數據對預訓練大模型進行微調以適應特定應用任務時,絕大多數情況下這些數據具有單一性。以這些數據對預訓練大模型進行微調訓練,往往會降低模型魯棒性,使基于預訓練大模型的應用變得困難。特別是在視覺模型方面,由于圖像的多樣性遠遠超過語言,下游微調訓練導致視覺相關的預訓練大模型魯棒性下降的問題尤其突出。

之前的研究方法通常通過模型集成等方式在模型參數層面隱式地保持微調后預訓練模型的魯棒性。但是,這些工作并沒有分析微調導致模型分布外性能下降的本質原因,也沒有明確解決上述大模型微調后魯棒性下降的問題。

該工作以跨模態大模型為基礎,從因果關系的角度分析了預訓練大模型魯棒性損失的本質原因,并據此提出了一種能夠顯著提升模型魯棒性的微調訓練方法。該方法使得模型在適應下游任務的同時,仍能保持較強的魯棒性,更好地滿足實際應用需求。

以 OpenAI 在 2021 年發布的跨模態預訓練大模型 CLIP(Contrastive Language–Image Pre-training)為例:CLIP 是一種基于對比的圖片 - 文本聯合學習的跨模態預訓練大模型,是 Stable Diffusion 等生成式模型的基礎。該模型通過包含約 4 億個圖像 - 文本對的海量多源數據進行訓練,在一定程度上學習到了一些對于分布變化魯棒的因果關系。

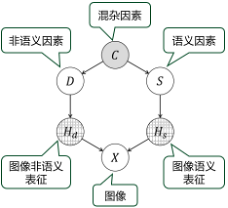

然而,當用特征單一的下游數據對 CLIP 進行微調時,容易破壞模型學習到的這些因果知識,因為訓練圖像的非語義表征和語義表征是高度糾纏的。例如,將 CLIP 模型遷移應用到 “農場” 這一下游場景時,許多訓練圖像中的 “奶牛” 都在草地上。此時,微調訓練可能使模型學習到依賴草地這一非 “奶牛” 的語義表征來預測圖像的語義。然而,這種相關性并不一定是真實的,例如 “奶牛” 也可能出現在公路上。因此,模型在進行微調訓練后,其魯棒性會降低,應用時的輸出結果可能變得極不穩定,缺乏可控性。

基于團隊多年的大模型搭建和訓練經驗,該工作從因果關系的角度重新審視了預訓練模型微調導致魯棒性下降的問題。基于因果建模與分析,該工作提出了一種基于圖像掩碼構造反事實樣本,并通過掩碼圖像學習提高模型魯棒性的微調訓練方法。

具體而言,為了打破下游訓練圖像中的假性相關,該工作提出了一種基于類激活圖(CAM)的方法掩蓋并替換圖像特定區域的內容,用以操縱圖像的非語義表征或語義表征,產生反事實樣本。微調模型可以通過蒸餾的方式學習模仿預訓練模型對這些反事實樣本的表征,從而更好地解耦語義因素與非語義因素的影響,提高對下游領域中分布偏移的適應能力。

實驗表明,該方法能夠顯著提高預訓練模型在下游任務中的性能,同時在提升魯棒性方面相較于現有大模型微調訓練方法有顯著優勢。

該工作的重要意義是在一定程度上打開了預訓練大模型從深度學習范式中繼承的 “黑盒子”,是解決大模型的 “可解釋性” 和 “可控性” 問題的重要探索,讓我們離切實可享受的由預訓練大模型帶領的生產力提升越來越近。

中山大學 HCP 團隊自 Transformer 機制問世起,從事大模型技術范式研究多年,致力于提升大模型的訓練效率和引入因果模型來解決大模型的 “可控性” 問題。團隊多年來自主研究開發了多個視覺、語言、語音和跨模態的預訓練大模型,與華為諾亞方舟實驗室聯合開發的 “悟空” 跨模態大模型 (鏈接:https://arxiv.org/abs/2202.06767) 即是其中的典型案例。

團隊簡介

中山大學人機物智能融合實驗室 (HCP Lab) 在多模態認知計算、機器人與嵌入式系統、元宇宙與數字人、可控內容生成等領域開展體系化研究,并深入應用場景打造產品原型,輸出大量原創技術及孵化創業團隊。實驗室由 IAPR Fellow 林倞教授于 2010 年創辦,獲得中國圖像圖形學會科技一等獎、吳文俊自然科學獎、省級自然科學一等獎等榮譽;培養了梁小丹、王可澤等國家級青年人才。