速度提升24倍,30分鐘完成室內大場景逆渲染,如視研究成果入選CVPR 2023

三維重建是計算機視覺(CV)和計算機圖形學(CG)的熱點主題之一,它通過 CV 技術處理相機等傳感器拍攝的真實物體和場景的二維圖像,得到它們的三維模型。隨著相關技術的不斷成熟,三維重建越來越廣泛地應用于智能家居、AR 旅游、自動駕駛與高精度地圖、機器人、城市規劃、文物重建、電影娛樂等多個不同領域。

典型的基于二維圖像的三維人臉重建。圖源:10.1049/iet-cvi.2013.0220

傳統三維重建大致可以分為光測度和幾何方法,前者分析像素點的亮度變化,后者依靠視差完成重建。近年來又開始采用機器學習尤其是深度學習技術,在特征檢測、深度估計等方面取得很好的效果。雖然當前一些方法利用空間幾何模型與紋理貼圖,在場景的外觀還原度上與真實世界看起來幾近相同。

但應看到,這些方法仍存在一些局限,僅能還原場景外觀特征,無法實現場景內光照、反射率和粗糙度等更深層次屬性的數字化,對這些深層信息的查詢和編輯更無從談起了。這也導致無法將它們轉化為渲染引擎可用的 PBR 渲染資產,也就不能生成真實感十足的渲染效果。如何解決這些問題呢?逆渲染技術逐漸進入了人們的視野。

逆渲染任務最早是由老一輩計算機科學家 Barrow 和 Tenenbaum 于 1978 年提出,在三維重建的基礎上,進一步恢復光照、反射率、粗糙度和金屬度等場景內在屬性,實現更具真實感的渲染。不過從圖像中分解這些屬性極其不穩定,不同的屬性配置往往導致相似的外觀。隨著可微分渲染和隱式神經表示的進展,一些方法在具有顯式或隱式先驗的以物體為中心的小場景中取得了較好效果。

然而大規模室內場景的逆渲染一直沒能很好地解決,不僅難以在真實場景下恢復物理合理的材質,場景內多視角一致性也很難保證。在國內有這樣一家深耕自主研發核心算法,專注三維重建領域大規模行業應用的技術公司 —— 如視(Realsee),針對大規模室內場景的逆渲染這一難啃的課題,開創性地提出了高效的多視角逆渲染框架。論文已被 CVPR 2023 會議接收。

- 項目地址:http://yodlee.top/TexIR/

- 論文地址:https://arxiv.org/pdf/2211.10206.pdf

具體來講,如視新方法可以基于精準的空間數據,反向推測獲取諸如光照、反射率、粗糙度等場景內在屬性,在三維重建的基礎上恢復出貼近真實場景的光照和材質表現,在重建效果、成本效率、應用范圍等維度實現全面提升。

本文將對如視大規模室內場景的多視角逆渲染技術進行詳細的解讀,并深入剖析其優勢所在。

面向大規模室內場景

如視全新逆渲染技術做到「準、細、快」

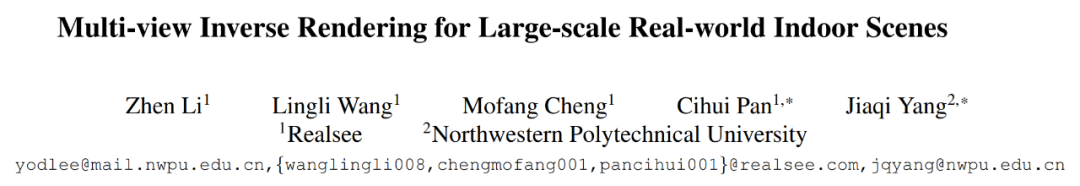

下圖 2 為如視全新逆渲染方法的整體流程。給定一組經過校準的大規模室內場景的 HDR 圖像,該方法旨在準確地恢復全局一致的光照和 SVBRDFs(雙向反射率分布函數),從而方便地集成到圖像 pipeline 和下游應用中。

為了實現這些目標,如視首先提出一種被稱為 TBL(Texture-based Lighting)的緊湊光照表示,它由 3D 網格和 HDR 紋理組成,高效建模了整個室內大場景任意位置內包含直接和無限次彈射間接光照的全局光照。基于 TBL,如視又進一步提出了具有預計算輻照度的混合光照表示,大幅提升了效率并減輕了材質優化中的渲染噪聲。最后如視引入了一種基于分割的三階段式材質優化策略,很好地處理了復雜大規模室內場景中材質物理上的模糊性。

基于紋理的光照(TBL)

在表示大規模室內場景的光照上,TBL 的優勢分別表現在神經表示的緊湊性、IBL 全局光照以及參量光的可解釋性和空間一致性。TBL 是對整個場景的全局表示,定義了所有表面點的射出輻照度。而一個表面點的射出輻照度通常等于 HDR 紋理的值,即輸入的 HDR 圖像中相應像素觀察到的 HDR 輻照度。

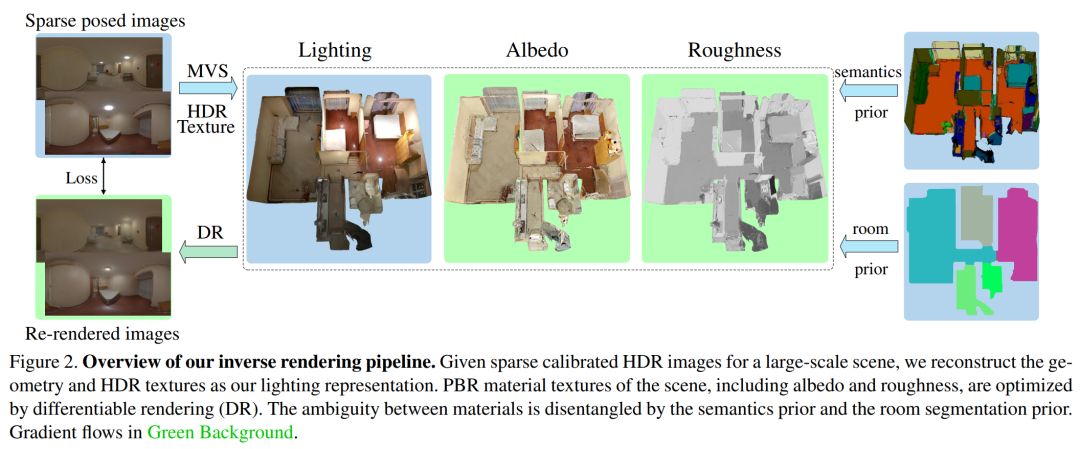

如視使用自研的高質量三維重建技術來重建整個大場景的網格模型。最終基于輸入的 HDR 圖像來重建 HDR 紋理,并通過 HDR 紋理從任意位置任意方向查詢全局光照。下圖 3(左)展示了 TBL 的可視化。

混合光照表示

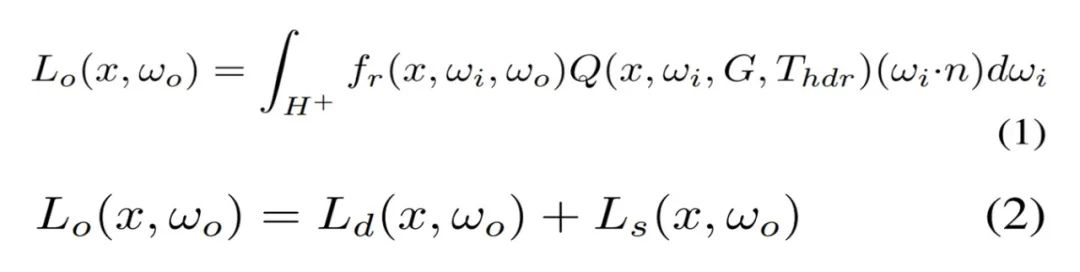

在實踐中,直接利用 TBL 優化材質存在弊端,蒙特卡洛高采樣數會導致很高的計算和內存成本。由于大多數噪聲存在于漫反射分量,如視對漫反射分量表面點的輻照度進行預計算。因此可以高效地查詢輻照度,取代了成本高昂的在線計算,如圖 3(右)所示。基于 TBL 的渲染方程由公式 (1) 重新寫為公式 (2)。

如視提出了兩種表示來建模預計算輻照度。一種是神經輻照度場(NIrF),它是一個淺層多層感知器(MLP),以表面點作為輸入并輸出輻照度 p。另一種是輻照度紋理(IrT),它類似于計算機圖形學中常用的光照貼圖。

可以看到,這種混合光照表示包含了用于漫反射分量的預計算輻照度和用于鏡面反射分量的源 TBL,大大降低了渲染噪聲,實現了材質的高效優化。公式 (2) 中的漫反射分量被建模為公式 (3) 所示。

基于分割的三階段式材質估計

對于神經材質而言,很難用極其復雜的材質對大規模場景進行建模,并且不適配傳統的圖形引擎。如視選擇直接優化幾何的顯式材質紋理,使用了以 SV 反照率和 SV 粗糙度作為參數的簡化版 Disney BRDF 模型。不過由于觀察的稀疏性,直接優化顯式材質紋理導致不一致和未收斂的粗糙度。

對此,如視利用語義和房間分割先驗來解決這一問題,其中語義圖像通過基于學習的模型預測,房間分割通過占用網格計算。在實現過程中,如視采取三階段式策略。

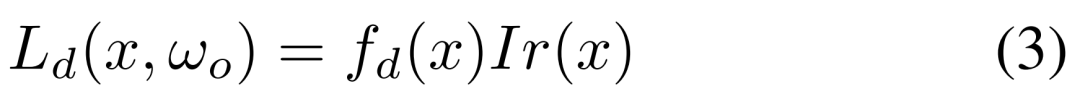

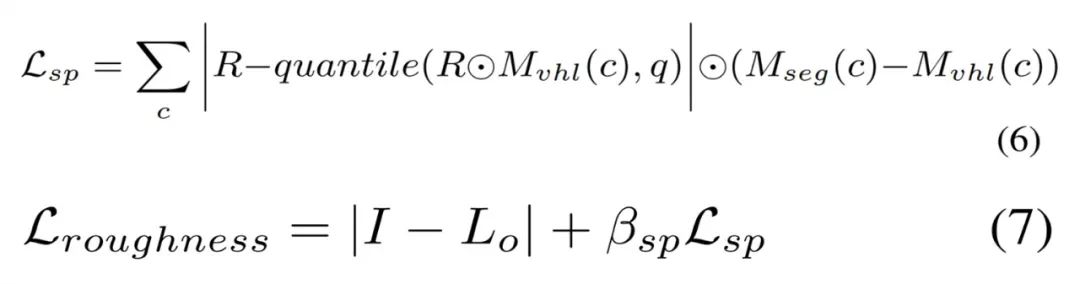

第一階段基于 Lambertian 假設來優化稀疏反照率,而不像以物體為中心的小場景那樣將反照率初始化為常數。雖然可以通過公式 (3) 直接計算漫反射反照率,但在高光區域會使得反照過亮,導致下一階段的粗糙度過高。因此,如視使用語義平滑約束在相同的語義分割上激發類似的反照率,如下公式 (4) 所示。稀疏的反照率通過公式 (5) 來優化。

第二階段基于虛擬高光(VHL)的采樣和基于語義的傳播。在多視圖圖像中,只能觀察到稀疏的鏡面反射線索會導致全局不一致的粗糙度,大規模場景尤甚。不過通過語義分割先驗,高光區域的合理粗糙度可以傳播到具有相同語義的區域。

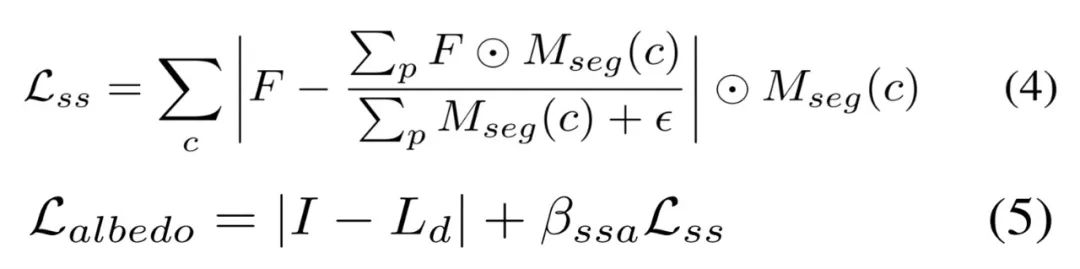

如視首先基于粗糙度為 0.01 的輸入姿態來渲染圖像以找到每個語義類的 VHL 區域,然后根據凍結的稀疏反照率和光照來優化這些 VHL 的粗糙度。合理的粗糙度可以通過公式 (6) 傳播到相同的語義分割中,并且該粗糙度可以通過公式 (7) 進行優化。

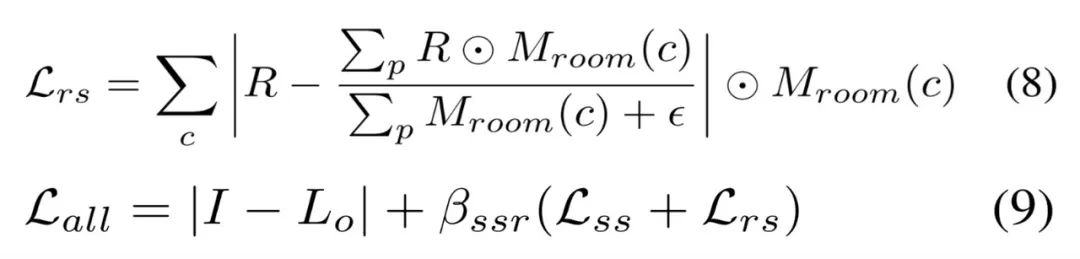

第三階段基于分割的微調。如視基于語義分割和房間分割先驗來微調所有的材質紋理。具體地,如視使用了與公式 (4) 類似的平滑約束以及用于粗糙度的房間平滑約束,使不同房間的粗糙度變得更柔和、平滑。房間平滑約束由公式 (8) 定義,同時不對反照率使用任何平滑約束,總損失被定義公式 (9) 所示。

實驗設置和效果比較

關于數據集,如視使用了兩個數據集:合成數據集和真實數據集。對于前者,如視使用路徑追蹤器創建一個具有不同材質和光源的合成場景,渲染了 24 個用于優化的視圖和 14 個新視圖,為每個視圖渲染 Ground Truth 材質圖像。對于后者,由于 Scannet、Matterport3D 和 Replica 等常用大規模場景的真實數據集缺乏 full-HDR 圖像,如視收集了 10 個 full-HDR 真實數據集,并通過合并 7 個包圍式曝光捕獲 10 到 20 個 full-HDR 全景圖像。

關于基線方法。對于從大規模場景的多視圖圖像中恢復 SVBRDFs,目前逆渲染方法有基于單張圖像學習的 SOTA 方法 PhyIR、以多視圖物體為中心的 SOTA 神經渲染方法 InvRender、NVDIFFREC 和 NeILF。關于評估指標,如視使用 PSNR、SSIM 和 MSE 來評估材質預測和重渲染圖像以進行定量比較,并使用 MAE 和 SSIM 來評估由不同光照表示渲染的重打光圖像。

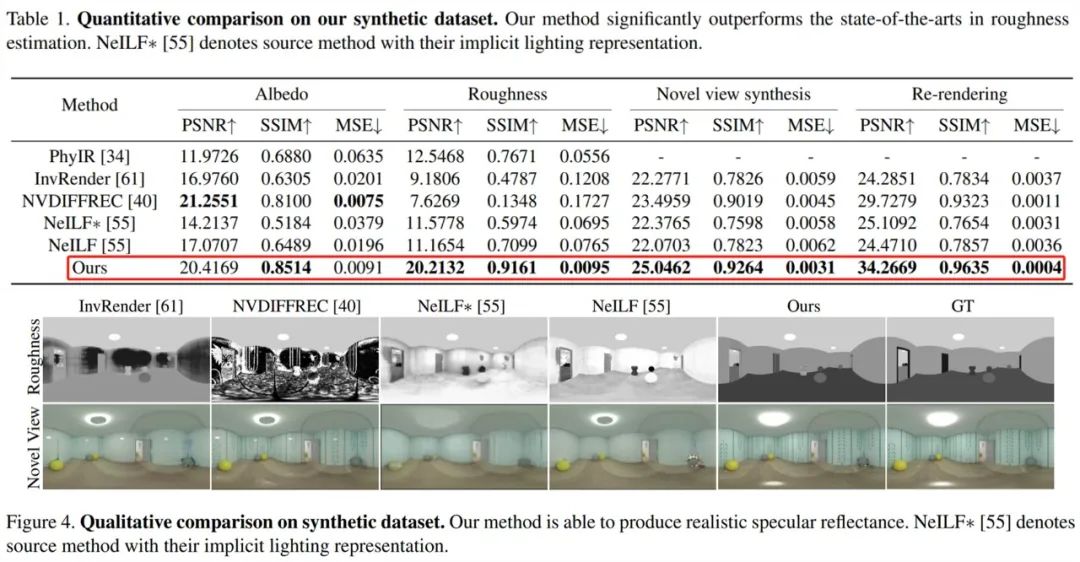

首先來看合成數據集上的評估,如下表 1 和圖 4 所示,如視方法在粗糙度估計方面顯著優于 SOTA 方法,并且該粗糙度可以產生物理合理的鏡面反射率。此外相較于原來的隱式表示,具有如視混合光照表示的 NeILF 減少了材質與光照之間的模糊性。

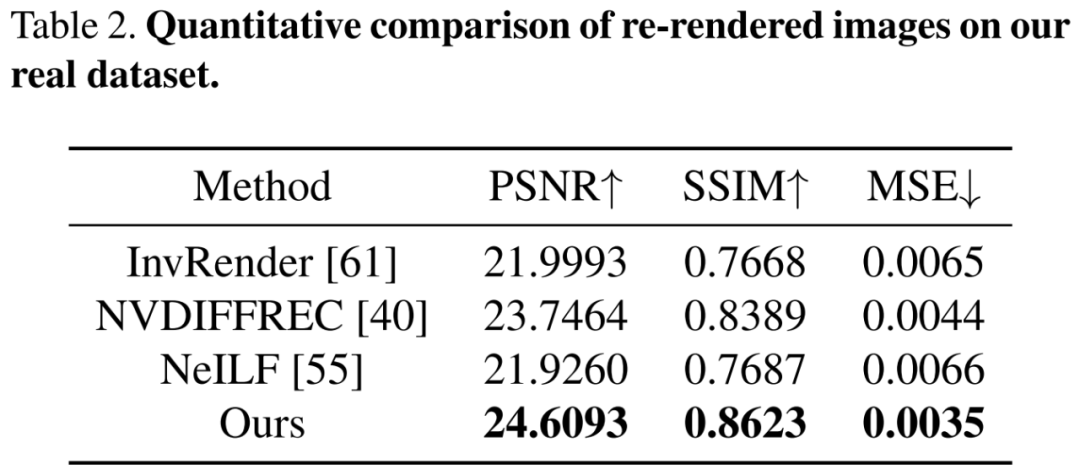

接著在包含復雜材質和光照的挑戰性真實數據集上進行評估,下表 2 的定量比較結果顯示出如視方法優于以往方法。盡管這些方法具有近似的重渲染誤差,但僅有如視方法解耦了全局一致和物理合理的材質。

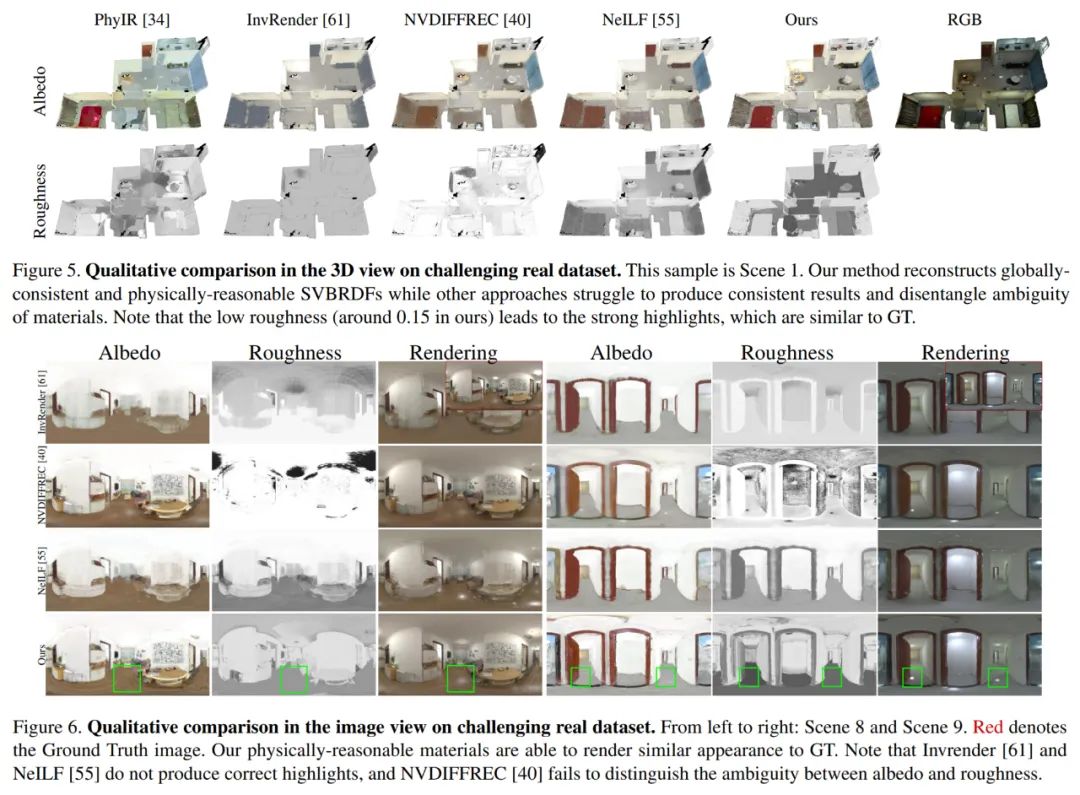

下圖 5 和圖 6 分別展示了 3D 視圖和 2D 圖像視圖的定性比較。PhyIR 由于域間隙大導致泛化性能差,無法實現全局一致性預測。InvRender、NVDIFFREC 和 NeILF 產生了帶有偽影的模糊預測,難以解耦正確的材質。NVDIFFREC 雖能實現與如視方法類似的性能,但無法解耦反照率與粗糙度之間的模糊性,比如鏡面反射分量中的高光被錯誤地恢復為漫反射反照率。

消融實驗

為了展示其光照表示和材質優化策略的有效性,如視針對 TBL、混合光照表示、第一階段的反照率初始化、第二階段用于粗糙度估計的 VHL 采樣和語義傳播、第三階段基于分割的微調進行了消融實驗。

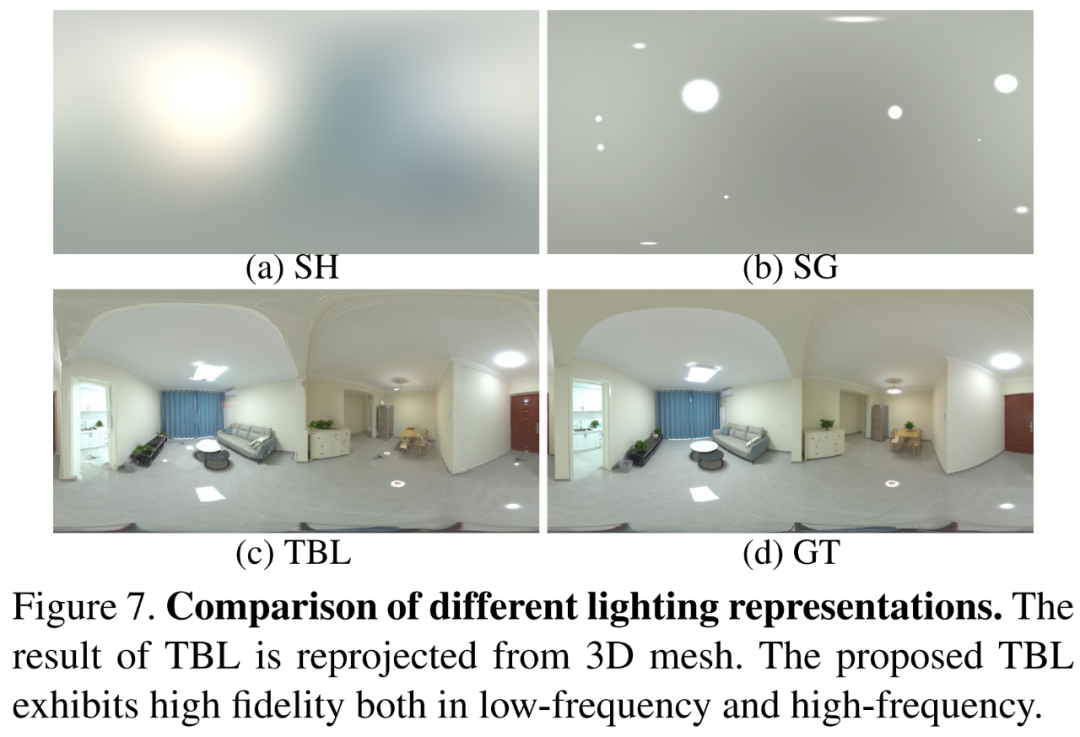

首先將 TBL 與以往方法中廣泛使用的 SH 光照和 SG 光照方法進行了比較,結果如下圖 7 所示,如視 TBL 在低頻和高頻特征方面都表現出了高保真度。

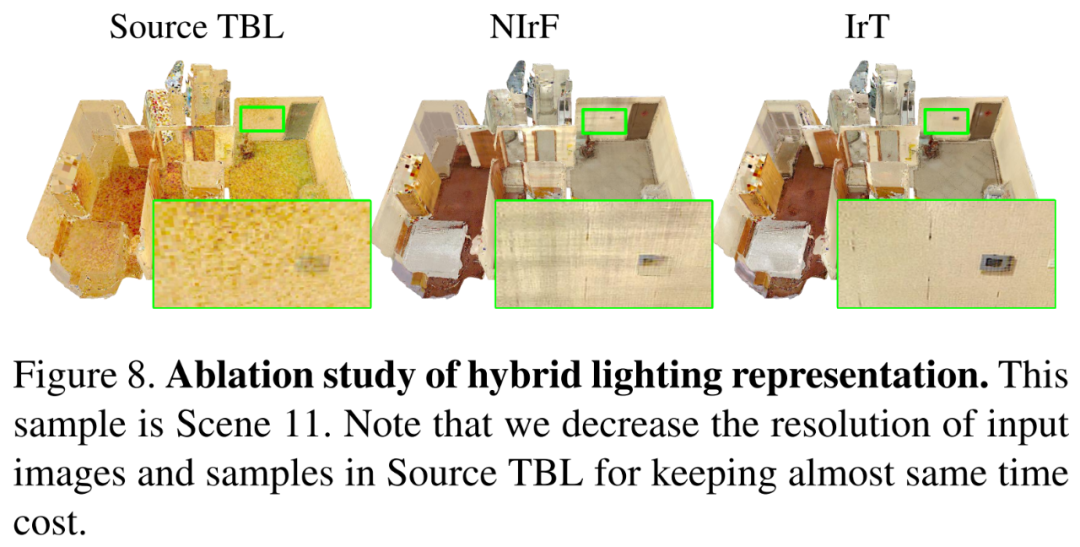

其次驗證混合光照表示的有效性,將混合光照表示與原始 TBL 進行比較,結果如下圖 8 所示。如果沒有混合光照表示,反照率會導致噪聲并且收斂變慢。預計算輻照度的引入可以使用高分辨率輸入來恢復精細的材質,并大大加速優化過程。同時與 NIrF 相比,IrT 產生了更精細和無偽影的反照率。

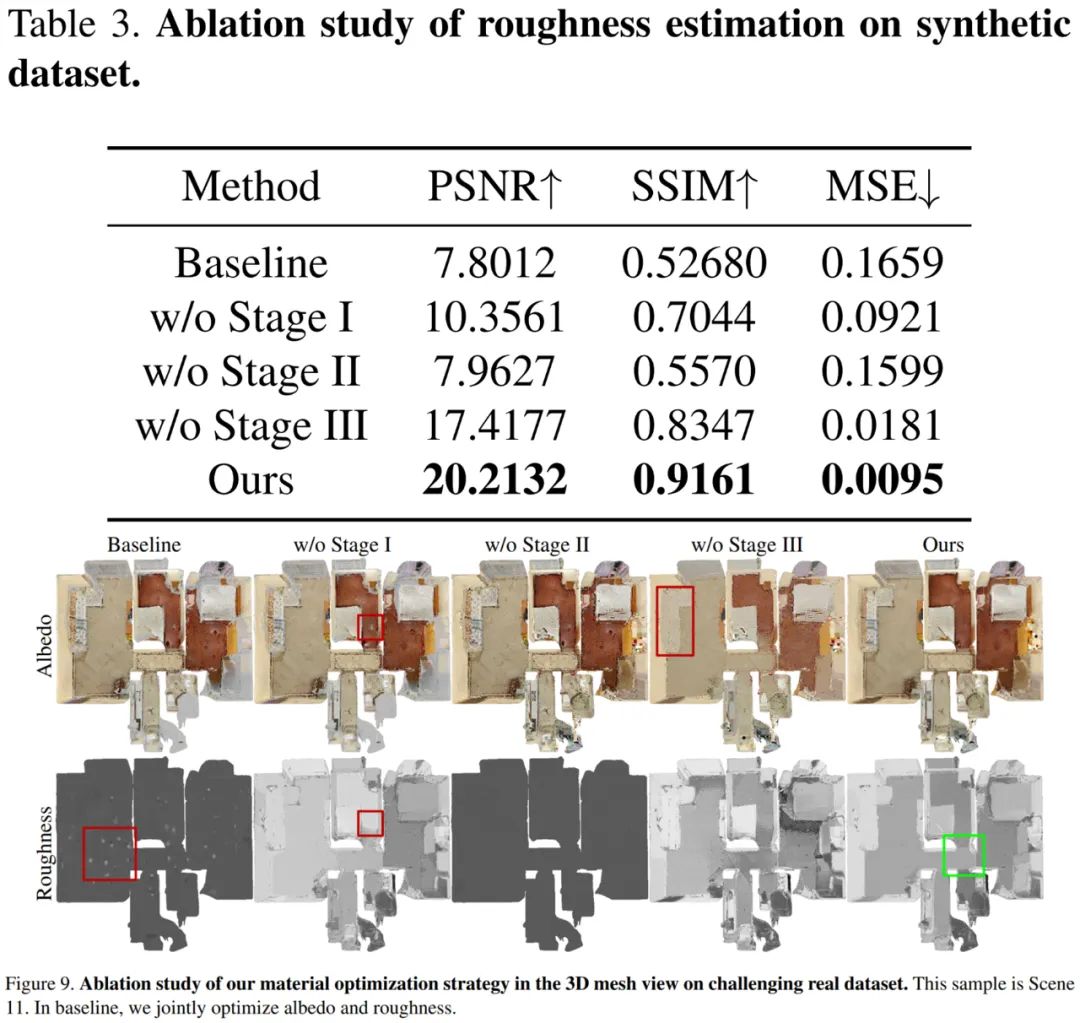

最后對三階段式策略的有效性進行了驗證,結果如下表 3 和圖 9 所示。基線粗糙度未能收斂且僅高光區域得到更新。第一階段如果沒有反照率初始化,則高光區域反照過亮并導致不正確的粗糙度。第二階段基于 VHL 的采樣和基于語義的傳播,對于恢復未觀察到鏡面反射高光區域的合理粗糙度至關重要。第三階段基于分割的微調產生了精細的反照率,使得最終的粗糙度更平滑,并阻止了不同材質之間粗糙度的錯誤傳播。

如視全新逆渲染技術,強在哪里?

其實,如視在其 CVPR 2022 論文《PhyIR: Physics-based Inverse Rendering for Panoramic Indoor Images》中通過提出神經網絡訓練方法,在單張圖像的逆渲染任務上取得了 SOTA 結果。現在全新逆渲染框架不僅做到了多視角、整屋全空間全場景,而且解決了以往逆渲染方法的多個關鍵缺陷。

首先以往基于合成數據訓練的方法在真實場景中表現不佳。如視全新深度逆渲染框架首次引入了「層級式場景先驗」,通過多階段的材質優化并結合全球最大三維空間數據庫如視數字空間中的居住空間數據,對空間內的光照、反射率和粗糙度等物理屬性實現了分層級的精準預測。

預測結果最終輸出為物理合理、全局一致的多類型材質貼圖,將如視設備真實拍攝的室內場景數據無縫轉化為數字化渲染資產,適配 Unity、Blender 等目前所有主流渲染引擎,由此實現場景資產自動生成和基于物理的 MR 應用,如材質編輯、新視圖合成、重打光、虛擬物體插入等。這種通用性很強的數字資產有利于支持后續更多不同的應用和產品。

材質編輯

重打光

其次以往基于優化的可微渲染方法計算成本極高,效率極低。近年來,為了更好地解決逆渲染問題,同時減少對訓練數據的依賴,可微渲染方法被提出,即通過「微分求導」方式使正向渲染可微分,進而將梯度反向傳播至渲染參數,最終優化得到基于物理的待求解參數。這類方法包括球諧(spherical-harmonic, SH)光照 [1] 和三維球形高斯(Volumetric Spherical Gaussian, VSG)光照。

但是大規模室內場景存在遮擋、陰影等大量復雜的光學效應,在可微渲染中建模全局光照會帶來高昂的計算成本。如視本次提出的 TBL 在高效準確地表示室內場景全局光照的同時,只需要大約 20MB 內存,而基于密集網格的 VSG 光照 [2] 大約需要 1GB 內存,基于稀疏網格的 SH 光照方法 Plenoxels [3] 大約需要 750MB 內存,數據內存容量實現了數十倍縮減。

不僅如此,如視新方法可以在 30 分鐘內完成整個室內場景的逆渲染,而傳統方法 [4] 可能需要 12 個小時左右,整整提升了 24 倍。計算速度的大幅提升意味著成本的降低,性價比優勢更加顯著,從而離大規模實際應用更近了一步。

最后以往的類 NeRF 神經逆渲染方法(如 PS-NeRF [5]、 NeRFactor [6] 等)主要面向以物體為中心的小規模場景,建模大規模室內場景似乎無能為力。基于如視精準數字空間模型以及高效準確的混合光照表示,全新逆渲染框架通過引入語義分割和房間分割先驗解決了這一問題。

對于此次的全新深度逆渲染框架,如視首席科學家潘慈輝表示,「真正意義上實現了對真實世界更深層的數字化,解決了以往逆渲染方法難以在真實場景下恢復物理合理的材質和光照以及多視角一致性的問題,為三維重建和 MR 的落地應用帶來了更大想象空間。」

把握逆渲染技術優勢

在數字空間中創新 VR + 產業融合

一直以來,如視在三維重建領域擁有很多技術積累,投入大量精力打磨并致力于相關算法的落地。同時對前沿技術的研發支持力度很大,非常看重行業上領先技術的攻克。這些成為包括此次全新逆渲染技術在內如視三維實景模型重建和 MR 研究獲得國際學術界認可的重要基礎,并幫助如視算法能力在理論研究、技術應用等層面步入國際領先水平。

這些算法及技術優勢將實現對真實世界的更深層數字化,并借此進一步加速實現數字空間的建設。目前,如視數字空間通過自研的采集設備,在不同國家、不同應用場景中的累計采集量已經超過 2700 萬套、覆蓋面積達到 22.74 億平方米。如視數字空間又將助力其 VR + 產業融合發展方向,為商業零售、工業設施、文博會展、公共事務、家居家裝、房產交易等行業帶來數字化應用升級的全新發展機遇,如 VR 看房、VR 博物館等。

如視打造的AI營銷助手

對于 VR + 產業融合,如視的最大優勢在于不斷良性進化的數字化重建算法和海量真實數據的積累,使其同時擁有了較高的技術壁壘和較大的數據壁壘。這些算法和數據在某種程度上還能相互循環起來,不斷地擴大優勢。同時數據和算法的壁壘使如視更加容易地切入各個行業的痛點問題,帶來一些技術解決方案,創新行業發展新模式。

逆渲染技術成果連續兩年入選 CVPR,主要脫胎于如視想要在 MR 方向上有所作為并在產業上實現一些落地。未來,如視希望打通實景 VR 與純虛擬仿真之間的 Gap,真正做到虛實融合,并構建更多行業應用。