英偉達「一句話生成3D模型」碾壓谷歌:分辨率清晰八倍,速度快兩倍,編輯文本還可直接修改

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

一句話生成3D模型,英偉達也來“秀肌肉”了~

來看它最新搗鼓出的Magic3D AI,效果是這樣兒的。

輸入“坐在睡蓮上的藍色箭毒蛙”,就能得到這樣一個細節豐富的3D模型:

“擺滿了水果的銀盤”也難不倒它:

還有諸如“鳥瞰角度的城堡”、“用壽司做的汽車”、“裝著蛋的鳥巢”、“用垃圾袋做的裙子”……

精準程度可見一斑。

除了這個主要本領,它還可以通過編輯文本完成模型的修改:

或者在輸入中攜帶一些圖片,最終成果就可以保留圖中的風格或者主要“人物”。

不知道這把有沒有打到你的心巴上?

反正建模師看了都要喊失業了……

如何做到?

據介紹,Magic3D快速、高質量地得到結果所采用的策略是“從粗到細”,一共經過兩階段:

低分辨率優化和高分辨率優化。

它使用eDiff-l作為模型的低分辨率文本到圖像擴散先驗(diffusion prior)。

首先,第一階段,采用英偉達今年推出的3D重建模型Instant NGP,并對其優化,生成初始3D模型。

具體來說,就是通過重復采樣和渲染低分辨率圖像,計算出SDS損失,讓Instant NGP給出結果。

注:SDS全稱得分蒸餾采樣(Score Distillation Sampling),是谷歌提出的一種新的采樣方法,它無需對擴散模型進行反向傳播更新。

這步完成后,就使用DMTet提取出初始3D mesh,作為第二階段的輸入。

第二階段采用高分辨率文本到圖像潛(latent)擴散先驗。

還是使用同樣的方法,對高分辨率圖像進行采樣和渲染,并使用相同的步驟進行更新,得到最終結果。

唯一的不同,就是本階段的操作都是在第一階段得出的初始“糙”模型上進行的。

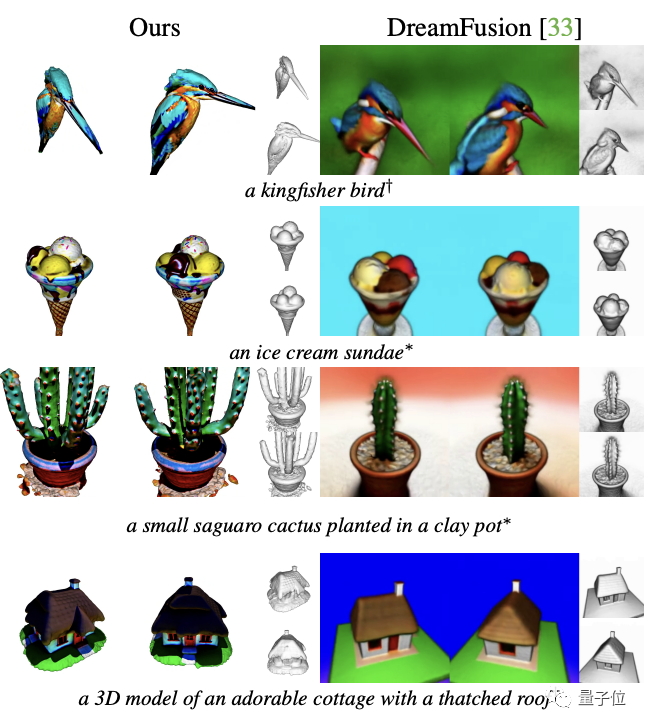

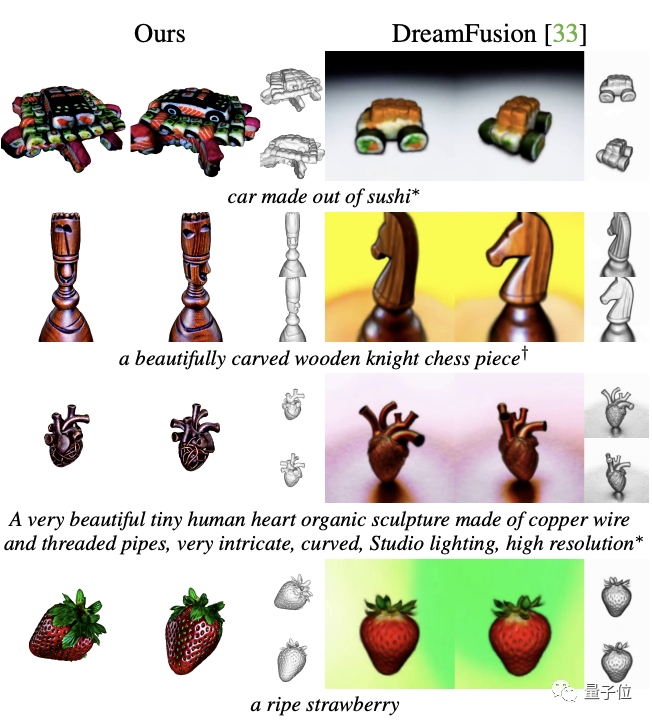

比DreamFusion分辨率高8倍,速度快2倍

關注這一領域的朋友知道,一句話生成3D模型的AI中,目前最受關注的當屬谷歌今年9月剛發布的DreamFusion。

它通過一個預先訓練的二維文本到圖像擴散模型來完成最終的文本到三維合成,效果驚艷。

那么,英偉達剛推出的這個Magic3D,與之相比如何?

經實驗對比發現,后來者顯然更勝一籌,主要表現在分辨率和速度上:

Magic3D的分辨率比DreamFusion高8倍,速度快2倍——只需在40分鐘之內即可完成一次渲染。

而在具體效果上,Magic3D的生成結果也更細節一些,比如下面的“仙人掌”、“房子”和“草莓”等(左為Magic3D,右為DreamFusion)。

不過,遺憾的是,Magic3D還并未像DreamFusion一樣已開源。

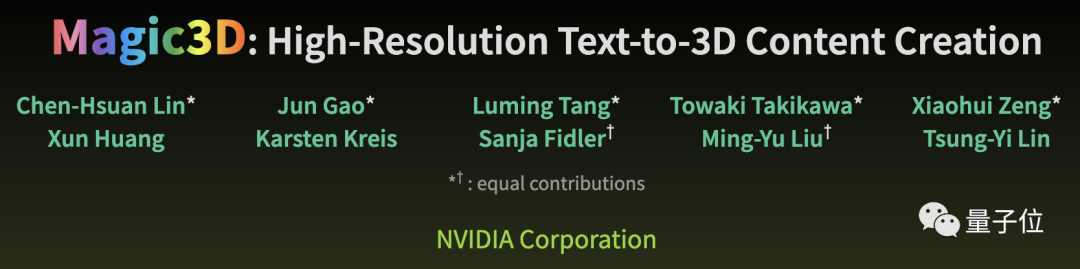

關于作者

一共有10位。

前5位都具有同等貢獻,包括:

現英偉達研究科學家、博士畢業于CMU機器人專業的Lin Chen-Hsuan,他曾在Facebook人工智能研究部和Adobe實習;

正在多倫多大學讀博士的Gao Jun,北大計算機本科畢業;

正在多倫多讀博士的Zeng Xiaohui,香港科技大學畢業;

以及同樣來自該大學的Towaki Takikawa;

最后是正在康奈爾大學讀博士的唐路明,清華大學物理和數學專業本科畢業。

論文地址:https://arxiv.org/abs/2211.10440

項目主頁:https://deepimagination.cc/Magic3D/