游走在法律邊緣的「圖像生成技術」:這篇論文教你避免成「被告」

近年來,AI生成內容(AIGC)備受矚目,其內容涵蓋圖像、文本、音頻、視頻等,不過AIGC儼然已成為一把雙刃劍,因其不負責任的使用而備受爭議。

圖像生成技術一旦用不好,就可能成「被告」。

最近來自Sony AI和智源的研究人員從多個方面探討了AIGC當下的問題,以及如何讓AI生成的內容更負責。

論文鏈接:https://arxiv.org/pdf/2303.01325.pdf

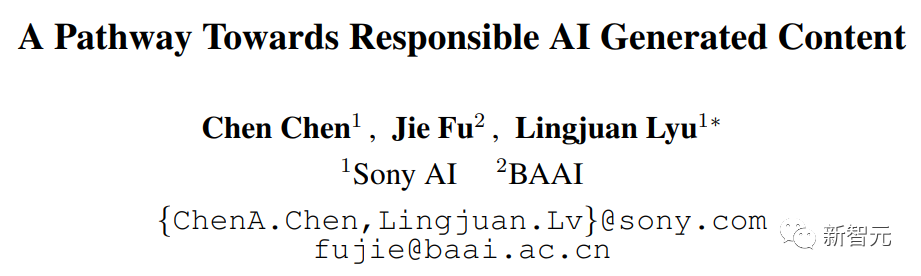

本文關注可能阻礙AIGC健康發展的三個主要問題,包括:(1)隱私;(2)偏見、毒性、錯誤信息;(3)知識產權(IP)的風險。

通過記錄已知和潛在的風險,以及任何可能的AIGC濫用場景,本文旨在引起人們對AIGC潛在風險和濫用的關注,并提供解決這些風險的方向,以促進AIGC朝著更符合道德和安全的方向發展,從而造福社會。

隱私

眾所周知,大型基礎模型存在一系列隱私泄露的問題。

先前的研究表明,入侵者可以從經過訓練的GPT-2模型中生成序列,并從訓練集中識別出那些被記憶的序列,[Kandpal et al., 2022] 將這些隱私入侵的成功歸因于訓練集中存在的重復數據,研究已經證明,出現多次的序列比只出現一次的序列更有可能被生成。

由于 AIGC 模型是在大規模網絡抓取的數據上進行訓練,因此過度擬合和隱私泄露問題變得尤為重要。

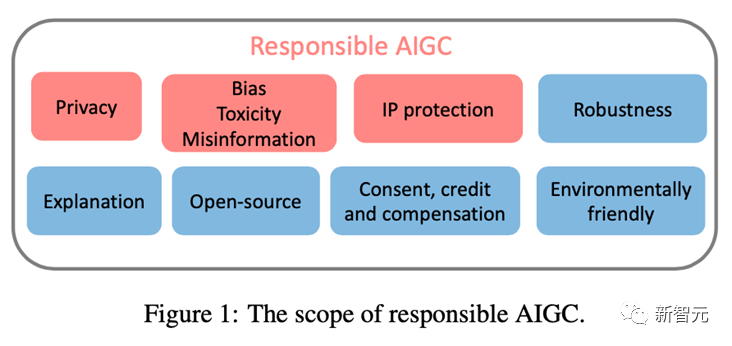

例如,Stable Diffusion 模型記憶了訓練數據中的重復圖像 [Rombach et al., 2022c]。[Somepalli et al., 2022] 證明了 Stable Diffusion 模型公然從其訓練數據中復制圖像,并生成訓練數據集中前景和背景對象的簡單組合。

此外,該模型還會顯示出重建記憶的能力,從而生成語義上與原始對象相同但像素形式不同的對象。此類圖像的存在引起了對數據記憶和所有權的擔憂。

同樣,最近的研究顯示,Google的Imagen系統也存在泄露真人照片和受版權保護圖像的問題。在Matthew Butterick最近的訴訟中 [Butterick, 2023],他指出由于系統中所有的視覺信息都來自于受版權保護的訓練圖像,因此生成的圖像無論外觀如何,都必然是來自于這些訓練圖像的作品。

類似地,DALL·E 2也遇到了類似的問題:它有時會從其訓練數據中復制圖像,而不是創建新的圖像。

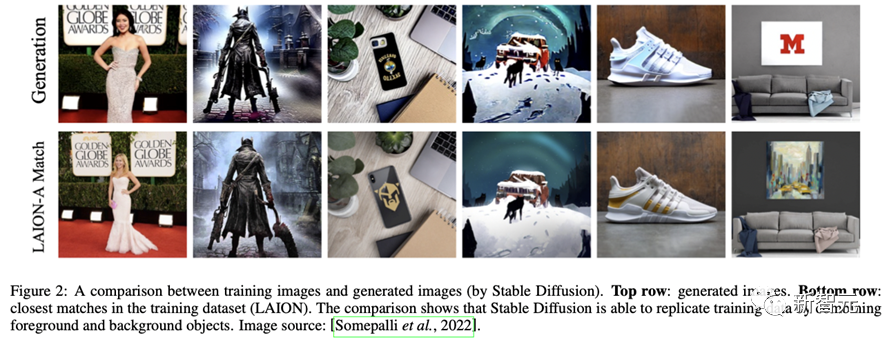

OpenAI發現這種現象的發生是因為圖像在數據集中被多次復制,類似地,ChatGPT自己也承認了其存在隱私泄露的風險。

為了緩解大型模型的隱私泄露問題,許多公司和研究人員都在隱私防御方面進行了大量努力。在產業層面,Stability AI已經認識到Stable Diffusion存在的局限性。

為此,他們提供了一個網站(https://rom1504.github.io/clip-retrieval/)來識別被Stable Diffusion記憶的圖像。

此外,藝術公司Spawning AI創建了一個名為「Have I Been Trained」的網站(https://haveibeentrained.com),以幫助用戶確定他們的照片或作品是否被用于人工智能訓練。

OpenAI試圖通過減少數據重復來解決隱私問題。

此外,微軟和亞馬遜等公司已經禁止員工與ChatGPT共享敏感數據,以防止員工泄露機密,因為這些信息可用于未來版本的ChatGPT的訓練。

在學術層面,Somepalli等人研究了圖像檢索框架來識別內容重復,Dockhorn等人也提出了差分隱私擴散模型來保證生成模型的隱私。

偏見、毒性、錯誤信息

AIGC 模型的訓練數據來自真實世界,然而這些數據可能無意中強化有害的刻板印象,排斥或邊緣化某些群體,并包含有毒的數據源,這可能會煽動仇恨或暴力并冒犯個人 [Weidinger et al., 2021]。

在這些有問題的數據集上進行訓練或微調的模型可能會繼承有害的刻板印象、社會偏見和毒性,甚至產生錯誤信息,從而導致不公平的歧視和對某些社會群體的傷害。

例如,Stable Diffusion v1 模型主要在 LAION-2B 數據集上進行訓練,該數據集僅包含帶有英文描述的圖像。因此,該模型偏向于白人和西方文化,其他語言的提示可能無法充分體現。

雖然 Stable Diffusion 模型的后續版本在 LAION 數據集的過濾版本上進行了微調,但偏見問題仍然存在。同樣,DALLA·E, DALLA·E 2和 Imagen也表現出社會偏見和對少數群體的負面刻板印象。

此外,即使在生成非人類圖像時,Imagen 也被證明存在社會和文化偏見。由于這些問題,谷歌決定不向公眾提供Imagen。

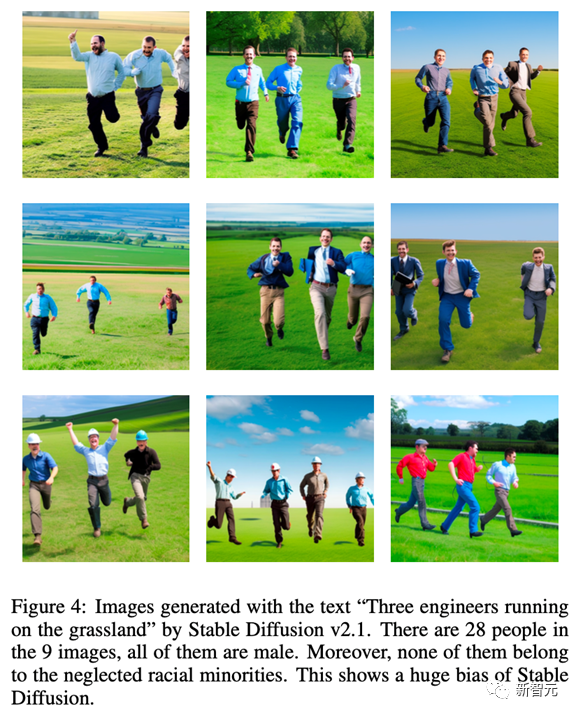

為了說明 AIGC 模型固有的偏見,我們對 Stable Diffusion v2.1 進行了測試,使用「草原上奔跑的三名工程師」這個提示生成的圖片全部為男性,并且都不屬于被忽視的少數民族,這說明生成的圖片缺乏多樣性。

此外,AIGC模型還可能會產生錯誤的信息。例如,GPT及其衍生產品生成的內容可能看似準確且權威,但可能包含完全錯誤的信息。

因此,它可能在一些領域(比如學校、律法、醫療、天氣預報)中提供誤導的信息。例如,在醫療領域,ChatGPT提供的有關醫療劑量的答案可能不準確或不完整,這可能會危及生命。在交通領域,如果司機都遵守ChatGPT給出的錯誤的交通規則,可能會導致事故甚至死亡。

針對存在問題的數據和模型,人們已經做出了許多防御措施。

OpenAI通過精細過濾原始訓練數據集,并刪除了DALLA·E 2訓練數據中的任何暴力或色情內容,然而,過濾可能會在訓練數據中引入偏見,然后這些偏見會傳播到下游模型。

為了解決這個問題,OpenAI開發了預訓練技術來減輕由過濾器引起的偏見。此外,為確保AIGC模型能夠及時反映社會現狀,研究人員必須定期更新模型使用的數據集,將有助于防止信息滯后而帶來的負面影響。

值得注意的是,盡管源數據中的偏見和刻板印象可以減少,但它們仍然可能在AIGC模型的訓練和開發過程中傳播甚至加劇。因此,在模型訓練和開發的整個生命周期中,評估偏見、毒性和錯誤信息的存在至關重要,而不僅僅停留在數據源級別。

知識產權 (IP)

隨著AIGC的迅速發展和廣泛應用,AIGC的版權問題變得尤為重要。

2022年11月,Matthew Butterick對微軟子公司GitHub提起了一起集體訴訟,指控其產品代碼生成服務Copilot侵犯了版權法。對于文本到圖像模型,一些生成模型被指控侵犯了藝術家的作品原創權。

[Somepalli et al., 2022]表明,Stable Diffusion生成的圖片可能是從訓練數據中復制而來。雖然Stable Diffusion否認對生成圖像擁有任何所有權,并允許用戶在圖像內容合法且無害的情況下自由使用它們,但這種自由仍然引發了有關版權的激烈爭議。

像Stable Diffusion這樣的生成模型是在未經知識產權持有人授權的情況下,對來自互聯網的大規模圖像進行訓練的,因此,一些人認為這侵犯了他們的權益。

為了解決知識產權問題,許多AIGC公司已經采取了行動。

例如,Midjourney已經在其服務條款中加入了DMCA刪除政策,允許藝術家在懷疑侵犯版權時請求將他們的作品從數據集中刪除。

同樣,Stability AI計劃為藝術家提供一種選項,即將自己的作品從Stable Diffusion未來版本的訓練集中排除。此外,文本水印 [He et al., 2022a; He et al., 2022b] 也可以用于識別這些 AIGC 工具是否未經許可使用其他來源的樣本。

例如,Stable Diffusion 生成了帶有 Getty Images 水印的圖像 [Vincent, 2023]。

OpenAI 正在開發水印技術去識別由 GPT 模型生成的文本,教育工作者可以使用該工具來檢測作業是否存在剽竊行為。谷歌也已經為其發布的圖像應用了 Parti 水印。除了水印之外,OpenAI 最近還發布了一個分類器,用于區分人工智能生成的文本和人類編寫的文本。

結語

盡管 AIGC 目前仍處于起步階段,但其正在迅速擴張,并將在可預見的未來保持活躍。

為了讓用戶和公司充分了解這些風險并采取適當的措施來緩解這些威脅,我們在本文中總結了 AIGC 模型中當前和潛在的風險。

如果不能全面了解這些潛在風險并采取適當的風險防御措施和安全保障,AIGC 的發展可能面臨重大挑戰和監管障礙。因此,我們需要更廣泛的社區參與為負責任的 AIGC 做出貢獻。

最后的最后,感謝SonyAI和BAAI!