Nature|GPT-4被吹爆,科學家擔憂溢屏!

GPT-4的橫空出世,既讓人興奮,又讓人沮喪。

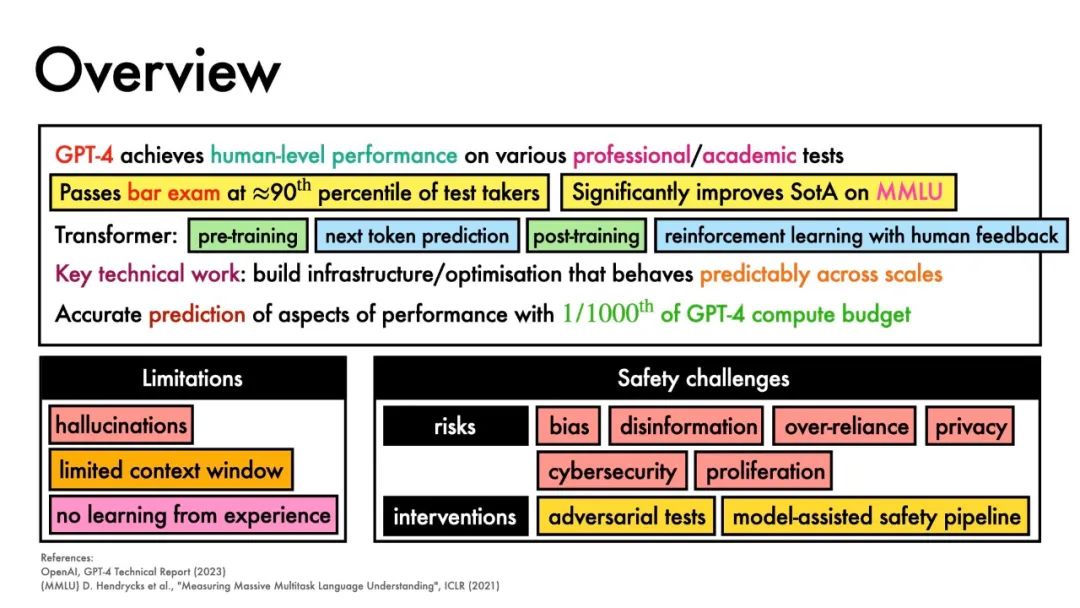

盡管GPT-4擁有讓人震驚的創造力,推理能力,但科學家們卻對這項技術的安全性表示出擔憂。

由于OpenAI違背初衷,并未開源GPT-4、公布模型的訓練方法和數據,因此它的實際工作情況也無從得知。

科學界對此感到十分沮喪。

開源AI社區HuggingFace專門從事環境研究的科學家Sasha Luccioni表示,「OpenAI可以在他們的研究基礎上繼續發展,但對于整個社區來說,所有這些閉源模型,在科學上就像是一個死胡同。」

還好有紅隊測試

羅切斯特大學的化學工程師Andrew White作為 「紅隊」(red-teamer) 成員,享有訪問GPT-4的特權。

OpenAI付錢給紅隊,讓其負責測試平臺,試圖讓它做一些壞事。所以Andrew White在過去的6個月里,一直有機會接觸到GPT-4。

他向GPT-4提問,制造一種化合物需要哪些化學反應步驟,讓其預測反應產量,并選擇一種催化劑。

「與以前的迭代相比,GPT-4似乎沒有什么不同,我也覺著沒什么。但是后來它真的很令人驚訝,它看起來如此逼真,它會在這里幻化出一個原子,又在那里跳過一個步驟。」

但是當他繼續測試,并讓GPT-4訪問論文時,事情發生了巨大的變化。

「我們突然意識到,這些模型也許并不是那么出色。但是當你開始將它們連接到像回溯合成計劃器或計算器這樣的工具時,突然間,新的能力出現了。」

隨著這些能力的出現,人們開始擔心。例如,GPT-4能否允許制造危險的化學品?

Andrew White表明,有了像White這樣的紅隊人的測試投入,OpenAI的工程師們將其反饋到他們的模型中,就可以阻止GPT-4創造危險、非法或破壞性的內容。

虛假的事實

輸出虛假信息是另一個問題。

Luccioni 說,像GPT-4這樣的模型還無法解決它出現幻覺的問題,也就是說還會胡言亂語。

「你不能依賴這類模型,因為有太多的幻覺,盡管OpenAI說它在GPT-4中已經提高了安全性,這在最新版本中仍然是一個問題。」

由于無法獲得用于訓練的數據,OpenAI對安全性的保證在Luccioni看來是不夠的。

「你不知道數據是什么。所以你無法改善它。用這樣的模型做科學是完全不可能的。」

關于GPT-4如何訓練,這一謎團也一直困擾著心理學家Claudi Bockting:「要人類去對你無法監督的東西負責,這是非常困難的。」

Luccioni 也認為GPT-4會被訓練數據加深偏見,而如果不能訪問GPT-4背后的代碼,就不可能看到偏見可能起源于哪里,也不可能對其進行補救。

倫理討論

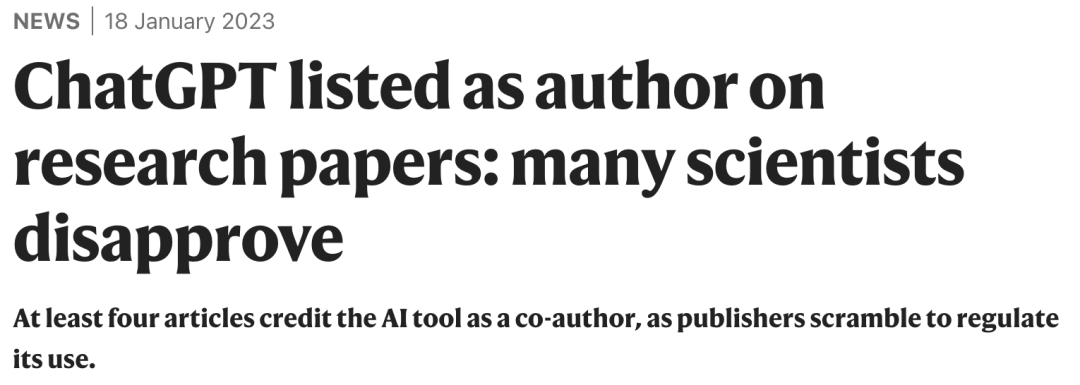

科學家們對GPT一直持保留態度。

在ChatGPT推出時,科學家們就已經反對過GPT出現在作者欄里。

出版商們也都認為,ChatGPT等人工智能不符合研究作者的標準,因為它們不能對科學論文的內容和完整性負責。不過人工智能對撰寫論文的貢獻可以在作者名單以外的部分得到承認。

此外,人們還擔心,這些人工智能系統越來越多地掌握在大型科技公司手中。這些技術應該得到科學家的測試和驗證。

我們迫切需要制定一套指導方針,來管理人工智能和GPT-4等工具的使用和發展。

White說,盡管有這樣的擔憂,GPT-4及其未來的迭代將撼動科學:「我認為它將成為科學領域的一個巨大的基礎設施變化,就像互聯網一樣的巨大的變化。我們開始意識到,我們可以連接論文、數據程序、圖書館、計算工作甚至機器人實驗。它不會取代科學家,但可以幫助完成一些任務。」

但是,似乎圍繞人工智能技術的任何立法難以跟上發展的步伐。

4月11日,阿姆斯特丹大學將召開一次邀請性峰會,與來自聯合國教科文組織科學倫理委員會、經濟合作與發展組織和世界經濟論壇等組織的代表討論這些問題。

主要話題包括堅持對LLM輸出進行人工檢查;在科學界內,相互建立問責規則,旨在實現透明度、誠信和公平;投資由獨立非營利組織擁有的可靠和透明的大語言模型;擁抱 AI 的優勢,但是必須在人工智能的好處和失去自主性之間做出權衡;邀請科學界與相關方(從出版商到倫理學家)討論GPT等等。