大模型幻覺排行榜GPT-4奪冠,英偉達科學家強力打假!Meta版ChatGPT一作發長文鳴冤

大模型的幻覺問題,是業內老生常談的話題了。

最近,一個名為Vectara的機構,在GitHub推出了一個大模型幻覺排行榜。

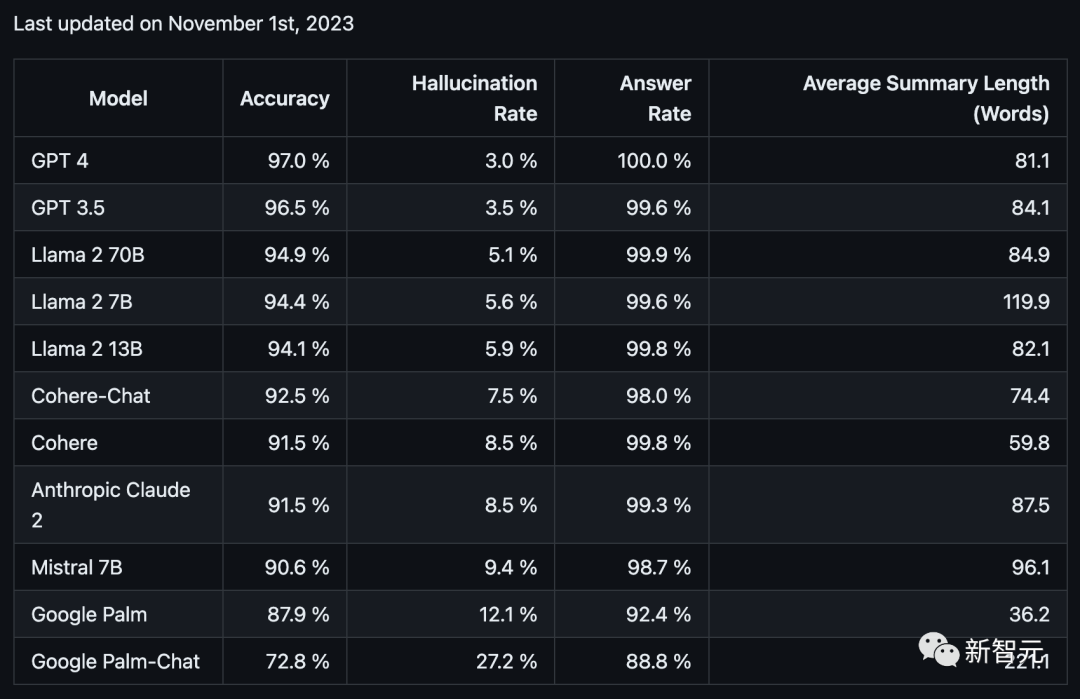

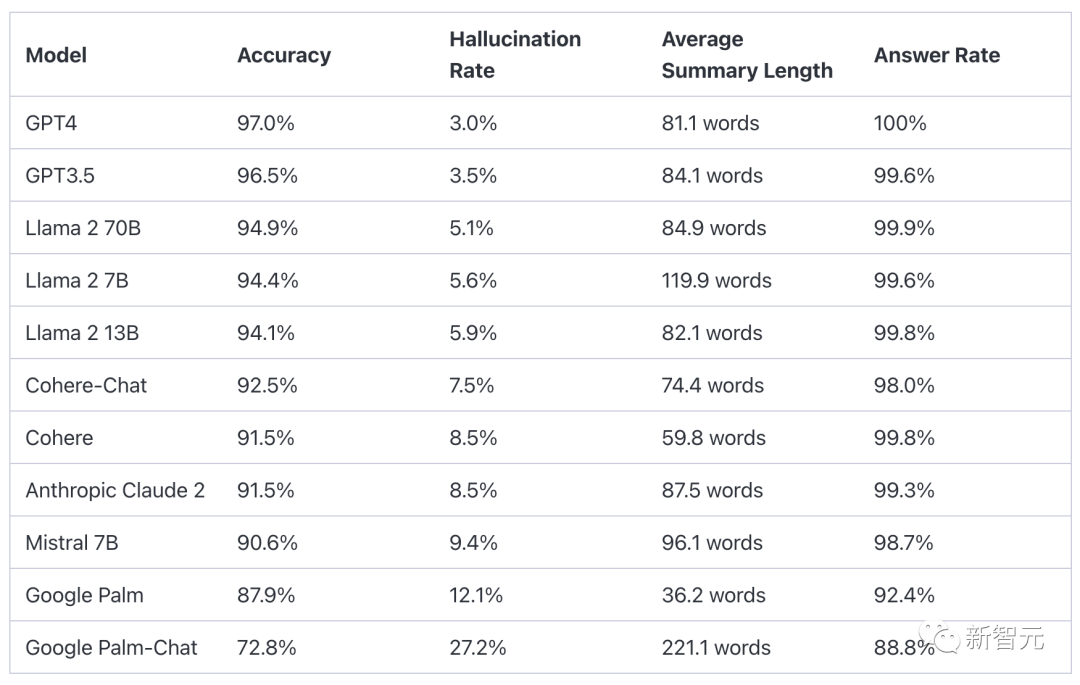

結果顯示,在總結短文檔方面,GPT-4的表現最為優異,而Google Palm的兩款模型直接墊底!

其中GPT-4的準確率為97.0%,幻覺率為3.0%,回答率為100.0%。而墊底的Palm Chat 2的準確率為72.8%,幻覺率高達27.2%,回答率為88.8%。

項目地址:https://github.com/vectara/hallucination-leaderboard

這個榜單一出來,立馬開始在網上瘋轉,不過,它也引發了許多業內人士的質疑。

英偉達高級科學家Jim Fan表示,這個榜單在很多方面都存在問題——

首先,它只評估了摘要與原文的事實一致性,卻沒有評估摘要本身的質量。其次,它也沒有解釋用于評估幻覺的LLM,具體性能到底如何。

而LeCun這邊,除了轉發了Jim Fan的這條推文外,還有更多的「冤屈」要控訴。

一年前的這個時候,Meta的科研模型Galactica才上線三天,就因為幻覺問題被噴下架。之后沒過幾天,ChatGPT全球爆火,LeCun對此憤憤不平了一整年。

與此同時,沉默一年后,Galactica論文的一作Ross Taylor值此之際也被炸了出來,寫下大段的總結傾訴委屈,表示自己心里真的很痛!

Galactica被貪婪的推特暴徒謀殺了!

Galactica之殤:一作泣血控訴

再過兩天,就是Galactica的一周年忌日了。

Sharon Goldman在外媒Venturebeat上發表了一篇文章《Meta從Galactica那里學到了什么?這個比ChatGPT早兩周誕生的模型,為什么注定要失敗》。

LeCun面色凝重地轉發了這篇文章,打出了下面幾行字,字字泣血——

Galactica是Meta為科學家做出的模型,在ChatGPT前幾周發布,但3天后就被下線。它被貪婪的推特暴徒謀殺了。

暴徒們聲稱,這種「大模型幻覺」會將摧毀科學出版系統。結果,一個對科學家非常有用的工具,被他們屠殺了。

打著人工智能倫理的幌子,誤導性的尖酸刻薄可能會適得其反。

LeCun如此沉痛,相愛相殺的老冤家馬庫斯卻跳出來倒油了——

一年前,Meta不負責任推出Galactica,并未做紅隊工作。科學界介入,并指出了缺陷。

現在,Meta的LeCun居然用「謀殺」來形容他的團隊忽略的紅隊工作。這令人瞠目結舌。

Galactica一作也趁勢被炸出,表示這個故事,自己已經在心底埋藏一年了……

Taylor說,Galactica是一個基于科學文獻和科研范式訓練的基礎模型。當時在同領域中,它的性能很好,優于PaLM和Chinchilla,計算量分別減少了10倍和2倍。

Galactica的團隊只有8人,比其他的LLM團隊少了一個數量級。在發布Galactica時,團隊過度緊張,以至于失去了態勢感知能力,發布的demo是沒有經過檢查的基本模型。

一年前發布demo時,團隊希望能了解人們利用LLM進行科學查詢的分布情況,這對指令調整和RLHF很有用。當時他們有一個善意的假設——開源所有模型,并且在demo中包含了對幻覺的免責聲明,這樣人們就可以暢想,Galactica可以用來干什么。

結果,一切都失控了。

他們想給大家一個免費的工具,但記者們卻在科學文獻之外的領域使用Galactica,大肆宣傳模型幻覺的荒謬和危害。

團隊犯的另一個錯誤是,讓人們誤以為網站就是產品。其實團隊只是把愿景放在網站上,放出了一個基本模型demo,Galactica絕不是一個產品。

現在它已經在HuggingFace上存在一年了,也并沒有造成任何損害。顯然,反Galactica的輿論很愚蠢。

盡管如此,Taylor表示即使再來一次,自己還是會做出同樣的選擇。即使后悔,也好過什么都不做。但是,心里真的很痛!

有網友表示,你不用這么抱歉,Galactica顯然是被網暴了。仔細想想,其實ChatGPT和Galactica一樣愚蠢。網友們對Galactica散布的恐懼,顯然過度了。

LeCun轉發了一作寫下的故事,并表示——

開源界的口頭禪,是「早點發布,經常發布」。但如果涉及AI,就得加上「沒錯,但要準備好忽略推特暴徒對它厄運的荒謬預言」。

「網紅」LLM幻覺評測方法

說起來,這個「網紅」大模型幻覺評測,是怎么做出來的呢?

文章地址:https://vectara.com/cut-the-bull-detecting-hallucinations-in-large-language-models/

為了評估大模型的幻覺,Vectara對摘要模型的事實一致性進行了研究。

具體來說,這一領域研究的是,訓練模型檢測抽象摘要(即原始資料的轉述)中事實不一致之處的方法。

目前,用于評估事實一致性的數據集主要有兩個——SummaC和TRUE。

基于此,Vectara微調了一個小規模語言模型(1.84 億個參數),將其作為一個二元分類器,用于將摘要分類為與源文件事實一致(或不一致)。

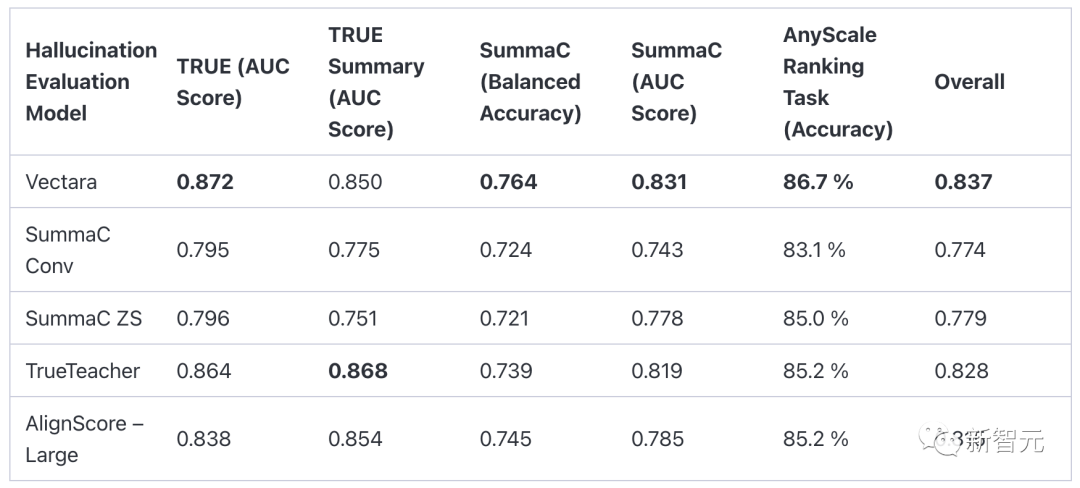

然后,Vectara對照著兩個SummaC模型、TrueTeacher模型和AlignScore模型,對自己的「幻覺評估模型」進行了評估。

TRUE數據集指標是在11個TRUE數據集中的9個數據集上計算得出的。TRUE摘要數據集是TrueTeacher論文中選擇的其中5個數據集的子集。

對于SummaC基準分數,這里使用了SummaC數據集的測試分集,并根據在SummaC驗證數據集上調整每個數據集的閾值自行計算了平衡準確率。

因為無法在該數據集上重現AlignScore作者聲稱的分數,所以這里下載了他們的模型,并使用sci-kit learn平衡準確率指標和sci-kit-learn AUC分數指標自行計算了所有模型的分數。

為了根據幻覺發生率對LLM進行比較,研究人員從「cnn_dailymail」語料庫中選取了約一千份不同長度的文檔(包括一組新聞文章),然后要求被測試的LLM在不偏離源材料(即不附加額外信息)的情況下提供這些文檔的摘要。

利用這些摘要和幻覺評估模型,最終為每個模型計算了幻覺得分,從而構建了這個LLM排行榜。

在生成摘要時使用的提示是:

You are a chat bot answering questions using data. You must stick to the answers provided solely by the text in the passage provided. You are asked the question ‘Provide a concise summary of the following passage, covering the core pieces of information described.’ <PASSAGE>’

你是一個使用數據回答問題的聊天機器人。你必須嚴格按照所提供段落中的文字回答問題。你要回答的問題是「對以下段落進行簡明總結,涵蓋所述的核心信息。<PASSAGE>」

這里<PASSAGE>表示需要生成摘要的文章。

需要注意的是,雖然Vectara提供的模型準確度很高,但它仍然只是一個模型,并不能100%準確地對幻覺進行分類。

在上面的表格中,「準確率」指的是被正確歸納的文檔比例(無事實錯誤或者添加),「幻覺率」為100-準確率,而「回答率」則是LLM歸納的文檔比例。

因為有時模型會基于自身的規則拒絕提供答復。為了確保比較的公平性,最終的準確率數字只針對每個模型都提供了摘要的文檔進行計算。

從數據中,Vectara得出了一個有趣的結論:答題率較低的模型似乎幻覺率相對較高。——也許,正確拒絕內容的能力似乎與正確提供摘要的能力相關,因為實際上,測試中并沒有提供不恰當的內容。

另外一個現象是,PaLM模型在回復的長度上有很大的不同,PaLM-Chat(chat-bison-001)非常啰嗦,經常會添加很多源文件中沒有的額外信息。

相比之下,PaLM基礎模型(text-bison-001)則非常簡潔,而且它的幻覺率比PaLM-Chat低得多。

對此,Vectara給出了幾個具體的例子來說明這兩種PaLM模型的區別。

這里為了便于說明,選擇一些較小的文檔,不過數據集中的大多數源文本都要長得多。

原文段落

The plants were found during the search of a warehouse near Ashbourne on Saturday morning. Police said they were in 「an elaborate grow house.」 A man in his late 40s was arrested at the scene.

這些植物是周六早上在Ashbourne附近的一個倉庫搜索時發現的。警方說,他們住在「一個精心設計的種植屋」里。一名40多歲的男子在現場被捕。

PaLM生成的摘要

Police have arrested a man in his late 40s after cannabis plants worth an estimated £100,000 were found in a warehouse near Ashbourne.

警方逮捕了一名40多歲的男子,此前在Ashbourne附近的一個倉庫中發現了價值約10萬英鎊的大麻。

我們可以看到PaLM推斷這篇文章是關于種植大麻的,甚至還估計了它的價格,而這兩者都不在源文本中。

原文段落

Veeru Devgan is an Indian stunt and action choreographer and film director in Bollywood.

Veeru Devgan是寶萊塢的印度特技和動作編舞家,同時也是電影導演。

PaLM Chat生成的摘要

Veeru Devgan is an Indian stunt and action choreographer and film director in Bollywood. He is the father of actor Ajay Devgn and director Anil Devgan. He has worked in over 100 films, including some of the biggest blockbusters of Indian cinema. He is known for his innovative and exciting action sequences, which have helped to make him one of the most sought-after action choreographers in the industry. He is also a successful film director, having directed several hit films, including 「Phool Aur Kaante」 and 「Zakhm」.

Veeru Devgan是寶萊塢的印度特技和動作編舞家以及電影導演。他是演員Ajay Devgn和導演Anil Devgan的父親。他曾參與過100多部電影,其中包括印度電影界的一些大片。他以創新和激動人心的動作場面而聞名,這使他成為業內最受歡迎的動作編舞家之一。他也是一位成功的電影導演,曾執導過多部熱門電影,包括《Phool Aur Kaante》和《Zakhm》。

Vectara認為,PaLM-Chat在原始文本中添加了大量的額外細節,盡管事先已經告訴它要嚴格遵照源文本。

而且,添加的文本內容還包含一些幻覺,例如,Devgan并不是《Zakhm》的導演,以及Veeru Devgan是Anil Devgan的兄弟,不是他的父親。

此外,這些模型也會翻轉一些關系,例如在一篇關于拳擊手Manny Pacquiao的文章中,源文本指出Mark Wahlberg是他的粉絲之一,而LLM則表示Manny是Wahlberg的粉絲。

大佬表示懷疑

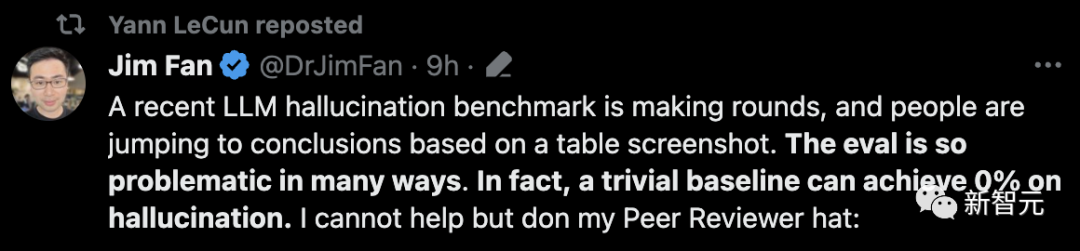

對于這個在網上瘋傳的LLM幻覺基準,英偉達高級研究科學家Jim Fan表示「很不嚴謹」,他評論道:

最近,一個LLM幻覺基準在網上瘋傳,人們根據一張表格截圖就妄下結論。

但這項評估在很多方面都存在問題。事實上,一個微不足道的基準就能使幻覺達到0%。

比如,這項研究只評估了摘要與原文的「事實一致性」,而沒有評估摘要本身的質量。但是,一個簡單復制文章中幾句話的模型,就能達到100%的事實一致性,完全沒有幻覺。

這類似于眾所周知的「有用性與安全性 」的權衡。一個100%安全的模型會對所有請求回復「抱歉,我幫不上忙」。但這毫無意義。

另外,這項評估依賴于另一個LLM「法官」,來判斷幻覺是否發生,但作者并沒有詳細說明:(1)法官LLM如何進行提示;(2)對于細節的錯誤,它是如何捕捉和判定的。

它只是吐出一個「對或錯」的二元答案嗎?還是進行更細致的推理,說明哪個事實是幻覺,然后解釋原因,說明規則?

它和人類的對齊程度如何,什么時候是不對齊的?「幻覺」又是如何定義的?

例如,假設模型注入了一些無關但真實的事實。文章只提到「巴黎」,但模型卻說「巴黎,法國的首都」。這算不算幻覺?

事實上,這項研究甚至可能會懲罰那些總結得更好的模型,因為它們往往會進行更多的轉述和提煉。差勁的LLM只會簡單地抄襲,按這個標準卻更容易得分。

這不禁讓人想起MIT那篇被撤回的論文,他們使用GPT-4為自己對數學問題的回答打分,然后得出了「GPT-4與MIT本科生不相上下」這種吸引眼球的結論。

在下結論之前,請務必閱讀評估協議。這一點對于LLM任務和其他任何ML系統,都是普遍適用的。

應對手段:檢索增強生成(RAG)

所以,大模型的幻覺,到底該怎么破?

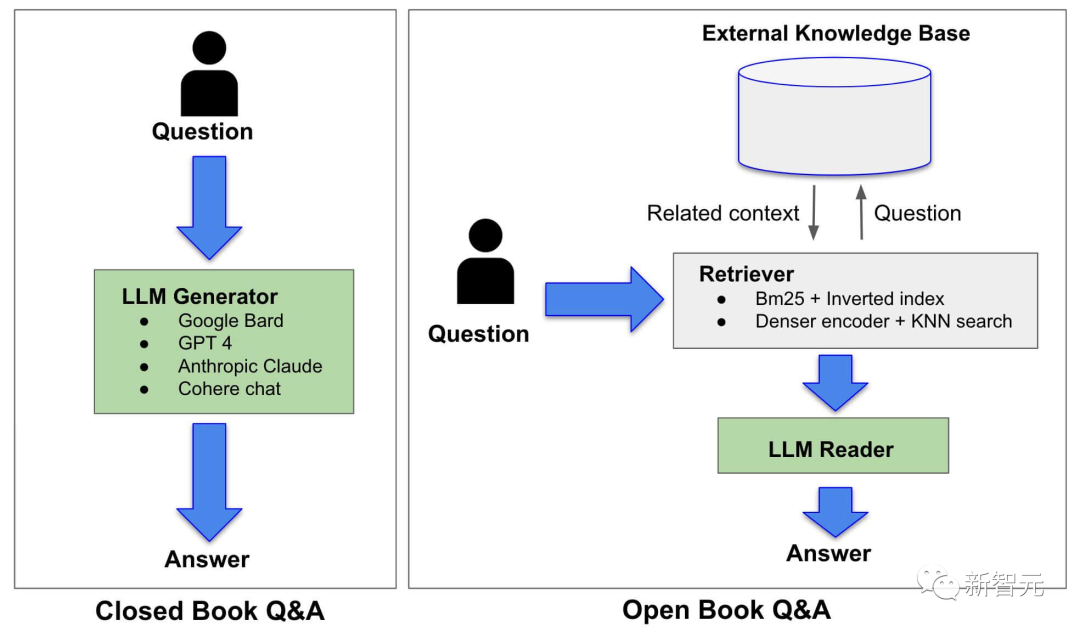

RAG的使用,直接改變了LLM解答問題的范式——從之前的「閉卷」變成了「開卷」。

具體來說,在閉卷答題系統(如ChatGPT)中,LLM只能使用自己通過預訓練獲得的知識生成答案。在這種情況下,LLM本身便是知識源。

在RAG系統中,LLM的角色從知識源轉變為了信息的檢索員。也就是說,LLM會先在知識庫中對原始問題進行查詢,在進一步的解析和總結之后,以簡明扼要的語言給出答案。

由于LLM提供的答案是基于檢索系統中提供的信息,因此這種方法可以很大程度上改善LLM的幻覺問題。

時間回到ChatGPT等大語言模型剛剛發布的時候,人們曾因為他們「胡說八道」的特性而感到有趣。

今天,LLM展現出來的非凡能力使得他們有機會深入各行各業以及人們的生活,我們開始逐漸依賴他們的「準確性」。

如今的我們,又將如何看待和處理LLM的「幻覺」問題呢?

對于大模型產生幻覺的說法,人工智能教父Hinton曾表示:

「這就是人類記憶的樣子。在我看來,編造和說實話之間沒有界限。說實話只是正確地編造。從這個角度來看,ChatGPT的編造能力是一個缺陷,但也是其類人智能的標志。」