單個GPU就能跑!UC伯克利領頭,130億參數「小羊駝」權重公布

3月31日,UC伯克利聯手CMU、斯坦福、UCSD和MBZUAI,推出了130億參數的Vicuna,俗稱「小羊駝」(駱馬),僅需300美元就能實現ChatGPT 90%的性能。?

今天,團隊正式發布了Vicuna的權重——只需單個GPU就能跑!

項目地址:https://github.com/lm-sys/FastChat/#fine-tuning

130億參數,90%匹敵ChatGPT

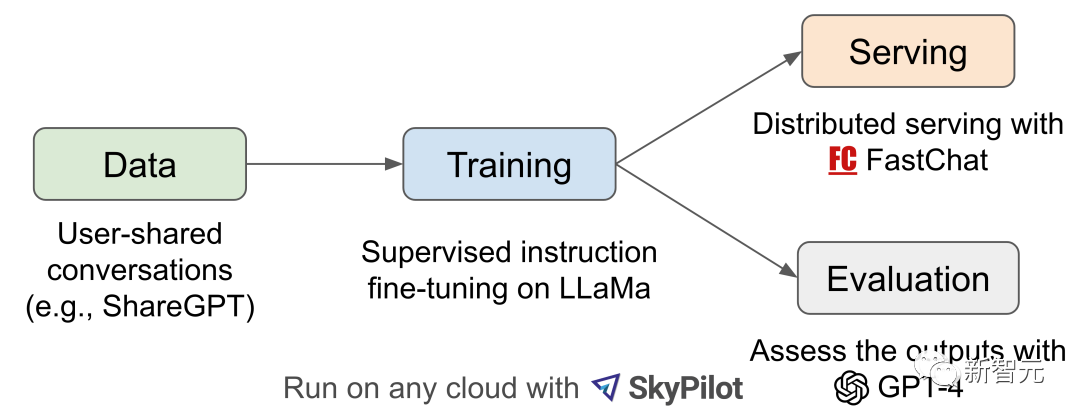

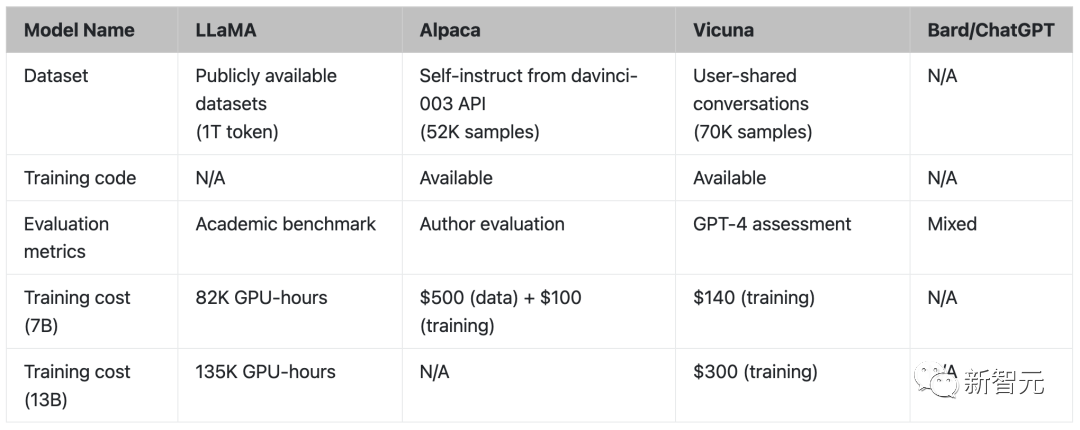

Vicuna是通過在ShareGPT收集的用戶共享對話上對LLaMA進行微調訓練而來,訓練成本近300美元。

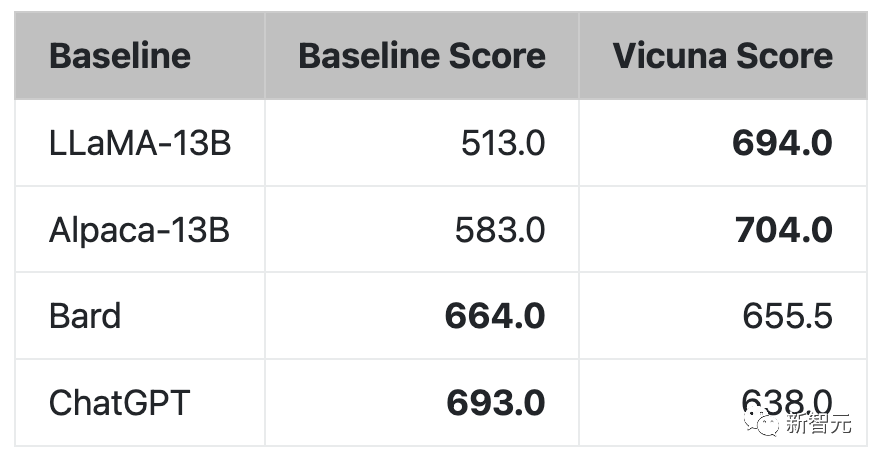

研究人員設計了8個問題類別,包括數學、寫作、編碼,對Vicuna-13B與其他四個模型進行了性能測試。

測試過程使用GPT-4作為評判標準,結果顯示Vicuna-13B在超過90%的情況下實現了與ChatGPT和Bard相匹敵的能力。同時,在在超過90%的情況下勝過了其他模型,如LLaMA和斯坦福的Alpaca。

訓練

Vicuna-13B的訓練流程如下:

首先,研究人員從ChatGPT對話分享網站ShareGPT上,收集了大約70K對話。接下來,研究人員優化了Alpaca提供的訓練腳本,使模型能夠更好地處理多輪對話和長序列。之后利用PyTorch FSDP在8個A100 GPU上進行了一天的訓練。

- 內存優化:

為了使Vicuna能夠理解長上下文,將最大上下文長度從Alpaca的512擴展到2048,這大大增加了GPU內存需求。在此,研究人員通過使用梯度檢查點和閃存注意力來解決內存壓力。

- 多輪對話:

通過調整訓練損失以考慮多輪對話,并僅在聊天機器人的輸出上計算微調損失。

- 通過Spot實例降低成本:

采用SkyPilot托管的Spot實例來降低成本,將7B模型的訓練成本從500美元降低到約140美元,將13B模型的訓練成本從約1000美元降低到300美元。

評估

在模型的質量評估方面,研究人員創建了80個不同的問題,并用GPT-4對模型輸出進行了評價。

為了比較不同的模型,研究人員將每個模型的輸出組合成一個單獨的提示,然后讓GPT-4評估哪個模型給出的回答更好。

其中,GPT-4在超過90%的問題中更喜歡Vicuna,而不是現有的SOTA開源模型(LLaMA、Alpaca)。

在45%的問題中,GPT-4認為Vicuna的回答和ChatGPT差不多甚至更好。

綜合來看,Vicuna在總分上達到ChatGPT的92%。

安裝使用

安裝

方法一:

方法二:

1. clone版本庫并變更目錄到FastChat文件夾

2. 安裝Package

權重

根據LLaMA模型的許可,權重將以delta的形式發布。只需將其加到原來的LLaMA權重上,就可以獲得最終的Vicuna權重。

1. 按照huggingface上的說明,獲得原始的LLaMA權重

2. 通過腳本,自動從團隊的Hugging Face賬戶上下載delta權重

使用

- 單個GPU

Vicuna-13B需要大約28GB的GPU顯存。

- 多個GPU

如果沒有足夠的顯存,則可以使用模型并行來聚合同一臺機器上多個GPU的顯存。

- 僅用CPU

如果想在CPU上運行,則需要大約60GB的內存。

Web UI

- 啟動控制器

- 啟動model worker

當進程完成模型的加載后,會看到「Uvicorn running on ...」。

- 發送測試消息

· 啟動gradio網絡服務器

現在,你就可以打開瀏覽器和模型聊天了。

微調

- 數據

Vicuna是通過使用從ShareGPT收集到的大約7萬個用戶共享的對話與公共API來微調一個LLaMA基礎模型而創建的。

為了確保數據質量,團隊將HTML轉換回markdown,并過濾掉一些不合適或低質量的樣本。此外,團隊還將冗長的對話分成較小的片段,以符合模型的最大上下文長度。

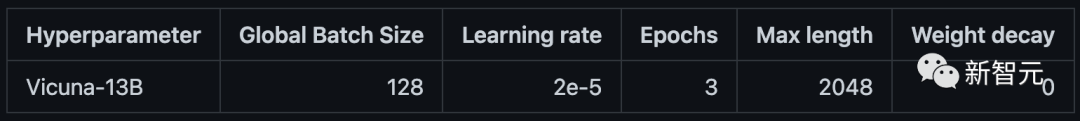

- 代碼和超參數

團隊使用斯坦福大學Alpaca的代碼對模型進行微調,并做了一些修改以支持梯度檢查點和Flash注意力。此外,團隊也使用與斯坦福Alpaca相似的超參數。

- 用SkyPilot在云服務上進行微調

SkyPilot是由加州大學伯克利分校建立的一個框架,可以在任何與一個云服務(AWS、GCP、Azure、Lambda等)上輕松、經濟地運行ML工作負載。

安裝說明:https://skypilot.readthedocs.io/en/latest/getting-started/installation.html

Vicuna可以在8個擁有80GB內存的A100 GPU上進行訓練。下面的命令將自動啟動一個滿足要求的節點,在上面設置并運行訓練作業。

對于Alpaca來說,訓練作業會在具有4個A100-80GB GPU的單一節點上啟動。

Vicuna也可以用以下代碼在8個A100 GPU上訓練,顯存為80GB。

如果要在更少的GPU上訓練,則可以減少per_device_train_batch_size,并相應地增加gradient_accumulation_steps,以保持全局批大小不變。要設置環境,可以參見scripts/train-vicuna.yaml中的設置部分。

參考資料:

https://github.com/lm-sys/FastChat/#fine-tuning