現(xiàn)在自我調(diào)節(jié)是人工智能的控制標(biāo)準(zhǔn)

你是否擔(dān)心人工智能發(fā)展過(guò)快,可能會(huì)產(chǎn)生負(fù)面后果?你希望有一部國(guó)家法律來(lái)規(guī)范它嗎?如今,沒(méi)有新的法律來(lái)限制人工智能的使用,通常自我監(jiān)管成為采用人工智能的公司的最佳選擇——至少目前是這樣。

盡管“人工智能”取代“大數(shù)據(jù)”成為科技界最熱流行詞匯已經(jīng)很多年了,但2022年11月下旬ChatGPT的推出開(kāi)啟了一場(chǎng)人工智能淘金熱,這讓包括我們?cè)趦?nèi)的許多人工智能觀察者感到驚訝。在短短幾個(gè)月內(nèi),大量強(qiáng)大的生成人工智能模型吸引了世界的注意力,這要?dú)w功于它們模仿人類(lèi)語(yǔ)言和理解的非凡能力。

在ChatGPT的出現(xiàn)的推動(dòng)下,主流文化中生成模型的非凡崛起引發(fā)了許多關(guān)于這一切走向的問(wèn)題。人工智能能夠產(chǎn)生令人信服的詩(shī)歌和異想天開(kāi)的藝術(shù),這一令人驚訝的現(xiàn)象正在讓位于對(duì)人工智能負(fù)面后果的擔(dān)憂,從消費(fèi)者傷害和失業(yè),一直到虛假監(jiān)禁,甚至毀滅人類(lèi)。

這讓一些人非常擔(dān)心。上個(gè)月,一個(gè)人工智能研究人員聯(lián)盟尋求暫停開(kāi)發(fā)比GPT-4更大的新生成模型六個(gè)月(延展閱讀:公開(kāi)信敦促暫停人工智能研究),GPT-4是OpenAI上個(gè)月推出的大規(guī)模語(yǔ)言模型(LLM)。

圖靈獎(jiǎng)得主Yoshua Bengio和OpenAI聯(lián)合創(chuàng)始人Elon Musk等人簽署的一封公開(kāi)信表示:“先進(jìn)的人工智能可能代表著地球生命史的深刻變化,應(yīng)該以相應(yīng)的謹(jǐn)慎和資源進(jìn)行規(guī)劃和管理。”“不幸的是,這種水平的規(guī)劃和管理并沒(méi)有實(shí)現(xiàn)。”

毫不奇怪,對(duì)人工智能監(jiān)管的呼聲正在上升。民意調(diào)查顯示,美國(guó)人認(rèn)為人工智能不可信,希望對(duì)其進(jìn)行監(jiān)管,尤其是在自動(dòng)駕駛汽車(chē)和獲得政府福利等有影響力的事情上。

然而,盡管有幾項(xiàng)針對(duì)人工智能的新地方法律——比如紐約市的一項(xiàng)法律,該法律側(cè)重于在招聘中使用人工智能,執(zhí)法工作被推遲到本月——國(guó)會(huì)沒(méi)有專門(mén)針對(duì)接近終點(diǎn)線的人工智能的新聯(lián)邦法規(guī)(盡管人工智能已涉足金融服務(wù)和醫(yī)療保健等高度監(jiān)管行業(yè)的法律范疇)。

在人工智能的刺激下,一家公司該做什么?公司想要分享人工智能的好處并不奇怪。畢竟,成為“數(shù)據(jù)驅(qū)動(dòng)”的沖動(dòng)被視為數(shù)字時(shí)代生存的必要條件。然而,公司也希望避免使用人工智能不當(dāng)可能導(dǎo)致的負(fù)面后果,無(wú)論是真實(shí)的還是感知的。

人工智能是狂野的“西部世界”。人工智能律師事務(wù)所BNH.AI的創(chuàng)始人Andrew Burt曾說(shuō)過(guò),“沒(méi)有人知道如何管理風(fēng)險(xiǎn)。每個(gè)人都有不同的做法。”

話雖如此,公司可以使用幾個(gè)框架來(lái)幫助管理人工智能的風(fēng)險(xiǎn)。Burt建議使用人工智能風(fēng)險(xiǎn)管理框架(RMF: Risk Management Framework),該框架來(lái)自美國(guó)國(guó)家標(biāo)準(zhǔn)研究所(NIST),于今年早些時(shí)候定稿。

RMF幫助公司思考他們的人工智能是如何工作的,以及可能產(chǎn)生的潛在負(fù)面后果。它使用“地圖、測(cè)量、管理和治理”的方法來(lái)理解并最終降低在各種服務(wù)產(chǎn)品中使用人工智能的風(fēng)險(xiǎn)。

另一個(gè)人工智能風(fēng)險(xiǎn)管理框架來(lái)自O(shè)'Neil風(fēng)險(xiǎn)咨詢與算法審計(jì)(ORCAA)首席執(zhí)行官Cathy O'Neil。ORCAA提出了一個(gè)名為“可解釋的公平”的框架。

可解釋的公平性為組織提供了一種方法,不僅可以測(cè)試他們的算法是否存在偏見(jiàn),還可以研究當(dāng)檢測(cè)到結(jié)果差異時(shí)會(huì)發(fā)生什么。例如,如果一家銀行正在確定是否有資格獲得學(xué)生貸款,那么哪些因素可以合法地用于批準(zhǔn)或拒絕貸款或收取更高或更低的利息?

顯然,銀行必須使用數(shù)據(jù)來(lái)回答這些問(wèn)題。但是,他們可以使用哪些數(shù)據(jù),也就是說(shuō),哪些因素反映了貸款申請(qǐng)人?哪些因素在法律上應(yīng)該被允許使用,哪些因素不應(yīng)該被使用?O'Neil說(shuō),回答這些問(wèn)題既不容易也不簡(jiǎn)單。

O'Neil在上個(gè)月舉行的Nvidia GPU技術(shù)會(huì)議(GTC)上的一次討論中表示:“這就是這個(gè)框架的全部意義,即這些合法因素必須合法化。”

數(shù)據(jù)分析和人工智能軟件供應(yīng)商Dataiku人工智能的負(fù)責(zé)人Triveni Gandhi表示,即使沒(méi)有新的人工智能法律,公司也應(yīng)該開(kāi)始自問(wèn)如何公平、合乎道德地實(shí)施人工智能,以遵守現(xiàn)有法律。

“人們必須開(kāi)始思考,好吧,我們?nèi)绾慰创F(xiàn)有的法律,并將其應(yīng)用于目前存在的人工智能用例?”“有一些規(guī)定,但也有很多人在思考我們想要構(gòu)建人工智能的道德和價(jià)值導(dǎo)向方式。這些實(shí)際上是公司開(kāi)始問(wèn)自己的問(wèn)題,即使沒(méi)有總體規(guī)定。”

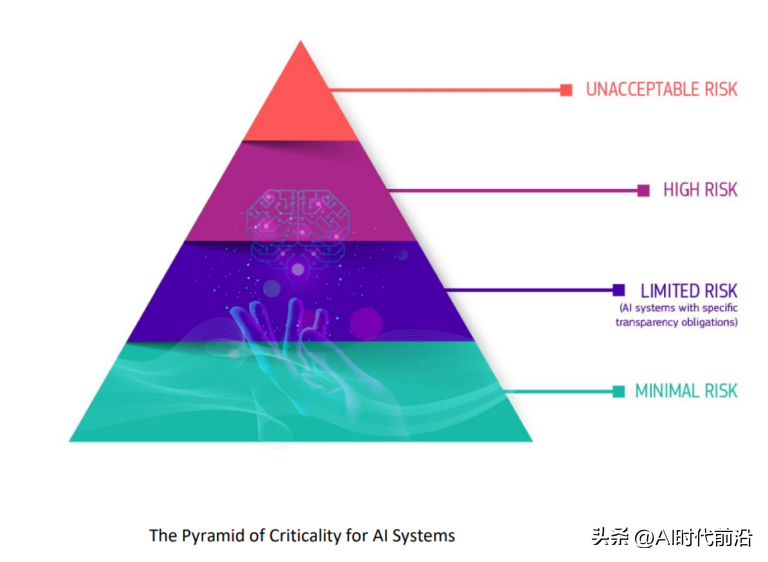

歐盟將人工智能的潛在危害歸類(lèi)為“臨界金字塔”

歐盟已經(jīng)在推進(jìn)自己的法規(guī),即《人工智能法案》,該法案可能在今年晚些時(shí)候生效。

《人工智能法案》將為影響歐盟居民的人工智能的使用創(chuàng)建一個(gè)共同的監(jiān)管和法律框架,包括人工智能的開(kāi)發(fā)方式、公司可以將其用于什么目的,以及不遵守要求的法律后果。該法律可能會(huì)要求公司在某些用例中采用人工智能之前獲得批準(zhǔn),并禁止某些被認(rèn)為風(fēng)險(xiǎn)太大的其他人工智能用途。