國產乾元2大模型來了:可編程金融文生圖,120億參數,超對稱聯手復旦出品

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

國產大模型隊伍正當“百模大戰”之際,現在又添一員——

BBT-2,全稱BigBang Tansformer-2(乾元2),120億參數的通用大模型。

以其為基礎,項目團隊還訓練出了代碼、金融、文生圖等專業模型。

根據官方數據,其中的代碼大模型在CSDN的自動編程評測標準上能達到C3,和GPT-3.5處于同一等級“條件自動編程”。

目前,專業的代碼問答,已有demo可在線試玩~

據悉,BBT系列模型其中3個即將開源到GitHub、UCloud和官網,開箱可用。

會一并開源的還有近1000億tokens的通用和金融預訓練語料,以及8個中文金融大模型的評測數據集。

而這個項目的背后,是超對稱公司和復旦大學知識工場實驗室。

術業有專攻的BBT-2系列

BBT-2,是基于GPT Decoder-only架構的大模型,同系列BBT-1模型的2億參數版本去年已經開源。

此次發布的BBT-2系列模型,包含以下6個:

- BBT-2-12B-Text:120億參數的中文基礎模型

- BBT-2.5-13B-Text:130億參數的中文+英文雙語基礎模型

- BBT-2-12B-TC-001-SFT:經過指令微調的代碼模型,可以進行對話

- BBT-2-12B-TF-001:在120億模型上訓的金融模型,用于解決金融領域任務

- BBT-2-12B-Image:文生圖模型

- BBT-2-12B-Science:科學論文模型

總體看下來,BBT-2系列既有通用大模型,也有術業有專攻的垂域模型。

通用模型

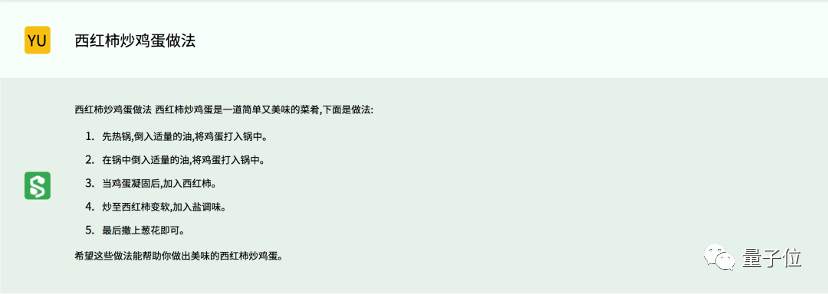

先看通用方面,利用BBT-2,可以進行通用性的人機對話——

比如做一道居家旅行必備家常快手菜:

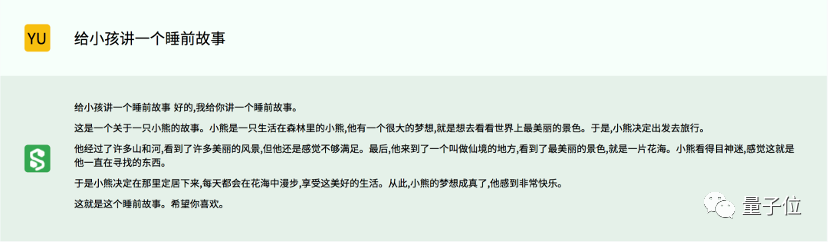

又或者每天編一個童話故事,講給不肯睡覺的小朋友:

再或者提綱挈領,寫個論文綱要:

專業模型

而專業模型提供的能力就相對聚焦。

利用BBT-TC,完成代碼撰寫——這個代碼模型,是在百億基座模型BBT-2-12B-Text后接續訓練代碼數據集,并通過有監督執行微調(supervised fine-tuing)等技術,實現人類意圖對齊。

BBT-TC是微調模型,比其通用大模型推理快不少。因此,代碼問答也是本次BBT開放的最主要的能力。

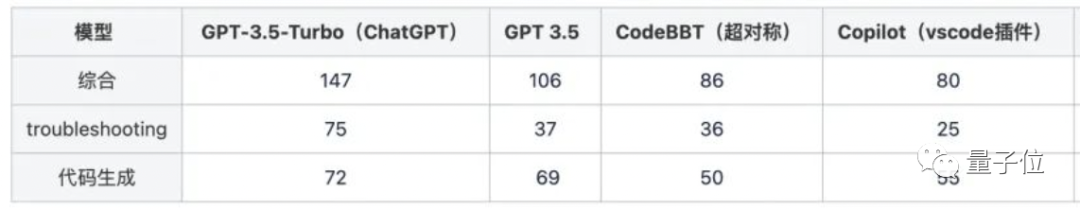

官方公布數據,專業測評中,BBT-TC寫代碼的能力次于GPT-3.5,但高于Copilot。

△各產品分項得分(150 分制)

實際測評中,BBT-TC會出現大部分代碼模型都存在的問題,就是首次回答不完全正確,只有在多次提問后,才會微調出正確答案。

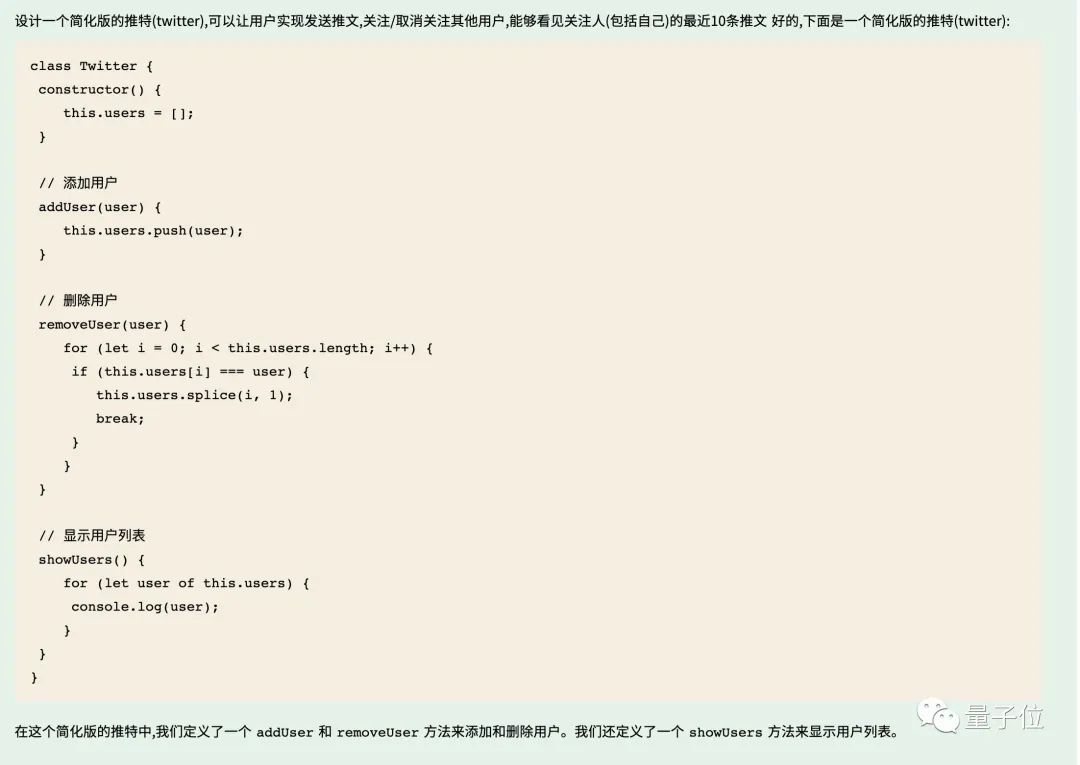

如讓它設計一個簡化版的推特,并附帶一些額外功能。

首次給出的回答,并沒有查看推文這部分的代碼功能,卻擅自增加了顯示用戶列表的部分。

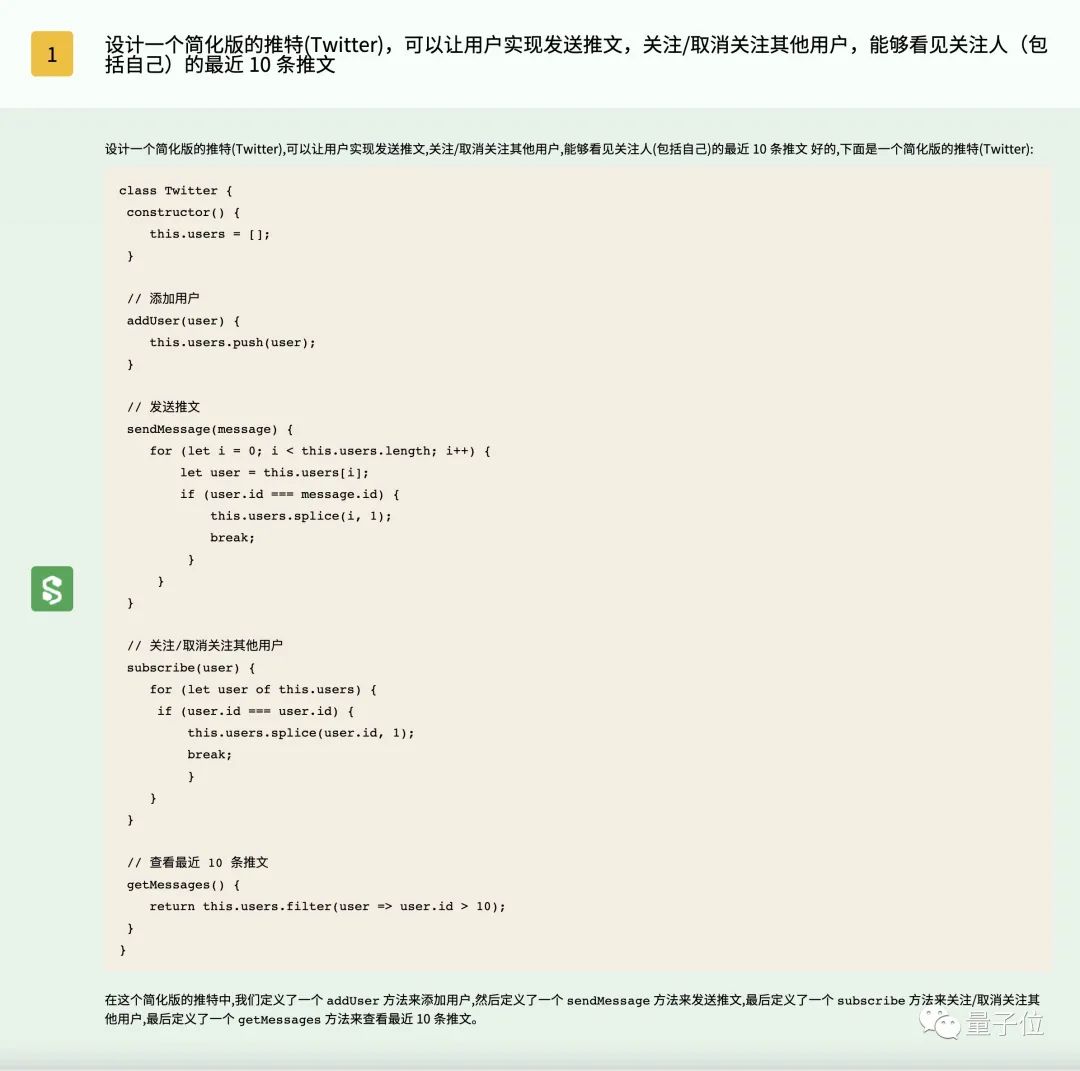

但再多嘗試幾次,也會出現一個比較不錯的答案。

體驗過程中還發現,偶爾BBT-TC還會出現只提供代碼實現思路,而非直接生成代碼的情況。

也就是說,想要一次性生成能夠成功運行的代碼,還是需要一些特殊的prompt輸入技巧。

(prompt工程師的重要性突然體現)

代碼模型外,利用對標BloombergGPT的金融模型BBT-2-Finance,也可以完成金融領域的具體任務。

訓練過程中,BBT-2-Finance搜集和爬取了幾乎所有公開可以獲得的中文金融語料數據。

比如過去20年主流媒體的財經新聞、上市公司公告和財報、金融社交平臺用戶發帖等。

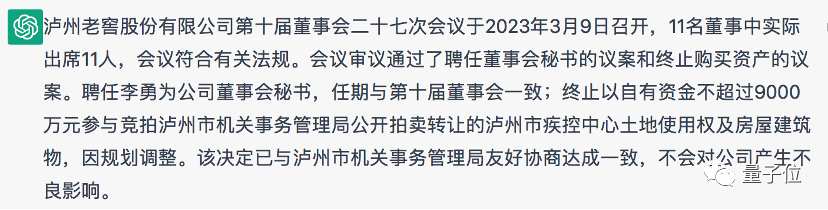

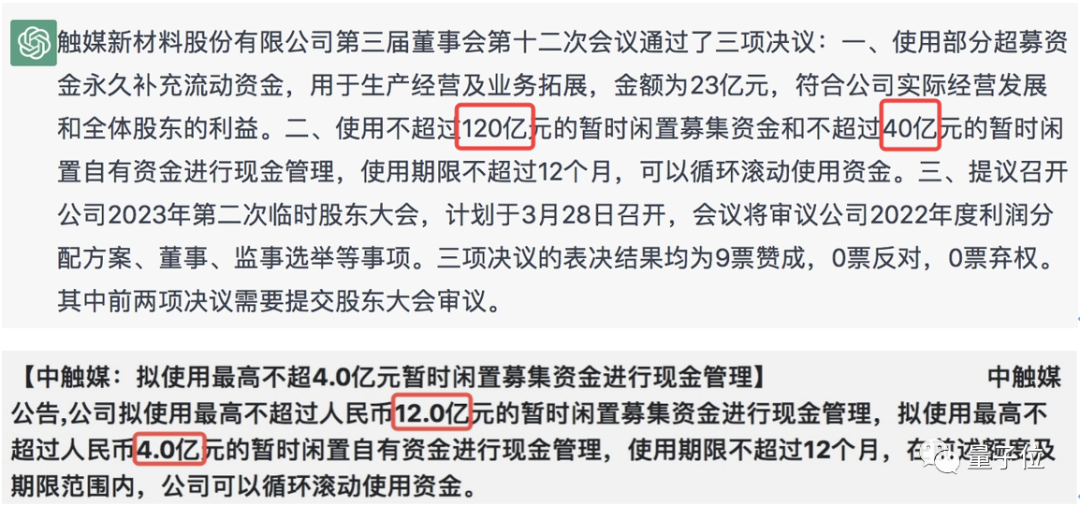

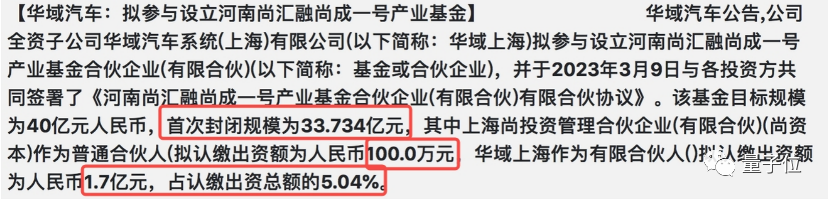

所以用戶可以用它從長篇文本中抓關鍵信息,撰寫摘要:

△ChatGPT和BBT-2-Finance同題對比

和ChatGPT相比,BBT-2-Finance的摘要更簡潔,同時也沒落下重要信息。

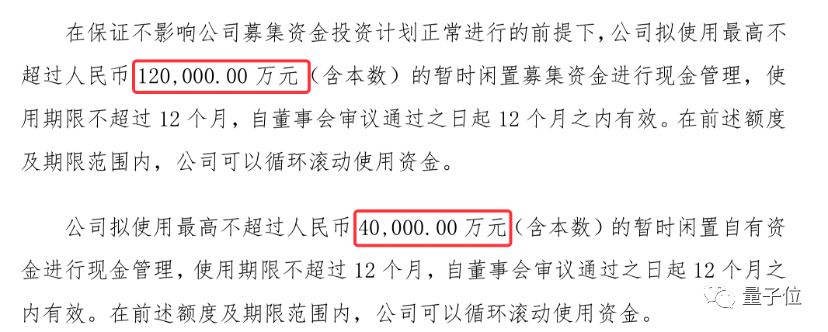

還能針對金融行業對數字的高精度需求,對單位進行換算:

△ChatGPT和BBT-2-Finance同題對比

如上同題對比,ChatGPT就弄錯了單位換算,但BBT-2-Finance完成了正確的單位轉換。

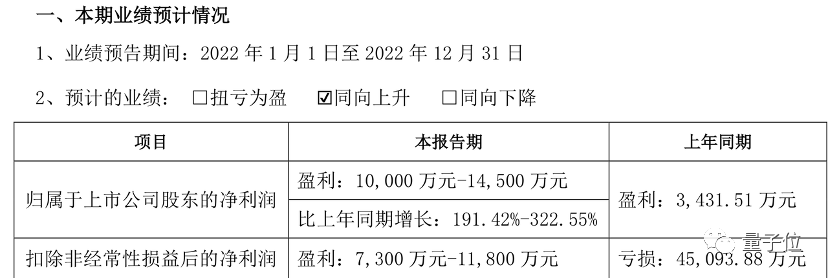

淺試了一下,表格什么的也能解讀且摘取相應文字:

專業領域,除了文字生成,還有個文生圖模型BBT-Image。

和一般生成逼真圖像的文生圖模型不同,BBT-Image專門針對紡織行業,可以生成具有紋理、色彩和設計元素的紡織品團。

可以對比一下它和Stable Diffusion的生成效果。

△prompt:熱帶花卉芙蓉花,熱帶葉子,水彩效果圖案,黑色背景,無縫圖,循環圖

△prompt:五顏六色的水母圖案,細節清晰,無縫圖,循環圖

至于在科研論文上訓練構建的BBT-Sicence,官方稱可以應用在物理、化學、生物、數學領域,它能提供的能力主要有三方面:

- 一是快速精準的知識檢索;

- 二是針對所研究領域的前沿問題提供新的ideas;

- 三是利用多學科知識訓練出的能力提供跨學科的建議。

還要提一句,整個BBT系列中的3個模型即將開源,分別是金融模型BBT-1-1B、基礎模型BBT-2-12B-Text、基礎模型BBT-2.5-13B-Text。

背后團隊

一系列操作的幕后玩家,是超對稱技術公司和復旦大學知識工場實驗室。

超對稱技術公司在去年5月,發布了大模型BigBang Tansformer(乾元)的第一版BBT-1,在中文金融語料上訓練而成的10億參數模型。

復旦大學知識工場實驗室,源于復旦圖數據管理實驗室(GDM@FUDAN),由教授肖仰華領銜。

整個過程,超對稱公司主導預訓練部分,指令微調和評測工作則聯合復旦大學知識工場實驗室完成。

據悉,有了系列模型后,背后團隊也開始致力于對科學大模型進行評測。

超對稱合作復旦、上海交大、浙大、南航、中山、北師大等多所大學,號召全球一線科研人員共同構建科研問題評測數據集ResearchQA,覆蓋數學、物理、化學、生物、地理地質、計算機和電子工程等前沿科研領域。

ResearchQA提交郵箱:researchqa@susymmetry.com

BBT-2地址:https://www.ssymmetry.com/