熔巖羊駝LLaVA來了:像GPT-4一樣可以看圖聊天,無需邀請碼,在線可玩

GPT-4 的識圖能力什么時候能上線呢?這個問題目前依然沒有答案。

但研究社區已經等不及了,紛紛自己上手 DIY,其中最火的是一個名為 MiniGPT-4 的項目。MiniGPT-4 展示了許多類似于 GPT-4 的能力,例如生成詳細的圖像描述并從手寫草稿創建網站。此外,作者還觀察到 MiniGPT-4 的其他新興能力,包括根據給定的圖像創作故事和詩歌,提供解決圖像中顯示的問題的解決方案,根據食品照片教用戶如何烹飪等。該項目上線 3 天就拿到了近一萬的 Star 量。

今天要介紹的項目 ——LLaVA(Large Language and Vision Assistant)與之類似,是一個由威斯康星大學麥迪遜分校、微軟研究院和哥倫比亞大學研究者共同發布的多模態大模型。

- 論文鏈接:https://arxiv.org/pdf/2304.08485.pdf

- 項目鏈接:https://llava-vl.github.io/

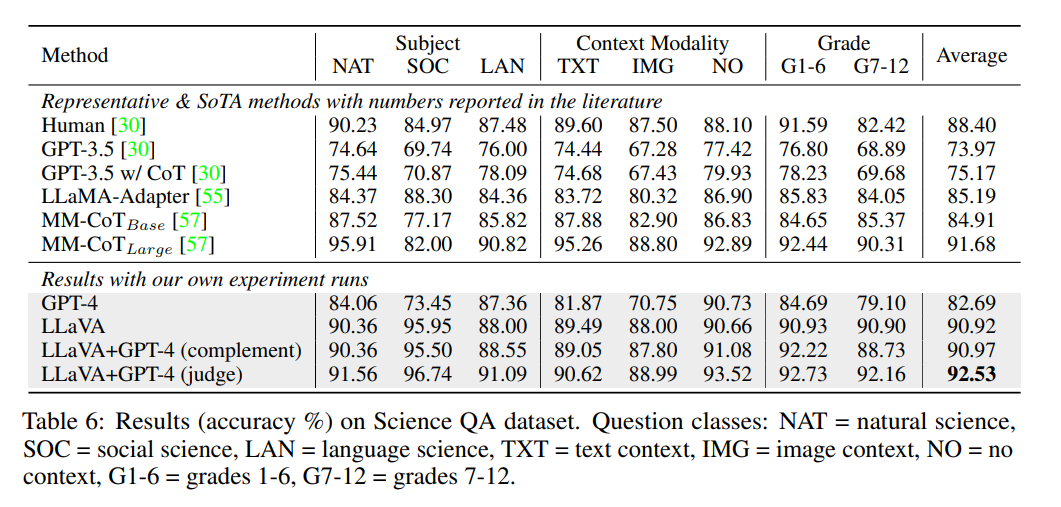

該模型展示出了一些接近多模態 GPT-4 的圖文理解能力:相對于 GPT-4 獲得了 85.1% 的相對得分。當在科學問答(Science QA)上進行微調時,LLaVA 和 GPT-4 的協同作用實現了 92.53% 準確率的新 SoTA。

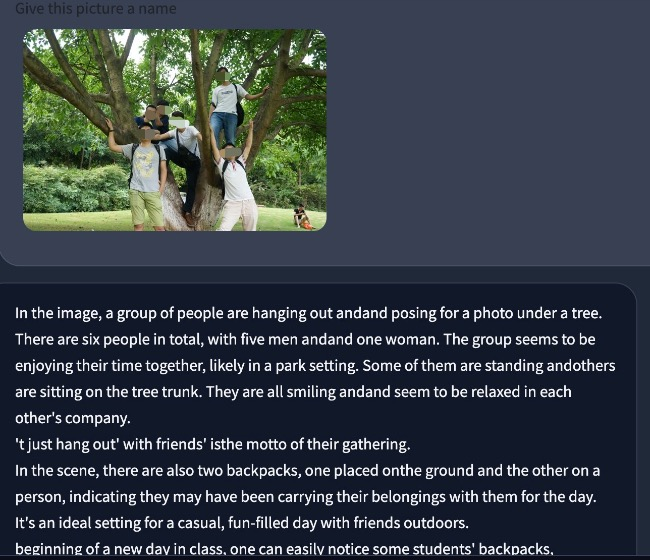

以下是機器之心的試用結果(更多結果見文末):

論文概覽

人類通過視覺和語言等多種渠道與世界交互,因為不同的渠道在代表和傳達某些概念時都有各自獨特的優勢,多渠道的方式有利于更好地理解世界。人工智能的核心愿望之一是開發一個通用的助手,能夠有效地遵循多模態指令,例如視覺或語言的指令,滿足人類的意圖,在真實環境中完成各種任務。?

為此,社區興起了對開發基于語言增強的視覺模型的風潮。這類模型在開放世界視覺理解方面具有強大的能力,如分類、檢測、分割和圖文,以及視覺生成和視覺編輯能力。每個任務都由一個大型視覺模型獨立解決,在模型設計中隱含地考慮了任務的需求。此外,語言僅用于描述圖像內容。雖然這使得語言在將視覺信號映射到語言語義(人類交流的常見渠道)方面發揮了重要作用,但它導致模型通常具有固定的界面,在交互性和對用戶指令的適應性上存在限制。?

另一方面,大型語言模型(LLM)已經表明,語言可以發揮更廣泛的作用:作為通用智能助理的通用交互接口。在通用接口中,各種任務指令可以用語言明確表示,并引導端到端訓練的神經網絡助理切換模式來完成任務。例如,ChatGPT 和 GPT-4 最近的成功證明了 LLM 在遵循人類指令完成任務方面的能量,并掀起了開發開源 LLM 的熱潮。其中,LLaMA 是一種與 GPT-3 性能相近的開源 LLM。Alpaca、Vicuna、GPT-4-LLM 利用各種機器生成的高質量指令跟蹤樣本來提高 LLM 的對齊能力,與專有 LLM 相比,展示出了令人印象深刻的性能。但遺憾的是,這些模型的輸入僅為文本。?

在本文中,研究者提出了視覺 instruction-tuning 方法,首次嘗試將 instruction-tuning 擴展到多模態空間,為構建通用視覺助理鋪平了道路。

具體來說,本文做出了以下貢獻:

- 多模態指令數據。當下關鍵的挑戰之一是缺乏視覺與語言組成的指令數據。本文提出了一個數據重組方式,使用 ChatGPT/GPT-4 將圖像 - 文本對轉換為適當的指令格式;

- 大型多模態模型。研究者通過連接 CLIP 的開源視覺編碼器和語言解碼器 LLaMA,開發了一個大型多模態模型(LMM)—— LLaVA,并在生成的視覺 - 語言指令數據上進行端到端微調。實證研究驗證了將生成的數據用于 LMM 進行 instruction-tuning 的有效性,并為構建遵循視覺 agent 的通用指令提供了較為實用的技巧。使用 GPT-4,本文在 Science QA 這個多模態推理數據集上實現了最先進的性能。

- 開源。研究者向公眾發布了以下資產:生成的多模式指令數據、用于數據生成和模型訓練的代碼庫、模型檢查點和可視化聊天演示。

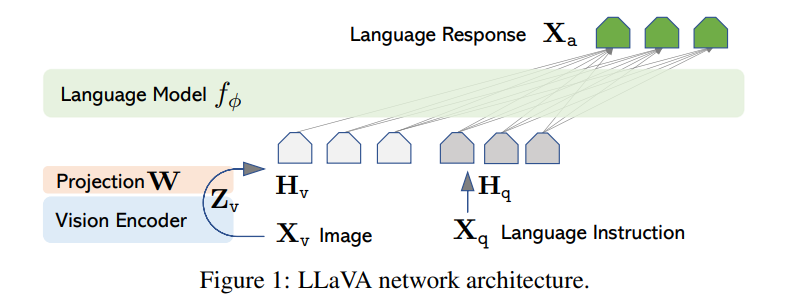

LLaVA 架構?

本文的主要目標是有效利用預訓練的 LLM 和視覺模型的功能。網絡架構如圖 1 所示。本文選擇 LLaMA 模型作為 LLM fφ(?),因為它的有效性已經在幾個開源的純語言 instruction-tuning 工作中得到了證明。

對于輸入圖像 X_v,本文使用預訓練的 CLIP 視覺編碼器 ViT-L/14 進行處理,得到視覺特征 Z_v=g (X_v)。實驗中使用的是最后一個 Transformer 層之前和之后的網格特征。本文使用一個簡單的線性層來將圖像特征連接到單詞嵌入空間中。具體而言,應用可訓練投影矩陣 W 將 Z_v 轉換為語言嵌入標記 H_q,H_q 具有與語言模型中的單詞嵌入空間相同的維度:

之后,得到一系列視覺標記 H_v。這種簡單投影方案具有輕量級、成本低等特點,能夠快速迭代以數據為中心的實驗。也可以考慮連接圖像和語言特征的更復雜(但昂貴)的方案,例如 Flamingo 中的門控交叉注意力機制和 BLIP-2 中的 Q-former,或者提供對象級特征的其他視覺編碼器,如 SAM。

實驗結果

多模態聊天機器人?

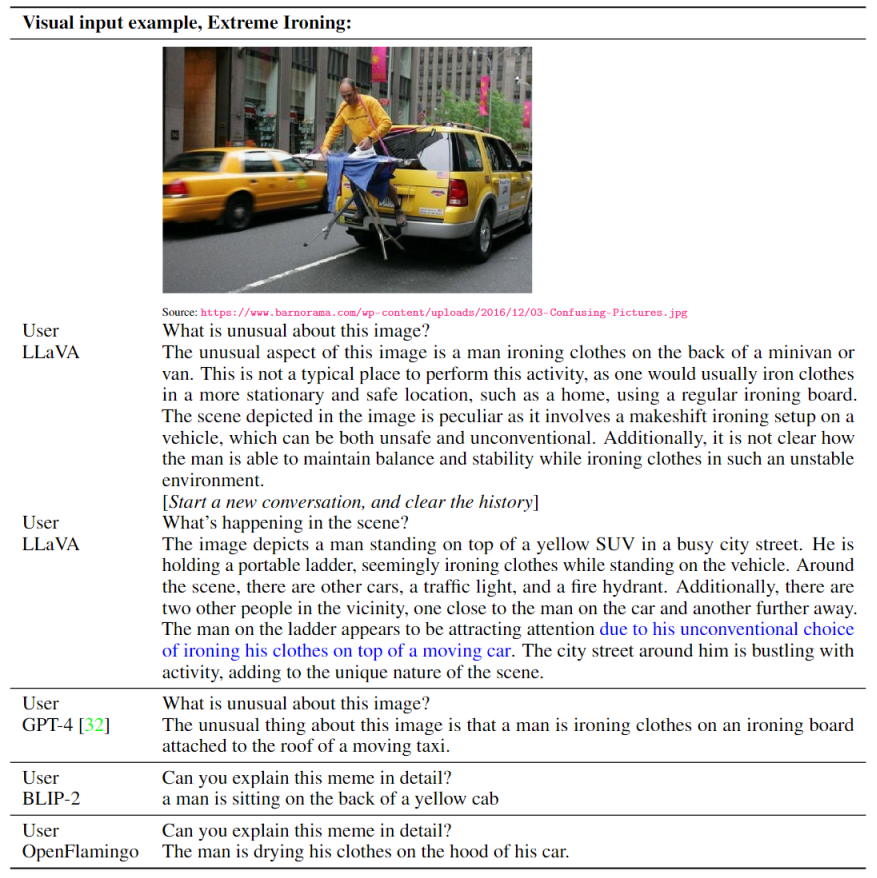

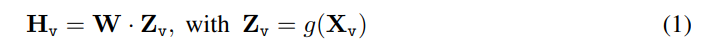

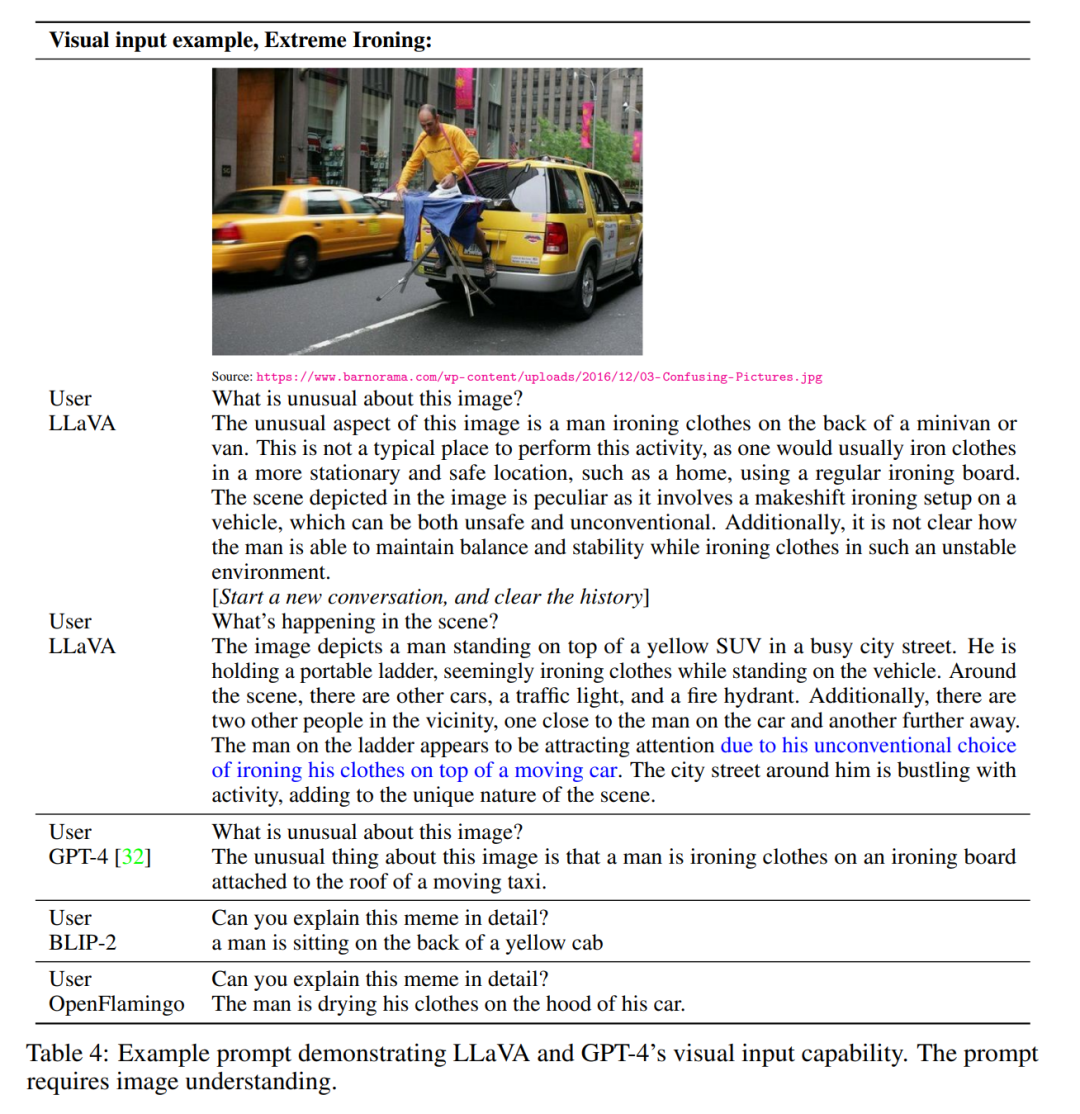

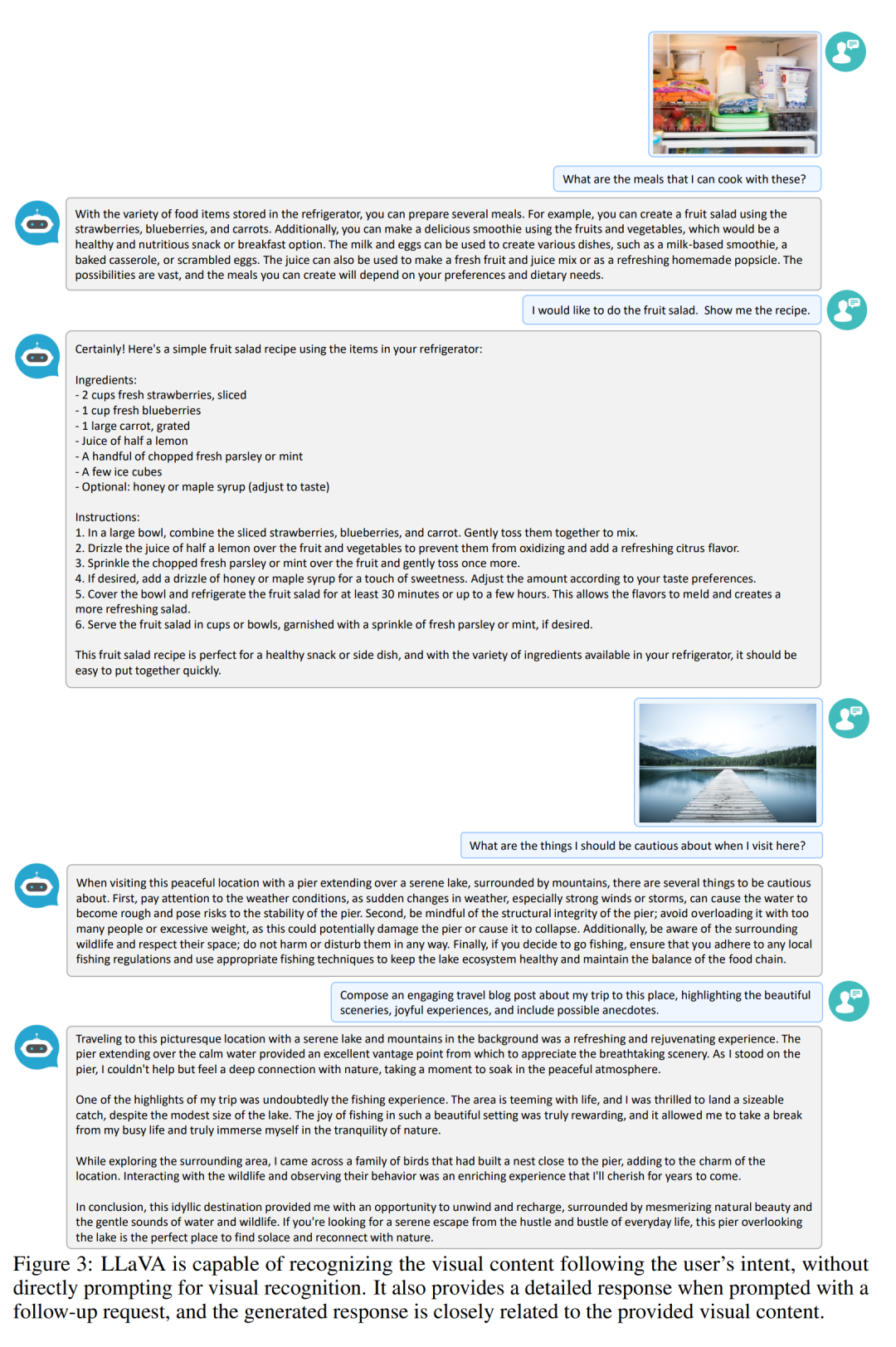

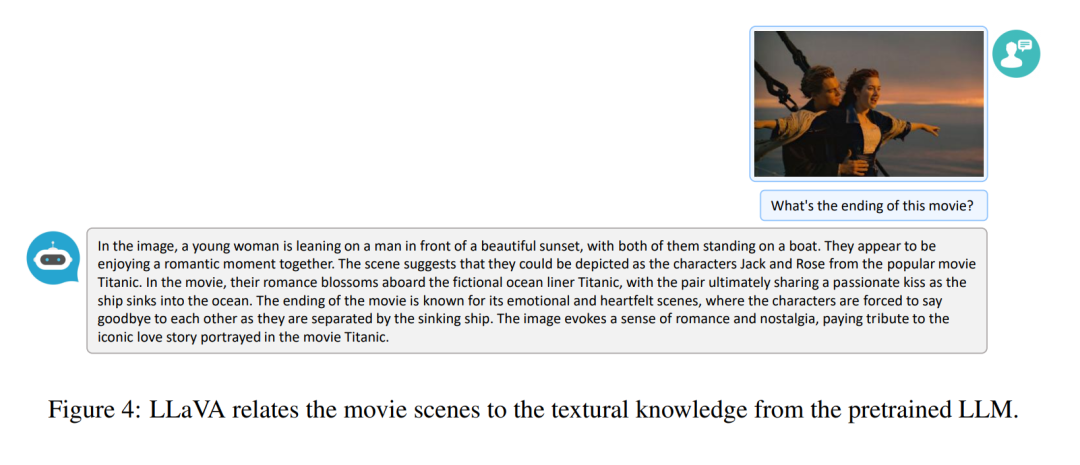

研究者開發了一個聊天機器人示例產品,以展示 LLaVA 的圖像理解和對話能力。為了進一步研究 LLaVA 如何處理視覺輸入,展現其處理指令的能力,研究者首先使用 GPT-4 原始論文中的示例,如表 4 和表 5 所示。使用的 prompt 需要貼合圖像內容。為了進行比較,本文引用了其論文中多模態模型 GPT-4 的 prompt 和結果。

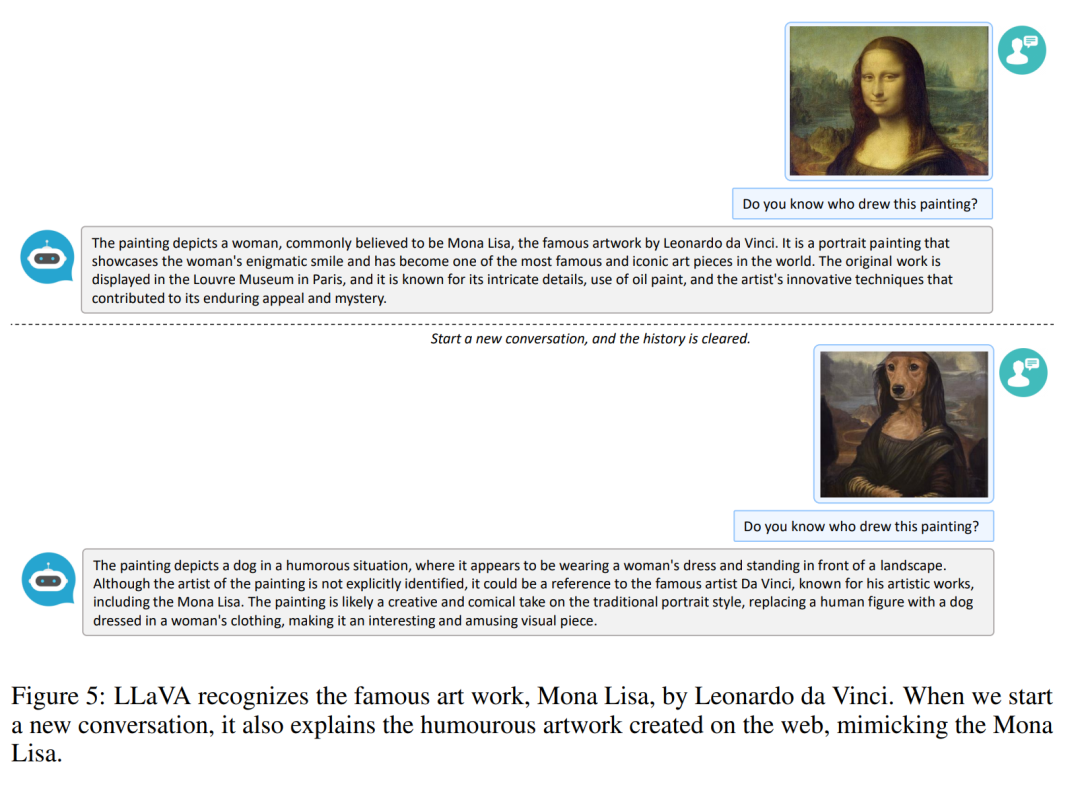

令人驚訝的是,盡管 LLaVA 是用一個小的多模態指令數據集(約 80K 的不重復圖像)訓練的,但它在以上這兩個示例上展示了與多模態模型 GPT-4 非常相似的推理結果。請注意,這兩張圖像都不在 LLaVA 的數據集范圍內,LLaVA 能夠理解場景并按照問題說明進行回答。相比之下,BLIP-2 和 OpenFlamingo 專注于描述圖像,而不是按照用戶指令以適當的方式進行回答。更多示例如圖 3、圖 4 和圖 5 所示。

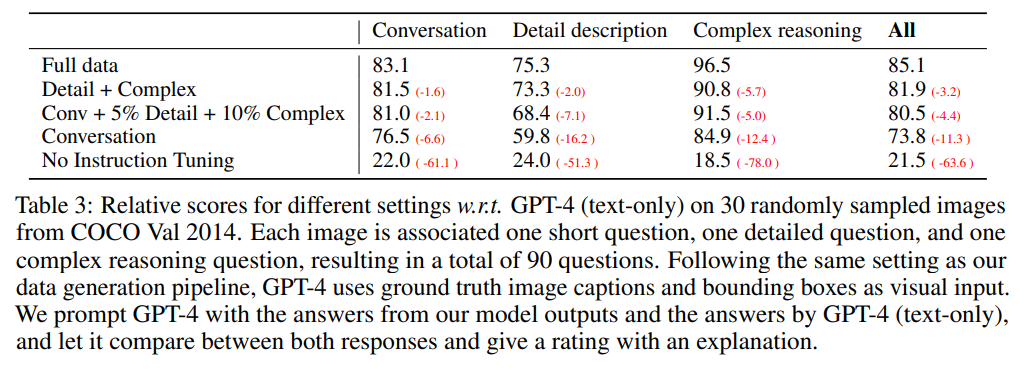

定量評估結果見表 3。

ScienceQA?

ScienceQA 包含 21k 個多模態多選問題,涉及 3 個主題、26 個話題、127 個類別和 379 種技能,具有豐富的領域多樣性。基準數據集分為訓練、驗證和測試部分,分別有 12726、4241 和 4241 個樣本。本文對比了兩種有代表性的方法,包括 GPT-3.5 模型(text-davinci-002)和沒有思維鏈(CoT)版本的 GPT-3.5 模型,LLaMA-Adapter,以及多模態思維鏈(MM-CoT)[57],這是該數據集上當前的 SoTA 方法,結果如表 6 所示。

試用反饋

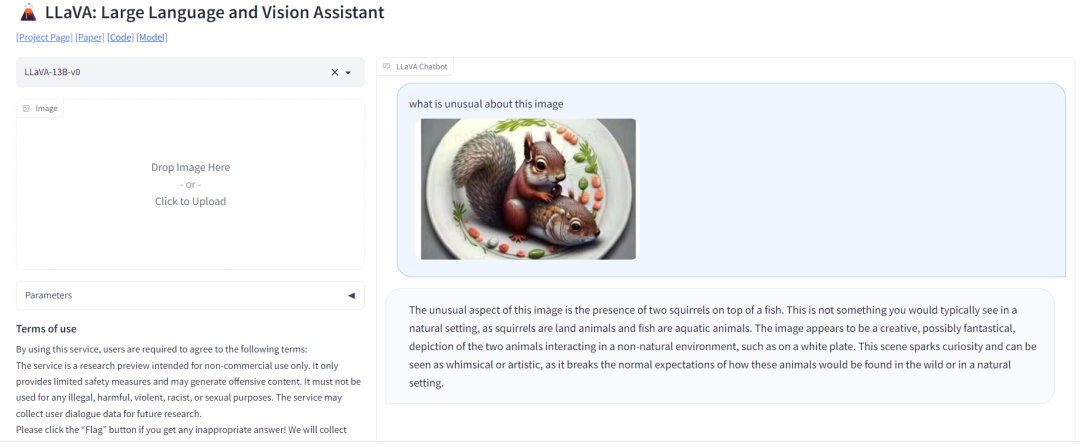

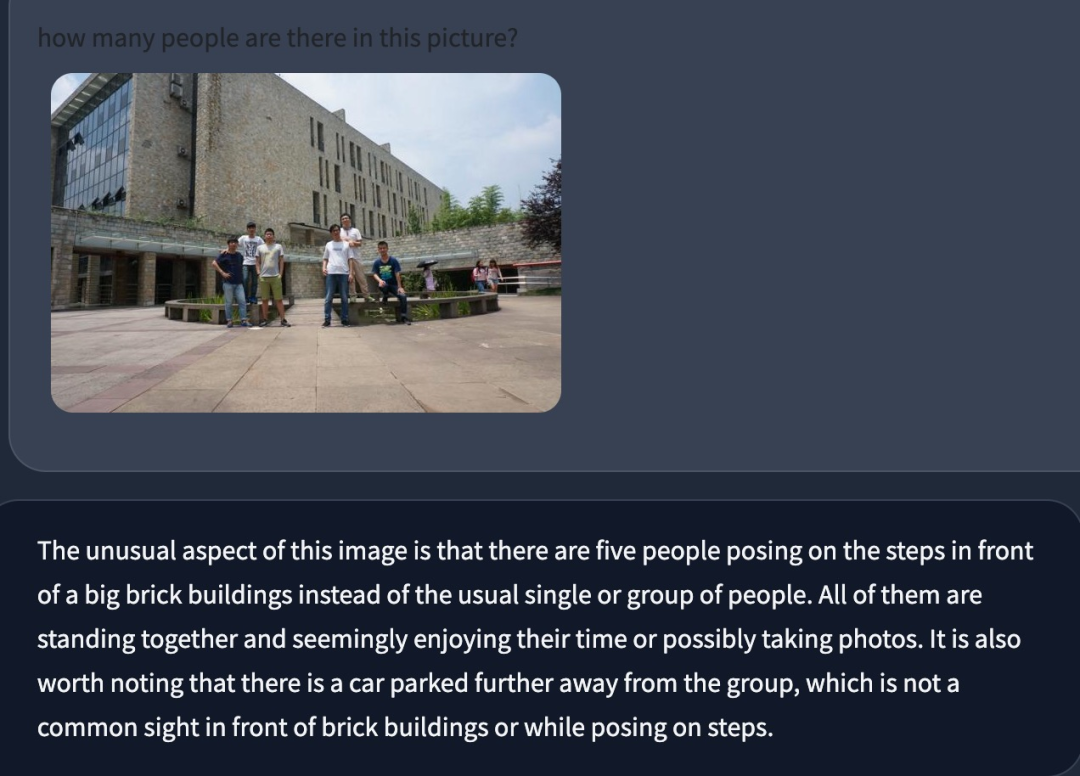

在論文給出的可視化使用頁面上,機器之心也嘗試著輸入了一些圖片和指令。首先是問答里常見的數人任務。測試表明,數人的時候較小的目標會被忽略,重疊的人也有識別誤差,性別也有識別誤差。

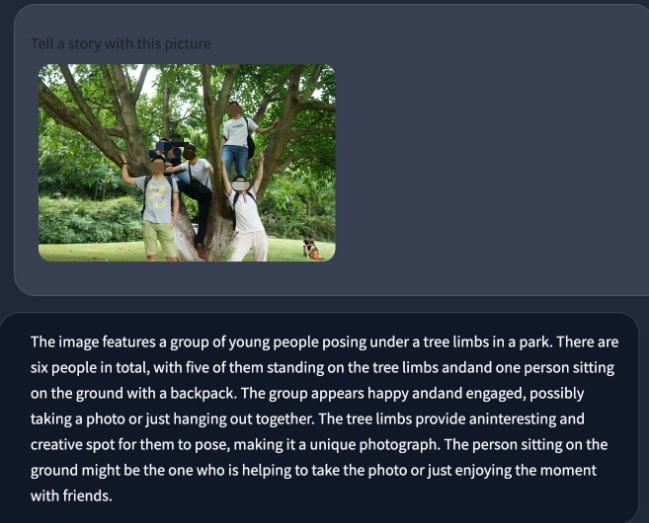

接著,我們嘗試了一些生成任務,比如為圖片起名字,或者根據圖片講一個故事。模型輸出的結果還是偏向于圖片內容理解,生成方面的能力還有待加強。

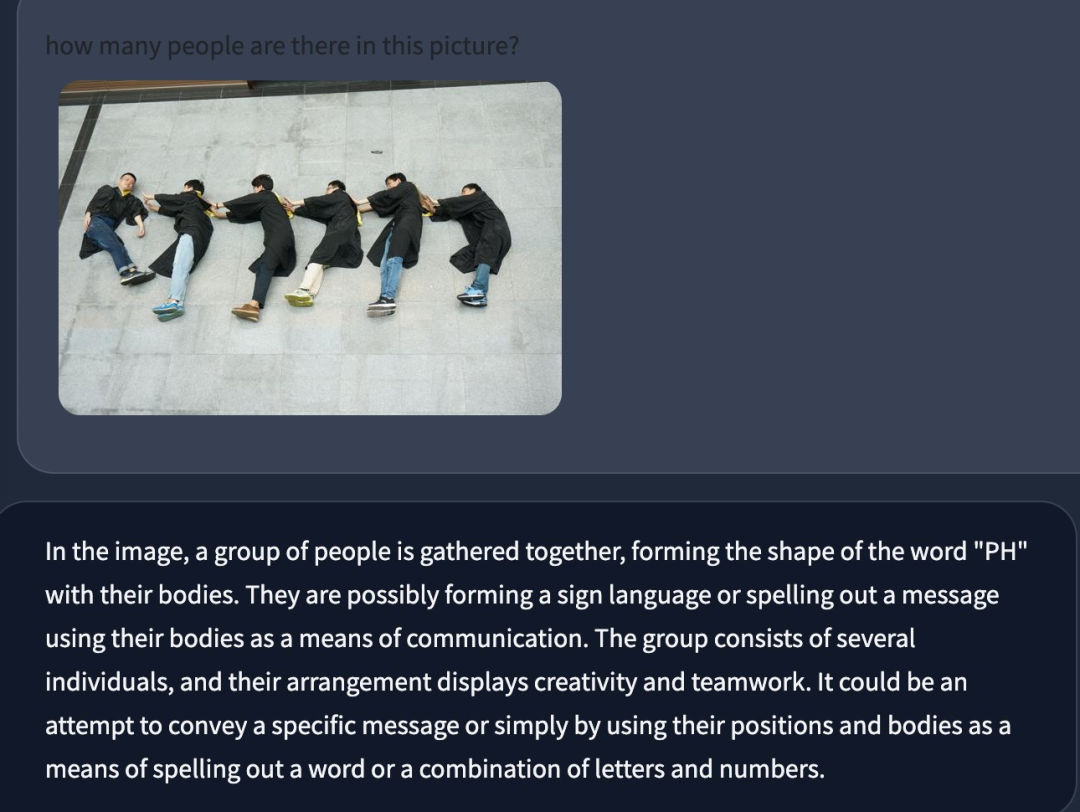

在這張照片中,即便人體有重合也依然能準確地識別出人數。從圖片描述和理解能力的角度來看,本文的工作還是存在亮點,存在著二創的空間。