南科大黑科技:一鍵消除視頻人物,特效師的救星來了!

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

來自南方科技大學的這款視頻分割模型,可以追蹤視頻中的任意事物。

不僅會“看”,還會“剪”,從視頻中去掉個人,對它來說也是輕輕松松的事。

而操作上,你唯一需要做的就是點幾下鼠標。

這位特效藝術家看到消息后仿佛找到了救星,直言這一產品將改變CGI行業的游戲規則。

這款模型叫做TAM(Track Anything Model),是不是和Meta的圖像分割模型SAM名字很像?

的確,TAM就是將SAM擴展到了視頻領域,點亮了動態物體追蹤的技能樹。

視頻分割模型其實不是新技術了,但傳統的分割模型并沒有減輕人類的工作。

這些模型使用的訓練數據全部需要人工標注,甚至在使用時還需要先用特定物體的遮罩參數進行初始化。

SAM的出現為解決這一問題提供了前提——至少初始化數據不再需要人工獲取。

當然,TAM也并不是逐幀使用SAM再疊加,還需要構建對應的時空關系。

團隊將SAM與名為XMem的記憶模塊進行了集成。

只需要在第一幀中用SAM生成初始參數,XMem便可以指導接下來的追蹤過程。

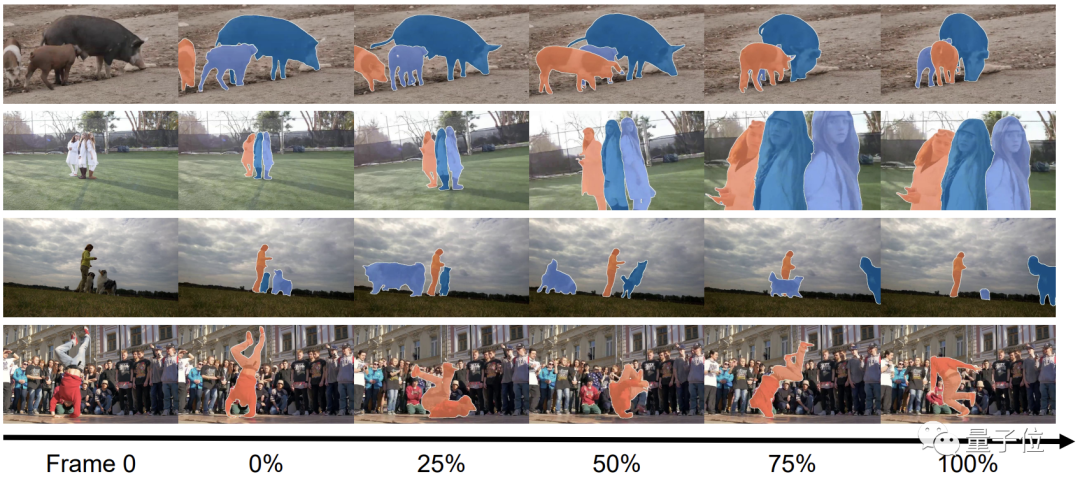

追蹤的目標還可以是很多個,比如下面的清明上河圖:

甚至場景發生改變,也不影響TAM的表現:

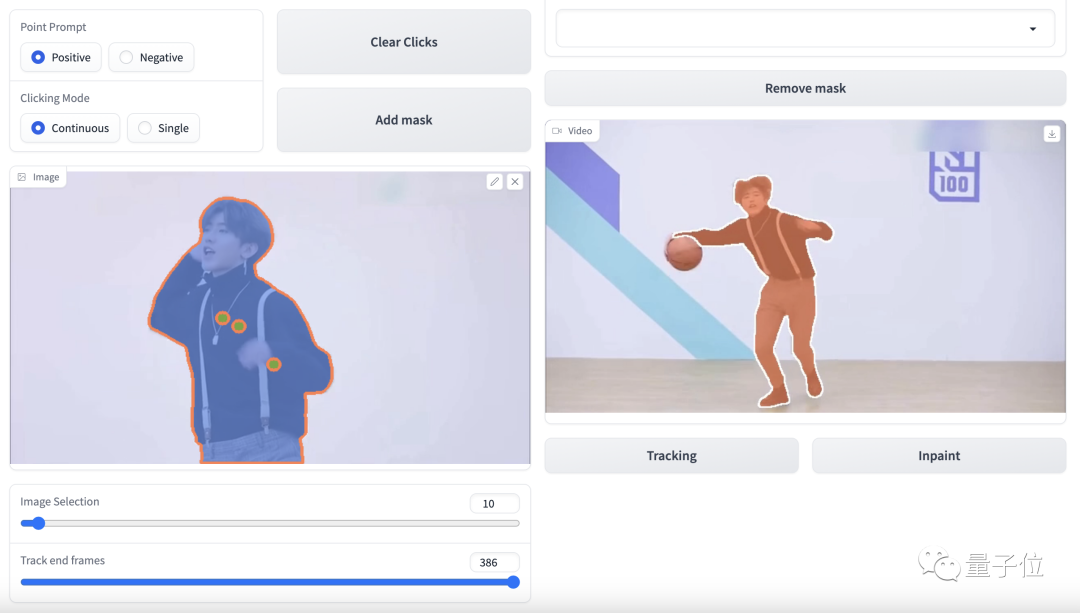

我們體驗了一番發現,TAM采用了交互式用戶界面,操作上十分簡單友好。

硬實力方面,TAM的追蹤效果的確也不錯:

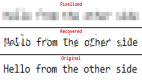

但是,消除功能在一些細節上的精確度還有待提高。

從SAM到TAM

前文已經提到,TAM是在SAM的基礎之上結合記憶能力建立時空關聯實現的。

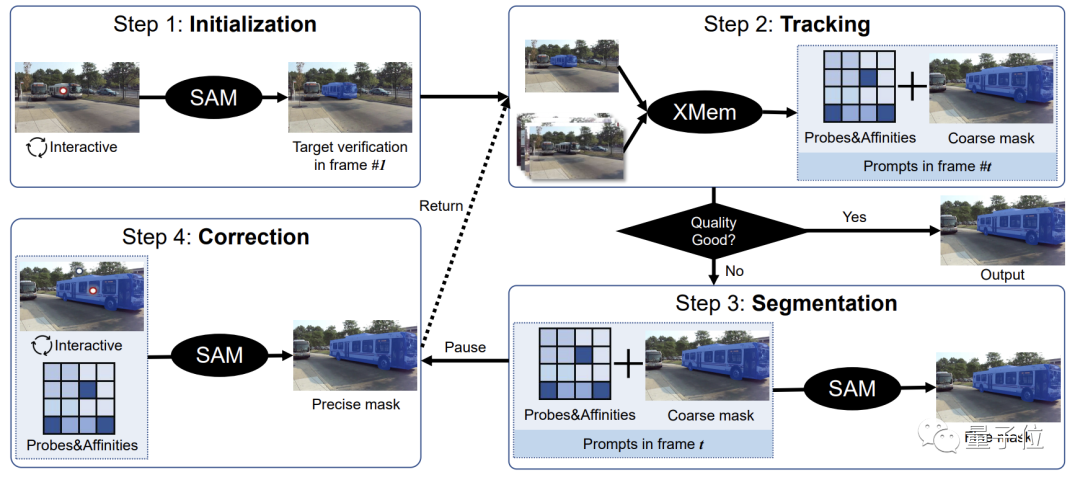

具體而言,第一步是借助SAM的靜態圖像分割能力對模型進行初始化。

只需一次點擊,SAM就能生成目標物體的初始化遮罩參數,代替了傳統分割模型中的復雜初始化過程。

有了初始參數,團隊就可以將它交給XMem,進行半人工干預訓練,大大減少了人類工作量。

在這一過程中,會有一些人工預測結果被用于和XMem的輸出進行比較。

實際過程中,隨著時間的增長,得到準確的分割結果對XMem變得越來越困難。

當結果與預期差距過大時,將進入再分割環節,這一步還是由SAM完成。

經過SAM的再優化,大部分輸出結果已比較準確,但還有一部分需要人工再調整。

TAM的訓練過程大致就是這樣,而開頭提到的物體消除的技能是TAM與E2FGVI結合形成的。

E2FGVI本身也是一個視頻元素消除工具,在TAM精準分割的加持下,其工作更加有的放矢。

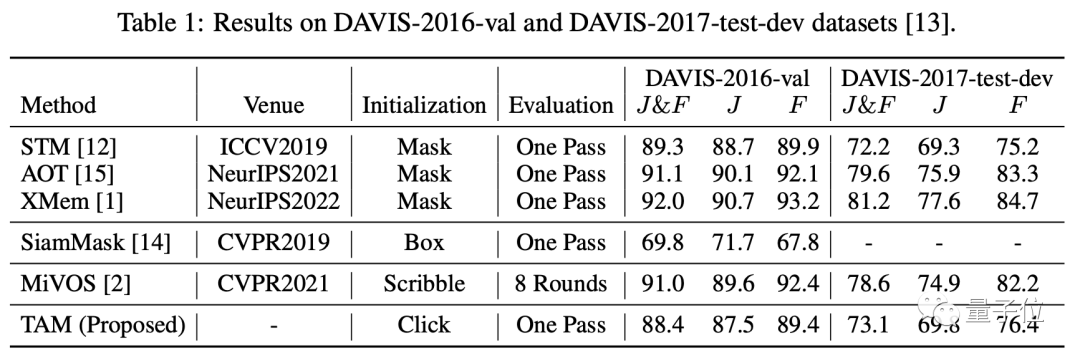

為了測試TAM,團隊使用了DAVIS-16和DAVIS-17數據集對其進行了評估。

直觀感受還是很不錯的,從數據上看也的確如此。

TAM雖然無需手工設置遮罩參數,但其J(區域相似度)和F(邊界準確度)兩項指標已十分接近手工模型。

甚至在DAVIS-2017數據集上的表現還略勝于其中的STM。

其他初始化方式中,SiamMask的表現根本無法和TAM相提并論;

另一種名為MiVOS方法雖然表現好于TAM,但畢竟已經進化了8輪……

團隊簡介

TAM來自南方科技大學視覺智能與感知(VIP)實驗室。

該實驗室研究方向包括文本-圖像-聲音多模型學習、多模型感知、強化學習和視覺缺陷檢測等。

目前團隊已發表論文30余篇,獲得專利5項。

團隊領導人是南方科技大學鄭鋒副教授,博士畢業于英國謝菲爾德大學,先后供職于中科院深研院、騰訊優圖等機構,于2018年進入南科大,2021年晉升為副教授。

論文地址:

https://arxiv.org/abs/2304.11968

GitHub頁面:

https://github.com/gaomingqi/Track-Anything

參考鏈接:

https://twitter.com/bilawalsidhu/status/1650710123399233536?s=20