最新研究,GPT-4暴露了缺點!無法完全理解語言歧義!

自然語言推理(Natural Language Inference,NLI)是自然語言處理中一項重要任務,其目標是根據給定的前提和假設,來判斷假設是否可以從前提中推斷出來。然而,由于歧義是自然語言內在的特征,處理歧義也是人類語言理解的重要組成部分。由于人類語言表達的多樣性,歧義處理成為解決自然語言推理問題的難點之一。當前,各種自然語言處理算法被應用到問答系統、語音識別、智能翻譯和自然語言生成等場景中,但即使有這些技術,完全解決歧義仍然是一個極具挑戰性的任務。

對于 NLI 任務,大型自然語言處理模型如 GPT-4 等確實面臨著挑戰。其中一個問題是語言歧義導致模型難以準確理解句子的真正含義。此外,由于自然語言的靈活性和多樣性,不同文本之間可能存在各種各樣的關系,這使得 NLI 任務中的數據集變得極其復雜,同時也對自然語言處理模型的普適性和泛化能力提出了巨大挑戰。因此,在處理歧義語言方面,如果今后大模型成功將顯得至關重要,并且大模型已被廣泛應用于對話界面和寫作輔助工具等領域。處理歧義將有助于適應不同的背景,提高溝通的清晰性,以及識別誤導性或欺騙性言語的能力。

這篇討論大模型歧義的論文標題使用了一語雙關的表達,“We’re Afraid…”,既表達了當前對語言模型難以準確建模歧義的擔憂,又暗示了論文所描述的語言結構。本文也表明,人們正在努力制定新的基準,以真正挑戰強大的新的大模型,以便更準確地理解和生成自然語言,并實現模型上的新突破。

論文題目: We're Afraid Language Models Aren't Modeling Ambiguity

論文鏈接: https://arxiv.org/abs/2304.14399

代碼和數據地址: https://github.com/alisawuffles/ambient

本文作者計劃研究預訓練大模型是否有能力識別和區分含有多個可能解釋的句子,評估模型如何區分不同的讀法和解釋。然而,現有的基準測試數據通常不包含歧義的例子,因此需要自己構建實驗來探究這個問題。

傳統的 NLI 三路標注方案指的是一種用于自然語言推理(NLI)任務的標注方式,它需要標注者在三個標簽中選擇一個標簽來表示原始文本和假設之間的關系。這三個標簽通常是“蘊含(entailment)”、“中立(neutral)”和“矛盾(contradiction)”。

作者使用了 NLI 任務的格式來進行實驗,采用了函數式方法,通過對前提或假設中的歧義對蘊含關系的影響來表征歧義。作者提出了一個名為 AMBIENT(Ambiguity in Entailment)的基準測試,涵蓋了各種詞匯、句法和語用歧義,并更廣泛地涵蓋了可能傳達多個不同信息的句子。

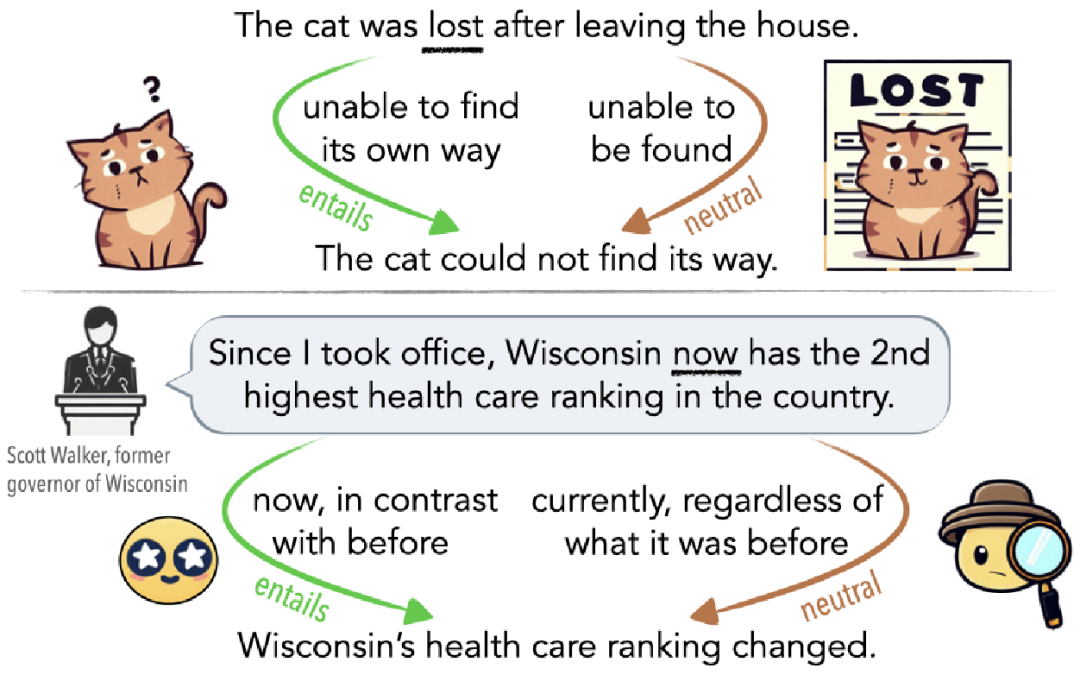

如圖 1 所示,歧義可能是無意識的誤解(圖 1 頂部),也可能是故意用來誤導聽眾的(圖 1 底部)。例如,如果貓離開家后迷失方向,那么從無法找到回家的路線的意義上看,它是迷路了(蘊涵邊);如果它已經好幾天沒有回家,那么從其他人無法找到它的意義上看,它也是迷路了(中立邊)。

▲圖1 用貓迷路解釋的歧義示例

AMBIENT 數據集介紹

精選示例

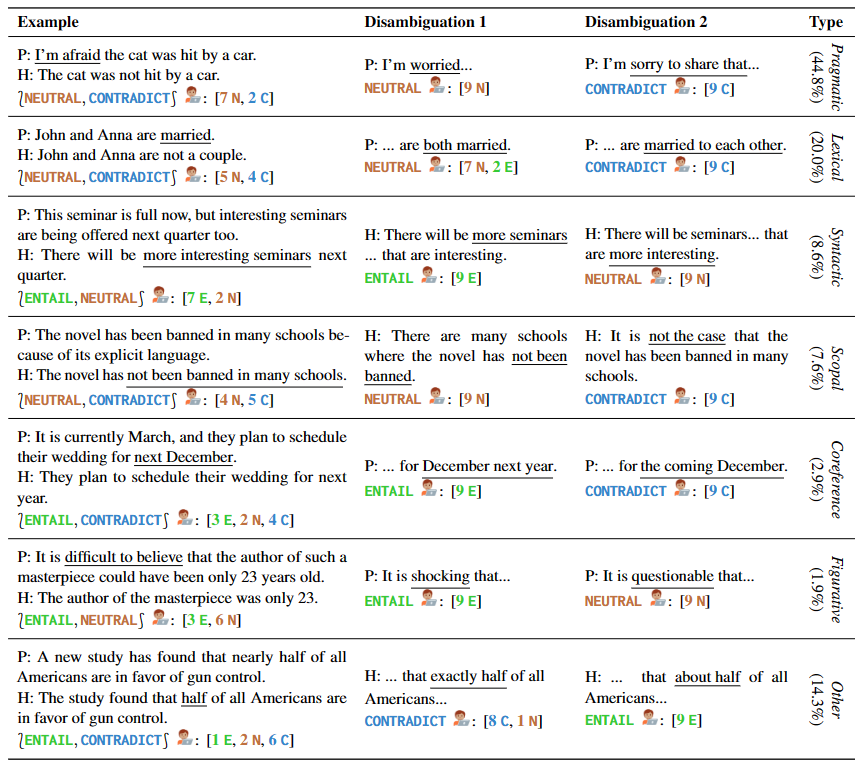

作者提供了 1645 個涵蓋多種類型歧義的句子樣例,其中包括手寫樣本和來自現有NLI數據集和語言學教材。AMBIENT 中的每個示例都包含一組標簽,對應于各種可能的理解,以及每種理解的消歧重寫,如表 1 所示。

▲表1 精選示例中的前提和假設對

生成的示例

研究人員還采用了過度生成和過濾的方法來構建一個大型的未帶標簽的 NLI 示例語料庫,以更全面地涵蓋不同的歧義情況。他們受到前人工作的啟發,自動識別共享推理模式的前提假設對組,并通過鼓勵創建具有相同模式的新示例來加強語料庫的質量。

注釋和驗證

針對先前步驟獲得的例子,需要進行注釋和標注。這一過程涉及到了兩位專家的注釋、一位專家的驗證和匯總,以及部分作者的驗證。同時,37 名語言學專業的學生為每個例子選擇了一組標簽,并提供了消歧重寫。所有這些被注釋后的例子經過篩選和驗證,最終得到了 1503 個最終的例子。

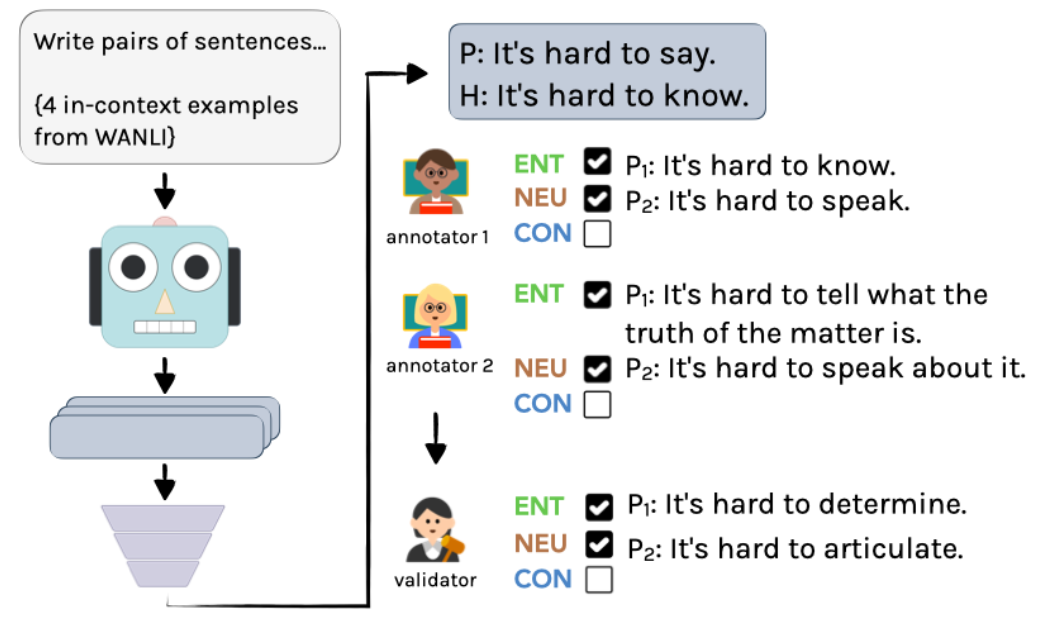

具體過程如圖 2 所示:首先,使用 InstructGPT 創建未帶標簽的示例,再由兩位語言學家獨立進行注釋。最后,通過一位作者的整合,得到最終的注釋和標注。

▲圖2 AMBIENT 中生成示例的注釋流程

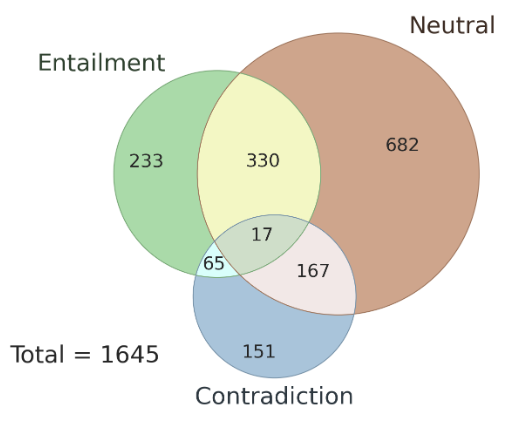

此外,這里還探討了不同標注者之間標注結果的一致性問題,以及 AMBIENT 數據集中存在的歧義類型。作者在該數據集中隨機選擇了 100 個樣本作為開發集,其余樣本用作測試集,圖 3 是其中集合標簽的分布情況,每個樣本都具有對應的推理關系標簽。研究表明,在歧義情況下,多個標注者的標注結果具有一致性,使用多個標注者的聯合結果可以提高標注準確性。

▲圖3 AMBIENT 中集合標簽的分布

歧義是否說明了“不同意”?

該研究分析了在傳統的 NLI 三路標注方案下,標注者在對含歧義輸入進行標注時的行為。研究發現,標注者可以意識到歧義,并且歧義是導致標簽差異的主要原因,因此挑戰了“不同意”是模擬例子不確定性的流行假設。

在研究中,采用 AMBIENT 數據集,雇傭了 9 名眾包工作者對每個含歧義的例子進行標注。

任務分為三步:

- 標注含歧義的例子

- 識別可能的不同解釋

- 標注已消除歧義的例子

其中,步驟 2 中,三個可能的解釋包括兩個可能的意思和一個類似但不完全相同的句子。最后,對每個可能的解釋,都將其代入原始例子得到三個新的 NLI 例子,讓標注者分別選擇一個標簽。

此實驗的結果支持了假設:在單標注體系下,原始的模糊例子會產生高度不一致的結果,即在給句子打標簽的過程中,人們對于模糊不清的句子容易產生不同的判斷,導致結果不一致。但是,當在任務中加入消除歧義的步驟后,注釋員們普遍能夠識別并驗證句子的多種可能性,結果的不一致性得到了大幅度解決。因此,消除歧義是減少注釋員主觀性對結果影響的有效方法。

評估大模型上的表現

Q1. 能否直接生成與消歧有關的內容

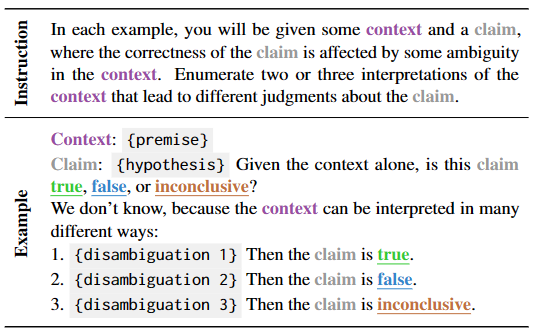

該部分重點在于測試語言模型在上下文中直接生成消歧和對應標簽的學習能力。為此,作者構建了一個自然提示并使用自動評估和人工評估來驗證模型的表現,如表 2 所示。

▲表2 當前提不明確時,用于生成歧義消除任務的 few-shot 模板

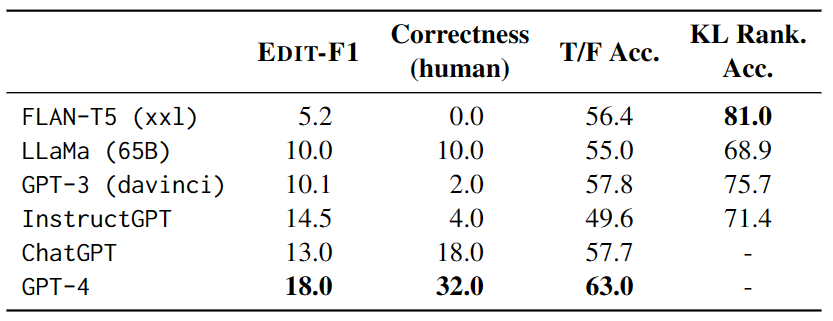

在測試中,每個示例都有 4 個其他測試示例作為上下文,并使用 EDIT-F1 指標和人工評估來計算得分和正確性。實驗結果如表 3 顯示,GPT-4 在測試中表現最佳,實現了18.0%的 EDIT-F1 得分和 32.0% 的人工評估正確性。此外,還觀察到大模型在消歧時常常采用加入額外上下文的策略來直接確認或否定假設。不過需要注意的是,人工評估可能會高估模型準確報告歧義來源的能力。

▲表3 大模型在 AMBIENT 上的性能

Q2. 能否識別出合理解釋的有效性

該部分主要研究了大模型在識別含有歧義的句子時的表現。通過創建一系列真假陳述模板,并對模型進行 zero-shot 測試,研究人員評估了大模型在選擇正誤之間的預測中的表現。實驗結果表明,最佳模型是 GPT-4,然而,在考慮歧義性的情況下,GPT-4 在回答所有四個模板的歧義解釋中的表現比隨機猜測的準確率還低。此外,大模型在問題上存在一致性問題,對于同一個歧義句子的不同解釋對,模型可能會出現內部矛盾的情況。

這些發現提示我們,需要進一步研究如何提高大模型對含有歧義的句子的理解能力,并更好地評估大模型的性能。

Q3. 通過不同解釋模擬開放式連續生成

這一部分主要研究基于語言模型的歧義理解能力。通過給定上下文,對語言模型進行測試,比較模型對于不同可能解釋下的文本延續的預測。為了衡量模型對于歧義的處理能力,研究人員通過在相應語境下比較模型在給定歧義和給定正確語境下所產生的概率和期望差異,用 KL 散度來衡量模型的“驚奇度”,并且引入隨機替換名詞的“干擾句”來進一步測試模型的能力。

實驗結果表明,FLAN-T5 的正確率最高,但不同測試套件(LS 涉及同義詞替換,PC 涉及拼寫錯誤的修正,SSD 涉及語法結構修正)和不同模型的表現結果不一致,說明歧義仍然是模型的一個嚴重挑戰。

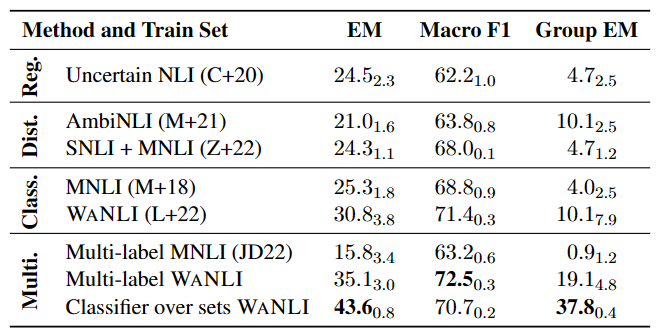

多標簽 NLI 模型實驗

如表 4 所示,在已有帶有標簽變化的數據上微調 NLI 模型仍有較大提升空間,特別是多標簽 NLI 任務中。

▲表4 多標簽 NLI 模型在 AMBIENT 上的性能

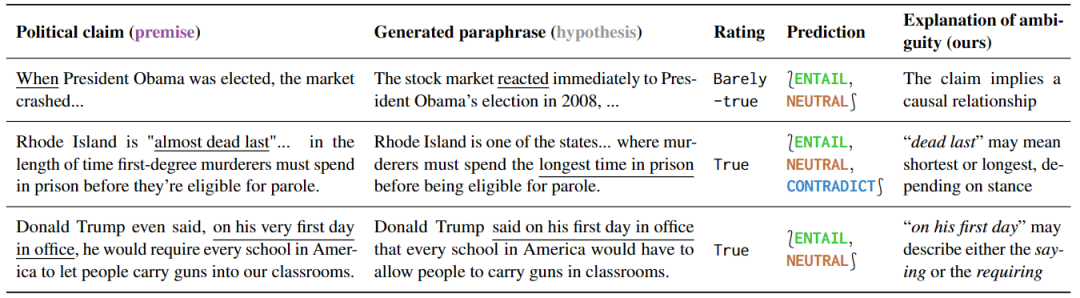

檢測誤導性的政治言論

這項實驗研究了對政治言論的不同理解方式,證明了對不同理解方式敏感的模型可被有效利用。研究結果如表 5 所示,針對有歧義的句子,一些解釋性的釋義可以自然而然地消除歧義,因為這些釋義只能保留歧義或者明確表達一個特定的意義。

▲表5 本文檢測方法標記為有歧義的政治言論

此外,針對這種預測的釋義,可以揭示歧義的根源。通過進一步分析誤報的結果,作者還發現了很多事實核查中沒有提到的歧義,說明這些工具在預防誤解方面具有很大的潛力。

小結

如同本文中所指出的那樣,自然語言的歧義性將是模型優化中的一個關鍵挑戰。我們期待未來的技術發展中,自然語言理解模型能夠更加準確地識別文本中的上下文和重點,并在處理歧義性文本時表現出更高的敏感度。盡管我們已經建立了評估自然語言處理模型識別歧義的基準,并能夠更好地了解模型在這個領域中的局限性,但這仍然是一個非常具有挑戰性的任務。

夕小瑤科技說 原創

作者 |智商掉了一地、Python