大模型物種進化圖轉瘋了:8位華人打造,一眼看懂“界門綱目”,原來BERT后代已絕種

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

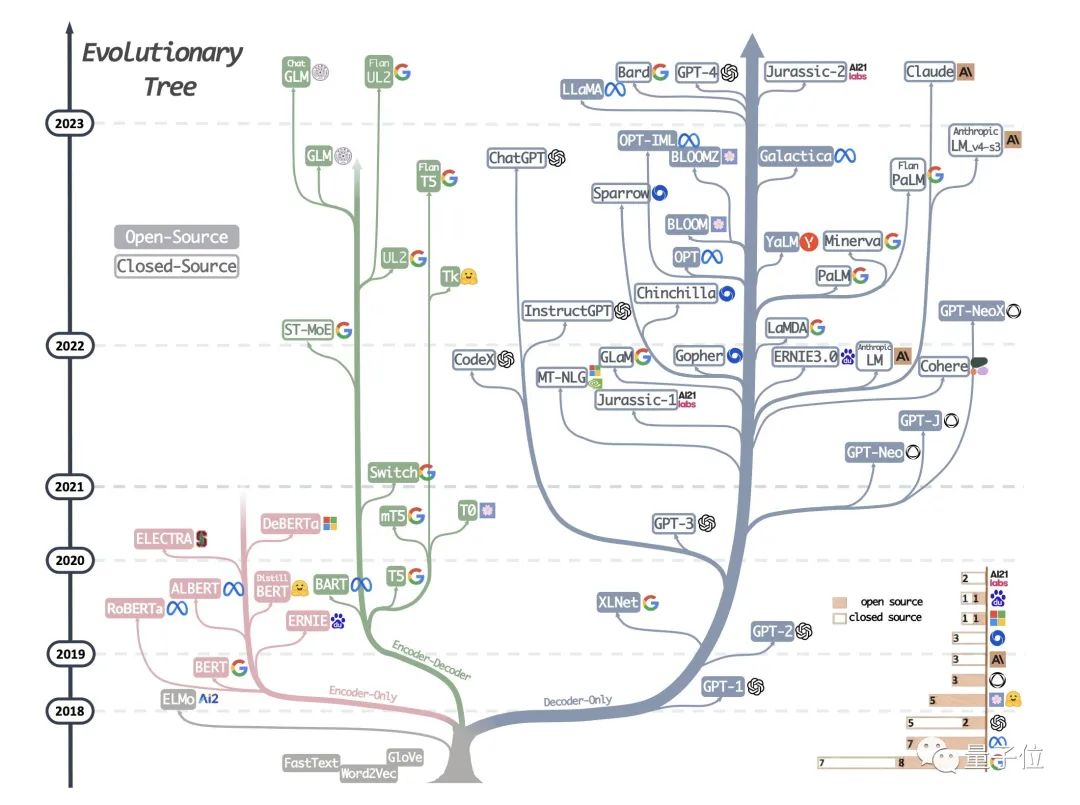

這幾天,一張名為“大語言模型進化樹”的動圖在學術圈瘋轉:

它清晰梳理了2018到2023五年間所有的大語言模型“代表作”,并將這些模型架構分成三大類,進化結果一目了然:

業界頗具影響力的谷歌BERT,從一開始就走向了“岔路”,如今在生成AI領域已瀕臨淘汰;

與谷歌和Meta“多線布局”不同,OpenAI從GPT-1開始,就堅定其中一條技術路線,如今成功走在這條路線的最前沿……

有網友調侃,在大模型沒有成功之前,大家都只是在參與一場“賭局”:

還有網友感嘆,兩年后會進化成什么樣子簡直不敢想象。

我們扒了扒,發現這張圖原來來自于最近一篇爆火的綜述論文《在實踐中利用大模型的力量》:

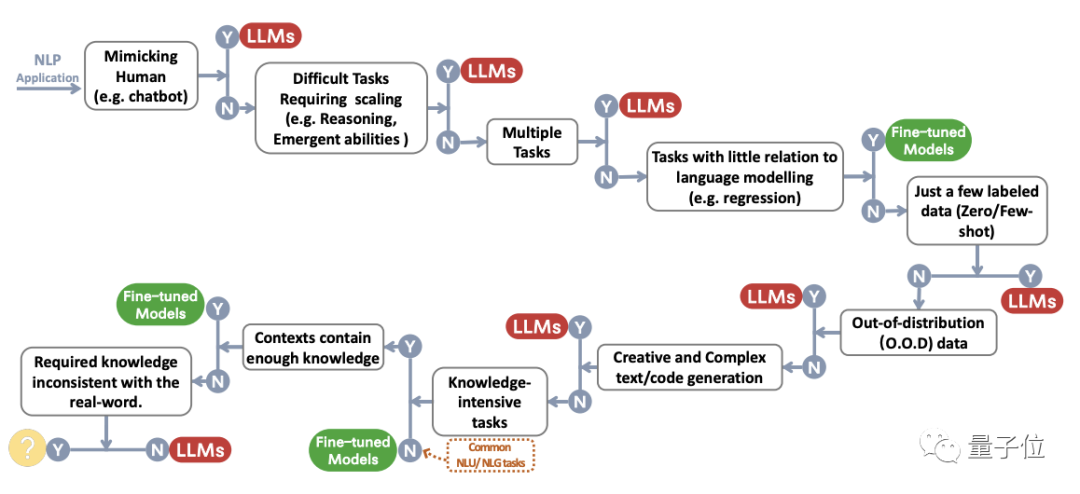

論文不僅詳細闡述了現代大語言模型LLM這5年的發展歷程,還針對當下大伙兒最焦慮的“如何選用LLM”這一關鍵問題,給出了詳細解答。

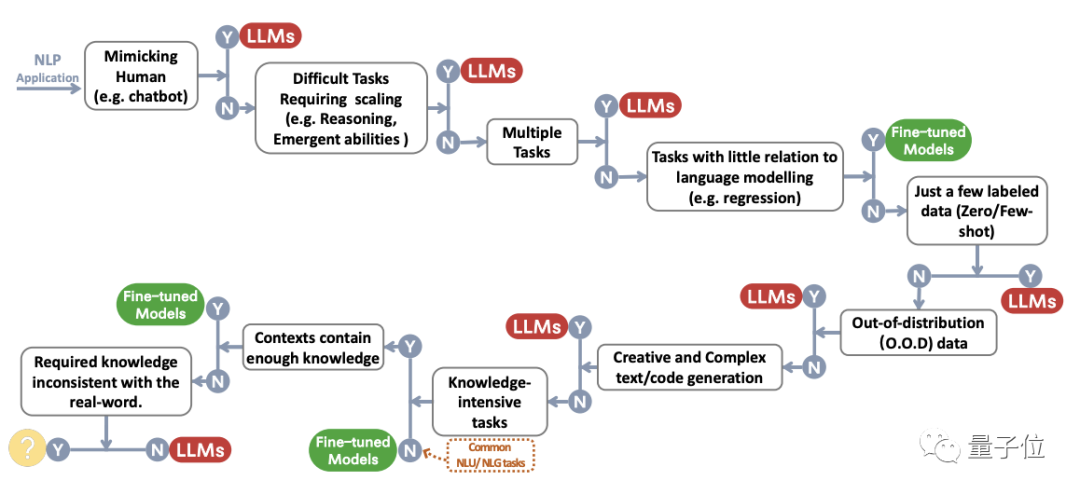

比如在自然語言理解任務中,微調模型通常是比LLM更好的選擇,不過LLM可以提供強大的泛化能力;而在知識型密集任務中,LLM學到了更豐富的現實世界知識,所以比微調模型更適合。

所有的一切都被濃縮成了一張圖,簡直不要太清晰明了。

整體來說,論文分為三個部分,對大語言模型是如何發展的(模型實用指南)、大模型性能究竟受什么影響(數據實用指南)、以及什么場景用什么類型的模型(NLP任務實用指南)這幾個重點分別進行了詳細介紹。

我們逐個來看看。

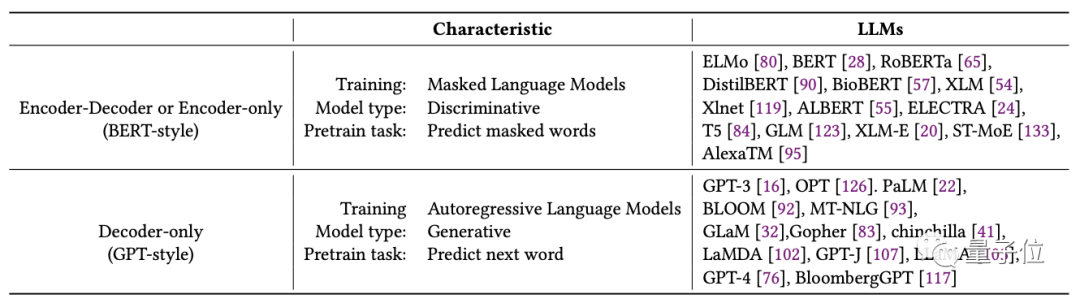

“BERT派”和“GPT派”二分天下

首先來解讀一下上面的LLM發展進化史,也就是論文中的《模型實用指南》。

根據論文,大模型發展主要可以分為兩類,作者們將它命名為“BERT派”和“GPT派”:

其中,“BERT派”的特征是模型中有編碼器架構,具體分為編解碼器(Encoder-Decoder)和只有編碼器(Encoder-only)兩類架構;

“GPT派”則主張扔掉編碼器,架構中只保留解碼器(Decoder-only)。

最初“BERT派”占據上風。但以BERT為代表的Encoder-only路線發展慘淡,相關研究到2020年就逐漸消失。

隨后,GPT-3的出現,徹底轉變了大語言模型領域的風向,OpenAI為代表的“GPT派”開始發展壯大,并成為如今LLM中發展最順利的一支。

根據這一想法,作者們將它做成了一張完整的樹狀圖,記錄了這些年大模型各大路線的發展興衰。

而這張圖也成為了谷歌和OpenAI在大模型這場戰爭的“記錄圖”。

顯然,谷歌在只有解碼器、只有編碼器和編解碼器三個方向都有不少布局,然而如今,大模型依舊是“一條路走到頭”、只搞Decoder-Only的OpenAI占據上風:

△圖中有個bug,ALBERT是谷歌開發的

然而與此相對,我們也能發現,大模型整體呈現出“越來越封閉”的狀態,而這很大程度上要歸功于“Open”AI的表現。

不過在這些大廠里,Meta開源還是做得不錯的,只有幾十人的HuggingFace也成了重要力量:

當然,這并不意味著“BERT派”已經整體落于下風,畢竟編解碼器這個分支發展得也還不錯,包括清華GLM和谷歌T5都是這個領域的代表開源模型。

未來這幾大LLM路線的發展速度是否會發生變化,還是一個未知數。

那么,影響大模型性能的關鍵因素究竟是什么呢?

如何判斷LLM性能好壞?

論文認為,影響LLM性能的關鍵因素依舊是數據。

什么樣的數據?

根據LLM不同階段,數據類型也主要分為三種,包括預訓練數據、微調數據和測試/用戶數據。

數據類型不同,對模型的影響作用也并不一樣,甚至能直接決定大模型的最佳適用范圍,論文在《數據實用指南》有具體闡述。

首先是預訓練數據。它相當于大語言模型的“基底”,既決定了LLM的“語言功底”,又會極大影響LLM在下游任務的表現。

一方面是LLM的“語言功底”,指大語言模型對單詞的知識、語法、句法和語義的理解能力,以及上下文和生成連續文本的能力。

為了鍛煉LLM這部分能力,數據需要全面展現人類知識、語言和文化。

另一方面是LLM在下游任務的表現,這部分對于如何選擇LLM應用思路起著至關重要的作用。

為了鍛煉LLM這部分能力,需要考慮預訓練數據的多樣性,尤其是完成特定下游任務需要的“特定”數據,例如用社交媒體數據訓練出的LLM問答能力、用代碼數據訓練出的LLM邏輯和代碼填充能力等。

其次是微調數據。這部分數據往往被用于“調試”特定任務性能,具體又分為零標注數據、少量標注數據和大量標注數據。

其中,零標注數據通常被用于零次學習(Zero-Shot Learning)中,即希望大模型能完成之前沒見過的任務,具備更強的“推理能力”;

少量標注數據主要用于引導大模型出現推理能力的同時,更好地提升某些少樣本任務的性能,類似方法有元學習和遷移學習等;

大量標注數據則用于提升特定任務性能,當然這種情況下,微調模型和LLM都可以考慮使用它。

最后是測試/用戶數據。這部分數據用于縮小模型訓練效果和用戶需求之間的差距,典型方法包括RLHF,即人類反饋強化學習,能顯著增強LLM的泛化能力。

了解了三類數據對模型的不同影響,如何在實際任務中,選擇對應的模型呢?

LLM還是微調模型?六大具體情況分析

接下來是本文重點部分:《NLP任務實用指南》。

在實際下游任務中,選擇直接用只經過預訓練的大模型LLM,還是用在此基礎上經過特定數據集微調后的較小模型?

具體情況具體分析。

首先來看傳統自然語言理解(NLU)任務,包括文本分類、用于知識圖構建的命名實體識別(NER),以及自然語言推理entailment prediction等。

先上結論:

在這類任務中,微調模型通常是比LLM更好的選擇,不過LLM可以提供強大的泛化能力。

具體而言,在大多數自然語言理解任務中,如果這些任務帶有豐富的、注釋良好的數據,并且在測試集上包含很少的分布外示例,那么微調模型性能更好。

不過對于不同的任務和數據集,兩者的差距還不完全一樣。

比如在文本分類中,LLM大多只是略遜于微調模型;而在情緒分析上,LLM和微調模型表現一樣好;毒性檢測上,則所有LLM都很差。

作者認為,這種結果一是跟LLM的指令或prompt設計有關,二是微調模型的能力上限確實還很高。

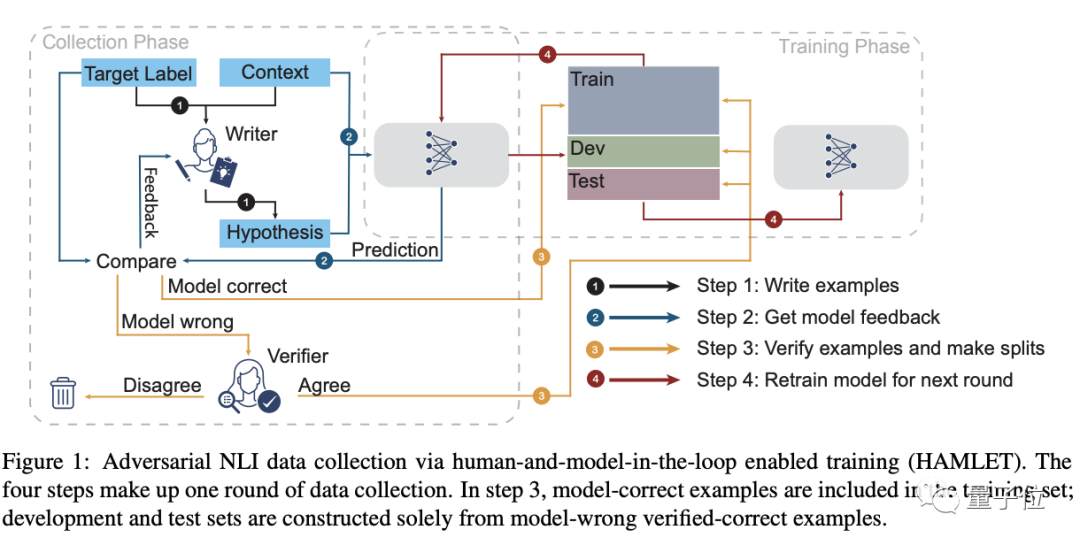

當然,也有LLM擅長的,一個是雜項文本分類,需要處理各種沒有明確關聯的內容,更接近真實世界;另一個是對抗性自然語言推理(ANLI)。LLM對這種具有分布外和注釋稀疏的數據有良好的泛化能力,微調模型不行。

其次是生成任務,包括兩種:

第一種側重于對輸入文本進行加工轉換,比如寫摘要和機器翻譯;第二種是開放式生成類,根據用戶需求從頭生成文本,比如寫故事、寫代碼等。

這類任務要求模型理解能力好,以及有創造性,LLM絕大多數情況都表現更好。

具體而言,對于寫摘要來說,盡管機器評估結果顯示LLM并沒有比微調更有優勢,但在人類評估上它贏了。

在機器翻譯上,盡管LLM平均性能略低于一些商業翻譯工具,但它尤其擅長將一些預訓練可能都沒見過的小語種翻譯成英語,比如羅馬尼亞語、羅曼什語、加利西亞語等等。

而開放式生成中,目前我們見到的很多作品都是基于沒有經過微調的LLM生成的,比如GPT-4,其實力可見一斑,不用多說。

第三是知識密集型任務,這類任務強烈依賴背景知識、特定領域專業知識或現實世界常識等,要解決它們早已超出簡單的模式識別或語法分析的范疇。

同樣,先說結論:

(1)LLM因具有豐富的現實世界知識所以更擅長知識密集型任務。

(2)當需求與其所學知識不匹配時,或者面臨只需要上下文知識的任務時,LLM會遇到困難。在這種情況下,微調模型可以頂上。

具體而言,在一般的知識密集型任務中,LLM在幾乎所有數據集上都表現更好,這是數十億的訓練token和參數給它帶來的。

比如在谷歌提出的大模型新基準Big bench中的大多數任務中,它的性能優于人類的平均水平,某些情況下,甚至可以與人類的最佳性能相媲美,比如提供有關印度教神話的事實、從元素周期表中預測元素名稱等。

不過,Big bench其中一些任務比如要求模型說出ASCII藝術表示的數字,或者是重新定義了一個公共符號,要求模型在原始含義和從定義中派生的含義之間進行選擇時,LLM表現不如微調模型,甚至比隨機猜測還要差。

這是因為這類任務需要的知識與現實世界無關。

需要注意的是,如果“閉卷任務變成開卷”,給模型賦予檢索增強的能力,尺寸更小的微調模型的表現會比LLM更好。

在以上三類任務之外,作者還詳細分析了LLM擴展(Scaling)方面的知識,以及我們在上面提及任務之外的其他任務和現實世界真實任務上的選擇。

這里就不一一展開了,奉上結論。

LLM擴展:

當模型規模呈指數級增長時,LLM將變得特別擅長算術推理和常識推理;

不過在許多情況下,由于人類理解還有限,擴大規模后的LLM性能并不會隨之穩步提升。

其他未歸類的雜項任務:

在與LLM的預訓練目標和數據相去甚遠的任務中,微調模型或特定模型仍有空間;

LLM在模仿人類、數據評注和生成方面非常出色,也可以用于NLP任務中的質量評估,并具有可解釋性的優點。

現實任務:

這類任務面臨的挑戰包括嘈雜/非結構化的輸入、用戶的請求可能包含多個隱含意圖等。

與微調模型相比,LLM更適合處理這些場景。然而,在現實世界中評估模型的有效性仍然是一個懸而未決的問題。

最后,還有一些總體準則:

如果對成本敏感或有嚴格的延遲要求,考慮輕型的微調模型,而不是LLM;

LLM的零樣本方法無法從特定任務數據集進行shortcut learning,但微調模型可以;

高度重視與LLM相關的安全問題,因為LLM會產生潛在有害或偏見輸出。

Over。

看完上面這些,是不是覺得條條框框有些不好記?

別急,如開頭所述,作者已經將它們全部濃縮成了一張思維導圖,照著它來分析就好了!(手動狗頭)

8位華人作者

本文作者一共8位,全部是華人,分別來自亞馬遜、得克薩斯農工大學和萊斯大學,其中5人是共同一作。

共同一作楊靖鋒(Jingfeng Yang),目前是亞馬遜應用研究科學家,本科畢業于北大,碩士畢業于佐治亞理工學院,研究方向是NLP和機器學習。

此前,他還寫過一篇關于GPT-3和GPT-3.5的復現和使用指南,詳細解讀了為什么關于GPT-3的復現大部分會失敗、以及使用GPT-3.5和ChatGPT的最佳方式。

共同一作靳弘業(Hongye Jin),目前是得克薩斯農工大學在讀博士生,本科畢業于北京大學,研究方向是機器學習等。

共同一作Ruixiang Tang,萊斯大學計算機科學四年級博士生,本科畢業于清華大學自動化系,研究方向是可信任AI,包括機器學習的可解釋性、公平性和魯棒性。

共同一作Xiaotian Han,得克薩斯農工大學四年級博士生,本科畢業于山東大學通信工程,于北郵拿到計算機科學碩士學位,研究興趣是數據挖掘和機器學習。

共同一作Qizhang Feng,得克薩斯農工大學博士生,本科畢業于華中科技大學,碩士畢業于杜克大學,研究方向是機器學習。

此外,亞馬遜應用研究科學家姜昊茗(Haoming Jiang)、亞馬遜應用科學主管Bing Yin和萊斯大學助理教授Xia Hu也參與了這次研究。

論文地址:https://arxiv.org/abs/2304.13712

大模型實用指南(持續更新中):

https://github.com/Mooler0410/LLMsPracticalGuide