朱玉可團隊新作:看一眼就能模仿,大模型讓機器人輕松學會撒鹽

在人形機器人領域,有一個非常值錢的問題:既然人形機器人的樣子與人類類似,那么它們能使用網絡視頻等數據進行學習和訓練嗎?

如果可以,那考慮到網絡視頻的龐大規模,機器人就再也不用擔心沒有學習資源了。

近日,德克薩斯大學奧斯汀分校和 NVIDIA Research 的朱玉可團隊公布了他們的一篇 CoRL 2024 oral 論文,其中提出了一種名為 OKAMI 的方法,可基于單個 RGB-D 視頻生成操作規劃并推斷執行策略。

- 論文地址:OKAMI: Teaching Humanoid Robots Manipulation Skills through Single Video Imitation

- 論文鏈接:https://arxiv.org/pdf/2410.11792

- 項目地址:https://ut-austin-rpl.github.io/OKAMI/

先來看看演示視頻:

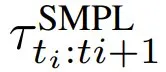

可以看到,機器人在看過人類演示者向袋子中裝東西后,也學會了以同樣的動作向袋子中裝東西。不僅如此,OKAMI 還能讓人形機器人看一眼演示視頻就輕松學會撒鹽、將玩具放進籃子和合上筆記本電腦等任務。

和 AI 領域內的許多技術一樣,OKAMI 也是一個縮寫詞,全稱是 Object-aware Kinematic retArgeting for huManoid Imitation,即用于人形機器人模仿的物體感知型動力學重定向。

和 AI 領域內的許多技術一樣,OKAMI 也是一個縮寫詞,全稱是 Object-aware Kinematic retArgeting for huManoid Imitation,即用于人形機器人模仿的物體感知型動力學重定向。

顧名思義,這是一種物體感知型重定向方法,可以讓具有兩個靈巧機器手的雙手型人形機器人基于單個 RGB-D 視頻演示模仿其中的操作行為。

OKAMI 方法詳解

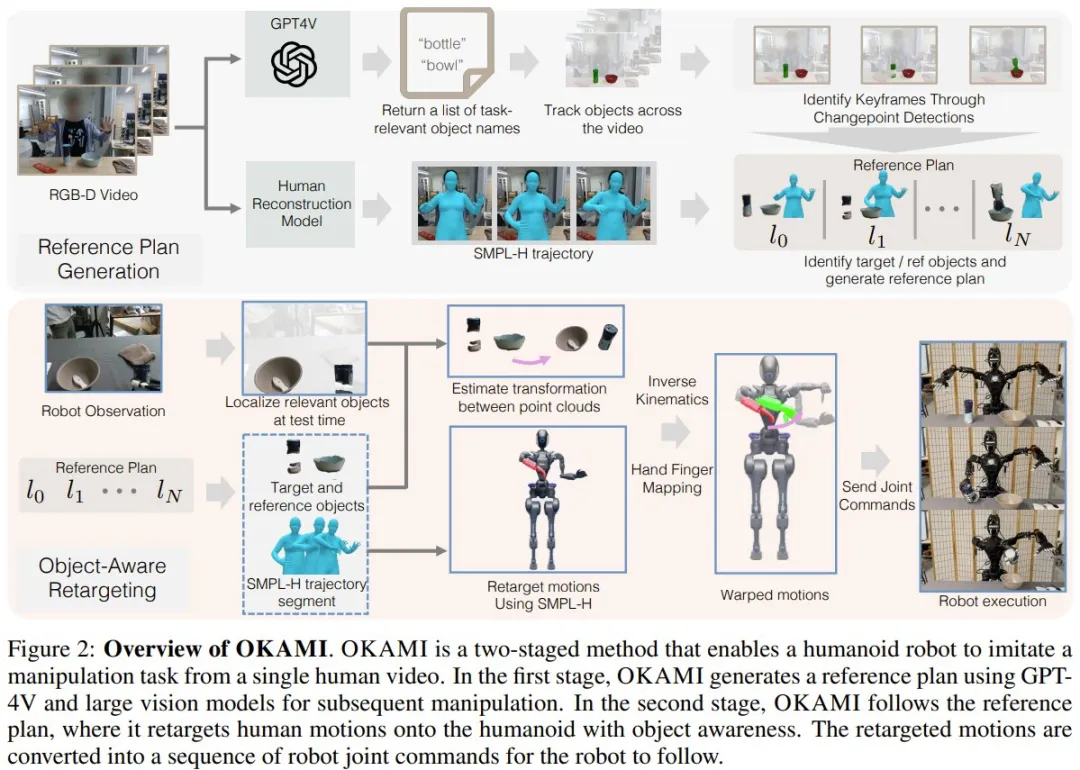

OKAMI 采用了一種兩階段過程,可將人類運動重新定向成人形機器人的運動,從而可在不同初始條件下完成任務。

在第一個階段,OKAMI 會處理視頻并生成一個參考操作規劃。

在第二個階段,OKAMI 會使用該規劃來合成人形機器人的運動,這個過程會用到運動重定向,其作用是適應目標環境中的物體位置。

圖 2 展示了其整個工作流程。

問題描述

首先,該團隊將人形機器人操作任務描述成了一個離散時間馬爾可夫決策過程,并將其定義成了一個元組 M = (S, A, P, R, γ, μ)。其中 S 是狀態空間、A 是動作空間、P (?|s, a) 是轉移概率、R (s) 是獎勵函數、γ ∈ [0, 1) 是折扣因子、μ 是初始狀態分布。

在這里,S 就是原始 RGB-D 觀察的空間,其中包含機器人和物體的狀態;A 則是人形機器人的運動指令的空間;R 是一個稀疏的獎勵函數 —— 當任務完成時,返回 1。對于一個任務,其目標是找到一個策略 π,使其可以在測試時間最大化大量不同的初始配置下的預期任務成功率。

他們考慮了「基于觀察的開放世界模仿」設置。在該設置中,這個機器人系統會獲得一段錄制的 RGB-D 人類視頻 V,然后其需要返回一個人形機器人操作策略 π,使機器人可以完成視頻演示的任務。

參考規劃生成

為了實現物體感知型重新定向,OKAMI 首先會為人形機器人生成一個參考規劃。規劃生成需要了解有哪些與任務相關的物體以及人類如何操作它們。

識別和定位與任務相關的物體

為了模仿視頻 V 中的操作任務,OKAMI 必須識別要交互的物體。之前的方法需要具有簡單背景的無監督方法或需要額外的人工標注,而 OKAMI 則不一樣,其使用了現成可用的視覺 - 語言模型(VLM)GPT-4V 來識別 V 中與任務相關的物體;這自然是用到了該模型中內化的常識性知識

具體來說,OKAMI 會通過采樣 RGB 幀并使用 GPT-4V 來獲取與任務相關的物體的名稱。使用這些名稱,OKAMI 再使用 Grounded-SAM 來分割第一幀中的物體并使用視頻目標分割模型 Cutie 來跟蹤這些物體的位置。

重建人類運動

為了將人類運動重新定向成機器人運動,OKAMI 會重建來自 V 的人類運動以獲取運動軌跡。為此,他們采用了改進版的 SLAHMR,這是一種用于重建人類運動序列的迭代式優化算法。雖然 SLAHMR 假設雙手平放,而新的擴展優化了 SMPL-H 模型的手部姿勢,這些姿勢使用來自 HaMeR 的估計手部姿勢進行初始化。此修改使得單目視頻中的身體和手部姿勢可以進行聯合優化。其輸出是一個獲取了全身和手部姿勢的 SMPL-H 模型序列,讓 OKAMI 可以將人類動作重新定向到人形機器人。

此外,SMPL-H 模型還能表示不同人類外觀的人類姿勢,從而可以輕松地將人類演示者的運動映射到人形機器人。

基于視頻生成規劃

有了任務相關的物體和重建出來的人類運動,OKAMI 就可以基于 V 生成用于完成每個子目標的參考規劃了。

OKAMI 識別子目標的方式是基于以下流程執行時間分割:

- 首先使用 CoTracker 跟蹤關鍵點,并檢測關鍵點的速度變化以確定關鍵幀,這些關鍵幀對應于子目標狀態。

- 對于每個子目標,都確定一個目標物體(會因為操作而運動)和一個參考物體(通過接觸或非接觸關系作為目標物體運動的空間參考)。目標物體是根據每個物體的平均關鍵點速度確定的,而參考物體則通過 GPT-4V 預測的幾何啟發式或語義關系來識別。

- 確定子目標和相關物體后,生成一個參考規劃 l_0, l_1, . . . , l_N,其中每一步 l_i 都對應于一個關鍵幀,并且包含目標物體 o_target、參考問題 o_reference 和 SMPL-H 軌跡段

的點云。

的點云。

物體感知型重定向

有了來自演示視頻的參考規劃后,OKAMI 便可以讓人形機器人模仿 V 中的任務。機器人會遵循規劃中的每個步驟 l_i。然后經過重新定向的軌跡會被轉換成關節指令。這個過程一直重復直到任務完成,之后基于任務特定的條件來評估是否成功。

在測試時間定位物體

為了在測試時間環境中執行規劃,OKAMI 必須定位機器人觀察中的相關物體,提取 3D 點云來跟蹤物體位置。通過關注與任務相關的物體,OKAMI 策略可以泛化用于各不相同的視覺背景,包括不同的背景或任務相關物體新實例。

將人類運動重新定位到人形機器人

物體感知的關鍵是使運動適應新的物體位置。在定位物體后,OKAMI 會采用一種分解式重新定位過程,即分別合成手臂和手部運動。

OKAMI 首先根據物體位置調整手臂運動,以便將手指置于以物體為中心的坐標系內。然后,OKAMI 只需在關節配置中重新定位手指,以模仿演示者用手與物體交互的方式。

具體來說,首先將人體運動映射到人形機器人的任務空間,縮放和調整軌跡以考慮尺寸和比例的差異。然后,OKAMI 扭曲變形(warp)重新定位的軌跡,以便機器人的手臂到達新的物體位置。該團隊考慮了兩種軌跡變形情況 —— 當目標和參考物體之間的關系狀態不變時以及當關系狀態發生變化時,相應地調整變形。

在第一種情況下,僅基于目標物體位置執行軌跡變形。在第二種情況下,基于參考物體位置執行變形。

變形之后,使用逆動力學計算機器臂的關節配置序列,同時平衡逆運動學計算中的位置和旋轉目標的權重以保持自然姿勢。同時,將人類手部姿勢重新定位到機器人的手指關節,使機器人能夠執行精細的操作。

最后,可得到一套全身關節配置軌跡。由于機器臂運動重新定向是仿射式的,因此這個過程可以自然地適應不同演示者的情況。通過調整手臂軌跡以適應物體位置并獨立重新定位手部姿勢,OKAMI 可實現跨各種空間布局的泛化。

實驗及結果

研究者在實驗部分主要回答了以下四個研究問題:

- OKAMI 能否有效地讓人形機器人基于單個人類演示視頻來模仿各種操作任務?

- 在 OKAMI 中,將演示者的身體動作重新定位到人形機器人身上是否重要,以及為什么沒有選擇僅根據物體位置進行重新定位?

- OKAMI 能否在多樣化人體統計學特征的人類演示視頻中始終保持自身性能?

- OKAMI 生成的展示(rollout)是否可以用來訓練閉環視覺運動策略?

任務設計。研究者在實驗中執行了六項任務,分別如下:

- 將毛絨玩具放入籃子里(Plush-toy-in-basket)

- 將少許鹽撒入碗中(Sprinkle-salt)

- 關上抽屜(Close-the-drawer)

- 合上筆記本電腦的蓋子(Close-the-laptop)

- 將一袋零食放在盤子上(Place-snacks-on-plate)

- 將薯片袋放入購物袋中(Bagging)

硬件設置。研究者使用 Fourier GR1 機器人作為自己的硬件平臺,配備了兩個 6 自由度(DoF)的 Inspire 靈巧手以及一個用來錄制視頻和進行測試時觀察的 D435i Intel RealSense 攝像頭。此外還實現了一個以 400Hz 運行的關節位置控制器。為了避免出現抖動,研究者以 40Hz 來計算關節位置命令,并將命令插入 400Hz 軌跡。

評估方案。研究者針對每項任務運行了 12 次試驗。過程中,物體的位置在機器人攝像頭視野和人形手臂可觸及范圍的交點內進行隨機初始化。

基線。研究者將 OKAMI 與基線 ORION 進行了比較。

定性結果

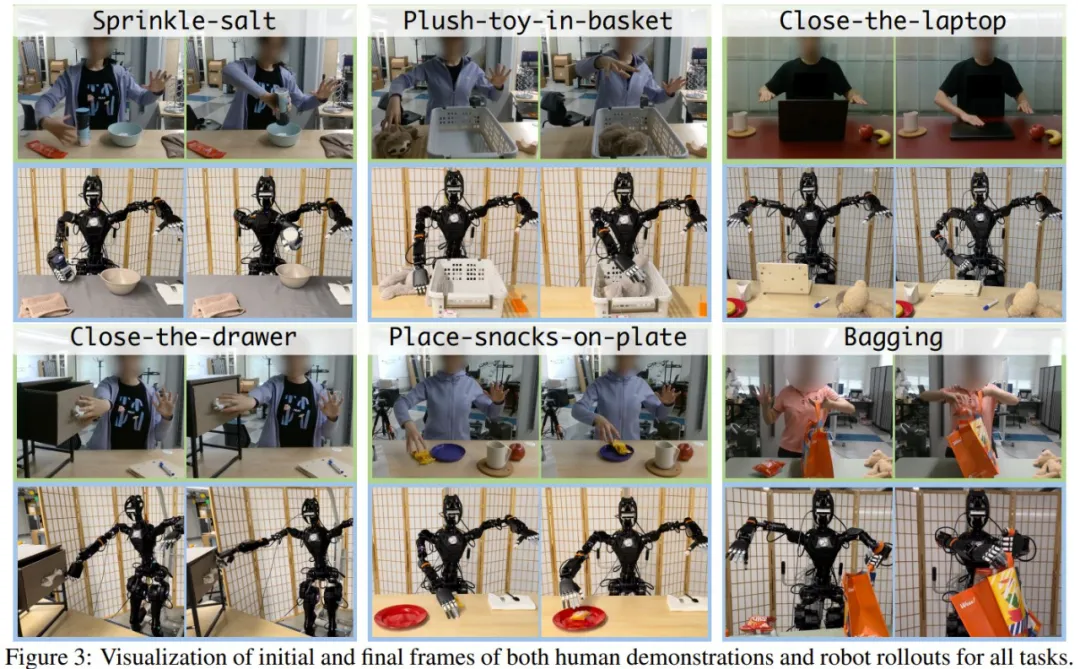

為了回答問題 1),研究者評估了 OKAMI 在所有任務中的策略,覆蓋日常取放、傾倒和操縱鉸接物體等多樣性行為。結果如下圖 4(a)所示,實驗中隨機初始化了物體位置,這樣做讓機器人需要適應物體的位置。從結果來看,OKAMI 可以有效地泛化到不同的視覺和空間條件。

為了回答問題 2),研究者在兩項代表性任務上將 OKAMI 與 ORION 進行比較,分別是將 Place-snacks-on-plate 和 Close-the-laptop。二者的不同之處在于 ORION 不以人類身體姿態為條件。結果顯示,OKAMI 在兩項任務上分別實現了 75.0% 和 83.3% 的成功率,而 ORION 分別只有 0.0% 和 41.2%,拉開了很大的差距。

為了回答問題 3),研究者進行了一項受控實驗,記錄了不同演示者的視頻,并測試 OKAMI 策略是否對所有視頻輸入都能保持良好的性能。同樣地,他們選擇的任務是 Place-snacks-on-plate 和 Close-the-laptop,結果如圖 4(b)所示。

總體而言,OKAMI 能夠在處理不同演示者的視頻時保持相當不錯的性能,不過處理這類多樣性的視覺 pipeline 仍有改進的空間。

利用 OKAMI Rollout 數據學習視覺運動策略

為了解決問題 4),研究者在 OKAMI rollout 上訓練了神經視覺運動策略。他們首先在隨機初始化的物體 rollout 上運行 OKAMI,并在收集一個包含成功軌跡的數據集同時丟棄失敗的軌跡。此外他們通過行為克隆算法在該數據集上訓練神經網絡策略,并為 Sprinkle-salt 和 Bagging 兩項任務訓練視覺運動策略。

下圖 5 展示了這些策略的成功率,表明 OKAMI rollout 可以成為有效的訓練數據源。并且,隨著收集到的 rollout 增多,學習到的策略會隨之改進。這些結果有望擴展數據收集范圍,從而無需費力遠程操作也能學習人形機器人操作技能。

局限性和未來工作

OKAMI 雖強,但也并不完美,下面展示了兩個失敗實例:

OKAMI 目前專注于人形機器人的上半身運動重定向,尤其是用于桌面工作空間的操控任務。因此未來有希望擴展到下半身重定向,以便在視頻模仿期間實現運動行為。更進一步,實現全身運動操控則需要一個全身運動控制器,而不是 OKAMI 中使用的關節控制器。

此外,研究者在 OKAMI 中依賴 RGB-D 視頻,這限制了他們使用以 RGB 記錄的野外互聯網視頻。因此擴展 OKAMI 使用網絡視頻將是未來另一個有潛力的研究方向。最后,當前重定向的實現在面對物體的形狀變化較大時表現出了較弱的穩健性。

未來的改進將是整合更強大的基礎模型,使機器人能夠總體了解如何與一類物體進行交互,即使這類物體的形狀變化很大。